- Vorteile von Onpage-Tools

- Wichtige Seitenelemente

- Kanonisierung, Duplicate Content

- Content-Qualität/-Menge

- HTTP-Status-Codes

- Klicktiefe

- Performance/Ladezeit

- URL-Probleme

- Abgleich mit der XML-Sitemap

- Suchanalyse-Daten

- Grenzen der Tools

- Abdeckung von Suchbegriffen

- Sichtbarkeit von Inhalten, Rendering

- Weitere Probleme

- Was Website-Betreiber beachten sollen

Das Ranking verbessern: Was bringen Onpage-Tools wirklich?

(Grafik: Shutterstock/ Trymyr)

Sie indexieren Seite für Seite, folgen internen Links und prüfen die Inhalte auf suchmaschinenrelevante Kriterien: Onpage-Tools helfen dabei, das Ranking der eigenen Website bei Google zu verbessern. Die Werkzeuge setzen bei einer bestimmten Seite an und crawlen dann die einzelnen Unterseiten. Es geht dabei nicht nur darum, eine Auflistung aller Seiten zu erhalten, sondern die Inhalte auf bestimmte SEO-Kriterien hin zu prüfen. Die Onpage-Tools schlagen dann auch Verbesserungen vor, mit denen Betreiber ihre Website optimieren können.

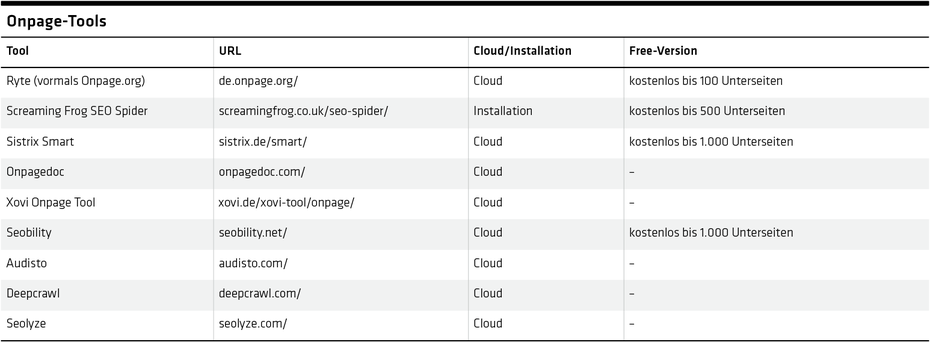

Für wen sich welches Onpage-Tool eignet, hängt sowohl von dem Ziel der Nutzung ab als auch von der Größe der Website. Wer über sehr große Websites mit mehr als einer Millionen Seiten verfügt, sollte über Tools wie Audisto oder Deepcrawl nachdenken (siehe Tabelle). Auch andere Tools können große Websites crawlen, sie werden aber typischerweise eher für kleinere Webangebote verwendet. Der Screaming Frog SEO Spider, ein kostenloses Tool, das in der SEO-Szene beliebt ist, beschwert sich in der Standardinstallation etwa schon bei einer mittleren fünfstelligen Seitenanzahl über Speichermangel. Selbst wenn das Speicherproblem nicht gelöst ist, kann man nicht sagen, dass das Tool bei großen Datenmengen noch sonderlich performant arbeitet. Es ist auch das einzige von den in diesem Artikel genannten Tools, das nicht in der Cloud arbeitet.

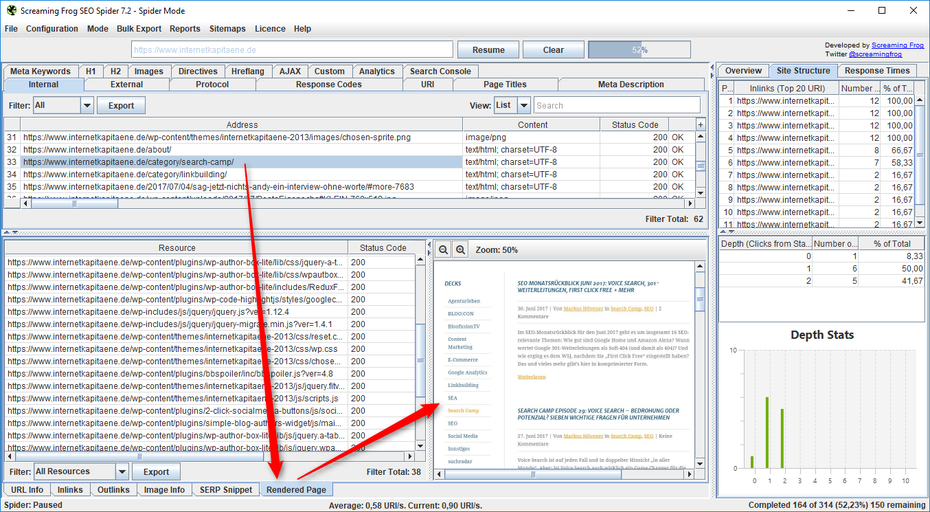

Der Screaming Frog SEO Spider kann mittlerweile auch das Rendering von Seiten prüfen.

Die Funktionen der einzelnen Tools sind extrem unterschiedlich, der konkrete Umfang zum Teil von den gebuchten Paketen abhängig. Zudem sind manche Funktionen hinsichtlich ihrer Wirksamkeit nicht belegt. So gibt es zum Beispiel bei einigen Tools Analysen der Textlesbarkeit anhand des Flesch-Scores. Da aber nicht bekannt ist, ob Google dasselbe Verfahren zur Textbewertung benutzt, ist der Einsatz vieler Tools ohnehin eine philosophische Frage.

Vorteile von Onpage-Tools

Auch wenn die Möglichkeiten primär von den Tools abhängen, gibt es konkrete Tests, die Onpage-Tools generell ermöglichen:

Wichtige Seitenelemente

Seitentitel und Meta Description sind wichtige Elemente einer Seite, da diese primär im Suchergebnis angezeigt werden. Aber auch Elemente wie <h1> können SEOs durch die Tools sehr einfach prüfen: Sind diese zu lang und werden in der Folge abgeschnitten dargestellt? Sind sie nicht unique, sodass Google sie häufig verwirft? Oder sind sie zu kurz und bestehen nur aus einem Wort, was zu einem unattraktiven Suchergebnis führen kann?

Kanonisierung, Duplicate Content

Häufig gibt es bei Websites Probleme mit doppelten Inhalten – auch wenn es nur selten Anlass zur oft befürchteten Abstrafung oder Abwertung gibt. Dennoch sollten Website-Betreiber solchen Problemen auf den Grund gehen, um zum Beispiel wichtige SEO-Signale auf einer einzigen Seite zu bündeln oder um kein Crawl-Budget zu verschwenden. Die Anzahl der täglich vom Googlebot gecrawlten Seiten ist schließlich begrenzt.

Content-Qualität/-Menge

Inhalte führen nur dann zu einem guten Ranking, wenn sie auch die nötige Qualität und Quantität aufweisen. Einige Tools können Content bewerten, beispielsweise über WDF-IDF. So ermöglichen sie Website-Betreibern, in gewissem Umfang textliche Defizite zu erkennen und zu beheben.

HTTP-Status-Codes

Bei einem internen Crawl sollten alle URLs einen HTTP-Code 200 liefern, also „Inhalt konnte erfolgreich geladen werden“. Durch fehlerhafte interne Verlinkung und fehlerhafte Konfigurationen kann es aber durchaus passieren, dass es interne Weiterleitungen (Code 3xx), Fehler beim Seitenabruf (Code 4xx) oder Server-Fehler (5xx) gibt. Diese Fehler können mit Hilfe von Onpage-Tools gefunden und dann behoben werden.

Klicktiefe

Die Klicktiefe definiert die minimale Anzahl an Klicks, die ein Mensch oder ein Crawler braucht, um von der Startseite aus nur durch Link-Klicks auf eine bestimmte Seite zu gelangen. Wenn diese Klicktiefe zu hoch ist, kann es passieren, dass die jeweiligen Seiten gar nicht mehr gecrawlt und in der Folge dann auch nicht indexiert werden. Solche Fehler können beispielsweise durch eine fehlerhafte Paginierung entstehen.

Performance/Ladezeit

Die Ladezeit einer Seite gewinnt als Ranking-Faktor an Gewicht. Manche Tools messen mittlerweile auch diese Performance-Daten, da diese von Seite zu Seite sehr unterschiedlich sein können. An dieser Stelle sei gesagt, dass auch Google Analytics diese Daten von realen Nutzern liefert – in vielen Fällen auch deutlich aussagekräftigere Daten.

URL-Probleme

Bei URLs können viele Probleme auftreten: Sonderzeichen, überlange URLs, gemischte Nutzung von Klein- und Großschreibung, GET-Parameter in unterschiedlicher Reihenfolge. Da ein Tool alle URLs der Website crawlt, können solche Fälle, die zu ernsthaften Problemen führen können, schnell gefunden werden.

Abgleich mit der XML-Sitemap

Bei einem Crawl können nur Inhalte gefunden werden, die auch intern verlinkt sind. Manchmal gibt es aber auch sogenannte Orphans – Seiten, die es zwar gibt, die aber ein Crawler und damit auch Google nicht finden kann. Es macht daher Sinn, die generierten XML-Sitemaps mit den realen Crawls abzugleichen, um solche Probleme der internen Verlinkung aufzuspüren.

Suchanalyse-Daten

Manche Tools bieten auch den Import der Suchanalyse-Daten aus der Google Search Console. Das hat vor allem den Vorteil, dass man so Zugriff auf mehr Daten als die in der Console angebotenen 90 Tage erhält. Mit fortschreitender Dauer der Tool-Nutzung wächst die Datenmenge so immer stärker an. Mit den Daten können Empfehlungen generiert werden, zum Beispiel Keyword-Chancen, also Rankings auf den Positionen elf bis 20, die man eventuell auf die erste Seite optimieren kann, oder konkurrierende Seiten, also zwei oder mehr Seiten, die denselben Suchbegriff abdecken und zu unterschiedlichen Zeiten ranken.

Grenzen der Tools

Die Punkte geben einen Einblick in das, was Onpage-Tools leisten können. Allerdings gibt es auch Aspekte, bei denen die Werkzeuge keine Hilfe anbieten können.

Abdeckung von Suchbegriffen

Es kann passieren, dass eine Seite durch fehlerhafte Benennung auf den vollkommen falschen Suchbegriff, den niemand eintippt, abzielt. Und es kann passieren, dass es spannende, relevante Suchbegriffe gibt, für die derzeit keine passenden Inhalte vorliegen. Bei diesen Fällen sind die Tools in der Regel machtlos. Es muss natürlich erwähnt werden, dass Google im so genannten Matching immer besser wird und eine Seite für „Faschingskostüme“ auch für die Suchanfrage „Karnevalskostüme“ anzeigt. In vielen Fällen greift das Matching aber leider nicht, da viele – vor allem sehr spezielle – Suchanfragen inhaltlich nicht vollständig verstanden werden.

Sichtbarkeit von Inhalten, Rendering

Google lädt nicht mehr nur eine reine HTML-Seite herunter, sondern rendert diese vollständig – wie ein Browser, also inklusive JavaScript-, CSS- und Bild-Dateien. Einige Tools können mittlerweile auch das Rendering überprüfen (siehe Abbildung).

(Quelle: t3n)

Google kann dank des Renderings erkennen, ob ein bestimmter Text eingeklappt ist („click-to-expand“) oder etwa hinter Tabs „versteckt“ wird. In den Google-Richtlinien steht aber klar:

„Stellen Sie sicher, dass die wichtigsten Inhalte Ihrer Website standardmäßig sichtbar sind. Google ist in der Lage, HTML-Inhalte zu crawlen, die sich hinter Navigationselementen wie Tabs oder maximierbaren Bereichen verbergen. Wir stufen diese Inhalte jedoch als weniger zugänglich für Nutzer ein und sind der Ansicht, dass die wichtigsten Informationen in der Standard-Seitenansicht sichtbar sein sollten.“

Ob ein Inhalt aber versteckt ist und ob dieser relevant ist, können die gängigen Tools nicht erkennen. Und auch die Frage, ob sich besonders wichtige Inhalte im direkt sichtbaren Bereich („above the fold“) befinden oder ob die Website zu viel Werbung anzeigt, muss man meistens manuell prüfen.

Weitere Probleme

Darüber hinaus sind die Tools in der Regel nicht hilfreich bei Aspekten wie:

- Umsetzung der Internationalisierung: Gerade internationale Unternehmen, die Inhalte für viele Länder und Sprachen anbieten, haben oftmals Defizite hinsichtlich der Domain-Strategie. In der Regel ist es etwa nicht ratsam, für jedes Land eine eigene länderspezifische Domain zu kreieren. Aber auch eine suboptimale interne Verlinkung der unterschiedlichen Land- und Sprach-Versionen oder eine missglückte Umleitung anhand der IP-Adresse kann von den Tools in der Regel nicht gut erkannt werden.

- Optimierung der internen Verlinkung: Die Tools können natürlich Hinweise auf intern gut oder schlecht verlinkte Seiten geben. Aber wie der optimale Linkfluss ist, können nur erfahrene SEOs festlegen.

- Fehlendes Markup: Gibt es Seiten, auf denen ein bestimmtes Markup fehlt, obwohl es grundsätzlich dort sinnvoll wäre?

- User Generated Content: Werden bestimmte Möglichkeiten nutzergenerierter Inhalte, zum Beispiel Kommentare oder Forum, derzeit noch nicht genutzt?

- Crawler-Probleme: Es gibt hin und wieder Probleme, weil der Google-Crawler anders als ein „normaler“ Crawler behandelt wird. Wer etwa Umleitungen auf Basis der IP-Adresse einsetzt, wird diese Fehler nicht sehen können, wenn immer nur aus Deutschland gecrawlt wird. Aber wie wird der Googlebot behandelt, dessen IP in der Regel aus den USA kommt?

Was Website-Betreiber beachten sollen

Ein Website-Betreiber sollte nicht nur die Möglichkeiten seines Tools kennen, sondern auch die fehlerhaften Lücken, damit er sie durch eigene Analysen – oder weitere Werkzeuge – schließen kann. Dafür ist es wichtig, dass er die Features seines Tools in- und auswendig kennt. Viele Hersteller bieten mittlerweile Zertifizierungen oder Online-Tutorials an, die Betreiber nutzen können.

Das Wissen beschränkt sich aber nicht nur auf das Tool an sich. Die digitalen Helfer zeigen oft Probleme auf, helfen aber nicht sonderlich gut bei der Lösung. Ein Beispiel: Die Klicktiefe einer Seite ist zu hoch. Wie ist dieses Problem zu lösen? Ein Betreiber sollte deshalb nicht nur in dem Tool, sondern vor allem auch im Bereich SEO insgesamt hinreichend geschult sein, um die richtigen Entscheidungen abzuleiten.

Ihm sollte etwa klar sein, dass Onpage-Tools nicht alle Fehler aufdecken können. Eine Website mit null Fehlern bedeutet nicht, dass diese auch fehlerfrei ist. Sie könnte massive Defizite hinsichtlich der Keyword-Abdeckung haben, ohne dass das Tool Alarm schlagen würde. Außerdem sind viele Fehler systematischer Natur. Ein Fehler kann bei 10.000 Seiten auch 10.000 Mal auftreten. Website-Betreiber sollten sich von hohen Fehlerzahlen also nicht abschrecken lassen.

Der vielleicht wichtigste Hinweis: Nutzer von Onpage-Tools sollten ihrer eigenen Einschätzung trauen. Von den Tools gelieferte Empfehlungen sind nicht unbedingt für den einzelnen Betreiber relevant. Wer 10.000 zu lange Meta Descriptions hat, sollte diese nicht alle manuell einkürzen – in der Regel wäre das wirtschaftlich nicht sinnvoll. Am Ende liegt es also vor allem in der Entscheidung des Nutzers, ob eine Änderung wirklich einen Ranking-Vorteil bringt oder ob sie ein „Nice-to-have“ ist.

Bitte beachte unsere Community-Richtlinien

Wir freuen uns über kontroverse Diskussionen, die gerne auch mal hitzig geführt werden dürfen. Beleidigende, grob anstößige, rassistische und strafrechtlich relevante Äußerungen und Beiträge tolerieren wir nicht. Bitte achte darauf, dass du keine Texte veröffentlichst, für die du keine ausdrückliche Erlaubnis des Urhebers hast. Ebenfalls nicht erlaubt ist der Missbrauch der Webangebote unter t3n.de als Werbeplattform. Die Nennung von Produktnamen, Herstellern, Dienstleistern und Websites ist nur dann zulässig, wenn damit nicht vorrangig der Zweck der Werbung verfolgt wird. Wir behalten uns vor, Beiträge, die diese Regeln verletzen, zu löschen und Accounts zeitweilig oder auf Dauer zu sperren.

Trotz all dieser notwendigen Regeln: Diskutiere kontrovers, sage anderen deine Meinung, trage mit weiterführenden Informationen zum Wissensaustausch bei, aber bleibe dabei fair und respektiere die Meinung anderer. Wir wünschen Dir viel Spaß mit den Webangeboten von t3n und freuen uns auf spannende Beiträge.

Dein t3n-Team