SEO-Audit in 13 Schritten: So optimierst du deine Suchmaschinen-Rankings

(Grafik: Shutterstock)

Ein SEO-Audit untersucht meistens, ob die Prozesse, Anforderungen und Richtlinien nach allen Regeln der Suchmaschinenoptimierung durchgeführt worden sind. Wenn das nicht der Fall ist, hilft ein solches Audit zu identifizieren, wo die Optimierungspotentiale liegen und wo ungenutzte Chancen im Ranking oder in der Qualitätsverbesserung einer Webseite liegen. In großen Agenturen, die sich auf Suchmaschinenoptimierung spezialisiert haben, ist dieses Vorgehen state of the art. Auch größere Inhouse-Teams bedienen sich solcher Listen. Dieser Artikel zeigt in 13 Schritten, wie man ein professionelles und strukturiertes SEO-Audit sorgfältig planen und erfolgreich durchführen kann.

SEO-Audit richtig planen

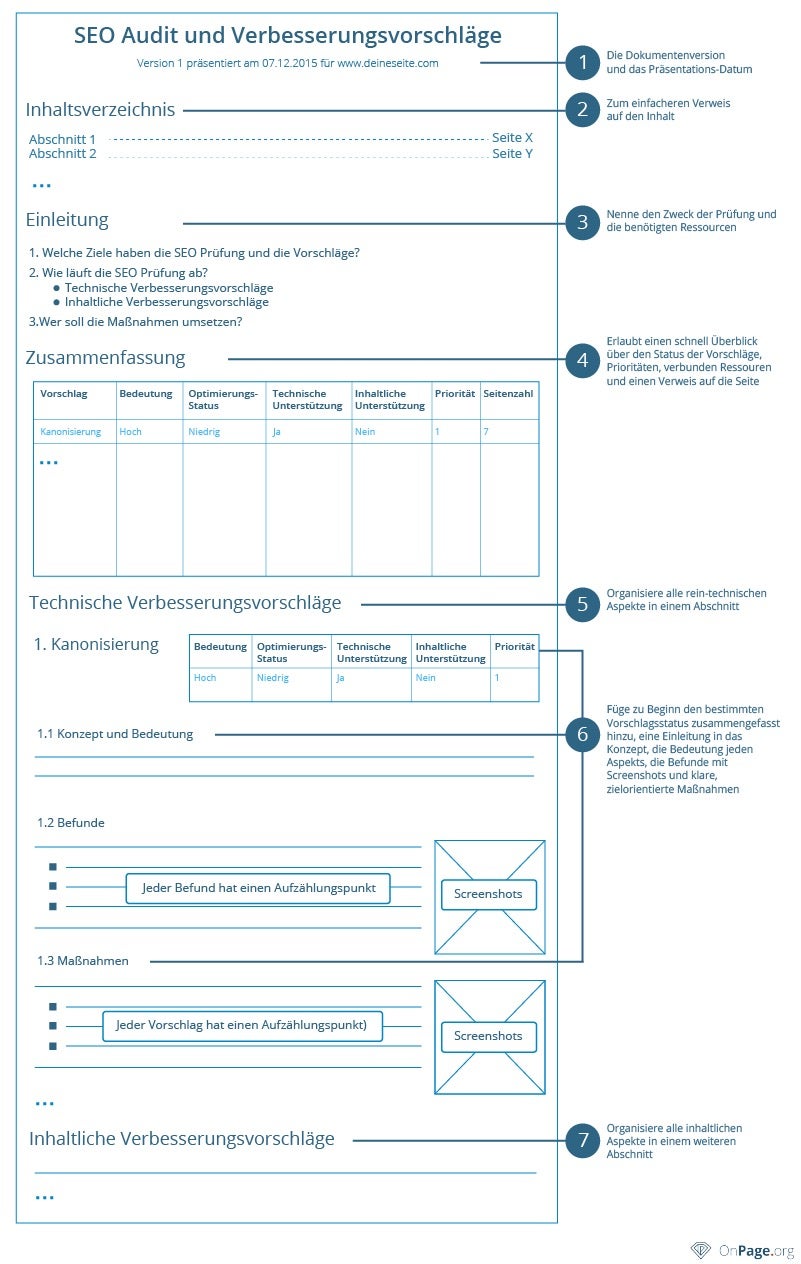

SEO-Audit-Template zum Planen und Nachfassen. (Grafik: aleydasolis.com)

Bevor man sich an die ausführliche SEO-Analyse wagt, sollte man sich zunächst einen gut durchdachten Plan zurecht legen. Die meisten können es kaum erwarten, direkt die Analyse zu starten und riskieren somit, einige der wesentlichen Faktoren aus den Augen zu verlieren. Auch das Nachfassen kann zu kurz kommen oder die Deadlines nicht eingehalten werden. Es ist also empfehlenswert, einen Plan zu erstellen, an dem man auch in Teams festhält. Wichtig ist, die wichtigen Suchmaschinenfaktoren dabei zu berücksichtigen. Auf dem Markt gibt es eine Reihe Templates und Best-Practice-Beispiele, wie eine SEO-Audit-Planung aussehen kann. Dabei können viele Kriterien wie Priorisierung oder Deadlines zur Umsetzung berücksichtigt werden.

Status Quo ermitteln

Ein SEO-Audit startet für gewöhnlich mit einer eingehenden Analyse der Website. Hierfür ist es empfehlenswert, diverse automatisierte Werkzeuge in Anspruch zu nehmen, da der manuelle Aufwand bei größeren Websites enorm hoch sein kann. Es gibt eine Reihe an kostenlosen und kostenpflichtigen Analyse-Tools, die eine Website vollständig oder teilweise überprüfen können. Im Idealfall berücksichtigen die Tools nicht nur das technische Setup einer Website, sondern gehen auf die internen Links, Content- und Website-Architektur ein. So kann man mit einem Werkzeug sämtliche Bereiche einer Website analysieren, ohne dass man mehrere Auswertungen zusammenführen muss. In der Praxis hat sich der Einsatz der Google-Search-Console bewährt. Die Google-Search-Console ist ein kostenloser Dienst von Google, bei dem Website-Inhaber ihre Websites mit der Search-Console verbinden und verschiedene Suchdaten analysieren können. Das Tool von Google gibt einen guten Überblick über die Strukturfehler, Code-Unstimmigkeiten oder kaputte Links. Anhand der Analyse können entsprechende Optimierungsmaßnahmen abgeleitet werden. Die Search-Console ermöglicht zwar einen guten Überblick über die Website-Daten. Wer jedoch noch tiefer in die Analyse einsteigen möchte, um tiefergehenden Daten zu bekommen, kann zusätzlich auch auf Tools wie Screaming Frog oder OnPage.org zurückgreifen.

Hinweis: Stell euch darauf ein, dass ihr ab diesem Zeitpunkt eine unglaublich große Datenmenge bekommt und die Daten gegebenenfalls auch zusammenführen müsst. Wenn euer Webauftritt sehr groß ist, empfiehlt es sich, sich zunächst nur auf die wichtigen Website-Bereiche zu beschränken.

Nach der Ermittlung des Status Quo kann das eigentliche SEO-Audit durchgeführt werden. Auf diese 13 Kriterien solltet ihr besonders achten, wenn ihr eine Website hinsichtlich Suchmaschinenfaktoren „auseinander nehmen“ wollt.

- Zugänglichkeit

- Seiten im Index analysieren

- Seitenstruktur nachvollziehen

- Interne Links

- Externe Links

- OnPage-Faktoren

- Content

- Keywords

- Wichtige SEO-KPIs

- Mobile

- International

- Rich Snippets

- Local SEO

1. Zugänglichkeit prüfen (Accessibility)

Eine wichtige Voraussetzung für eine erfolgreiche Aufnahme einer Webseite in den Index ist ihre Zugänglichkeit. Es ist wichtig, sicher zu stellen, dass der Suchmaschinen-Bot die Seite korrekt überprüfen (crawlen) kann. Der Bot von Google wird als Google-Bot bezeichnet. Es ist ein Crawler, der die vorhandenen Webseitendaten erfasst, damit diese zum späteren Zeitpunkt indexiert werden können.

Auch hier kann die Search-Console Abhilfe schaffen, indem sie eine Webseite wie der Google-Bot überprüft und beim Crawling gefundene Fehler anzeigt. Der Google-Bot kann folgende Aktionen durchführen:

- Erfassen von HTML-Dateien, Images, PDFs und anderen Dateienformaten

- Erfassen von JavaScript, Ajax und CSS

- Annahme der Cookies

- URL-Normalisierung

- Berücksichtigung der Robots.txt-Datei

- Überprüfung von Subdomains

- Sitemap berücksichtigen

- Blockierte URLs ignorieren

- uvm.

Der Google-Bot arbeitet so die Dokumente einer Webseite durch, folgt den Links, die sich auf den Seiten befinden und hat das Ziel, die gefundenen und relevanten Seiten entsprechend zu indexieren. Sobald der Bot eine Seite besucht, kann er als solcher identifiziert werden:

- Googlebot – „Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)“

Um die Zugänglichkeit von bestimmten Seiten zu gewährleisten, sollte man bestimmte Regeln beachten, damit der Google-Bot alle wichtigen Seiten crawlen kann.

Robots.txt

Beispiel einer robots.txt von otto.de.

Die Robots.txt-Datei ist eine Textdatei, die im Root-Verzeichnis hinterlegt wird und bestimmte Anweisungen für Crawler enthält. Bevor ein Suchmaschinencrawler mit dem Crawling beginnt, wird nach dieser Datei explizit gesucht und deren Anweisungen berücksichtigt.

Meta Tag „robots“

So wird das Meta-Tag „robots“ im Code deklariert.

Das Meta-Tag „robots“ ist ein Meta-Tag, das im Header einer Seite deklariert wird. Es beinhaltet zwei Attribute, die dem Bot mitteilen, wie die Vorgehensweise für diese Seite erfolgen muss. Die vier Eigenschaften, die man im Tag mitgeben kann, sind: index oder noindex und follow oder nofollow. Dabei weisen die „index“- und „noindex“-Attribute auf die Indexierung hin und „follow“ beziehungsweise „nofollow“ auf das Crawling und das Folgen der vorhandenen internen und externen Links auf einer Seite.

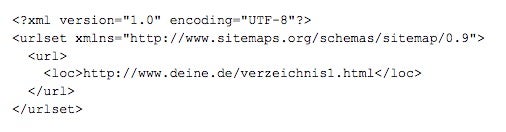

Sitemap.xml

Beispiel einer XML-Sitemap-Datei.

Die Sitemap ist eine Datei, die dem Crawler lediglich helfen kann, die richtigen und wichtigen Inhalte zu erfassen. Im Gegensatz zum robots-Tag und der robots.txt kann die Sitemap den Crawler nicht blockieren. Jedoch kann man in einer sitemap.xml sinnvolle indexrelevante Seiten hinterlegen, die dem Nutzer einen eindeutigen Mehrwert bieten. Darunter ist es auch möglich, bestimmte Seiten Google vorzuschlagen, die eine besonders hohe Priorität haben.

Ausschließen muss auch mal sein

Es können jedoch auch bestimmte Daten existieren, die sensibel sind und nicht im Suchmaschinenindex erscheinen sollen. Das könnten Listen mit Duplikat-URLs sein, der Login-Bereich einer Webseite oder Payment-Seiten. Auch Impressum und Datenschutzbestimmungen sind Klassiker unter den auszuschließenden Seiten. Diese sollten dann vom Crawling bewusst, mittels der oben genannten Maßnahmen, ausgeschlossen werden.

Die Zugänglichkeit für Suchmaschinen ist sehr wichtig für SEO, deshalb sollte man sich diesem Thema insbesondere widmen. Beantwortet man im Rahmen des SEO-Audits diese Fragen, dann ist man schon auf der sicheren Seite:

- Ist der Google-Bot als Crawler zugelassen? (robots.txt/User-Agent-Weiche)

- Wird die Webseite regelmäßig von Google gecrawlt?

- Werden wichtige Verzeichnisse oder Unterseiten blockiert?

- Existiert eine gültige sitemap.xml?

- Werden wichtige Inhalte der Webseite durch die robots.txt oder über die Robots-Meta ausgeschlossen?

2. Seiten im Index analysieren

Bei einem SEO-Audit gilt es vor allem zu identifizieren, welche Seiten die Suchmaschine erfasst und welche tatsächlich in den Suchmaschinen-Index kommen, sprich indexiert werden. Das ist eine wichtige Voraussetzung, da Suchmaschinen nur indexierte Seiten ranken können.

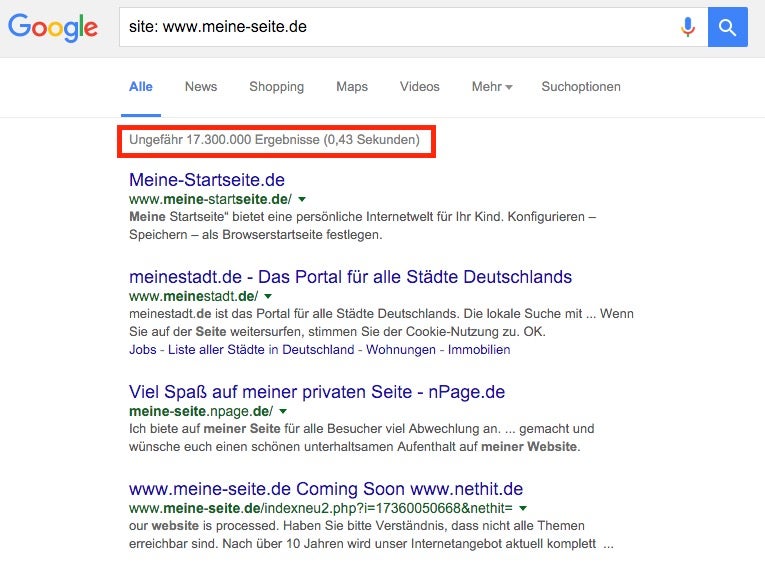

Einen ersten Überblick kann eine einfache site-Abfrage bei Google liefern. Dafür gebt ihr einfach „site:www.meine-domain.de“ in die Google-Suchmaske ein. Oberhalb der Suchergebnisse erscheint daraufhin die Anzahl der indexierten Seiten.

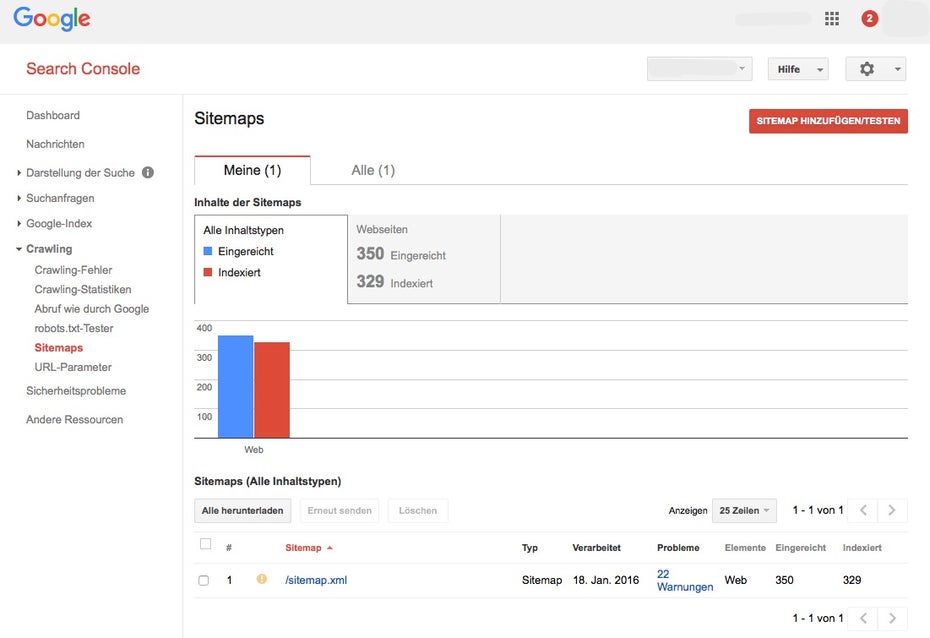

Eine Indexierung kann, wie oben schon erwähnt, nicht ohne Crawling erfolgen. Es muss also gewährleistet sein, dass die Seiten nicht blockiert, weitergeleitet, fehlerhaft sind oder andere Attribute enthalten, die das Crawling der einzelnen URL verhindern. Den Indexierungsstatus einer kompletten Website kann man innerhalb der Google-Search-Console abrufen und überprüfen.

Ein Indiz für die ungefähre Anzahl der indexierten Seiten bei Google. (Screenshot: Google)

Sind die Seiten im Index, können diese in den Suchergebnissen bei relevanten Keywords erscheinen. Das heißt also, die Seiten, die im Index sind, haben schon mal das Zeug dazu, gut zu ranken. Problematisch wird es, wenn das Verhältnis zwischen indexierbaren und nicht indexierbaren Seiten zu Lasten der nicht indexierbaren URLs geht. Das kann ein Indiz dafür sein, dass etwas mit der Seitenstruktur nicht stimmt oder bestimmte Seiten gesperrt werden. Solche Aspekte gilt es beim SEO-Audit herauszufinden.

Diese Fragen sollten im Hinblick auf die indexierten Seiten bei einem SEO-Audit gestellt werden, um Fehler zu identifizieren und zu sehen, ob bei der Indexierung etwas schief gelaufen ist:

- Wieviele Seiten sind im Index?

- Wieviele Seiten sollten im Index sein?

- Sind die wichtigen Bereiche indexiert?

- Anzahl der URLs, die in der Sitemap hinterlegt sind versus wieviele sind im Index?

- Weisen wichtige Bereiche der Website keinerlei Besucher über Suchmaschinen vor?

In der Google-Search-Console könnt ihr eure Sitemap überprüfen. (Screenshot: Google)

3. Seitenstruktur nachvollziehen

Die Website-Architektur spiegelt den Aufbau des Webauftritts wider und erfüllt eine wichtige Doppelfunktion. Zum einen hilft sie den Besuchern, schnell zum Ziel zu finden und zum anderen erleichtert sie dem Google-Bot das Crawling und somit auch die Indexierung. Eine verschachtelte Verzeichnis-Struktur oder untereinander schlecht verlinkte Unterseiten können sich nachteilig auf das Crawling auswirken.

Diese Fragen helfen, beim SEO-Audit zu identifizieren, ob die Seiten sinnvoll strukturiert und sauber miteinander verknüpft sind.

- Ist die Seitennavigation leicht verständlich und nicht zu komplex?

- Verfügt eure Seite über eine Breadcrumb-Navigation, welche Besuchern und Bots zusätzlich Orientierung gibt?

- Sind alle wichtigen Unterseiten in maximal vier Klicks erreichbar?

- Weist die Seitenhierarchie zu viele Ebenen auf?

- Sind die Unterseiten richtig kategorisiert und thematisch miteinander verknüpft?

- Sind die URLs sprechend und nicht zu lang?

4. Interne Links

Die interne Verlinkung spielt bekanntlich eine bedeutende Rolle im Ranking-Algorithmus der Suchmaschinen. Die Startseite gilt dabei als das zentrale Element einer Website und enthält weiterführende Links zu den einzelnen Unterseiten. Je nach Website können die Unterseiten kategorisiert werden und auf weitere thematisch passende Seiten verlinken. So entsteht ein heterogenes, hierarchisches Konstrukt, das eine Suchmaschine einwandfrei crawlen und indexieren kann. Leider kommt dieses Szenario in der Praxis selten vor, da die Linkstruktur häufig unter verwaisten Seiten, Fehlerseiten oder falsch weitergeleiteten Unterseiten leidet.

Die Suchmaschine Google misst zusätzlich jeder Seite einen bestimmten Wert bei. Dieser Wert spiegelt die Stärke einer Seite wider, die durch ein- und ausgehende Verlinkungen beeinflusst wird. Diese Berechnung ist ein wichtiger Teil des Google-Algorithmus (Pagerank-Berechnung) und spielt (nach wie vor) eine bedeutende Rolle fürs Ranking.

Die Stärke einer Website kann mithilfe von diversen Tools ermittelt werden, damit man nachvollziehen kann, welche Seiten besonders stark sind und potentiell höher im Ranking platziert werden können.

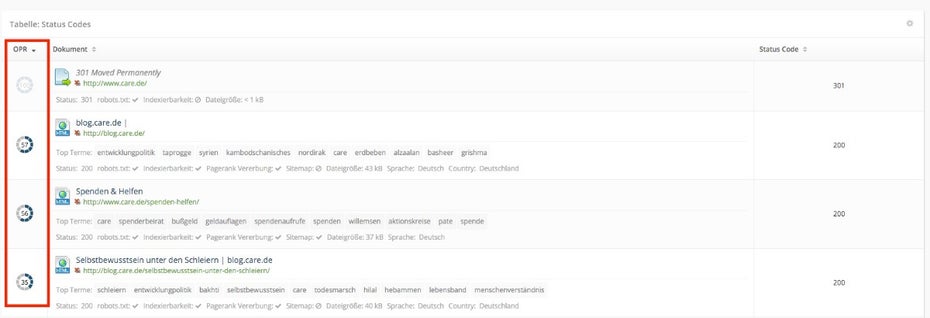

OPR-Werte bei OnPage.org zeigen die Stärke einer Seite innerhalb des Websitekonstrukts. (Screenshot: OnPage.org)

Bei einem SEO-Audit ist es empfehlenswert, folgende Faktoren, die die internen Links betreffen, zu identifizieren:

- Gibt es Fehlerseiten?

- Gibt es verwaiste Seiten?

- Sind Seiten falsch weitergeleitet?

- Gibt es Widersprüche bei der Verlinkung?

- Gehen mehr als 100 Links von einer Seite aus?

- Gibt es wichtige Seiten mit zu wenig Links?

- Sind relevante Seiten „zu weit“ von der Startseite entfernt (Klickpfad)?

5. Externe Links

Die Analyse der externen Links, also Links, die von anderen Domains auf die eigene Webseite eingehen, sind ebenfalls ein fester Bestandteil eines SEO-Audits. Achtet vor allem auf externe Links von Spam-Seiten oder auf eine ungewöhnlich hohe Anzahl Links von außerhalb. Diese können eurer Website möglicherweise einen „schlechten Ruf“ bei Suchmaschinen verschaffen. Bei der Analyse externer Links ist es empfehlenswert, die Linkpopularität genauer anzusehen. Je mehr Links von unterschiedlichen Domains auf die eigene Webseite zeigen, desto höher ist die Linkpopularität dieser Seite, das heißt je mehr Seiten eine Webseite empfehlen, desto vertrauenswürdiger ist diese.

Hier sind einige Fragestellungen zum sogenannten Linkprofil einer Webseite, die im Rahmen des SEO-Audits beantwortet werden sollen.

- Sind die externen Links themenrelevant zu der verlinkenden Seite/URL?

- Sind auffällig viele externe Links von einer Domain vorhanden (Sidewide Links)?

- Sind zu viele verdächtige gegebenenfalls Spam-Links vorhanden?

- Verlinken externe, vertrauenswürdige Webseiten auf die analysierte Webseite?

- Gibt es viele Links zur Startseite und nur sehr wenige auf einzelne Unterseiten?

- Liefert Google über die Google-Search-Console irgendwelche Informationen zu den eingehenden Links (zum Beispiel Penalty)?

- Gibt es wertvolle Links, die viele Besucher auf eine bestimmte Unterseite liefern?

6. OnPage-Faktoren

Es gibt eine Reihe weiterer wichtiger Faktoren, die ihr bei einem gründlichen SEO-Audit im Auge behalten solltet.

- Meta-Title: Dieses Tag im Header einer Seite wird im Snippet in der Suchergebnisliste von Google angezeigt. Der Title sollte nicht mehr als 55 Zeichen beinhalten und dient als Überschrift der Seite. Jeder Title sollte einzigartig sein.

<meta name="title" content="OnPage.org: Für bessere Webseiten!"> - Meta-Description: Diese Meta-Angabe ist zwar nicht rankingrelevant, doch sie wird von Google ebenfalls im Search-Snippet verwendet. Mit der Description kann die Klickrate in den SERPs erhöht werden. Hier sind maximal 155 Zeichen erlaubt, sonst wird diese in der Anzeige abgeschnitten. Jede Description sollte nur einmal verwendet werden. Fehlt diese, sucht sich Google eine passende selbst aus.

<meta name="description" content="Beschreibungstext"> - H-Tags für Überschriften: Überschriften-Tags sollten chronologisch verwendet werden (h1-h6) und dem Webseiten-Content eine sinnvolle Struktur geben. Dabei soll nur ein H1-Tag pro Seite verwendet werden (Hauptüberschrift).

Diese Fragen gilt es während eines SEO-Audits im Hinblick auf OnPage-Faktoren zu beantworten:

- Sind Title-Tags doppelt vorhanden?

- Gibt es Title-Tags, die zu kurz, zu lang oder gar nicht vorhanden sind?

- Welche Descriptions der Seiten sind zu lang, zu kurz oder gar nicht gesetzt?

- Gibt es doppelte H1-Überschriften?

- Sind die Überschriften h1 bis h6 in der falschen Reihenfolge gesetzt?

7. Content

Der Webseiten-Content, also der eigentliche Inhalt einer Seite, ist das, was die Webseiten-Besucher wahrnehmen. In der Regel handelt es sich dabei um textliche Inhalte. Aber auch Bilder, Videos und interaktive Elemente, die mit JavaScript und CSS erstellt werden, zählen zum Content dazu. Es besteht unter anderem die Möglichkeit, mit Bildern oder Videos in der vertikalen Bilder-Suche bei Google zu ranken und zusätzlichen Traffic dadurch zu generieren.

Für die Suchmaschinen sind vor allem der Kontext sowie die Einzigartigkeit der Inhalte wichtig. All das sollte im SEO-Audit geprüft werden, um künftig die Inhalte besser zu optimieren.

Folgende Aspekte solltet ihr beim SEO-Audit kontrollieren:

- Gibt es Seiten mit 1:1 identischen Inhalten?

- Gibt es Seiten, die sich vom Inhalt her sehr ähneln?

- Existieren Seiten mit sehr wenig Text (weniger als 300 Wörter)?

- Ist das Verhältnis zwischen Code und Text optimal?

- Sind Alt-Tags bei allen Bildern vorhanden?

- Sind die Bilder entsprechend komprimiert?

8. Keywords

Eine Webseite ist in Suchmaschinen dann erfolgreich, wenn sie bei relevanten Suchbegriffen (vulgo: Keywords) entsprechend auf höheren Positionen platziert ist und die Fragen der Suchenden beantwortet. Die Beobachtung, welche Keywords sich auf welchen Positionen im Google-Ranking befinden, ist essenziell wichtig und sollte auch im Rahmen eines SEO-Audits geprüft werden.

Auch die Positionen der Mitbewerber sowie die Ermittlung der Ranking-Potenziale spielt in diesem Zusammenhang eine große Rolle. Die genauen Platzierungen lassen sich auch mit Hilfe diverser Tools (wie zum Beispiel der Google-Search-Console, Sistrix, Searchmetrics oder OnPage.org) ermitteln.

Im Rahmen der SEO-Audits solltet ihr auf folgende Fragestellungen eingehen:

- Auf welcher Position ranken meine Brand-Keywords?

- Welche Suchbegriffe ranken auf Position 1 und bringen den meisten Traffic?

- Mit welchen Begriffen rankt meine Seite auf Position 1 und welche Begriffe haben das Potenzial, höher zu ranken?

- Wie ist die Ranking-Verteilung über alle Keywords hinweg?

- Was sind die Gewinner und Verlierer unter den Keywords?

- Wie hoch ist das Suchvolumen für meine Keywords?

- Für welche Keywords werde ich noch nicht gefunden?

- Gibt es für meine relevanten Keywords auch entsprechende Landingpages?

9. Wichtige SEO KPIs ermitteln

Bei jedem SEO-Audit dürfen die wichtigsten Kennzahlen (vulgo: Key-Performance-Indicators oder KPIs) nicht fehlen. Diese Kennzahlen gelten als wichtige Ranking-Faktoren und werden von Suchmaschinen bei der Beurteilung der Webseiten berücksichtigt. Es ist also ratsam, diese Faktoren in das SEO-Audit mit einzubeziehen, um darauf eine Optimierungsstrategie aufbauen zu können.

- Bounce-Rate und Verweildauer: Mit Hilfe dieser Kennzahlen erhaltet ihr deutliche Hinweise, ob Nutzer eure Inhalte konsumieren oder eure Seite schnell wieder verlassen. Wichtig ist es, die beiden Daten kritisch und voneinander abhängig zu prüfen. Ist die Absprungrate hoch und die Verweildauer niedrig, könnte das einen Hinweis auf uninteressanten Content oder eine komplizierte Navigation sein.

- Click-Through-Rate (CTR): Diese Kennzahl verrät, wie häufig Nutzer in den Google-Suchergebnissen auf die Search-Snippets eurer Webseite geklickt haben im Vergleich zu den Impressions (Anzeige) der Snippets. Die CTR kann Aufschluss über die Optimierung der Meta-Angaben (Title und Description) geben.

- Organischer Traffic: Anhand der eindeutigen Besucher aus dem SEO-Kanal kann man nachvollziehen, welche Seiten am meisten besucht werden und woher die Seitenbesucher überhaupt kommen (zum Beispiel über externe Links). Durch intensive Traffic-Beobachtung, können Rückschlüsse auf Saisonalität sowie auf das Nutzerverhalten im Allgemeinen gegeben werden. Der organische Traffic ist gegenüber anderen Traffic-Kanälen (Paid Search oder Social) sehr günstig.

Diese Fragen sollten im Rahmen eines SEO-Audits bezüglich SEO-KPIs gestellt werden:

- Welche SEO-KPIs sind für meine Seite relevant?

- Wie verhalten sich User auf meinen Seiten?

- Wie häufig wird die Webseite innerhalb der Suchergebnislisten geklickt?

- Wie wichtig ist der Traffic-Kanal „Organic Traffic“ im Gesamt Online-Marketing-Mix?

10. Mobile

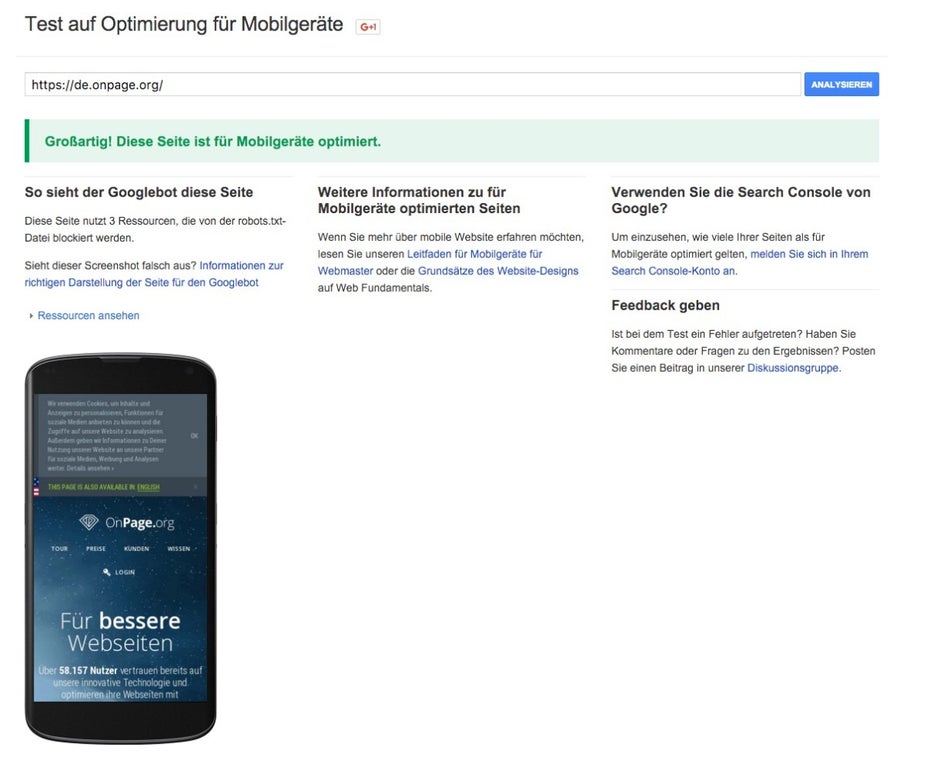

Mobile Friendliness mit dem Google-Test-Tool. (Screenshot: Google)

Mobile Friendliness ist seit April 2015 ein offizieller Ranking-Faktor von Google. Zugleich steigt die Zahl der mobilen Internetnutzer kontinuierlich an, umso wichtiger ist deshalb die mobile Optimierung von Webseiten. Ob eine Webseite die Kriterien für Mobilgerätefreundlichkeit erfüllt, kann man mit diversen Tools wie OnPage.org Focus oder Googles „Test auf Optimierung für Mobilgeräte“ testen. Auch in der Google-Search-Console findet man Hinweise zur Mobile-Optimierung im Abschnitt „Suchanfragen/Nutzerfreundlichkeit auf Mobilgeräten“.

Die wichtigsten Prüfelemente hinsichtlich der mobilen Nutzung für ein SEO-Audit wären folgende:

- Ist die Webseite auf mobilen Geräten aufrufbar und gut lesbar?

- Wird Responsive Webdesign, Dynamic Serving oder eine mobil-optimierte Subdomain eingesetzt?

- Wird der Viewport-Metatag, Vary-Header oder das Tag rel=alternate verwendet?

- Sind die Formulare/Buttons gut sichtbar und klickbar?

- Wird die Seite auch ohne LTE-Verbindung schnell geladen?

- Funktionieren alle wichtige Funktionen (Kontaktformular, Buchungsstrecke) meiner Seite auch auf den wichtigsten Mobilgeräten?

11. Internationale Ausrichtung

Viele Unternehmen stehen heute im globalen Wettbewerb und betreiben mehrsprachige Seiten, die zusätzlich auf einzelne Länder ausgerichtet sind. Sollte das der Fall bei einer Webseite sein, gilt es zu überprüfen, ob diese über die entsprechende Auszeichnung im Quellcode verfügt. Suchmaschinen können mit Hilfe des hreflang-Attributs leichter erkennen, für welches Land und welche Sprache die Inhalte ausgelegt sind und die Seite dementsprechend indexieren. Darüber hinaus hilft das hreflang-Attribut dabei, doppelte Inhalte durch Übersetzungen zu vermeiden.

Das hreflang-Attribut kann sowohl im head-Bereich einer Seite als auch im Response-Header oder in der sitemap.xml aufgeführt werden.

Diese Fragestellungen sollten im Zusammenhang mit Mehrsprachigkeit und Internationalisierung in einem SEO-Audit berücksichtigt werden:

- Welche Sprachen werden verwendet?

- In welchen Ländern ist die Seite aktiv?

- Sind die hreflang-Tags widersprüchlich gesetzt?

- Über wieviele Übersetzungsversionen verfügt jede Seite?

- Sind die übersetzten Seiten alle erreichbar oder liegen Fehler vor?

- Werden die für ausgewählte Sprachen und Länder definierten Seiten auch in den jeweiligen Märkten gefunden?

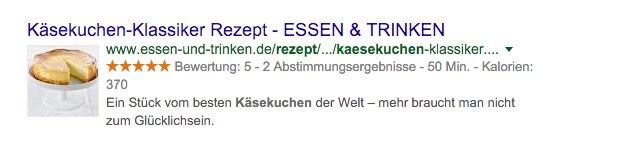

12. Rich Snippets

Um sich in den Suchergebnissen von Mitbewerbern abzuheben, bietet sich der Einsatz der Rich Snippets an. Dabei handelt es sich um ein Markup, das dabei hilft, Suchergebnis-Snippets mit zusätzlichen Daten wie Bewertungssternen, Preisen oder ähnlichem anzureichern. Damit Google und andere Suchmaschinen diese Daten berücksichtigen können, sollten diese im Quellcode entsprechend ausgezeichnet sein.

Rich Snippets in der Praxis bei essen-und-trinken.de. (Screenshot: Google)

Im Rahmen eines SEO-Audits kann man überprüfen, ob Markups korrekt verwendet werden. Dies kann beispielsweise mit Hilfe dieses Google-Tool erfolgen oder auch in der Search-Console unter dem Menüpunkt „Strukturierte Daten“ unter „Darstellung der Suche“. Weitere Hinweise zu Markups findet ihr auf schema.org.

Diese Fragestellungen können beim SEO-Audit im Bereich Rich Snippets aufkommen:

- Welche Daten können perspektivisch strukturiert werden?

- Sind Markups schon vorhanden?

- Sind Auszeichnungen im Quellcode syntaktisch korrekt erfolgt?

- Werden die Auszeichnungen in den Suchergebnissen angezeigt?

13. Local SEO

Local SEO ist für Unternehmen wichtig, die lokal agieren. Die interessierten Kunden beginnen ihre Suche schon online, bevor sie einen lokalen Anbieter aufsuchen. Im Zuge eines SEO-Audits sollte man dies berücksichtigen und gegebenenfalls das Google-My-Business-Profil überprüfen. Das ist ebenfalls von Bedeutung, wenn die Inhalte auf der Seite lokalen Bezug haben. Mit dem Eintrag teilt man der Suchmaschine die Eckdaten des Unternehmens mit, damit diese den lokalen Bezug des Unternehmens herstellen kann:

Diese Fragestellungen können beim SEO-Audit berücksichtigt werden:

- Existiert ein Google-My-Business-Eintrag?

- Finden sich lokale Bezüge in Title, Description, Überschriften und Content?

- Verlinkt euer My-Business-Profil auf eure Website?

- Verwendet ihr einen ausführlichen Beschreibungstext in eurem My-Business-Profil?

- Sind eure Unternehmensangaben (Adresse, Kontaktdaten) noch aktuell?

Alles in einem

Die oben erwähnten 13 Schritte eines SEO-Audits und die dazugehörigen Fragestellungen können dabei helfen, die Analyse einer Seite strukturiert durchzuarbeiten und eine Webseite ganz genau unter die Lupe zu nehmen (es gibt jedoch noch weitere Faktoren, die den Rahmen des Artikels an dieser Stelle sprengen würden). Wichtig ist, anschließend aus den Analysen korrekte Optimierungsmaßnahmen abzuleiten. Die Folgemaßnahmen helfen dabei, bessere Performance bei Suchmaschinen zu erreichen und die Website strategisch und technisch auf Vordermann zu bringen. So seid ihr bereit, die oberen Positionen im Ranking zu erobern: Mit einem sinnvollen SEO-Audit.

Über die Autorin

Irina Hey ist Head of Marketing & Communications bei OnPage.org, All-in-One-Software-Anbieter für bessere Webseiten. Die langjährige leidenschaftliche Online-Marketing-Expertin veröffentlichte schon zahlreiche Beiträge rund um das Thema Webseiten-Optimierung in einschlägigen Büchern und Fachzeitschriften.

Irina Hey ist Head of Marketing & Communications bei OnPage.org, All-in-One-Software-Anbieter für bessere Webseiten. Die langjährige leidenschaftliche Online-Marketing-Expertin veröffentlichte schon zahlreiche Beiträge rund um das Thema Webseiten-Optimierung in einschlägigen Büchern und Fachzeitschriften.

Bitte beachte unsere Community-Richtlinien

Wir freuen uns über kontroverse Diskussionen, die gerne auch mal hitzig geführt werden dürfen. Beleidigende, grob anstößige, rassistische und strafrechtlich relevante Äußerungen und Beiträge tolerieren wir nicht. Bitte achte darauf, dass du keine Texte veröffentlichst, für die du keine ausdrückliche Erlaubnis des Urhebers hast. Ebenfalls nicht erlaubt ist der Missbrauch der Webangebote unter t3n.de als Werbeplattform. Die Nennung von Produktnamen, Herstellern, Dienstleistern und Websites ist nur dann zulässig, wenn damit nicht vorrangig der Zweck der Werbung verfolgt wird. Wir behalten uns vor, Beiträge, die diese Regeln verletzen, zu löschen und Accounts zeitweilig oder auf Dauer zu sperren.

Trotz all dieser notwendigen Regeln: Diskutiere kontrovers, sage anderen deine Meinung, trage mit weiterführenden Informationen zum Wissensaustausch bei, aber bleibe dabei fair und respektiere die Meinung anderer. Wir wünschen Dir viel Spaß mit den Webangeboten von t3n und freuen uns auf spannende Beiträge.

Dein t3n-Team

Schöne Übersicht für einen Einstieg in dieses Thema.

Danke, Elias.

Als Webtexter und Seo-Texter beschäftige ich mich jeden Tag sehr intensiv mit SEO. Das Wichtigste im Online-Marketing ist neben den SEO-Basics auch die Erfüllung der sogenannten Erwartungskonformität. Denken Sie immer an jenes Ereignis, welches das Bedürfnis bzw. das Problem auslöst, welches Sie befriedigen bzw. lösen. Bei der Webseitengestaltung müssen daher folgende fünf Schritte mitberücksichtigt werden:

1. Zeigen Sie das Problem auf!

2. Bieten Sie eine Lösung an!

3. Erklären Sie die Vorteile!

4. Machen Sie den USP klar!

5. Verwenden Sie Call To Action!

Danke, Wolfgang für Dein Input, da kann ich nur zustimmen.

„onpage“: Schreibt doch bitte dazu, dass das WERBUNG ist und ein Haufen Muell auszufuellen ist – von wegen kostenloser Check!

Jetzt haben die eine Menge Daten von mir und ich – gar nichts.

Von t3n kann ich mehr erwarten!

Hallo Natalia,

vielen Dank für Dein Feedback und schade, dass Du den Artikel als Werbung empfindest. Ich habe schon vor OnPage.org SEO-Audits durchgeführt und wollte mein Wissen mit anderen teilen. Zu Deinem Punkt mit der Werbung: Wir bieten einen kostenlosen Free-Account an. Der kostenlose Website-Check ist keine Verarsche oder ähnliches. Hattest Du die Zugangsdaten nicht erhalten? Gerne helfen wir weiter. Schreib mir bitte direkt an irina@onpage.org – dann schaue ich mir gerne an, wo es hakt. Beste Grüße!

Super Artikel!

In 99% der Fälle wird der Seiten-Title aber mit dem -Tag definiert.

LG Lukas

Hallo Lukas, vielen Dank für das Lob und die Ergänzung.

Sehr praktisch! Vielen Dank dafür!

Für einen Einstieg finde ich den Artikel wirklich brauchbar, vielen Dank dafür.

Schade, dass es immer jemanden gibt, der meckern muß.

Wirklich gut für den Einstieg, auch heute noch. Nur bei der Robots.txt. ändert sich gerade, dass Google diese in Zukunft evtl. nicht mehr betrachtet.

Kann ich nur zustimmen. Guter Artikel für einen Einstieg ins Thema Suchmaschinenoptimierung!

Wirklich klasse Einsteigerartikel. Gibt eine gute Übersicht.

Ich denke jedoch, dass für eine ganzheitliches SEO Optimierung noch etwas mehr gemacht werden sollte.

LG Sam

Danke für den super Überblick zum SEO Audit – vor allem die Informationen zum Rich Snippet haben mir sehr weitergeholfen!

Vielen Dank für diese tolle Übersicht zu dem Audit – super Einstieg ins SEO, Snippets, robots.txt und Co.