Das Modell sieht ähnlich wie ein Mensch. (Foto: Shutterstock/Artem Oleshko)

Meta hat ein Computer-Vision-Model namens Image Joint Embedding Predictive Architecture (I‑Jepa) vorgestellt. Damit sollen KI-gesteuerte Roboter die Welt so ähnlich wahrnehmen können wie Menschen. Das ist effizienter als bisherige Methoden und liefert bessere Ergebnisse.

Wie I‑Jepa genau funktioniert, erklärt Meta in einem Artikel auf Meta AI und in der dazugehörigen Studie. Wie der Name bereits vermuten lässt, sieht die KI mit dem Modell vorausschauend.

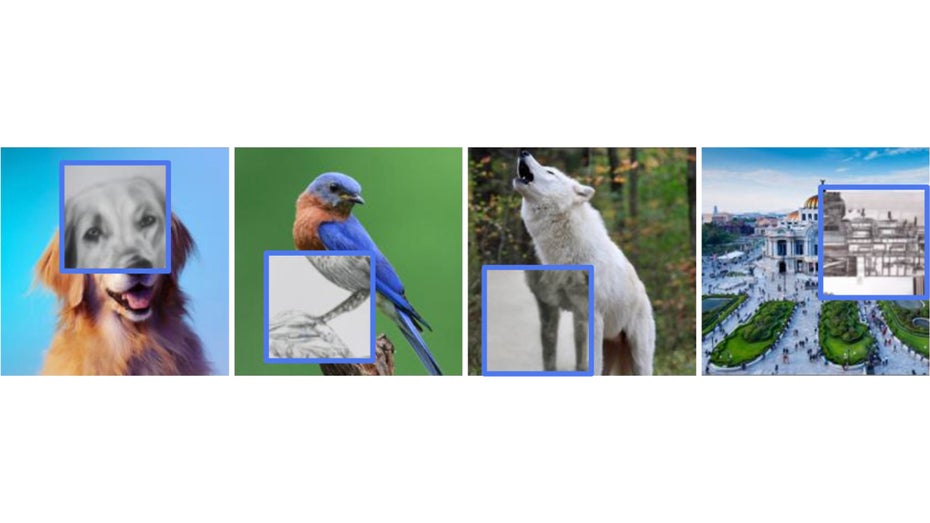

Sie kann also anhand von unvollständigen Bildern „erahnen“ oder errechnen, wie der Rest höchstwahrscheinlich aussehen wird. Meta gibt dafür vier Beispiele von unfertigen Bildern, auf denen jeweils ein Teil fehlt. Es fehlt etwa das Gesicht des Hundes, die Beine des Wolfs und so weiter. Die Zeichnungen in den blauen Kästen sind durch I‑Jepa vervollständigt worden.

I‑Jepa kann Bilder vervollständigen. (Foto: Meta)

I-Jepa kann seine Umgebung nach und nach verstehen

Das Modell kann also fehlende Informationen in Bildern ergänzen und so vorhersagen, wie das Bild aussehen sollte. So ähnlich bauen sich auch menschliche Augen die Welt um sich herum auf. Die Augen können sich nicht zu jedem Zeitpunkt auf alles konzentrieren, was sie im Sichtfeld haben, das menschliche Gehirn ergänzt den wahrgenommenen Eindruck.

Der größte Unterschied zwischen I‑Jepa und anderen Modellen ist, dass das Modell von Meta auf abstrakte Weise lernt und das wahrscheinlichste Erscheinungsbild darstellen kann. Andere Modelle arbeiten hier auf Pixelbasis und füllen jedes Detail aus.

I‑Jepa füllt nur die Lücken, die es braucht, um zu verstehen, worum es sich handelt. Laut Meta führt das zu einem Lernprozess, der I‑Jepa die Umgebung um sich herum nach und nach verstehen lässt. Andere Modelle können das nicht.

Effizienter und bessere Ergebnisse

Durch diese spezielle Funktionsweise soll I‑Jepa nicht nur besser sein als andere Modelle, sondern auch deutlich effizienter arbeiten. Dafür gibt Meta ein Beispiel: Ein visuelles Transformatormodell mit 632 Millionen Parametern wurde mit 16 A100 GPUs innerhalb von 72 Stunden trainiert. Damit erreichte es eine Low-Shot-Klassifizierung in Imagenet.

Laut Meta brauchen andere Modelle dafür zwei- bis zehnmal so viele GPU-Stunden und produzieren höhere Fehlerquoten.

Meta hat das Modell als Open-Source-Code veröffentlicht und möchte es genauer auf der Conference on Computer Vision and Pattern Recognition vom 18. bis zum 22. Juni in Vancouver, Kanada, vorstellen.

Bitte beachte unsere Community-Richtlinien

Wir freuen uns über kontroverse Diskussionen, die gerne auch mal hitzig geführt werden dürfen. Beleidigende, grob anstößige, rassistische und strafrechtlich relevante Äußerungen und Beiträge tolerieren wir nicht. Bitte achte darauf, dass du keine Texte veröffentlichst, für die du keine ausdrückliche Erlaubnis des Urhebers hast. Ebenfalls nicht erlaubt ist der Missbrauch der Webangebote unter t3n.de als Werbeplattform. Die Nennung von Produktnamen, Herstellern, Dienstleistern und Websites ist nur dann zulässig, wenn damit nicht vorrangig der Zweck der Werbung verfolgt wird. Wir behalten uns vor, Beiträge, die diese Regeln verletzen, zu löschen und Accounts zeitweilig oder auf Dauer zu sperren.

Trotz all dieser notwendigen Regeln: Diskutiere kontrovers, sage anderen deine Meinung, trage mit weiterführenden Informationen zum Wissensaustausch bei, aber bleibe dabei fair und respektiere die Meinung anderer. Wir wünschen Dir viel Spaß mit den Webangeboten von t3n und freuen uns auf spannende Beiträge.

Dein t3n-Team