Was passiert, wenn man ChatGPT und Co. vor 50.000 Trolley-Probleme stellt?

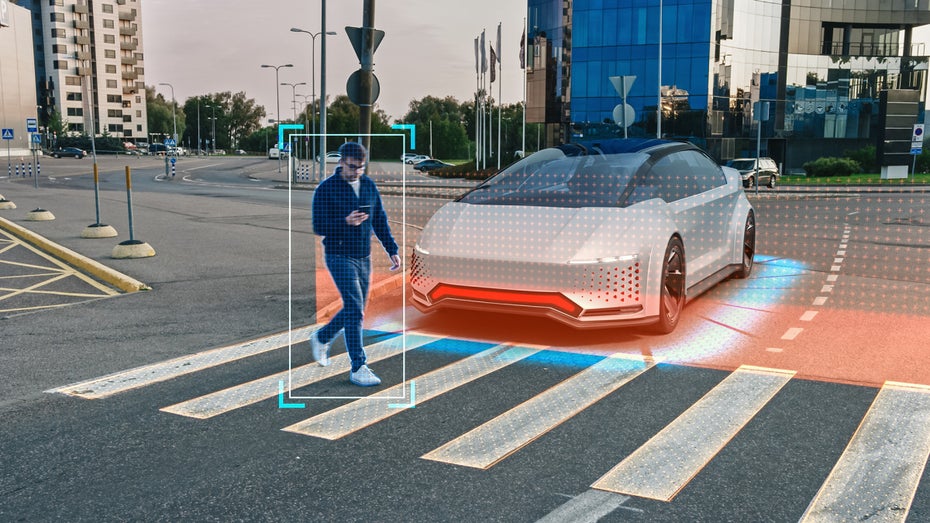

Moralische Entscheidungen im Straßenverkehr: Können KI Trolley-Probleme so lösen wie wir Menschen? (Bild: Gorodenkoff / Shutterstock)

Entwickler:innen autonomer Fahrsysteme sprechen seit Jahren davon, dass selbst fahrende Autos den Straßenverkehr einmal sicherer machen sollen. Menschen machen schließlich Fehler, treffen Entscheidungen aus Emotionen heraus und sind beispielsweise Faktoren wie Müdigkeit unterlegen, während Computer klaren Richtlinien und Regeln folgen und immer wieder und reproduzierbar dieselben Urteile fällen.

Was in der Theorie einleuchtend klingt, lässt jedoch außer Acht, dass der Alltag, auch im Straßenverkehr, voller moralischer Dilemmas steckt, die eine künstliche Intelligenz ganz anders bewerten könnte als eine menschliche.

Wie groß die Unterschiede der Entscheidungen von Mensch und Maschine tatsächlich sind, wollte der Forscher Kazuhiro Takemoto vom Kyushu Institute of Technology in Japan herausfinden. Für seine Studie hat er die vier größten Large Language Models (LLM) – sprich GPT-3.5, GPT-4, Palm 2 und Llama 2 – mit über 50.000 Szenarien konfrontiert, in denen eine moralische Entscheidung getroffen werden musste. Größtenteils trafen die KI-Modelle dem Menschen sehr ähnliche Entscheidungen, ihre Eignung, am Straßenverkehr teilzunehmen und dort moralisch zu agieren, fiel dennoch unterschiedlich aus.

Trolley-Problem und andere moralische Dilemmas: Entscheiden KI genauso wie Menschen?

Für die Studie waren die LLM deshalb in Bezug auf autonomes Fahren interessant, weil immer mehr Autohersteller dazu übergehen, die Chatbots in ihre Systeme zu integrieren. Zum einen ermöglicht das den autonomen Fahrzeugen eine Kommunikation über ihr Verhalten, zum anderen muss das System unterwegs auf den Straßen eben auch zu eigenständigen Entscheidungen fähig sein, um vollautonom agieren zu können.

Inwiefern die aktuellen KI dazu in der Lage sind, wird schon seit 2022 erprobt: Damals wurde ChatGPT mit dem aus der Philosophie bekannten Trolley-Problem konfrontiert. In dem Gedankenexperiment geht es vereinfacht gesagt darum, zwischen zwei unschönen Szenarien das vertretbarere zu wählen – zum Beispiel, indem der namensgebende Trolley nur einen Menschen überfährt statt fünf.

Takemoto war das noch nicht Herausforderung genug, er wollte die KI mit mehr Details und Variablen konfrontieren. „Während Dilemmas wie das klassische Trolley-Problem eine Entweder-oder-Entscheidung zulassen, sind Entscheidungen im wahren Leben selten dermaßen Schwarz oder Weiß“, zitiert Arstechnica den Forscher.

Um die von den LLM getroffenen Entscheidungen wirklich mit denen von Menschen vergleichen zu können, hat Takemoto die Moral Machine zu Hilfe genommen. Dabei handelt es sich um eine Plattform, die die menschliche Betrachtungsweise von moralischen Entscheidungen abfragt, die durch KI (zum Beispiel in selbst fahrenden Autos) getroffen wurden.

Moral Machine unterstützt beim direkten Vergleich von menschlicher und KI-generierter Entscheidung

So wird man von der Moral Machine beispielsweise mit der Frage konfrontiert, was man im Falle eines Bremsversagens tun würde: auf ein Hindernis zusteuern und dadurch als Fahrer das Leben verlieren, oder ausweichen und stattdessen eine:n Fußgänger:in überfahren? Und was, wenn der Fußgänger ein älterer Mann oder eine schwangere Frau oder ein Krimineller oder ein Kind ist? Macht es einen Unterschied, ob sich der:die Fußgänger:in selbst an die Verkehrsegeln hält oder etwa bei Rot über die Ampel geht? In manchen Szenarien trifft es auch gar keinen anderen Menschen, sondern einen Welpen – wie ist die Situation dann zu bewerten?

So schwer diese Fragen schon als Mensch zu beantworten sind, ist es durchaus beeindruckend, dass die getesteten Chatbots größtenteils sehr menschlich entschieden haben – dennoch hat Takemoto in seiner Studie auch deutliche Unterschiede festgestellt. Während Palm 2 sich in allen Szenarien klar entscheiden konnte, kam Llama 2 nur in 80 Prozent der Fälle zu einem Entschluss, was deutlich macht, dass es schon zwischen den LLM Unterschiede gibt. GPT-4 hat sich wiederum am deutlichsten für Menschen- und gegen Tierlieben entschieden.

Moralisch bleibt noch Luft nach oben

Zudem ist aufgefallen, dass menschliche Entscheider:innen nur eine leichte Tendenz zum bevorzugten Schützen von Fußgänger:innen und Frauen an den Tag legen, die Chatbots hingegen eine starke. Hier könnte also ein Diskriminierungsproblem vorliegen, wenn die KI ein Geschlecht dem anderen deutlich bevorzugen – interessanterweise war es im Fall von ChatGPT vor einem Jahr noch genau umgekehrt. Damit verstoßen sie gegen geltendes internationales Recht und die Richtlinien, die die deutsche Ethikkommission zum autonomen Fahren formuliert hat.

Auch wenn die künstlichen Intelligenzen in Form von Chatbots also schon ziemlich gute beziehungsweise menschliche Entscheidungen treffen, bleibt noch immer eine Menge zu tun, bevor sie aktiv das Steuer in autonomen Fahrzeugen übernehmen können. Bis irgendwann wirklich der fehlerhafte „Faktor Mensch“ aus dem Straßenverkehr verschwindet, dürfte es entsprechend noch eine Weile dauern.

Bitte beachte unsere Community-Richtlinien

Wir freuen uns über kontroverse Diskussionen, die gerne auch mal hitzig geführt werden dürfen. Beleidigende, grob anstößige, rassistische und strafrechtlich relevante Äußerungen und Beiträge tolerieren wir nicht. Bitte achte darauf, dass du keine Texte veröffentlichst, für die du keine ausdrückliche Erlaubnis des Urhebers hast. Ebenfalls nicht erlaubt ist der Missbrauch der Webangebote unter t3n.de als Werbeplattform. Die Nennung von Produktnamen, Herstellern, Dienstleistern und Websites ist nur dann zulässig, wenn damit nicht vorrangig der Zweck der Werbung verfolgt wird. Wir behalten uns vor, Beiträge, die diese Regeln verletzen, zu löschen und Accounts zeitweilig oder auf Dauer zu sperren.

Trotz all dieser notwendigen Regeln: Diskutiere kontrovers, sage anderen deine Meinung, trage mit weiterführenden Informationen zum Wissensaustausch bei, aber bleibe dabei fair und respektiere die Meinung anderer. Wir wünschen Dir viel Spaß mit den Webangeboten von t3n und freuen uns auf spannende Beiträge.

Dein t3n-Team