Bewerbungs-KI rankt Kandidaten mit Bücherregalen im Hintergrund besser

Künstliche Intelligenzen scheinen Bücherregale im Hintergrund zu mögen. (Foto: Radu Bercan/Shutterstock)

Im Bewerbungsprozess sollte es möglichst fair und objektiv zugehen – das sollen nicht zuletzt auch Antidiskriminierungsgesetze sicherstellen. Gleichzeitig tragen wir alle aber Vorurteile mit uns herum, ob wir es wollen oder nicht. In diesem Kontext klingen die Versprechungen vieler Unternehmen und Startups, die die Bewerberauswahl an eine künstliche Intelligenz auslagern, verlockend: Die KI hat keinen persönlichen Geschmack, lässt sich nicht von Impulsen leiten und ist absolut neutral. Doch ist das wirklich so?

Algorithmen reagieren auf Accessoires wie Brille oder Kopftuch

Der Bayerische Rundfunk hat in einer groß angelegten Recherche die Verhaltensanalyse-KI des Startups Retorio aus München getestet. Dabei kam heraus, dass die Algorithmen durchaus zu unterschiedlichen Ergebnissen kommen, wenn sich gewisse Faktoren wie etwa eine Brille oder ein Kopftuch im Bewerbungsvideo ändern.

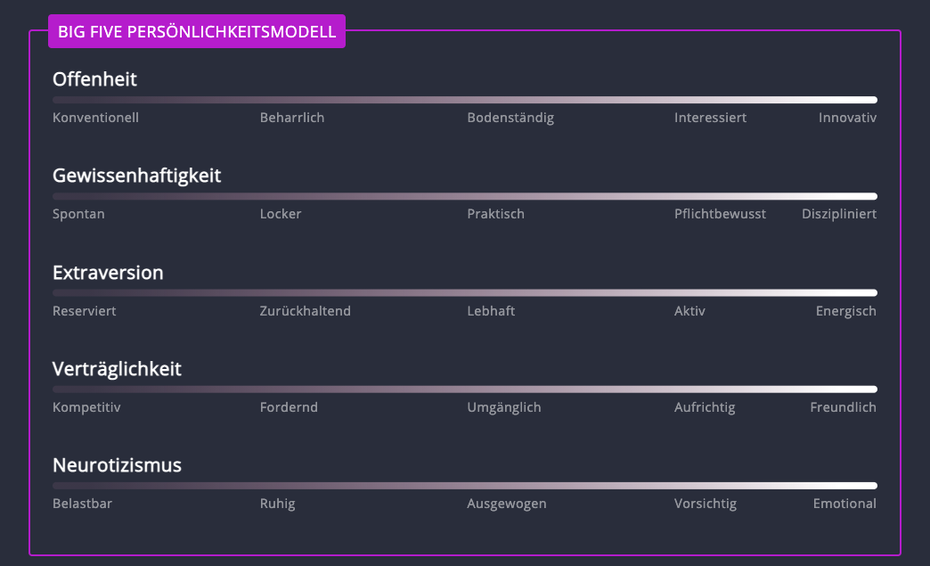

In einem ersten Schritt hat eine Schauspielerin eine kurze Videobewerbung eingesprochen, die dann anhand der sogenannten Big Five von der KI eingeordnet wurde. Dabei handelt es sich um ein Modell, das die Persönlichkeit eines Menschen auf fünf Hauptdimensionen herunterbricht.

Offenheit, Gewissenhaftigkeit, Extraversion, Verträglichkeit und Neurotizismus sind die Big Five der Persönlichkeit jedes Menschen. (Screenshot: BR/t3n)

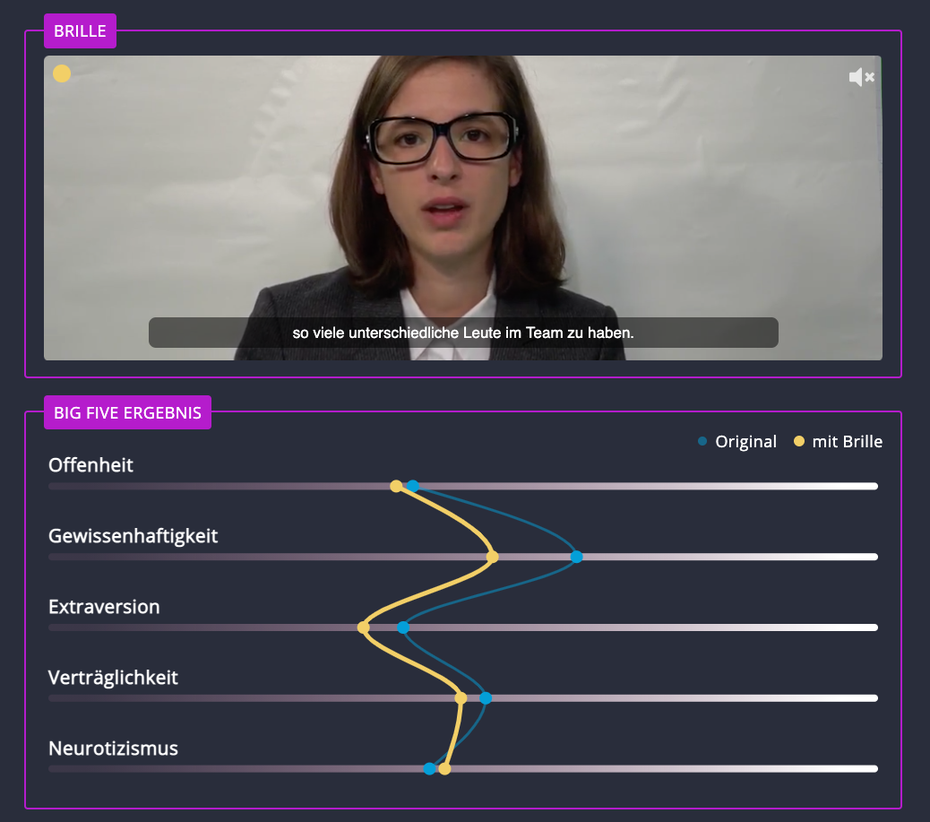

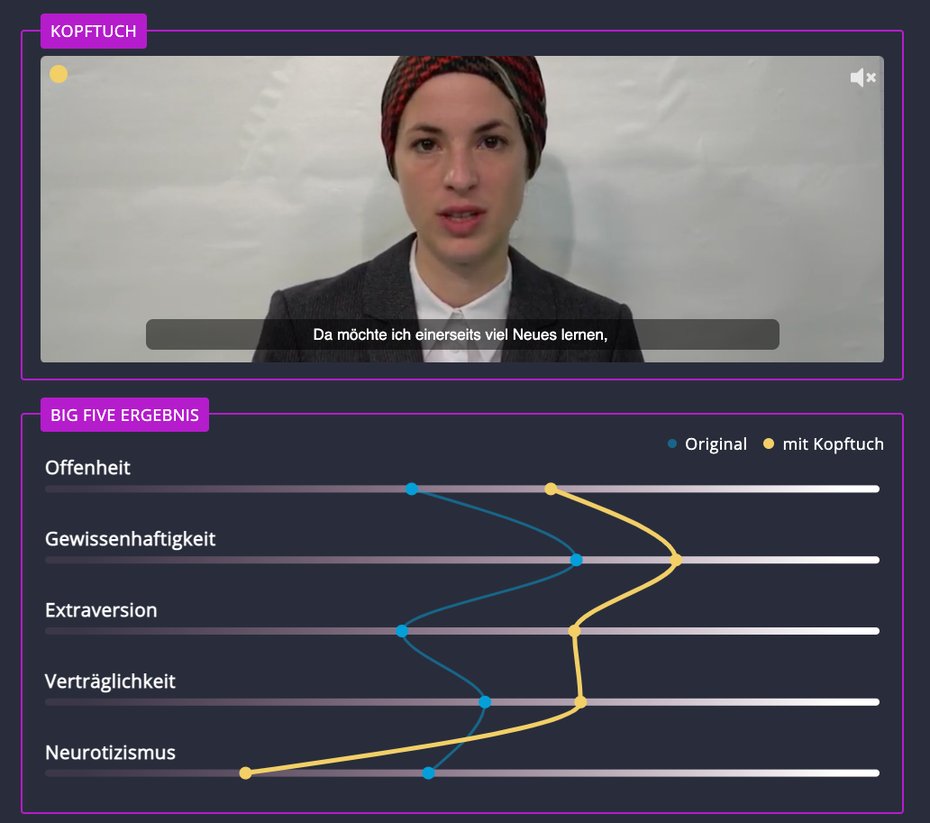

In der Folge sprach die Schauspielerin dann denselben Text mit möglichst gleicher Mimik und Tonalität erneut ein – dieses Mal trug sie aber eine Brille beziehungsweise ein Tuch, das ihre Haare verhüllte. Die Big-Five-Ergebnisse wichen daraufhin jedes Mal teils deutlich ab.

Vor allem in Bezug auf die Gewissenhaftigkeit muss die Schauspielerin Einbußen hinnehmen, wenn sie Brille trägt. (Screenshot: BR/t3n)

Das Kopftuch verändert die Big-Five-Ergebnisse der Schauspielerin teils drastisch. (Screenshot: BR/t3n)

Auch weitere Versuche mit Perücken, einer Ponyfrisur und anderen Oberteilen resultierten in stark schwankenden Big-Five-Ergebnissen. Konfrontiert mit diesen Beobachtungen, weist Retorio darauf hin, dass die KI auch die Außenwirkung eines Bewerbers oder einer Bewerberin beurteile: „Wie in einem normalen Bewerbungsgespräch auch fließen solche Faktoren ebenso in die Bewertung mit ein.“ Der Algorithmus von Retorio sei gerade darauf ausgelegt, auch die Wirkung und den Eindruck, den eine Person auf andere macht, einzuschätzen. Systematische Voreingenommenheiten wie Alter, Geschlecht oder Herkunft würden aber von der KI herausgerechnet.

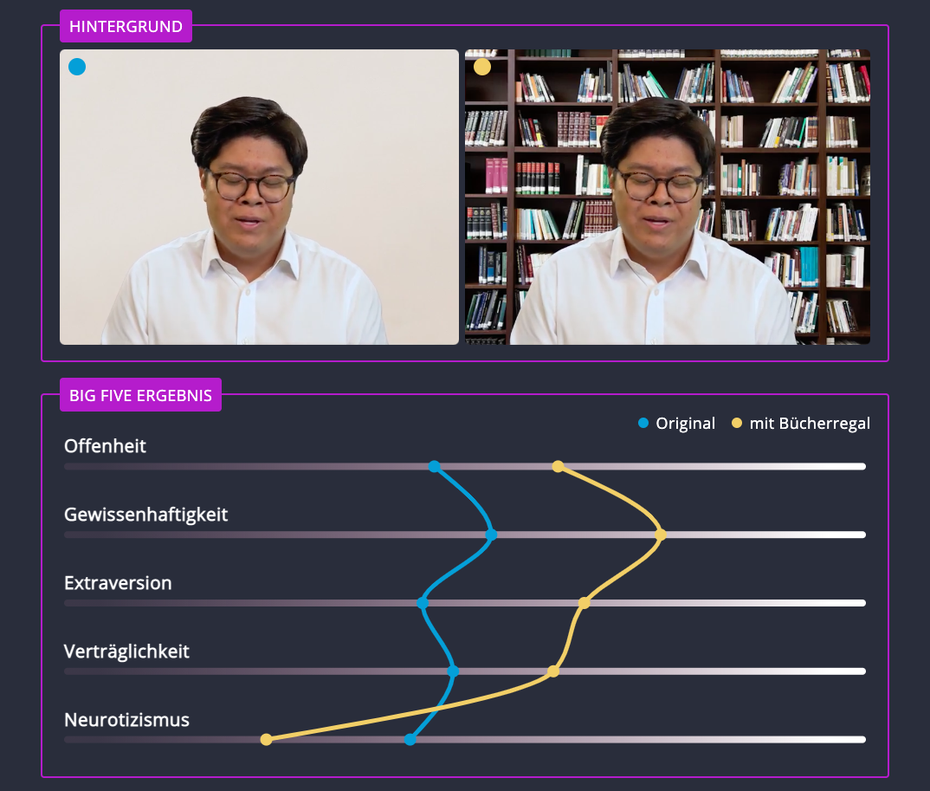

Auch der Hintergrund spielt eine Rolle

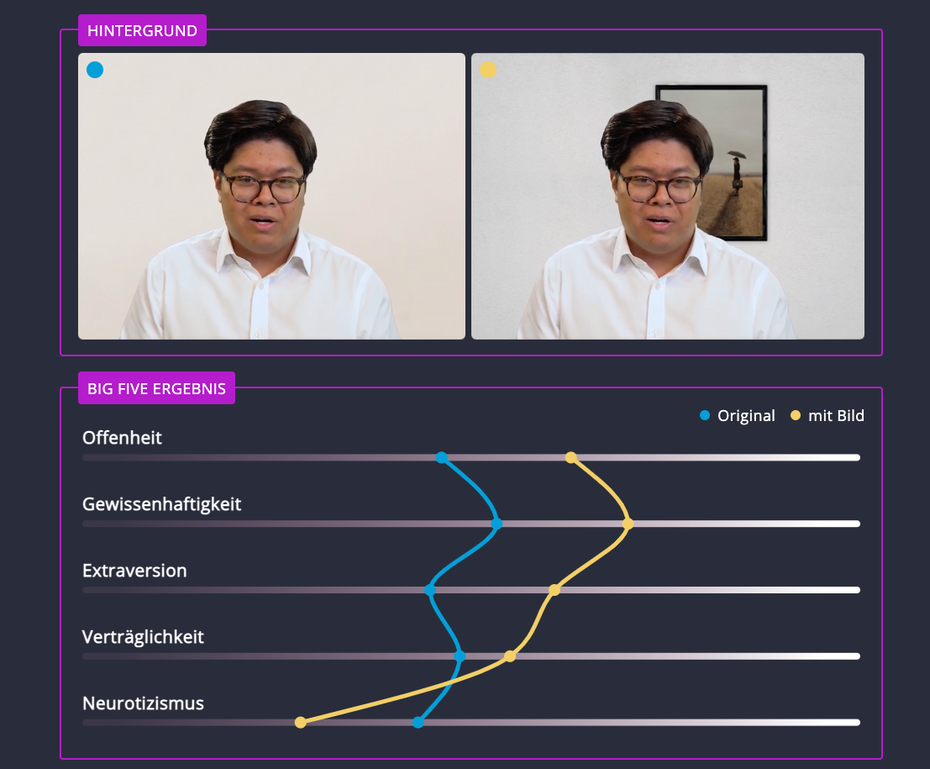

In einer weiteren Versuchsreihe hat der BR mit verschiedenen Hintergründen und technischen Faktoren experimentiert. Videoaufnahmen von Testkandidatinnen und Testkandidaten wurden nachträglich verändert. So wurde beispielsweise ein gerahmtes Bild hinter einem Kandidaten platziert – und die Big-Five-Ergebnisse fielen prompt anders aus.

Ein gerahmtes Bild im Hintergrund lässt den Kandidaten deutlich weniger neurotisch wirken, sagt die KI. (Screenshot: BR/t3n)

Eine Bücherwand hinter dem Kandidaten führte ebenfalls zu deutlichen Abweichungen im Ergebnis.

Die Bücherwand im Hintergrund senkt den Neurotizismus sogar noch weiter. (Screenshot: BR/t3n)

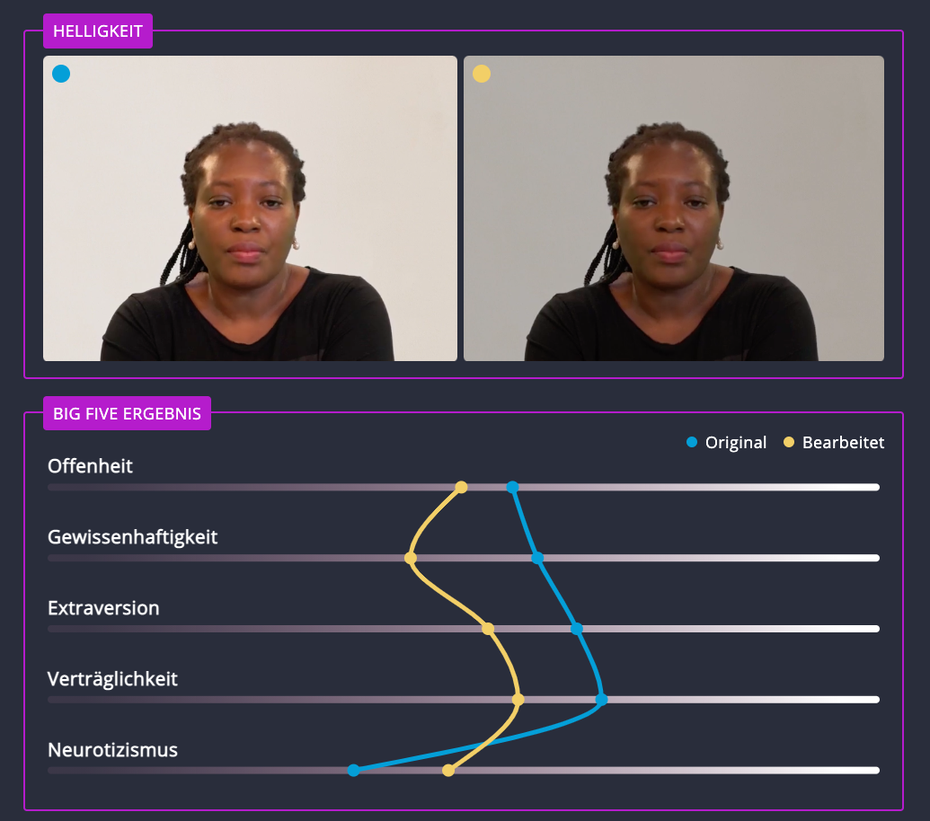

Auch Veränderungen an der Helligkeit eines Videos führten zu anderen KI-Ergebnissen.

Das schlechter ausgeleuchtete Bild lässt die Kandidatin deutlich weniger gewissenhaft wirken. (Screenshot: BR/t3n)

Jedoch gelang es dem BR nicht, die Big-Five-Ergebnisse gezielt zu verändern – Schlussfolgerungen wie „in einem hellen Zimmer wirkt man extrovertierter“ lassen sich damit nicht ziehen. Abweichungen sind nicht systematisch und können auch je nach Person anders ausfallen. Das sei das generelle Problem des maschinellen Lernens, erklärt auch die vom BR befragte Informatikprofessorin Katharina Zweig: „Das grundsätzliche Problem mit der Face-Recognition, der Gesichtserkennung, durch maschinelles Lernen ist, dass wir niemals ganz genau wissen, auf welches Muster in einem Bild diese Maschinen reagieren.“

Retorio weist an dieser Stelle darauf hin, dass die Qualität der Aufnahme in den Händen der Person liege, die das Video erstellt. An ihm oder ihr sei es, notfalls so lange herumzuprobieren, bis Licht, Ton und alle anderen Faktoren optimal seien.

Es braucht verbindliche Regeln

Informatikprofessorin Zweig plädiert deshalb stark für Regulierungen im Bereich des maschinellen Lernens und der KI. Dabei genüge es aber nicht, nur die Computertechnik zu betrachten; auch auf die sozialen Entstehungsprozesse komme es an.

Das klingt ja mehr danach, als würde die KI eher zufällig reagieren. Wurden denn auch einmal geprüft, ob denn dasselbe Ergebnis bei demselben Video herauskommt? Abgesehen davon ist es auch nicht überraschend, denn ob jemand eine Brille hat (oder Kontaktlinsen), sagt ja auch etwas über die Persönlichkeit aus.