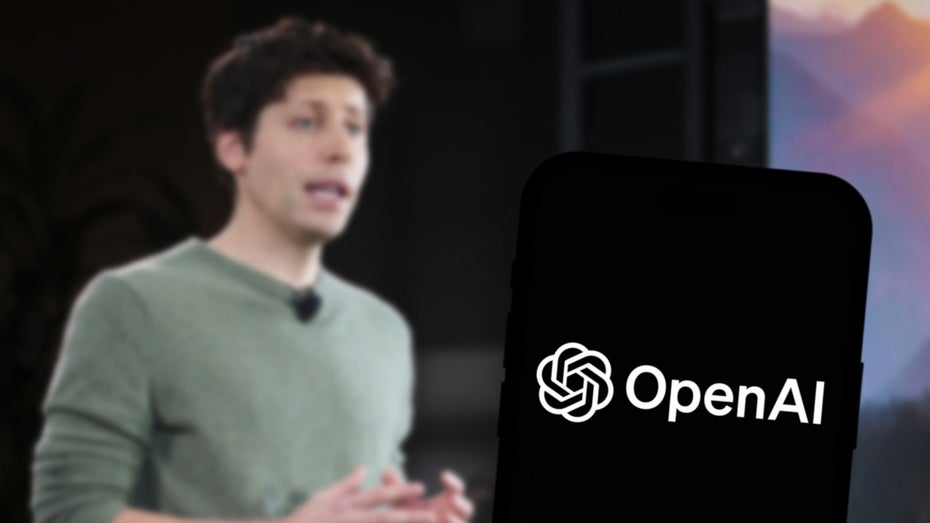

Sam Altman will, dass sich ChatGPT an dein ganzes Leben erinnert

ChatGPT soll sich an das gesamte Leben seiner Nutzer:innen erinnern – von allen E-Mails, die sie einmal geschrieben, bis hin zu jedem Buch, das sie gelesen haben. Das sagte Sam Altman, CEO von OpenAI, kürzlich auf einer Veranstaltung von Sequoia Capital, als er gefragt wurde, wie der Chatbot noch persönlicher werden könnte. Wie Techcrunch berichtet, ergibt sich daraus ein Zukunftsszenario, das Expert:innen gleichermaßen als spannend und furchterregend empfinden.

Das ganze Leben in einem KI-Modell

Was für manche wie Science-Fiction klingt, ist für Altman eine logische Konsequenz der heutigen Nutzung von KI-Tools. Viele junge Anwender:innen würden ChatGPT schon jetzt wie ein eigenes Betriebssystem einsetzen, so seine Beobachtung: Sie laden Dateien hoch, verknüpfen Datenquellen und nutzen komplexe Prompts, um sich den Alltag zu erleichtern. Manche treffen sogar keine wichtige Lebensentscheidung mehr, ohne vorher ChatGPT um Rat zu fragen.

Für Altman besteht das Ideal in einem sehr kleinen KI-Modell mit einer Billion Kontext-Token, in das man sein ganzes Leben einspeisen kann. Jedes Gespräch, jede gelesene E-Mail, jedes Buch, jede Webseite – auf all dieses Wissen solle die KI zurückgreifen können, um die Nutzer:innen bei täglichen Aufgaben und Entscheidungen zu unterstützen. Altman geht sogar noch einen Schritt weiter: Das Ganze solle nämlich nicht nur auf privater Ebene funktionieren, auch Unternehmen könnten ihre kompletten Datensätze auf diese Weise zur Verfügung stellen.

ChatGPT zwischen Utopie und Dystopie

In der Praxis könnte das bedeuten, dass ChatGPT die Nutzer:innen automatisch an den nächsten Ölwechsel ihres Autos erinnert, die Fahrt zur Silberhochzeit der Eltern plant und sich auch gleich ein passendes Geschenk überlegt und bestellt. OpenAI-Chef Altman fantasiert also von einer KI, die nicht nur reagiert, sondern die Menschen proaktiv in ihrem Leben begleitet. Für viele dauergestresste Nutzer:innen klingt das nach einer echten Entlastung.

Bei allem Innovationsgeist gibt es aber natürlich auch eine Schattenseite: Eine KI, die alle persönlichen Daten ihrer User:innen kennt, birgt ein enormes Missbrauchspotenzial – vor allem dann, wenn sie von einem profitorientierten Unternehmen kontrolliert wird. Big Tech hat in der Vergangenheit immer wieder gezeigt, dass Datenschutz, Ethik und gesellschaftliche Verantwortung nicht immer oberste Priorität haben.

Darüber hinaus sind die aktuellen KI-Modelle noch lange nicht perfekt: Die Modelle von OpenAI sind in letzter Zeit sogar noch unzuverlässiger geworden. Während ältere Modelle wie o1 und o3-mini noch eine Halluzinationsrate von etwa 15 bis 16 Prozent aufwiesen, erreichte das neue o3-Modell nur noch ein Drittel. Bei o4-mini lag die Fehlerquote sogar noch höher: Das KI-Modell halluzinierte bei fast der Hälfte aller Anfragen. Gerade wenn Menschen KI-Werkzeuge in allen Lebensbereichen einsetzen, können solche Schwachstellen potenziell schwerwiegende Folgen haben.

Wie vertrauenswürdig ist allwissende KI?

Die Idee einer KI, die das gesamte Leben ihrer Verwender:innen versteht, ist reizvoll. Sie verspricht mehr Effizienz, bessere Entscheidungen und Unterstützung im Alltag. Sie wirft aber auch zentrale Fragen auf: Wer kontrolliert die Daten? Wie transparent sind die Algorithmen? Und was passiert, wenn die Interessen von Nutzer:innen und Anbietern auseinanderdriften? Altman zeichnet eine ambitionierte Zukunftsvision, aber ob sie wirklich im Sinne der Nutzer:innen ist, wird maßgeblich davon abhängen, wie OpenAI mit ethischen und regulatorischen Fragestellungen umgeht. Die Technologie hat sich in den letzten Monaten enorm weiterentwickelt – jetzt ist es an der Zeit, dass die Transparenz nachzieht.

Sora – Das sind die besten Clips von OpenAIs Video-KI