(Grafik: Shutterstock / Max Griboedov)

Das Prinzip ist schnell erklärt: Einfach die Kamera auf eine Sehenswürdigkeit, ein Produkt im Geschäft oder eine Pflanze beim sonntäglichen Spaziergang richten, den Auslöser drücken und umgehend eine Websuche zu dem Motiv starten. Visuelle Suchmaschinen machen‘s möglich. Anders als bei der klassischen Bildersuche geben die User keine Keywords ein, sondern erfassen das gewünschte Objekt fotografisch über Apps wie Google Lens, Bing Visual Search oder Pinterest Lens. Dabei funktionieren sowohl ein bereits digital vorliegendes Foto als auch ein Livebild. Die nun gestartete Suche liefert ähnliche Motive und Gegenstände in Echtzeit.

Was Leisten Visual-Search-Engines?

Die auf Machine Learning und künstlichen, neuronalen Netzen basierende Technologie der genannten Anwendungen liefert besonders zuverlässige Ergebnisse, wenn viele Fotos von einem bestimmten Objekt im Netz zu finden sind. Denn dann kann die Suchmaschine auf eine Vielzahl von Bildern mit ähnlichen Merkmalsvektoren zurückgreifen. Schwieriger wird es bei Objekten, von denen im Netz kaum Referenzen zu finden sind. Mit einem „Dings vom Dach“, wie es etwa die gleichnamige Sendung im Hessischen Rundfunk regelmäßig präsentiert, dürften sich Google Lens und Co. deutlich schwerer tun: Ein vielleicht antiquarischer Nutzungsgegenstand, seit Jahren vergessen auf dem Dachboden, nie fotografiert, nie als digitales Abbild in die Weiten des Internets hochgeladen, wird kaum von ihnen erkannt werden. Es fehlt die Referenz – noch! Denn natürlich lernt die künstliche Intelligenz mit jedem neuen Bezugsbild dazu.

Das funktioniert vor allem mithilfe von Deep-Learning-Mechanismen: In einem dem menschlichen Gehirn nachempfundenen neuronalen Netz kommen zwischen den Eingangs- und Ausgangsneuronen mehrere Schichten mit Zwischenneuronen zum Einsatz. Dadurch und auf Basis vorhandener Daten können Maschinen komplexere Zusammenhänge erkennen, verstehen und Bezüge herstellen. Sie greifen dafür auf riesige Datenmengen zurück und sind in der Lage, immer wieder Neues zu erlernen.

Im Einzelnen läuft der Vorgang bei der visuellen Suche wie folgt ab: Zunächst muss die Suchmaschine die Suchanfrage aufnehmen und inhaltlich verstehen. Dabei kommen Bilderkennungstechnologien zum Einsatz, schließlich muss das gesuchte Objekt identifiziert werden. Sobald die künstliche Intelligenz den Bildinhalt versteht, kann sie Bezüge zu möglichen Textabfragen herstellen, die der visuellen Suche entsprechen. Sie fragt sich gewissermaßen: Welche textuelle Keyword-Abfrage könnte zu diesem Bild passen? Bei einem Foto von einem Sofa könnte das Keyword „Sofa“ oder ein Synonym wie „Couch“ sein. Anschließend muss – wie auch bei textuellen Abfragen – die Suchabsicht ermittelt werden. Nach einem Sofa sucht man in der Regel eher mit einer Kaufabsicht. Übersetzt in eine Keyword-Abfrage würde die Suche also „Sofa kaufen“ heißen. Kommerzielle Ergebnisse sind in diesem Fall relevanter als bei einer Suche, für die ein Foto von einem Baum oder einem Denkmal geschossen wurde. Zu guter Letzt müssen die Übereinstimmungen ermittelt und anhand der erkannten Merkmalsvektoren ein Ranking der Ergebnisse ausgespielt werden.

Das Maß aller Dinge in Sachen Deep Learning ist dabei immer das kognitive Vermögen des Menschen. Innerhalb weniger Millisekunden erkennen wir meistens Objekte aller Art. Nach einem Wimpernschlag wissen wir, was wir sehen, können Objekte zuordnen, auf einen Informationsschatz zurückgreifen und Schlüsse aus Beobachtungen ziehen. Selbst wenn wir nicht ad hoc etwas mit dem „Dings vom Dach“ anfangen können, sind wir doch in der Lage, die Bestandteile des Objekts zu identifizieren – Zahnräder, Schrauben, Scharniere? Von diesen Beobachtungen einzelner Bauteile können wir dann in der Regel auf das große Ganze schließen.

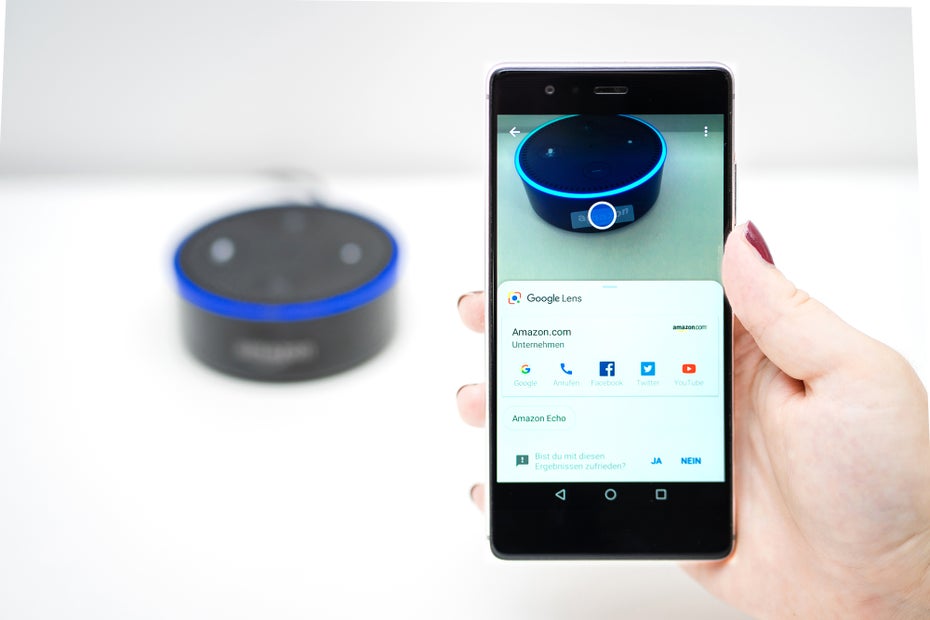

Google Lens: Mit der App können Nutzer Gegenstände in der physischen Welt scannen. Anschließend zeigt die App Informationen zu dem Gegenstand an – wie hier bei Amazon Echo. (Foto: t3n)

Diese Kompetenz fehlt einer visuellen Suchmaschine. Daher bleibt Deep Learning als Grundlage für visuelle Websuchen auf absehbare Zeit ein Annäherungsprozess an menschliche Fähigkeiten. Die Voraussetzung für eine zuverlässige Funktionsweise ist ein beträchtlicher Datenstamm, der für viele Motive erst noch zu erschaffen ist. Die Suchmaschine muss nicht nur den Gegenstand im Ganzen, sondern auch einzelne Merkmale erkennen können. Und noch komplizierter wird es, wenn die Suchabsicht ins Spiel kommt: Geht es um eine reine Information oder eine Kaufabsicht? Hier könnte Google Lens im Vorteil sein: Die verhältnismäßig gute Suchleistung der App bei Sehenswürdigkeiten, Möbeln oder Pflanzen ist auf die ungeheuren Datenmassen und die über Jahre hinweg verfeinerten Suchalgorithmen des Marktführers zurückzuführen.

Erfunden hat Google die visuelle Bildersuche hingegen nicht. Der sogenannte „contentbased Image-Retrieval“, die inhaltsbasierte Bildrecherche, wurde schon zuvor beispielsweise von der Webanwendung Tineye genutzt: Sie findet durch Upload eines Bildes ähnliche Bilder und sortiert die Ergebnisse nach Ähnlichkeitsgrad zum Referenzbild. Auch die konkurrierenden Suchmaschinenanbieter schlafen nicht: Vor allem die Bildercommunity Pinterest ist ein ernst zu nehmender Konkurrent. Der Dienst kann von der aktiven Fotocommunity und deren zahlreichen Suchanfragen nachhaltig profitieren. So verzeichnet die App laut einer Pressemitteilung von Februar 2018 monatlich bereits 600 Millionen visuelle Suchanfragen. Auch hier gilt: Je mehr Suchanfragen, desto besser funktioniert die Erkennung. Mit Bing Visual Search hat auch Microsoft inzwischen eine eigene visuelle Bildersuchmaschine lanciert, die sehr ähnlich funktioniert: Mit einem Klick auf das Lupensymbol in der Bing-Bildersuche können Fotos untersucht werden. Man zieht einen Rahmen um das zu suchende Objekt und startet die Websuche.

Chancen nicht nur für E-Commerce

Visuelle Suchmaschinen können die Tools der Zukunft für den E-Commerce oder für Visibility-Analysen werden. Die Idee: Ein User sieht ein tolles Outfit, erfasst Schuhe, Tasche und Kleid mit der App und lässt sich ähnliche Produkte anzeigen. Pinterest liefert beim Fotografieren von Lebensmitteln passende Rezepte und Google wirbt damit, Rezensionen zu vorliegenden Büchern anzeigen zu können. Bisher ist das Ergebnis einiger exemplarischer Suchanfragen allerdings noch ernüchternd. So erkennt die Pinterest-Lens einen fotografierten Weißkohl gerne auch mal als Melone. Das Foto orangefarbener Damenslipper führt hingegen neben einigen halbwegs passenden Ergebnissen auch zu braunen Herrenschuhen.

Diesen anfänglichen Ungenauigkeiten zum Trotz hat der Onlinehandel das Potenzial schnell erkannt: Der Londoner Onlineshop ASOS bietet seit August 2017 ein eigenes Tool zum visuellen Erkennen und Suchen von Kleidungsstücken an. Einen ähnlichen Vorstoß wagte Macys vor einigen Jahren und auch Ebay seit 2017. Mit der Ebay-Image-Search können Nutzer Fotos von Gegenständen machen oder bereits existierende Fotos untersuchen – ähnlich wie bei Pinterest, Google und Bing. Anschließend werden Millionen von Ebay-Artikeln durchsucht. Selbst Snapchat arbeitet an einer visuellen Produktsuche, die Nutzer direkt zum Amazon-Marktplatz weiterleitet.

Für den stationären Handel bedeutet diese Technologie eine Herausforderung: Die Preise der Produkte im Ladenregal können dank visueller Suchen noch unkomplizierter online verglichen werden. Allerdings bietet Visual Search Multichannel-Anbietern im gleichen Atemzug die Chance, den eigenen Onlineshop mit dem stationären Geschäft besser zu verbinden und einen nahtlosen Übergang vom Offline- zum Online-Einkaufserlebnis für ihre Kunden zu schaffen. Einer der wohl größten Nachteile des stationären Handels ist bislang die Begrenzung des Warensortiments. Größen oder Farbvarianten können nicht immer für jeden Bedarf vorrätig sein. Doch statt in einem Geschäft der Konkurrenz nach einer Jeans in der richtigen Größe zu suchen, könnte der Kunde der Zukunft das Smartphone zücken, ein Foto schießen und das Objekt der Begierde im Onlineshop des Ladens bestellen. Vorausgesetzt, das Angebot ist auch im Netz besser als das der Konkurrenz. Visual-Search-Engines begünstigen zwar die Vergleichsmöglichkeiten, sie verkürzen aber auch den Weg des Kunden zu den eigenen Produkten. Der größte Vorteil visueller Recherchemöglichkeiten ist, dass Kunden an nahezu jeder Station des Sales-Funnels abgeholt werden können: Inspiration für den nächsten Kauf wartet schließlich überall.

Doch damit nicht genug. Visuelle Bildersuchmaschinen können auch für interne Prozesse in Unternehmen interessant sein – so etwa das Logo-Erkennungstool Image Insights von Brandwatch. Damit können Unternehmen ihr Logo in unzähligen Kontexten aufspüren und wichtige Schlüsse zur Markensichtbarkeit im Netz ziehen. Die Bildersuche durchkämmt das Netz nach dem Logo und zeigt, wo es visuell Erwähnung findet. Das kann beispielsweise die Kontaktaufnahme zu Influencern erleichtern oder negative Umfelder aufdecken. So können PR-Abteilungen schneller reagieren und schlechte Presse früher abwenden. Weitere potenzielle Anwendungsfelder bieten sich unter anderem in Bibliotheken, im Tourismus oder im Stadtmarketing. Es wäre doch komfortabel, ganz bequem beim Kaffeetrinken am Alexanderplatz ein Foto vom Berliner Fernsehturm zu machen und darüber Tickets für den späteren Besuch zu buchen. Ähnliches wäre in der Gastronomie möglich: Im Vorbeigehen einen Tisch reservieren und die Karte studieren? Ausgereifte Bilderkennungstechnologien könnten das leisten.

Muss SEO neu gedacht werden?

Wenn sich die Art, wie wir nach Informationen im Netz suchen, so grundlegend ändert, hat das naturgemäß auch Auswirkungen auf die SEO-Branche. Es ist eine Binsenweisheit, dass Google und Co. relevante, sinnvoll eingebaute und sauber ausgezeichnete Multimediainhalte positiv bewerten. Doch mit einem einfachen Einbinden von Fotos ist es nicht getan. Zumal beim Thema visuelle Bilderkennung noch nicht ersichtlich ist, welche Bilder bei diesen Suchanfragen besser ranken: Die noch unausgereifte Technologie bringt zu viele Variablen ins Spiel. Eine konkrete Handlungsempfehlung für Webmaster zu formulieren, gestaltet sich daher zum jetzigen Zeitpunkt schwierig. Was wichtig bleibt, sind die bisherigen Google-Richtlinien zur Bildoptimierung. Damit Suchmaschinen Bildinhalte nicht nur finden, sondern auch deren Inhalt verstehen und Relationen herstellen können, ist eine Optimierung des Kontextes und der Metadaten notwendig. Das betrifft unter anderem:

- Aussagekräftige Bildtitel: Sie sollten so genau wie möglich beschreiben, was auf dem Foto zu sehen ist. Statt „blume1“, sollte man das Foto einer rot-orangefarbenen Rose auch entsprechend benennen: „rot-orangene-rose“. Hier lassen sich relevante Keywords unterbringen.

- Alt-Texte: Jedes Bild sollte mit beschreibenden und aussagekräftigen Alt-Texten versehen werden.

- Kontext: Jedes Bild sollte sinnvoll und thematisch relevant eingebunden werden, hier gehen Bild- und Keyword-Optimierung Hand in Hand.

- Dateigröße: Diese sollte möglichst klein ausfallen.

- Bildgröße: Schlecht aufgelöste Bilder sind ein No-Go.

- Sitemap: Diese macht es Suchmaschinen leichter, Abbildungen zu finden und zu verstehen.

- Auszeichnung nach schema.org: Strukturierte Daten erleichtern es Suchmaschinen, Bildinhalte- und -kontexte zu verstehen.

Durch die zunehmende Verbreitung von visuellen Websuchen könnten diese klassischen Maßnahmen an Bedeutung gewinnen: Markups und Metadaten bilden bei visuellen Suchanfragen in Ergänzung zu den bildlichen Merkmalsvektoren die wichtigsten – weil einzigen textuellen – Anhaltspunkte für Google, um Abbildungen einzuordnen und Zusammenhänge herzustellen. Zumal der Effekt für visuelle Suchanfragen noch nicht endgültig geklärt werden kann und die klassische keyword-basierte Bildersuche auf absehbare Zeit relevant bleibt. Es ist immerhin höchst unwahrscheinlich, dass diese selbst bei einwandfrei funktionierenden Bilderkennungstechnologien vollständig verdrängt wird. Gerade an Desktoprechnern dürfte eine manuelle Sucheingabe gängig bleiben.

Daher muss Bilder-SEO nicht vollends neu gedacht werden. Altbewährte Maßnahmen bleiben wichtig. Aber soll das schon alles sein? Immerhin erkennen visuelle Suchmaschinen Objekte auch anhand ihrer bildlichen Merkmale. Aus diesem Grund dürften im E-Commerce professionelle Produktfotografie und hochwertige, möglichst eindeutige Aufnahmen von Sehenswürdigkeiten im Stadtmarketing und Tourismus noch wichtiger werden. In Sachen motivischer Optimierungen drängen sich zurzeit noch zu viele Fragen auf: Ist das überhaupt möglich? Wenn ja, wie arbeitet Google konkret? Welche bildlichen Aspekte haben einen Einfluss auf das Ranking? Antworten muss die Zukunft liefern, wenn Visual-Search-Engines im SEO-Alltag angekommen sind. Noch jedenfalls ist eine visuelle Optimierung von Bildcontent aus SEO-Sicht ziemlich futuristisch.

Fazit

Die Potenziale der aktuellen Entwicklungen im Visual-Search-Bereich sind groß – ob für den E-Commerce, die Gastronomie, den Tourismus oder zum Monitoring visueller Markenbestandteile von Unternehmen im Netz. Beste Voraussetzungen also, dass sich hier nach der Voice-Search der nächste große Suchmaschinentrend entwickelt. Allerdings ist die Technologie noch weit von der Zuverlässigkeit einer klassischen Keyword-Anfrage entfernt. Noch leidet sie unter zu vielen „Kinderkrankheiten“. Auch zu klären sind ethische und bildrechtliche Fragen: Wann ist die Bildersuche erlaubt? Wo werden Grenzen überschritten, wenn beispielsweise Kleidungsstücke oder ganze Outfits in der Fußgängerzone fotografiert werden, um diese online nachzukaufen? Auf dieser Ebene gibt es noch viel Diskussionsbedarf, bevor sich die interfacelose Websuche durchsetzen kann. Contentmanager und Webmaster sollten sich trotzdem schon jetzt auf den Trend vorbereiten: Eine Optimierung von Bildinhalten gemäß aktueller SEO-Standards, eine professionelle Produktfotografie und möglichst eindeutige Motive sollten selbstverständlich werden und erzeugen schon jetzt positive SEO-Effekte.

Daniel Kaliner ist stellvertretender Geschäftsführer von Performics Berlin, einer Agentur für Suchmaschinen- und Performance-Marketing. Dort ist er seit 2012 in der strategischen und technischen Beratung tätig und unter anderem für das 20-köpfige Beratungsteam verantwortlich.

Daniel Kaliner ist stellvertretender Geschäftsführer von Performics Berlin, einer Agentur für Suchmaschinen- und Performance-Marketing. Dort ist er seit 2012 in der strategischen und technischen Beratung tätig und unter anderem für das 20-köpfige Beratungsteam verantwortlich. Daniel Koch ist Gruppenleiter in der Online-Redaktion von Performics Berlin. Performics ist als internationale Performance-Agentur mit über 2.400 Experten in 57 Ländern aktiv – in Berlin unter anderem mit dem Schwerpunkt Suchmaschinenoptimierung.

Daniel Koch ist Gruppenleiter in der Online-Redaktion von Performics Berlin. Performics ist als internationale Performance-Agentur mit über 2.400 Experten in 57 Ländern aktiv – in Berlin unter anderem mit dem Schwerpunkt Suchmaschinenoptimierung.

Hallo

ich habe diesen Artikel von Romano weitergeleitet bekommen, danke dafür Romano.

My 2Cent

. Visual Search hat Vorteile, weil die Objekte so sind wie sie sind und nicht wie sie beschriftet wurden.

– Trainingsdaten aus dem Internet sind auf der einen Seite toll, weil viel ist schon mal gut, auf der einen Seite kann man eine KI auch mit schlechten Daten in die Irre führen.

Im Consumer Umfeld werden Pinterest, Snapchat und soweiter das Thema massiv nutzen, um alles Mögliche zu verkaufen. Aber Internet ist nicht gleich Consumer-Internet und Maschinenbau/Industrie ist ein neues Spiel. Ähnlich aber mit gewissen Schwierigkeitsgraden. Dort liegt das Potential für unsere Region.

Wir arbeiten mit seit 2 Jahren mit Visual Search im Maschinenbau, da dort häufig Objekte einfach nicht beschriftet sind oder Maschinen einfach nicht mit Google durchsuchbar sind.

Object Recognition und Object Detection haben in meinen Augen das Potential alles zu verändern.

Gruß

Patrick

xrec.com