- Fiktive Szenarien, wie KI im Krieg eine Rolle spielen könnte

- Deep Learning: Paradigmenwechsel für das Militär

- KI-Einsatz im Gaza-Streifen und in der Ukraine

- Eine Frage der Verantwortung

- Ganz neue Fragen durch den Einsatz von KI

- Auf die Maschine hören?

- Wo ist die Grenze?

- Die Relevanz des menschlichen Urteilsvermögens

Der Chatbot drückt nicht den Knopf zum „Feuerbefehl“: Über die Verantwortung im Krieg, wenn KI im Einsatz ist

Wir befinden uns in einem Krieg der nahen Zukunft. Auf einem leeren Dach nimmt ein Soldat seine Schussposition ein. Seine Einheit hat sich Block für Block durch die Stadt gekämpft. Es scheint, als ob der Feind hinter jeder Ecke auf der Lauer liegt.

Durch sein Zielfernrohr scannt der Soldat die Fenster eines nahe gelegenen Gebäudes. Er bemerkt frische Wäsche, die an den Balkonen hängt. Über Funk erfährt er, dass sich sein Team ein Stück über offenes Gelände bewegen wird. Als es sich auf den Weg macht, erscheint in der oberen linken Ecke des Zielfernrohrs ein roter Rahmen. Die automatisierte Bilderkennung der Waffe hat ein potenzielles Ziel markiert – eine schemenhafte Gestalt scheint sich einem der Fenster zu nähern. Will sie einen Schuss abgeben? Der Soldat hat keine klare Sicht, aber seiner Erfahrung nach verfügt das System über die Fähigkeit, auch die schwächsten Anzeichen eines Feindes zu erkennen. Also macht er sich bereit, den Abzug zu betätigen.

Dieser Text ist zuerst in der Ausgabe 1/2024 von MIT Technology Review erschienen. Hier könnt ihr das Heft als pdf-Ausgabe bestellen.

Fiktive Szenarien, wie KI im Krieg eine Rolle spielen könnte

In einem anderen Krieg steht ein Kommandeur vor einer Reihe von Monitoren. Ein Chatbot meldet sich. Er informiert darüber, dass Satelliten einen Lastwagen erfasst haben, der in ein Stadtviertel gefahren ist, das als möglicher Treffpunkt für feindliche Raketenabschüsse ausgewiesen ist. Der Chatbot hat bereits eine Artillerieeinheit, die seiner Berechnung nach die höchste „Tötungswahrscheinlichkeit“ hat, angewiesen, den Lastwagen ins Visier zu nehmen und sich bereitzuhalten.

Der Chatbot schätzt keines der nahe gelegenen Gebäude als zivile Einrichtung ein, obwohl diese Feststellung noch manuell bestätigt werden muss. Eine Drohne, die vom System für eine genauere Untersuchung losgeschickt wurde, trifft vor Ort ein. Ihr Video zeigt, wie der Lkw rückwärts in eine enge Passage zwischen zwei Gebäuden fährt – er verschwindet aus dem Blickfeld der Kamera. Der Kommandant muss sich entscheiden. Die Zeit läuft. Den Knopf mit der Aufschrift „Feuerbefehl“ drücken oder sich zurückzuhalten?

Diese Szenarien sind zwar fiktiv, doch längst gehören intelligente Systeme und Szenen wie diese zum Repertoire des Militärs. Und sie sind inzwischen so ausgereift, dass sie schon jetzt neue, ethische Fragen aufwerfen. Fragen, die mit jedem Tag dringlicher werden: Was bedeutet es, wenn eine Entscheidung über Leben und Tod nur zum Teil menschlich und zum Teil maschinell getroffen wird? Wer – oder was – trägt dann die Verantwortung?

Deep Learning: Paradigmenwechsel für das Militär

Vor allem das Aufkommen des maschinellen Lernens habe einen Paradigmenwechsel für den Einsatz von Computern beim Militär eingeleitet, sagt Jack Shanahan, Generalleutnant der Air Force im Ruhestand. „Was wir jetzt sehen, zumindest aus meiner Sicht, ist der Übergang zu einer Welt, in der Menschen und Maschinen in einer Art Team arbeiten müssen.“

Shanahan war der erste Direktor von Project Maven, einem Pentagon-Programm, das Algorithmen entwickelte, die im Videomaterial von Drohnen potenzielle militärische Ziele erkennen sollten. Das Projekt wurde 2017 gestartet. Es löste heftige Proteste bei Google aus – 2018 unterzeichneten mehr als 3.000 Google-Mitarbeiter einen Protestbrief gegen die Beteiligung des Unternehmens an militärischer Forschung.

Mit auf maschinellem Lernen basierenden Entscheidungstools „hat man mehr offensichtliche Kompetenz, mehr Bandbreite“ als mit den früher üblichen Tools, sagt Matt Turek, stellvertretender Direktor des Information Innovation Office bei der Defense Advanced Research Projects Agency (DARPA). „Und vielleicht neigt man deshalb dazu, ihnen mehr Entscheidungsbefugnisse zu übertragen.“ Ein Soldat, der nach feindlichen Scharfschützen Ausschau hält, könnte dies beispielsweise mit dem Assault Rifle Combat Application System tun, einem Zielfernrohr, das vom israelischen Verteidigungsunternehmen Elbit Systems verkauft wird. Einem Datenblatt des Unternehmens zufolge ist das „KI-gesteuerte“ Gerät in der Lage, „menschliche Ziele“ in einer Entfernung von mehr als 600 Metern zu erkennen und auf der Länge eines Fußballfeldes zu „identifizieren“. Sprich: zu erkennen, ob es sich bei einer Person um jemanden handelt, der erschossen werden soll. Anna Ahronheim-Cohen, eine Sprecherin des Unternehmens, erklärte gegenüber MIT Technology Review: „Das System wurde bereits in Echtzeitszenarien von kämpfenden Infanteriesoldaten getestet.“

Ein anderes Zielfernrohr von der Firma Smartshooter wird mit ähnlichen Fähigkeiten beworben. Der Website des Unternehmens zufolge lässt es sich auch in ein ferngesteuertes Maschinengewehr einbauen, wie es israelische Agenten bei der Ermordung des iranischen Atomwissenschaftlers Mohsen Fakhrizadeh im Jahr 2020 eingesetzt haben.

Entscheidungshilfetools, die weiter vom Schlachtfeld entfernt sind, können jedoch ebenso entscheidend sein. Das Pentagon scheint KI für nachrichtendienstliche Analysen und Entscheidungen, die zu einem potenziellen Angriff führen, bereits eingesetzt zu haben – ein Prozess, der als Kill Chain bekannt ist. Mit Details hält sich das Pentagon allerdings zurück. Laura McAndrews, eine Sprecherin der Luftwaffe, antwortete auf Fragen der MIT Technology Review, dass die US-Luftwaffe „einen Ansatz der Zusammenarbeit zwischen Mensch und Maschine verwendet“.

KI-Einsatz im Gaza-Streifen und in der Ukraine

Andere Länder experimentieren offener mit einer solchen Automatisierung. Kurz nach dem israelisch-palästinensischen Konflikt im Jahr 2021 gab das israelische Militär bekannt, dass es KI-Tools eingesetzt habe, um die Truppen vor bevorstehenden Angriffen zu warnen und Ziele für Operationen vorzuschlagen. Auch bei dem aktuellen Militäreinsatz im Gaza-Streifen verwendet die israelische Armee nach eigenen Angaben ein System namens The Gospel, das „feindliche Kombattanten und Ausrüstung“ identifizieren und potenzielle militärische Ziele markieren soll.

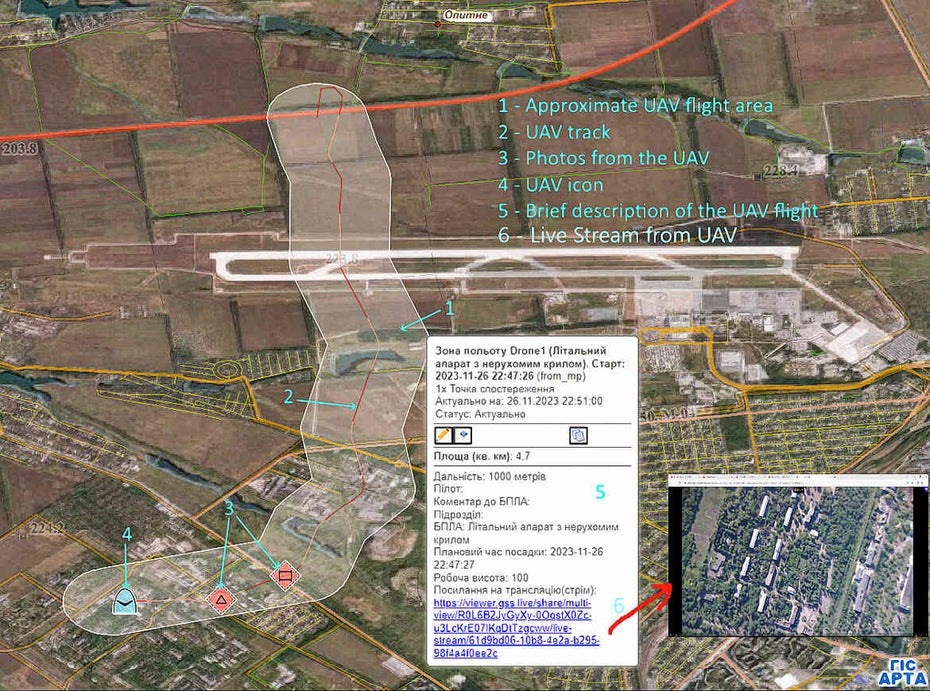

Die ukrainische Armee setzt ein Programm namens GIS Arta ein, das jedes bekannte russische Ziel auf dem Schlachtfeld der ukrainischen Artillerieeinheit zuordnet, die laut Algorithmus am besten geeignet ist, es zu beschießen. Ein Bericht der britischen Zeitung The Times stellte fest, dass die Software die Zeit zwischen der Entdeckung eines Ziels und dem Moment, in dem dieses Ziel unter Beschuss gerät, erheblich verkürzt – von bisher 20 Minuten auf eine Minute.

Das Feuerleitsystem GIS Arta der ukrainischen Armee verwendet unter anderem Bilder von Drohnen, um Ziele zu erkennen, die es dann automatisch einer Artillerieeinheit zuordnet.

(Bild: GIS Arta)

Auch Russland behauptet, über ein eigenes Kommando- und Kontrollsystem mit Künstlicher Intelligenz zu verfügen, hat aber nur wenige technische Details bekannt gegeben. Gregory Allen, Direktor des Wadhwani Center for AI and Advanced Technologies und einer der Architekten der aktuellen KI-Politik des Pentagons, empfiehlt, diese Behauptungen mit Vorsicht zu genießen. Er sagt, dass einige der angeblichen russischen militärischen KI-Anwendungen „Dinge sind, die jeder schon seit Jahrzehnten macht“. Allerdings nennt er auch GIS Arta „nur traditionelle Software“.

Doch die Bandbreite der Einschätzungen, die in militärische Entscheidungen einfließen, ist groß. Und es bedarf nicht immer einer künstlichen Superintelligenz, um diese Prozesse zu automatisieren. Es gibt Hilfsmittel zur Vorhersage feindlicher Truppenbewegungen, Werkzeuge, um herauszufinden, wie man ein bestimmtes Ziel ausschalten kann, und Möglichkeiten, um abzuschätzen, wie viel Kollateralschaden für die Zivilbevölkerung in der Nähe zu erwarten ist. Keine dieser Vorrichtungen kann als Killerroboter bezeichnet werden. Aber die Technologie ist trotzdem nicht ungefährlich. Auch ein KI-gestütztes Werkzeug kann versagen. Und in ihrer unerbittlichen Effizienz lassen diese Werkzeuge dem Menschen möglicherweise nicht einmal genug Zeit und Raum, um festzustellen, ob das, was sie tun, legal ist.

Trotzdem planen Streitkräfte, viele dieser einzelnen Instrumente mithilfe maschineller Intelligenz zu einem einzigen automatisierten Netzwerk zusammenzufügen, das jede Waffe, jeden Befehlshaber und jeden Soldaten mit jedem anderen verbindet – ein „Kill Web“.

Der israelische Rüstungskonzern Rafael Advanced Defence Systems hat bereits ein solches Produkt an die israelische Armee verkauft (es wurde auch dem US-Verteidigungsministerium und dem deutschen Militär vorgeführt): Fire Weaver. Nach Angaben des Unternehmens findet Fire Weaver feindliche Stellungen, benachrichtigt die Einheit, die seiner Berechnung nach am besten platziert ist, um auf diese zu schießen, und setzt sogar ein Fadenkreuz auf das Ziel direkt im Visier dieser Einheit. Ein Video der Software zeigt, dass die Aufgabe des Menschen nur noch darin bestehen soll, zwischen zwei Optionen zu wählen: „Genehmigen“ und „Abbrechen“.

Eine Frage der Verantwortung

Aber gehen wir zurück an den Anfang dieser Geschichte – nehmen wir einmal an, die Silhouette im Fenster sei kein Soldat, sondern ein Kind. Nehmen wir an, der Lastwagen würde keine Sprengköpfe an den Feind, sondern Wasser an ein Haus liefern. Bei den fünf „ethischen Grundsätzen für künstliche Intelligenz“ des US-Verteidigungsministeriums steht an erster Stelle: Verantwortungsbewusstsein. Alle Gesetze des Krieges wären bedeutungslos ohne die grundlegende Einsicht, dass jede vorsätzliche Handlung im Kampf immer von jemandem zu verantworten ist. Das Prinzip der Verantwortung galt natürlich schon lange vor dem Aufkommen von künstlich intelligenten Maschinen. Doch mit der Aussicht, dass Computer alle möglichen anspruchsvollen neuen Aufgaben übernehmen werden, erhält dieses uralte Gebot eine neue Bedeutung.

„Für mich und für die meisten Leute in Uniform, die ich kannte, war dies der Kern dessen, was wir als Kommandeure waren: letztlich jemand, der zur Verantwortung gezogen wird“, sagt Shanahan, der nach Maven der erste Direktor des Joint Artificial Intelligence Center des Pentagon wurde und die Entwicklung der ethischen Grundsätze für Künstliche Intelligenz beaufsichtigte. Deshalb muss eine menschliche Hand den Abzug betätigen, deshalb muss ein Mensch auf „Genehmigen“ klicken. Wenn ein Computer das falsche Ziel ins Visier nimmt und der Soldat trotzdem abdrückt, ist das seine Schuld. „Wenn ein Mensch etwas tut, das zu einem Unfall mit der Maschine führt, ist das immer noch eine Entscheidung, die ein Mensch getroffen hat“, sagt Shanahan.

Ganz neue Fragen durch den Einsatz von KI

Aber Unfälle passieren. Und genau hier wird es knifflig. Militärs haben Hunderte von Jahren damit verbracht, herauszufinden, wie man die unvermeidlichen, schuldlosen Tragödien der Kriegsführung von Handlungen mit böser Absicht, fehlgeleiteter Wut oder grober Fahrlässigkeit unterscheiden kann. Die Auslagerung eines Teils des menschlichen Urteilsvermögens an Algorithmen wird diese Fragen noch einmal ganz neu stellen, sagt Courtney Bowman, Global Director of Privacy and Civil Liberties Engineering bei Palantir. Das Unternehmen hat sich auf Datenanalyse für Militärs, Regierungen und große Unternehmen spezialisiert. „Es ist ein Bruch. Es ist eine Umwälzung“, sagt Bowman. „Es erfordert ein neues ethisches Konstrukt, um vernünftige Entscheidungen treffen zu können“.

Was das konkret bedeutet, kann man an einer Software namens Artificial Intelligence Platform (AIP) erkennen, die Palantir 2023 präsentierte. Das System besteht aus einem großen Sprachmodell, das auf diverse andere Militärprodukte des Unternehmens zugreifen kann. In einem Demo-Video von AIP, das im Frühjahr 2023 auf YouTube veröffentlicht wurde, warnt die Plattform den Benutzer vor einer potenziell bedrohlichen feindlichen Bewegung. Sie schlägt dann vor, eine Drohne für eine genauere Untersuchung zu schicken. Sie skizziert drei mögliche Pläne, um die angreifenden Kräfte abzufangen, und legt dann eine optimale Route für das ausgewählte Angriffsteam fest, um sie zu erreichen.

Doch selbst bei einer Maschine, die zu so etwas fähig ist, werden die Militärs nicht wollen, dass der Benutzer blindlings jedem Vorschlag vertraut. Bowman sagt, Palantirs Ansatz bestehe darin, „konstruierte Ineffizienzen“ in „Punkte im Entscheidungsprozess einzubauen, an denen man die Dinge tatsächlich verlangsamen möchte“. Wenn ein Computer beispielsweise auf eine feindliche Truppenbewegung hinweist, muss der Benutzer möglicherweise eine zweite, bestätigende Informationsquelle suchen, bevor er mit einer Aktion fortfährt. Im Demo-Video scheint die Plattform für Künstliche Intelligenz dies allerdings nicht zu tun.

Im Fall von AIP geht es laut Bowman zudem darum, die Informationen so zu präsentieren, „dass der Betrachter und der Analytiker verstehen, dass es sich nur um einen Vorschlag handelt“. In der Praxis könnte der Schutz des menschlichen Urteilsvermögens vor dem Einfluss einer verführerisch intelligenten Maschine auf kleine Details der grafischen Gestaltung hinauslaufen. „Wenn Personen, die von Interesse sind, auf einem Bildschirm als rote Punkte dargestellt werden, hat das eine andere unterbewusste Wirkung, als wenn Personen, die von Interesse sind, auf einem Bildschirm als kleine glückliche Gesichter dargestellt werden“, sagt Rebecca Crootof, Juraprofessorin an der University of Richmond. Sie hat sich ausführlich mit den Herausforderungen der Rechenschaftspflicht bei autonomen Waffen beschäftigt, die von Menschen bedient werden.

Der „Sensor- und Wirkungsverbund“ Fire Weaver von Dynamit Nobel Defence fasst alle Informationen vom Schlachtfeld in Echtzeit zusammen. Der Hersteller der „KI-gestützten Feuerleitung“ verspricht „mehr Sicherheit und Geschwindigkeit im Feuerkampf“.

(Bild: Dynamit Nobel Defence GmbH)

Einige Entscheidungs-Unterstützungssysteme sind jedoch eindeutig für Entscheidungen in Sekundenbruchteilen konzipiert, die mitten im Geschehen getroffen werden. Der US-Armee ist es nach eigenen Angaben in Live-Tests gelungen, ihren eigenen 20-minütigen Zielerfassungszyklus auf 20 Sekunden zu verkürzen. Auch auf dem Markt scheint die Zurückhaltung noch nicht angekommen zu sein. In den online veröffentlichten Demo-Videos sind die Begrenzungslinien für die computergesteuerten Zielfernrohre von Elbit und Smartshooter blutrot.

Und wenn der Soldat auf dem Dach das Zielfernrohr falsch eingeschätzt hätte und sich herausgestellt hätte, dass die Silhouette in Wirklichkeit ein feindlicher Scharfschütze war, hätten seine Kameraden für den Bruchteil einer Sekunde des Zögerns einen hohen Preis zahlen müssen.

Auf die Maschine hören?

Das bringt den Menschen in eine Zwickmühle. Die Soldaten sollen ihren digitalen Assistenten so viel Misstrauen entgegenbringen, dass die Unantastbarkeit ihres Urteils gewahrt bleibt. Aber bei Maschinen, die eben doch oft recht haben, kann genau diese Zurückhaltung selbst zu einem Punkt werden, an dem man versagen kann. So gibt es in der Luftfahrtgeschichte zahlreiche Fälle, in denen die Weigerung eines menschlichen Piloten, auf die Maschine zu hören, zu einer Katastrophe führte.

Die KI-Anthropologin Madeleine Claire Elish befürchtet, dass der Mensch, der sich in einer solchen Situation befindet, am Ende als „moralische Knautschzone“ dient. Im Falle eines Unfalls – unabhängig davon, ob der Mensch falsch lag, der Computer falsch lag oder beide zusammen falsch lagen – wird die Person, die die „Entscheidung“ getroffen hat, die Schuld auf sich nehmen und alle anderen in der Befehlskette vor den vollen Auswirkungen der Verantwortlichkeit schützen.

Doch jedes Bemühen um Rechenschaftspflicht in den oberen Führungsebenen würde wahrscheinlich durch den schweren Schleier der staatlichen Geheimhaltung behindert. Die US-Luftwaffe hat sich nicht dazu geäußert, ob ihre KI überhaupt in der Praxis eingesetzt wurde. Laut Shanahan wurden die KI-Modelle von Maven schon bald nach dem Start des Projekts für nachrichtendienstliche Analysen eingesetzt, und im Jahr 2021 erklärte der Luftwaffenminister, dass „KI-Algorithmen“ vor Kurzem „zum ersten Mal in einer laufenden operativen Kill Chain“ angewandt worden seien, wobei ein Sprecher der Luftwaffe damals hinzufügte, dass diese Werkzeuge in Nachrichtendienstzentren auf der ganzen Welt „bei Bedarf“ zur Verfügung stünden.

Laura McAndrews, die Sprecherin der Luftwaffe, sagte jedoch, dass diese Algorithmen „nicht in einer Live-Kill-Chain angewandt wurden“, und lehnte es ab, Einzelheiten über andere Algorithmen zu nennen, die seither verwendet worden sein könnten oder auch nicht. Die wahre Geschichte wird wohl noch jahrelang im Dunkeln bleiben. 2022 übergab das Pentagon das gesamte Programm an die National Geospatial-Intelligence Agency, die für die Verarbeitung von Amerikas riesigem Bestand an geheimer Luftüberwachung verantwortlich ist. Auf die Frage, ob die Algorithmen in Kill Chains eingesetzt werden, antwortete Robbin Brooks, ein Sprecher der NGA, gegenüber MIT Technology Review: „Wir können nicht genau sagen, wie und wo Maven eingesetzt wird.“

Wo ist die Grenze?

In einem Essay über Automatisierung, der 2018 veröffentlicht wurde, zu einer Zeit, als operative KI-gestützte Entscheidungshilfen noch eine Seltenheit waren, wies der ehemalige Marineminister Richard Danzig darauf hin, dass ein Präsident, der beschließt, einen Atomschlag anzuordnen, dies nicht tun wird, „weil irgendjemand aus dem Fenster des Oval Office geschaut und gesehen hat, dass feindliche Raketen auf DC herabregnen“. Sondern weil diese Raketen von Algorithmen im Luftverteidigungsnetz entdeckt, verfolgt und identifiziert wurden – und man hofft, dass sie dabei richtig liegen.

Löst ein Kommandeur auf Anraten eines Chatbots einen Artillerieschlag aus oder betätigt ein Schütze beim bloßen Anblick eines rot umrandeten Kastens den Abzug, „kann man höchstens sagen, dass ein Mensch beteiligt ist“, schrieb Danzig. „Das ist eine alltägliche Situation in der heutigen Zeit“, schrieb er. „Menschliche Entscheidungsträger sind Reiter, die über ein undurchsichtiges Terrain reiten und die mächtigen Tiere, die sie tragen und führen, kaum oder gar nicht einschätzen können.“

Unter den Menschen, die dafür verantwortlich sind, dass diese Bestien uns am Ende nicht auffressen, kann ein alarmierender Hang zum Defätismus herrschen. In einer Reihe von Gesprächen – die letztlich zu diesem Artikel führten – landeten meine Gesprächspartner bei der ernüchternden Feststellung, dass Tod und Zerstörung zwar tragisch sind, aber nicht auf einen einzelnen Menschen zurückgeführt werden können. Krieg ist chaotisch, Technologien versagen unvorhersehbar, und das ist einfach so.

Die Relevanz des menschlichen Urteilsvermögens

Es ist möglich, wenn auch noch nicht bewiesen, dass der Einsatz Künstlicher Intelligenz im Kampf weniger zivile Opfer zur Folge hat, wie Befürworter oft behaupten. Aber die unwiderrufliche Verbindung von menschlichem Urteilsvermögen und mathematischem Denken in den entscheidenden Momenten des Krieges könnte einen versteckten Preis haben. Vielleicht kann und sollte es nicht richtig sein, den Zeitpunkt und die Art und Weise zu wählen, in der ein Mensch stirbt, so wie man eine Fahrt bei Uber bestellt. Für eine Maschine mag dies eine suboptimale Logik sein. Aber für bestimmte Menschen ist genau das der Punkt. „Einer der Aspekte des menschlichen Urteilsvermögens ist, dass es in einer offenen Welt stattfindet“, sagt Lucy Suchman, emeritierte Anthropologieprofessorin an der Universität Lancaster, die seit vier Jahrzehnten über die Probleme der Mensch-Maschine-Interaktion schreibt.

Die Parameter von Entscheidungen über Leben und Tod – die Bedeutung der frischen Wäsche, die aus dem Fenster hängt, zu kennen und gleichzeitig zu wollen, dass die Teamkollegen nicht sterben, – sind „irreduzibel qualitativ“, sagt sie. Das Chaos, der Lärm, die Ungewissheit und die Last der Entscheidung, was inmitten all dieser Unruhe richtig und was falsch ist – nichts davon lässt sich in algorithmischen Begriffen definieren. Wenn es um Leben und Tod geht, gibt es kein rechnerisch perfektes Ergebnis. „Daraus ergibt sich die moralische Verantwortung“, sagt sie. „Man trifft eine Entscheidung.“

Das Visier drückt nie den Abzug. Der Chatbot drückt nicht auf den Knopf. Aber jedes Mal, wenn eine Maschine eine neue Rolle übernimmt, kommen wir dem Moment ein wenig näher, in dem Ethik zu einer Formel wird und Verantwortung kaum mehr als eine Abstraktion. Wenn wir uns einig sind, dass wir das nicht zulassen wollen, werden wir uns früher oder später fragen müssen: Wo ist die Grenze?