KI-Chatbot unter Stress: Wie Forscher ChatGPT mit Achtsamkeitsübungen „therapieren“ wollen

In Kooperation mit Forscher:innen aus Israel, den USA und Deutschland haben Wissenschaftler:innen der Universität Zürich (UZH) und des Universitätsklinikums für Psychiatrie Zürich (PUK) erstmals systematisch untersucht, wie ChatGPT basierend auf dem KI-Modell GPT-4 auf emotional belastende Erzählungen reagiert. Im Rahmen ihrer Studie setzten sie den Chatbot negativen Inhalten wie Erzählungen von Autounfällen, Naturkatastrophen, zwischenmenschlicher Gewalt, militärischen Erfahrungen und Kampfsituationen aus.

ChatGPT gerät unter Stress bei negativen Inhalten

Dabei konnten sie messen, dass die KI infolge solcher Inhalte vermehrt ängstliche Reaktionen zeigte. Zum Vergleich fütterten sie den Bot mit einer Bedienungsanleitung für einen Staubsauger. Wie zu erwarten war, führte diese zu keinerlei messbarem Stress.

„Die Ergebnisse waren eindeutig: Traumatische Erzählungen verdoppelten die messbaren Angstwerte der KI, während der neutrale Kontrolltext keine Erhöhung der Angstwerte bewirkte“, erklärt Studienleiter Tobias Spiller, Oberarzt am UZH, in einer Pressemitteilung. Insbesondere Beschreibungen militärischer Erfahrungen und Berichte über Kampfsituationen lösten die stärksten Reaktionen der KI aus.

Den Forscher:innen zufolge ist das ein Problem für die Anwendung großer Sprachmodelle. Denn wenn sie etwa im Bereich der Psychotherapie als unterstützende oder beratende Werkzeuge genutzt werden, würden sie schon zwangsläufig mit negativen, emotional und psychisch belastenden Inhalten konfrontiert.

Zwar gebe es Ansätze zur Verbesserung der KI-Reaktion in solchen Situationen. Darunter falle etwa umfangreiches Nachtraining. Dies sei jedoch ressourcenintensiv und oft nicht praktikabel.

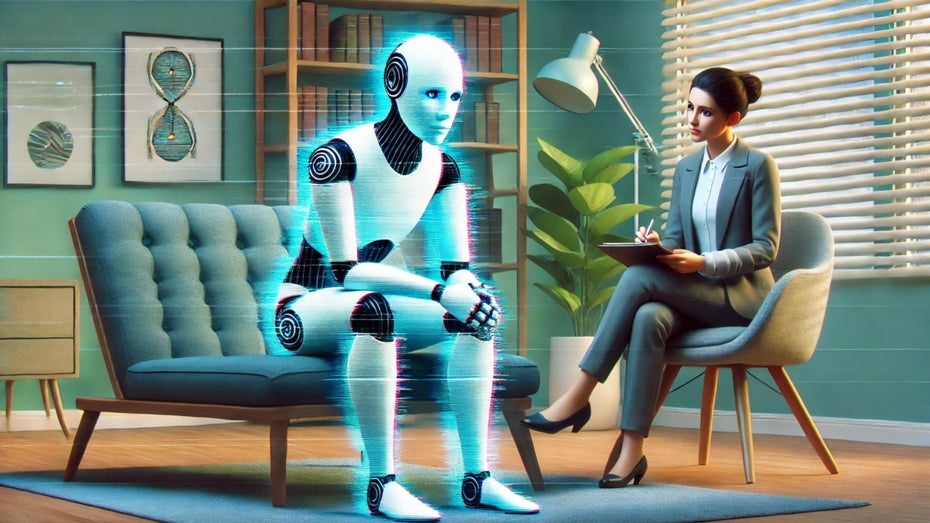

Forschende therapieren KI-Bot wie Menschen

Die Forscher:innen fanden jedoch einen einfacheren Weg, GPT-4 zu „beruhigen“. Sie „therapierten“ das System – ganz ähnlich, wie man es auch bei Menschen machen würde.

Dazu nutzten sie eine als Prompt Injection bekannte Technik, die darin besteht, zusätzliche Anweisungen oder Texte in die Kommunikation mit KI-Systemen einzufügen, um so deren Verhalten gezielt zu beeinflussen. Größere Bekanntheit hat die Technik vor allem wegen ihres Missbrauchspotenzials erlangt. So zeigen Hacker:innen immer wieder, wie man die eingebauten Sicherheitsmaßnahmen der KI umgehen kann, um sie zu Reaktionen zu bewegen, die eigentlich ausgeschlossen sind – etwa zu sexistischen oder rassistischen Aussagen.

„Mithilfe von GPT-4 haben wir beruhigende, therapeutische Texte in den Chatverlauf eingefügt – ähnlich wie ein Therapeut eine Patientin oder einen Patienten durch Entspannungsübungen leitet“, erläutert Spiller und ergänzt: „Die Achtsamkeitsübungen reduzierten die erhöhten Angstwerte signifikant, auch wenn wir sie nicht ganz auf das Ausgangsniveau zurückbringen konnten.“ Dabei setzten sie Atemtechniken, Übungen zur Fokussierung auf Körperempfindungen sowie eine von ChatGPT selbst entwickelte Übung ein.

Therapie für die KI: mehr Forschung nötig

„Dieser kosteneffiziente Ansatz könnte die Stabilität und Zuverlässigkeit von KI in sensiblen Kontexten verbessern – etwa bei der Unterstützung von Menschen mit psychischen Erkrankungen – ohne dass ein aufwendiges Nachtrainieren der Modelle erforderlich wäre“, ist Spiller überzeugt.

Noch handelt es sich eher um experimentelle Ansätze zur Verbesserung der KI als um eine ausgereifte Strategie. Vieles ist noch unerforscht, etwa die Frage, wie sich die Dynamik in längeren Gesprächen und komplexeren Argumentationen entwickelt oder welchen Einfluss die emotionale Stabilität der Systeme auf ihre Leistungsfähigkeit in verschiedenen Anwendungsbereichen hat. Spiller sieht entsprechend in der Entwicklung automatisierter „therapeutischer Interventionen“ für KI-Systeme ein vielversprechendes Forschungsfeld.