Von wegen unmöglich: Forscher simulieren erstmals komplexe Quantenfehlerkorrektur

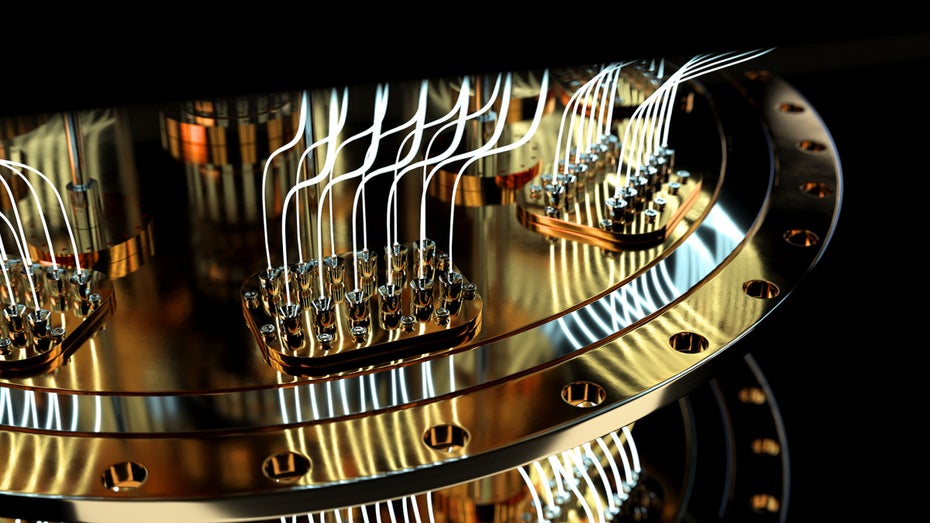

Ein Schritt näher am leistungsfähigen Quantencomputer. (Foto: Bartlomiej K. Wroblewski / Shutterstock)

Was auf dem Papier revolutionär erscheint, muss in der Praxis erst seine Zuverlässigkeit beweisen. Das gilt insbesondere für Quantencomputer, deren enorme Rechenleistung mit einer ebenso großen Anfälligkeit für Fehler einhergeht. Ein internationales Team von Physiker:innen hat jetzt eine Methode entwickelt, um einen entscheidenden Aspekt dieser neuen Computergeneration auf klassischen Systemen zu simulieren. Das ist eine Aufgabe, an der bisherige Ansätze scheiterten.

Veröffentlicht wurde die Methode im renommierten Fachmagazin Physical Review Letters. Sie stammt von einer Gruppe von Forscher:innen um den Doktoranden Cameron Calcluth und die außerordentliche Professorin Giulia Ferrini von der Chalmers University of Technology im schwedischen Göteborg. Beteiligt waren zudem Wissenschaftler:innen der Universitäten in Mailand, Granada und Tokio.

Der Flaschenhals der Fehlerkorrektur

Die zentrale Herausforderung für praxistaugliche Quantencomputer ist ihre Fehlerkorrektur. Jeder kleinste Einfluss von außen – Vibrationen, Strahlung, Temperaturschwankungen – kann die empfindlichen Quantenzustände (Qubits) stören und Berechnungen unbrauchbar machen. Um dies zu verhindern, verteilen Fehlerkorrektur-Codes die Informationen auf mehrere Systeme, um Fehler zu erkennen und zu beheben, ohne die Quanteninformation zu zerstören.

Um zu überprüfen, ob diese komplizierten Korrekturmechanismen wie beabsichtigt funktionieren, sind Simulationen unerlässlich. Doch gerade die vielversprechendsten Codes, wie der sogenannte Gottesman-Kitaev-Preskill-(GKP-)Code, beschreiben so komplexe Zustände, dass ihre Simulation auf herkömmlichen Supercomputern praktisch unmöglich war. Die dafür nötige Rechenzeit hätte das Alter des Universums überstiegen.

Ein neuer mathematischer Blickwinkel

Hier setzt die Arbeit des Teams an, über die SciTechDaily berichtet. Um das Problem zu verstehen, stellt euch vor, die Komplexität eines Quantenzustands ließe sich mit einem speziellen Messgerät analysieren. Das bisherige Standard-Messgerät für diese Aufgabe war die sogenannte Wigner-Funktion.

Wenn man sie auf die GKP-Zustände anwendete, schlug der Zeiger des Geräts extrem stark aus und zeigte einen hohen Wert an „Negativität“. Das ist ein Maß, das direkt anzeigt, wie unklassisch und damit wie rechenintensiv die Simulation eines Zustands ist. Ein hoher Negativitäts-Wert bedeutet: Die Simulation wird praktisch unmöglich.

Die Forscher:innen tauschten dieses universelle, aber für ihren Zweck ungeeignete Messgerät nun gegen ein Spezialwerkzeug aus: die Zak-Gross-Wigner-(ZGW-)Funktion. Dieses neue „Messgerät“ ist präziser auf GKP-Zustände zugeschnitten. Der entscheidende Durchbruch hängt mit einem Quanteneffekt zusammen, der als „Squeezing“ (deutsch: Quetschung) bezeichnet wird.

Was ist Squeezing? Man kann es sich wie die Fokussierung einer Welle vorstellen. In der Quantenmechanik gibt es bei Teilchen immer eine gewisse Unschärfe, etwa beim genauen Ort und beim Impuls. Squeezing ist eine Technik, die Unschärfe in einer Eigenschaft (zum Beispiel dem Ort) extrem zu reduzieren – sie also „zusammenzuquetschen“. Das geht allerdings nur auf Kosten einer größeren Unschärfe in einer anderen Eigenschaft (zum Beispiel dem Impuls). Für die Fehlerkorrektur sind solche stark gequetschten Zustände ideal, weil sie eine sehr präzise definierte Information tragen.

Und hier schließt sich der Kreis: Je stärker und präziser diese GKP-Zustände „gequetscht“ sind, desto ruhiger verhält sich das neue Messgerät, die ZGW-Funktion. Sie zeigt für diese für die Praxis so wichtigen Zustände eine verschwindend geringe Negativität an. Da die Geschwindigkeit des neuen Simulations-Algorithmus direkt von diesem Wert abhängt, wurde die vormals unmögliche Simulation plötzlich effizient und machbar.

„Wir haben einen Weg entdeckt, eine bestimmte Art von Quantenberechnung zu simulieren, bei der frühere Methoden nicht effektiv waren“, erklärt Erstautor Cameron Calcluth. Das Ergebnis ist beeindruckend: Der Algorithmus kann Schaltungen mit bis zu 1.000 Qudits (eine Verallgemeinerung von Qubits) bei einem Squeezing-Level von 12 Dezibel simulieren – ein Wert, der als notwendig für fehlertolerantes Quantenrechnen gilt. Der Mehraufwand gegenüber der Simulation eines einzigen Qudits ist dabei erstaunlich gering.

Ein Werkzeug, nicht die Lösung

So bedeutsam dieser Fortschritt für die Entwicklung ist, er ist kein Allheilmittel. Der Algorithmus beschleunigt nicht den Quantencomputer selbst, sondern liefert ein dringend benötigtes Validierungswerkzeug für die Entwickler:innen, die an der Hardware arbeiten. Er hat aber auch klare Grenzen, die in der Veröffentlichung selbst benannt werden.

Die Methode funktioniert demnach exzellent für sogenannte Stabilisator-Zustände und Clifford-Operationen. Doch was bedeutet das genau? Stellt euch die Clifford-Operationen als eine Art grundlegenden Werkzeugkasten für einen Quantencomputer vor. Sie umfassen eine Reihe von essenziellen Standard-Befehlen, die aber in ihren Möglichkeiten begrenzt sind. Damit lassen sich viele nützliche, aber nicht alle denkbaren Quantenalgorithmen ausführen.

Um von diesem soliden Grundgerüst zu einem universellen, für alle Probleme einsetzbaren Quantencomputer zu kommen, fehlt eine entscheidende Zutat: die sogenannten „magischen Zustände“ (magic states).

Diese Zustände sind keine Magie, sondern speziell präparierte, hochkomplexe Quantenzustände. Man kann sie sich als einen besonderen Schlüssel vorstellen. Erst wenn man diesen Schlüssel in den Schaltkreis „einspeist“, werden Operationen möglich, die über den einfachen Clifford-Werkzeugkasten hinausgehen. Sie schalten das volle Potenzial des Quantencomputers frei.

Genau hier liegt die Krux: Diese magischen Zustände sind nicht nur in der Herstellung aufwendig, ihre hohe Komplexität macht sie auch extrem schwer zu simulieren. Ihre Eigenschaften, die sie so mächtig machen, führen dazu, dass auch der neue Algorithmus an seine Grenzen stößt und die Simulation wieder rechenintensiv wird. Die vollständige Simulation eines universellen, fehlertoleranten Quantencomputers auf einem klassischen Rechner rückt damit zwar näher, bleibt aber auch weiterhin außer Reichweite.