SearchGPT Marke Eigenbau: So betreibt ihr eine lokale KI-Suchmaschine

Perplexity, you.com, Bing, Google und zuletzt auch OpenAI: Die Tech-Branche scheint überzeugt davon zu sein, dass die Zukunft der Websuche aus KI-generierten Zusammenfassungen besteht, statt aus den altbekannten Linklisten. Theoretisch könnte uns das viel Zeit ersparen, wenn die KI direkt die wirklich relevanten Informationen zu unserer Suche zusammenfasst. Aus Datenschutzsicht bringen uns die Cloud-Lösungen aber keine Verbesserung.

Wer nicht möchte, dass die eigenen Fragen über die Server von Microsoft, OpenAI oder Perplexity laufen, der kann mittlerweile aber eine Reihe von quelloffenen KI-Suchmaschinen selbst betreiben. Die meisten dieser Projekte befinden sich noch in einem recht frühen Entwicklungsstadium. Wir wollen euch am Beispiel des Open-Source-Projekts Farfalle aber dennoch zeigen, wie ihr lokal auf eurem Rechner eine KI-basierte Suchmaschine installiert und einsetzt.

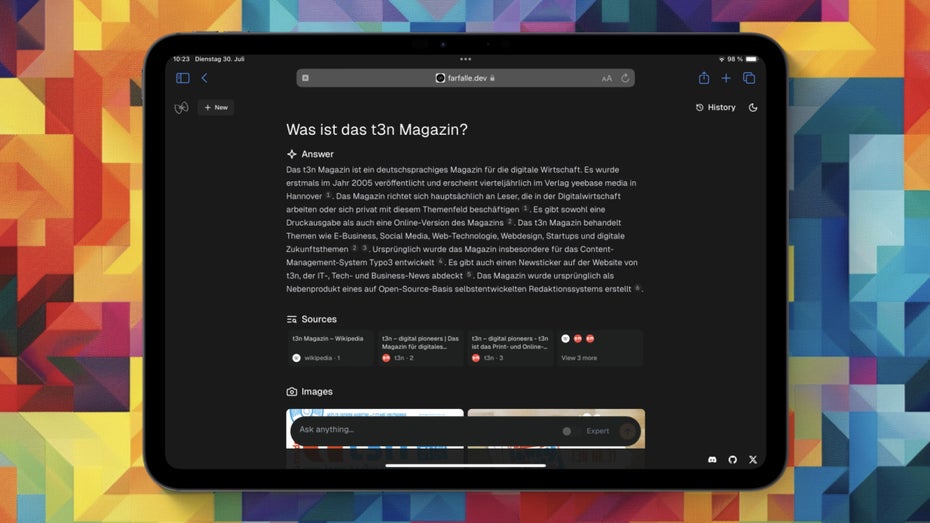

Dank Projekten wie Farfalle könnt ihr auch lokal eine KI-Suche ausführen – ganz ohne Cloud-Anbieter. (Screenshot: Farfalle / t3n)

Schritt für Schritt: So installiert ihr die KI-Suche Farfalle auf eurem Rechner

Farfalle steht euch als Docker-Container zur Verfügung. Sofern ihr Docker noch nicht installiert habt, müsst ihr die Virtualisierungslösung daher zunächst auf eurem Rechner installieren. Der erste Schritt besteht also darin, Docker Desktop herunterzuladen und zu installieren. Die Software ist für Windows, macOS und Linux verfügbar.

Anschließend müsst ihr Farfalle selbst von GitHub herunterladen. Dazu stehen euch verschiedene Möglichkeiten offen. Sofern ihr die Versionsverwaltungssoftware Git installiert habt und euch einigermaßen wohl mit dem Terminal fühlt, geht der einfachste Weg über die Kommandozeile. Hier gebt ihr lediglich folgenden Befehl ein:

git clone https://github.com/rashadphz/farfalle.git

Aber keine Angst. Ihr könnt alternative auch GitHub Desktop herunterladen und das Ganze über das grafische Benutzungsinterface der Software machen. Dafür benötigt ihr nicht mal zwingend ein GitHub-Konto. Öffnet einfach das Programm und wählt Clone a Repository. Anschließend klickt ihr auf den Reiter URL, und fügt rashadphz/farfalle in das URL-Feld ein. Jetzt wählt ihr noch einen Zielordner und klickt auf Clone.

Was jetzt noch fehlt, ist ein KI-Modell. Farfalle bringt zwar eine eigene Instanz der Peer-to-Peer-Suchmaschine SearxNG mit, die für die Web-Ergebnisse sucht. Die muss aber noch von einem geeigneten KI-Modell verarbeitet werden. Theoretisch könnt ihr per API-Key auch Cloud-Modelle von OpenAI oder Groq nutzen. In unserem Beispiel soll es aber um eine vollständig selbst gehostete Alternative gehen – ganz ohne Cloud-Anbieter.

Daher benötigt ihr das Programm Ollama. Mit dem könnt ihr lokal und ohne viel Aufwand eine Reihe von KI-Modellen auf eurem Rechner ausführen. Farfalle unterstützt Llama 3, Mistral, Gemma und Phi 3. Für unser Beispiel wollen wir Metas Llama 3 einsetzen.

Dazu installiert ihr zunächst Ollama und anschließend das KI-Modell Llama 3. Hierfür könnt ihr theoretisch auch ein grafisches Interface für Ollama herunterladen. Wie das funktioniert, haben wir euch in diesem Artikel über Ollama erklärt. Der einfachere Weg ist allerdings, einfach den folgenden Befehl in den Terminal einzugeben:

ollama run llama3

Jetzt habt ihr alles, was nötig ist, auf eurem Rechner. Alles, was ihr jetzt noch tun müsst, ist Farfalle über Docker zu starten. Dazu navigiert ihr zu dem Ordner, in dem ihr Farfalle gespeichert habt, und öffnet dort ein Terminal-Fenster. Unter macOS erreicht ihr das, indem ihr per Rechtsklick auf den Ordner klickt und Neues Terminal beim Ordner auswählt. Anschließend gebt ihr folgenden Befehl ein:

docker-compose -f docker-compose.dev.yaml up -d

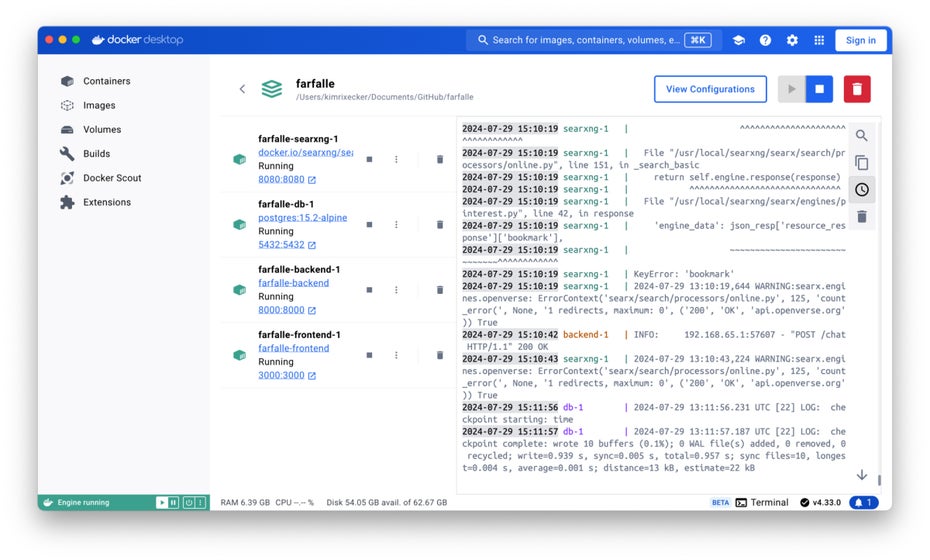

Farfalle in Docker. (Screenshot: Docker Desktop / t3n)

Et voilà! Jetzt sollte nach kurzer Wartezeit eure Farfalle-Instanz laufen. Aufrufen könnt ihr eure ganz eigene KI-Suche, indem ihr mit dem Browser auf die Adresse http://localhost:3000 navigiert. Alternativ findet ihr den Link auch in Docker Desktop unter farfalle-frontend-1. Dort könnt ihr auch überprüfen, ob euer Container wie gewünscht läuft.

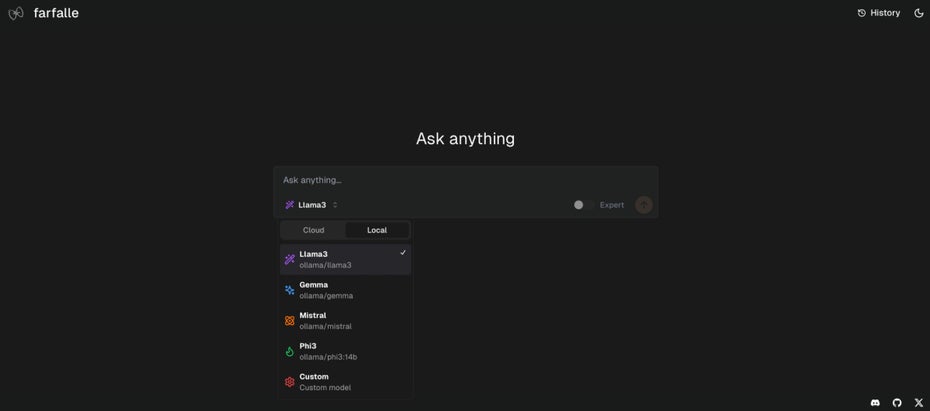

Im Farfalle-Frontend müsst ihr jetzt nur noch Llama 3 auswählen. Standardmäßig ist hier als KI nämlich OpenAIs Cloud-Angebot ausgewählt. Mit einem Klick auf das Auswahlmenü am unteren linken Rand des Suchfeldes kommt ihr auf die KI-Auswahl. Hier klickt ihr zunächst auf den Reiter Local und wählt dann Llama 3 aus.

In Farfalle müsst ihr noch Llama 3 als lokales KI-Modell auswählen. (Screenshot: Farfalle / t3n)

Licht und Schatten: Das kann die KI-Suche Farfalle mit Llama 3 – und das nicht

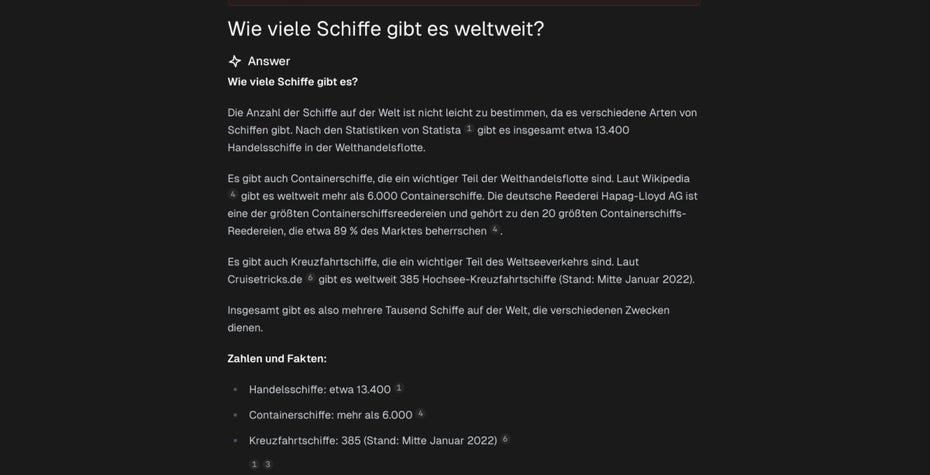

Wie bei der kommerziellen KI-Suche Perplexity könnt ihr Farfalle eure Fragen stellen und erhaltet dann einen kurzen Text als Antwort. Die Antworten basieren auf Web-Ergebnissen, die jeweils als Quellen unterhalb des Textes verlinkt sind.

Angereichert werden die Ergebnisse mit passenden Bildern aus dem Netz. Außerdem zeigt euch Farfalle weiterführende Fragen an, die ihr mit einem Klick ausführen könnt.

Fragen könnt ihr problemlos auf Deutsch stellen. Allerdings ist das keine Garantie dafür, dass die Antwort auch auf Deutsch erfolgt. Wer kein Englisch kann, ist hier eindeutig im Nachteil.

Ebenfalls zu beachten: Wann immer ihr eine Frage stellen wollt, die mit dem vorherigen Thema nichts zu tun hat, solltet ihr unbedingt oben Rechts auf den New-Button klicken. Ansonsten bezieht Farfalle das bisherige Thema in die Beantwortung mit ein, was dazu führt, dass bisweilen nicht eure Frage, sondern eine zum vorherigen Thema passende Frage beantwortet wird.

Aufpassen müsst ihr aber auch bei den Antworten selbst. Zwar gibt Farfalle Web-Quellen für die Antworten an, das garantiert aber auch nicht zu 100 Prozent, dass diese Quellen die gemachten Angaben wirklich hergeben. Mit diesem Problem steht die Open-Source-Lösung aber nicht alleine da.

Auch Perplexity hatte in unseren Tests ähnliche Probleme und selbst in dem Vorstellungsvideo von OpenAIs neuer KI-Suche SearchGPT befand sich ein Fehler. Ähnlich sieht es bei Googles KI-Suche aus, die im Netz für viel Spott gesorgt hat.

Letztlich ist die Technologie noch nicht wirklich so weit, dass sie uns treffsicher und ohne Falschinformationen alle Fragen beantworten kann. Mit Farfalle habt ihr aber immerhin den Vorteil, dass eure Fragen nicht über die Server der großen Tech-Unternehmen wandern.