ChatGPT und Co: Wir zeigen euch die wichtigsten Prompts für euren Job

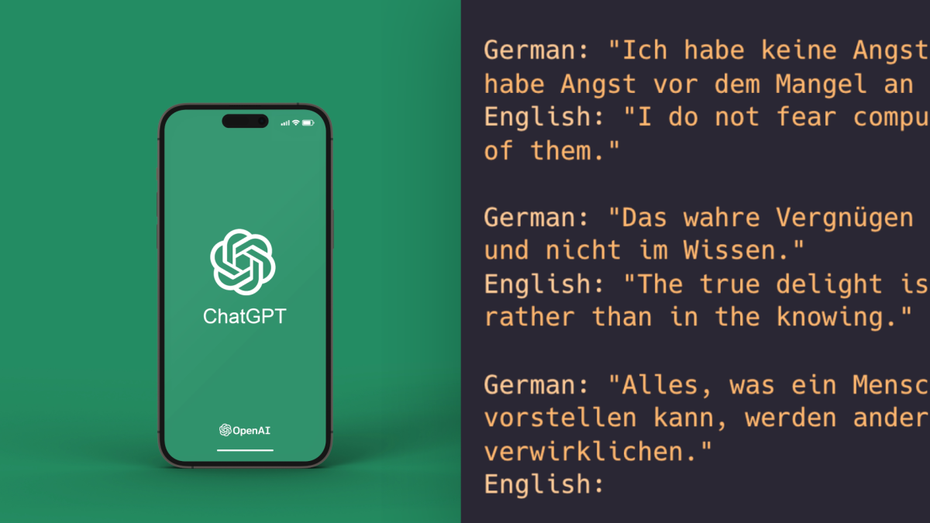

ChatGPT, Ernie Bot und Googles Bard: Künstliche Intelligenz ist greifbarer denn je. Sie ist dabei nicht nur nette Spielerei; Bild-KI und Chatbots bieten viel Potenzial und können Nutzer:innen tatsächlich auch bestimmte Aufgaben abnehmen. Dafür braucht es aber die richtigen Prompts.

- Sofort-Zugriff auf die exklusiven Briefings

- Digitaler Zugang zu allen Ausgaben des t3n Magazins

- Guides und Surveys im Wert von bis zu 396 Euro inklusive

- Exklusive Sessions mit t3n und Digital-Expert*innen

Du bist bereits Pro-Member? Hier anmelden