Künstliche Intelligenz als Geschäftsmodell: Wie Unternehmen sie einsetzen können

(Foto: Shutterstock/Konstantin Faraktinov)

Was passiert, wenn die Maschine smarter wird und uns immer mehr Aufgaben abnehmen kann? Diese Frage beschäftigt den Menschen schon seit Jahren, aber 2016 erreichte der Rummel seinen vorläufigen Höhepunkt: Künstliche Intelligenz (KI) oder auch Artificial Intelligence (AI) waren überall Thema. Das Marktforschungs- und Beratungshaus Tractica geht davon aus, dass der weltweite Umsatz mit KI von derzeit jährlich 643,7 Millionen auf 38,8 Milliarden US-Dollar im Jahr 2025 anwachsen wird. Der Umsatz mit KI-Anwendungen für Unternehmen soll von 358 Millionen jährlich auf 31,2 Milliarden US-Dollar (2025) steigen. Das ergibt laut Tractica eine durchschnittliche jährliche Zuwachsrate von stolzen 64,3 Prozent. Unternehmen aller Größen, Branchen und Formen stehen damit vor wichtigen Fragen: Mit welchen KI-Businessmodellen und -Anwendungen überzeuge ich meine Kunden? Und welche Technologien und Infrastrukturen sind dafür notwendig?

So funktioniert künstliche Intelligenz

„Das Ziel künstlicher Intelligenz ist es, Maschinen zu entwickeln, die sich so verhalten, als wären sie intelligent“, schrieb der US-amerikanische Logiker und Informatiker John McCarthy bereits 1955. Mit anderen Worten: Es liegt in der Verantwortung der Menschen, ihr Wissen mit Maschinen so zu teilen, als würden sie dies mit ihren Kindern, Partnern oder Kollegen tun. Anders können Hard- und Software niemals das werden, was man als intelligent bezeichnen könnte. Und nur so lässt sich eine Basis für selbstlernende Systeme schaffen. Dabei unterscheidet die KI-Forschung drei Typen der KI:

Strong AI

Sie ist eine selbstbewusste Maschine mit Gedanken, Gefühlen und einem Bewusstsein sowie den entsprechenden neuronalen Vernetzungen. Wer sich nun schon auf eine Realität wie in Filmen à la „Her“ oder „Ex Machina“ freut, der wird sich noch etwas gedulden müssen: Strong AIs existieren leider noch nicht und es ist unklar, wie lange sie noch auf sich warten lassen.

Narrow AI

Sie ist sehr gut darin, spezifische Aufgaben zu lösen, wie etwa Songs auf Pandora zu empfehlen oder die Tomatenzucht in einem Gewächshaus zu optimieren. Die meisten KI-Anwendungen fokussieren sich derzeit auf solche Lösungen für sehr spezielle Probleme.

General AI

Sie kann Aufgaben aus unterschiedlichen Bereichen und Ursprüngen bearbeiten. Zudem kann sie ihre Trainingsintervalle verkürzen, indem sie die in einem Bereich gesammelten Erfahrungen in einen artfremden Bereich übertr.gt. Dieser Wissenstransfer ist nur möglich, wenn eine semantische Verbindung zwischen den Bereichen existiert. Je stärker und verdichteter diese Verbindung ist, desto schneller und einfacher ist der Wissensübergang. Im Gegensatz zur Narrow AI könnte eine General AI also zum Beispiel nicht nur die Tomaten-, sondern auch die Gurken-, Auberginen-, Paprika- und Radieschenzucht optimieren. Sie kann somit mehr als nur eine spezifische Aufgabe lösen.

Ohne Technologien wie das Cloud-Computing hätte KI nicht diesen Boom erlebt. Cloud-Services und die fortschreitende Maschinenintelligenz erleichtern es Unternehmen, sich mit Hilfe KI-basierter Funktionen enger mit ihren Kunden auszutauschen. Firmen wie Airbnb, Uber oder Expedia setzen bereits auf cloudbasierte Systeme, um KI-relevante Aufgaben zu verarbeiten. Diese benötigen einen intensiven CPU- oder GPU-Einsatz sowie Services für umfangreiche Datenverarbeitungs- und Analyseaufgaben.

Unternehmen, die diesen Schritt ebenfalls gehen wollen, sollten eine KI-Strategie entwickeln. Auf dieser Basis sollten sie die KI-Services der Cloudanbieter evaluieren und eine KI-definierte Infrastruktur planen. Einer solchen Infrastruktur sollte eine „General AI“ zugrunde liegen, die drei typische (menschliche) Eigenschaften vereint: Mit ihnen können Unternehmen ihre IT- und Geschäftsprozesse per KI steuern.

Lernen (Learning)

Experten übermitteln der „General AI“ in Lerneinheiten ihre bewährten Methoden, Verfahren und Gedankengänge. Granulare Wissenspartikel vermitteln Stück für Stück die wichtigen Prozesse. Am Beispiel eines Gewächshauses bedeutet dies etwa: Experten lehren die KI alle Prozessschritte, die notwendig sind, um eine Tomate, Gurke, Aubergine oder Paprika zu züchten. Dabei erhält die KI kontextbezogenes Wissen wie „Was muss gemacht werden?“ und „Warum muss das gemacht werden?“.

Verstehen (Understanding)

Aus all diesen Informationen erstellt die „General AI“ einen semantischen Graph. Durch ihn versteht sie die Welt um das Unternehmen, seine IT und seinen Geschäftszweck herum. Wiederum bezogen auf das Gewächshausbeispiel gehören dazu verschiedene Kontexte – etwa Eigenschaften und Spezifika des Gewächshauses sowie der Gurken-, Auberginen- und Paprikazucht. Diesen Graph füttert die „General AI“ ständig mit neuem Wissen aus weiteren Lerneinheiten. Die IT des Unternehmens spielt dabei eine wichtige Rolle, da hier alle Daten zusammenlaufen.

Lösen (Solving)

Das Konzept des sogenannten „Machine Reasoning“ kann Probleme in unklaren und sich ständig verändernden Umgebungen lösen. So kann die „General AI“ auf fortwährend wechselnde Kontexte reagieren und den besten Ablauf wählen. Die Gewächshaus-General-KI könnte durch Machine Reasoning nicht nur Lernen und Verstehen, das wäre eine Narrow AI. Sie kann auch bestmögliche Wissenskombinationen ermitteln, um Lösungen für Probleme selbstständig zu finden. So lässt sich nicht nur die Bearbeitungszeit verkürzen. Auch die Zahl möglicher Permutationen vergrößert sich exponentiell mit der steigenden Wissensmenge. Je größer der semantische Graph, desto mehr weitere Gemüsesorten könnte die Gewächshaus-General-KI züchten.

Anforderungen an KI-Infrastrukturen

KI kann nicht nur existierende Infrastrukturen – etwa Cloud-Umgebungen– verbessern. Sie kann auch eine ganz neue Generation von Infrastruktur-Technologien vorantreiben. Denn sie verlangt nicht nur neue Programmier-Frameworks, sondern stellt auch ganz andere Anforderungen an die Hardware.

Mobile- und Internet-of-Things-Anwendungen hatten bisher nur geringe Anforderungen an die Runtime-Umgebung einer Infrastruktur. Kritisch sind bei ihnen dagegen die entsprechenden Services, um ein Backend aufzubauen. Im Gegensatz dazu erwarten KI-Applikationen anspruchsvolle Backend-Services und auch optimierte Runtime-Umgebungen, die auf die GPU-intensiven Anforderungen der KI-Lösungen abgestimmt sind. Denn KI-Anwendungen fordern die Infrastruktur durch die parallele Verarbeitung von Aufgaben in sehr kurzen Zeitzyklen heraus.

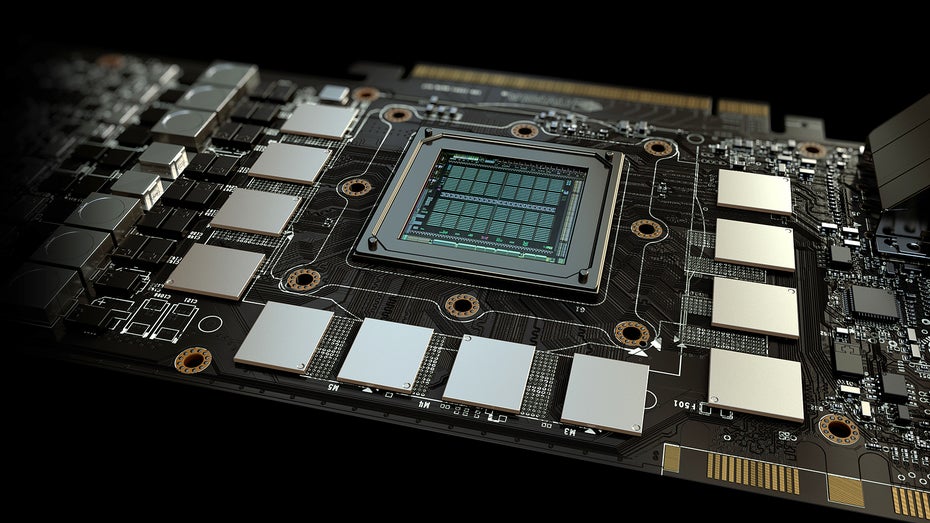

Vor allem für die Beschleunigung von Deep-Learning-Anwendungen kommen deshalb bevorzugt GPU-Prozessoren zum Einsatz. GPU-optimierte Anwendungen verteilen die rechenintensiven Bereiche der Anwendung auf die GPU, also den Grafikprozessor, und lassen die einfachen Berechnungen wie gewöhnlich von der CPU verarbeiten. Das beschleunigt die Ausführung der gesamten Anwendung.

Nvidia war bisher vor allem als Produzent von leistungsstarken Grafikkarten, etwa für Gaming-PCs, bekannt. Weil KI-Anwendungen aber besonders gut auf Grafikprozessoren (GPU) laufen, erlebt das Unternehmen einen regelrechten Aufwind. Hier im Bild die Titan-X-Grafikkarte. (Foto: Nvidia)

Der Vorteil einer GPU gegenüber einer CPU zeigt sich in den entsprechenden Architekturen: Eine CPU ist auf die serielle Verarbeitung ausgelegt und enthält nur wenige Kerne. Eine GPU besteht dagegen aus einer parallelen Architektur mit vielen kleineren Kernen, die die Aufgaben gleichzeitig bearbeiten. Laut Nvidia ist der Anwendungsdurchsatz einer GPU zehn- bis hundertmal größer als der einer CPU. Eine KI-Infrastruktur sollte also bei Bedarf ein Deep-Learning-Framework wie Tensorflow oder Torch mit hunderten oder gar tausenden Nodes bereitstellen können, die mit der optimalen GPU-Konfiguration zur Verfügung stehen.

Damit haben Unternehmen die Basis, um eine Anforderungsliste für ihre KI-Infrastruktur zusammenzustellen. Die Checkliste sollte unter anderem folgende Punkte unbedingt beantworten können:

- Unterstützt sie gängige KI-Frameworks? Kann die Infrastruktur KI-Applikationen, die auf gängigen KI-Frameworks wie Tensorflow, Caffe, Theano oder Torch laufen, genauso unterstützen wie Web-Applikationen oder Backend-Prozesse? Eine Infrastruktur sollte sich nicht nur auf ein KI-Framework beschränken, sondern im Interesse von Entwicklern ein möglichst gro.zügiges Portfolio abdecken. Bietet sie eine GPU-optimierte Umgebung? Stellt die Infrastruktur GPU-Umgebungen bereit, um dank schneller Rechenleistung willkürlich jeden KI-Prozess ausführen zu können? Mit seinen N-Series-GPU-Instanzen für Azure ist Microsoft zum Beispiel einer der Vorreiter in diesem Bereich.

- Wie sieht die Managementumgebung aus? Können KI-Framework und Infrastruktur direkt zusammenspielen? Wie gut ist deren Abstimmung und somit die Gesamtleistung? Die hier verfügbaren Managementwerkzeuge sind derzeit für KI-Infrastrukturen die größte Herausforderung.

- Gibt es KI-integrierte Infrastruktur-Services? Infrastrukturanbieter werden KI-Funktionen künftig nicht nur unterstützen, sondern als zentralen Bestandteil ihrer Infrastrukturund Service-Stacks integrieren. Diese Form der „AI-defined Infrastructure“ wird nicht nur die Intelligenz von Cloud-Services und Cloud-Applikationen erhöhen, sondern auch den Betrieb und Aufbau von KI-Infrastrukturen für Unternehmen vereinfachen.

Ist Machine Reasoning möglich? Stellt der Infrastruktur-Anbieter Machine-Reasoning-Technologien bereit? Kann die KI von Unternehmen also Probleme in unklaren und insbesondere sich ständig verändernden Umgebungen selbstständig lösen?

KI-Infrastruktur und -Technologien

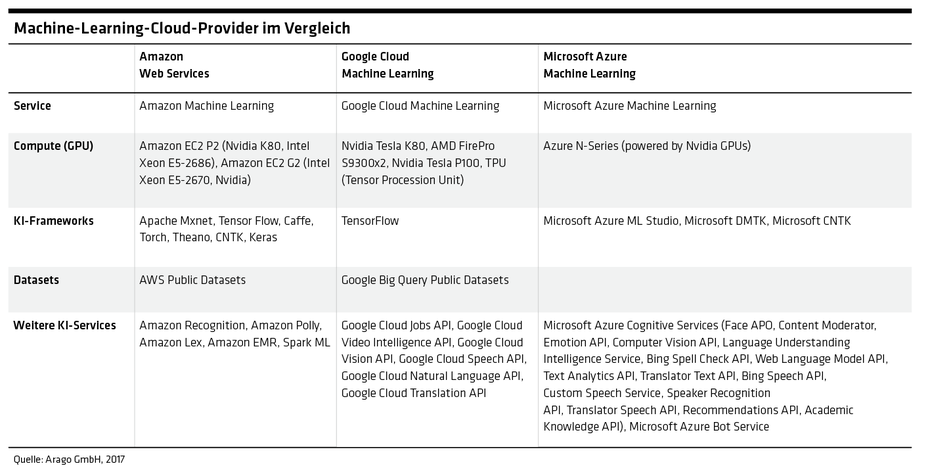

Die vergangenen Jahre haben enorme Investitionen in die KI-Funktionen der Cloudplattformen mit sich gebracht. Die führenden Public-Cloud-Anbieter Amazon, Microsoft und Google liegen hier weit vorne. Aber auch viele PaaS-Anbieter haben ihre Angebote um AI-Services erweitert. Die AI-Technologie-Landkarte besteht derzeit aus drei Hauptgruppen: den Cloud-Machine- Learning(ML)-Plattformen, den KI-Cloudservices und den Technologien für Private- und Public-Cloud-Umgebungen.

Zu den Cloud-ML-Plattformen gehören zum Beispiel Azure Machine Learning, AWS Machine Learning oder Google Machine Learning. Mit ihnen können Unternehmen ein „Machine Learning Model“ mit Hilfe proprietärer Technologien nutzen. Das heißt aber auch: Außer bei Google Cloud ML, das auf Tensorflow setzt, und AWS Machine Learning lassen sich mit den meisten Cloud- ML-Services AI-Applikationen auf Basis von etwa Theano, Torch, Tensorflow oder Caffe nicht ausführen.

Mit KI-Cloudservices wie Microsoft Cognitive Services, Google Cloud Vision oder Natural Language APIs können Unternehmen komplexe KI- oder Cognitive-Computing-Fähigkeiten anhand einer einfachen API aufrufen. So können sie Applikationen mit KI-Fähigkeiten entwickeln, ohne in die dafür notwendigen KI-Infrastrukturen investieren zu müssen.

Technologien für Private- und Public-Cloud-Umgebungen lassen sich auf Public-Cloud-Umgebungen wie Amazon Web Services oder auf Private-Cloud-Umgebungen wie Openstack oder VMware betreiben. Mit ihnen können Unternehmen auf Basis einer „General AI“ kontextübergreifende KI-basierte Geschäftsmodelle entwickeln und betreiben.

Wettbewerbsvorteile sichern mit KI und der richtigen Infrastruktur

Unternehmen müssen längst nicht nur um Talente oder effektive Veränderungen kämpfen. Sie stehen auf einmal in Konkurrenz mit Hightech-Unternehmen wie Amazon, Google, Microsoft oder Facebook, die unaufhaltsam in renommierte Märkte einmarschieren. Mit riesigen finanziellen Mitteln kapern sie den gesamten Kundenlebenszyklus vermeintlich bekannter Wettbewerbslandschaften.

Amazon ist nur ein Beispiel: Der US-Konzern hat die Zwischenhändler in seiner Lieferkette aus dem Weg geräumt – und mit „Amazon Prime Air“ Unternehmen wie DHL, UPS oder Fedex gehörig unter Veränderungsdruck gesetzt. Wie lange wird es dauern, bis Facebook eine Bankenlizenz beantragt? Zugang zu potenziellen Kunden, ausreichende Nutzerinformationen und genug Kapital hat es jedenfalls. Folglich müssen eingesessene Unternehmen schlagkräftige Antworten finden.

KI kann dabei Antworten liefern und ein Innovationswerkzeug sein, mit dem sich Unternehmen Wettbewerbsvorteile sichern. Deshalb ist eine KI-definierte Infrastructure mittlerweile ein essenzieller Teil moderner Enterprise-Stacks: Sie ist die Basis für ein KI-fähiges Unternehmen. Mit der Entwicklung der KI-Anwendungen müssen sich IT-Infrastrukturen deshalb von einem unterstützenden Modus hin zu einem Modell wandeln. Sie müssen dann KI-Applikationen ebenso unterstützen wie heute die Web-Applikationen und -Services.