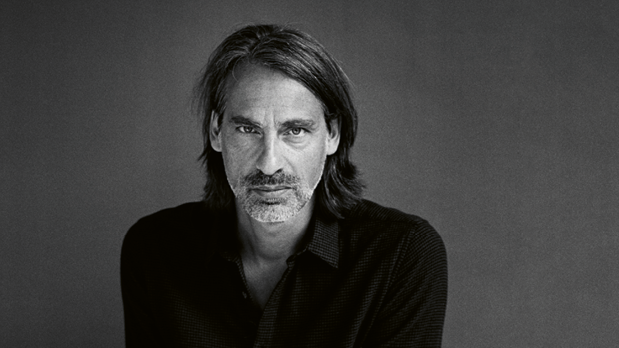

Precht im Interview: Ewiges Leben in der Cloud? „Nein, danke!“

Gehirn-Backup in der Cloud? Die erste menschliche Kolonie auf dem Mars? Eine Superintelligenz, die die Menschheit versklavt? Für Richard David Precht, einen der berühmtesten Philosophen des Landes, alles Hirngespinste einer nerdigen Tech-Elite aus Kalifornien. Mit ihren Visionen will sie uns laut Precht glauben lassen, dass alle Probleme der Welt mit Technologie lösbar sind. Das führe etwa auch zu der Forderung, KI ethisch zu programmieren – Precht hält das für naiv, wenn nicht gar gefährlich.

Der Philosoph kritisiert immer wieder öffentlichkeitswirksam das Silicon Valley. Auch in seinem neuen Buch „Künstliche Intelligenz und der Sinn des Lebens“ tut er das, bisweilen polemisch, in jedem Fall hart in der Sache. Manchmal lenkt diese Polemik von seinem eigentlichen Thema ab, denn das Buch wird vor allem dann interessant, wenn Precht sich explizit mit der menschlichen Intelligenz auseinandersetzt und fordert, sie als „das Nicht-Banale am Menschen neu zu entdecken“, und zwar „nicht als das Andere der Natur, sondern als das Andere der künstlichen Intelligenz.“ Und müsste nicht diese philosophische Auseinandersetzung mit dem Menschsein im 21. Jahrhundert und seinen Konsequenzen das eigentlich große Thema von Prechts neuer Veröffentlichung sein?

Wir sprachen Anfang Juni mit ihm am Telefon, als sein neues Buch gerade erschienen war und die Weltpolitik sich mit den wirtschaftlichen Folgen der Corona-Pandemie auseinandersetzte.

t3n: Herr Precht, warum schreibt ein Philosoph ein Buch über künstliche Intelligenz?

Richard David Precht: Das Thema Intelligenz ist ja ein philosophisches Thema. Künstliche Intelligenz ist von erheblicher Auswirkung auf unsere Gesellschaft. Und die Aufgabe von Philosophen besteht darin, über die Gesellschaft nachzudenken; insofern ist das ausgesprochen naheliegend, sich damit zu beschäftigen.

t3n: Worin unterscheidet sich denn menschliche Intelligenz von der künstlichen?

Es gibt ganz erhebliche Unterschiede, vor allem natürlich, weil wir im Gegensatz zu künstlicher Intelligenz emotionale Wesen sind. Wir haben ein Ich-Zentrum, auf das wir das, was wir erleben, beziehen. Wir Menschen sind fiktionsbedüftig, leben in unserer Fantasie also gerne in anderen Zeiten und anderen Welten. Das kann künstliche Intelligenz nicht. Und wir sind aufgrund all der anderen Eigenschaften moralfähig.

t3n: Ist das überhaupt Intelligenz, wenn wir von der Software sprechen, die wir heute als künstliche Intelligenz beschreiben?

Das ist eine schwierige Frage. Auch unter KI-Forschern selbst ist der Begriff künstliche Intelligenz nicht ganz unumstritten. Es gibt durchaus Spitzeninformatiker, die den Begriff nicht mögen. Intelligenz ist nach einer Definition von Jean Piaget das, was man einsetzt, wenn man nicht weiß, was man tun soll. Und das gilt natürlich im absoluten Sinne für künstliche Intelligenz nicht, da sie programmiert ist – selbst wenn sie innerhalb ihrer Programmierung auf kreative Lösungen kommt.

t3n: So etwas wie den gesunden Menschenverstand zum Beispiel können Maschinen nie verstehen?

Das wird in der Tat schwierig. Die menschliche Intelligenz dient in allererster Linie dazu, sich im Leben zu orientieren. Und Leben ist ein unglaublich komplexer und unberechenbarer Vorgang. Normales Leben fließt nicht in geregelten Bahnen. Und dafür sind unsere Gehirne im Evolutionsprozess optimiert worden. Das ist ein ganz großer Unterschied zur künstlichen Intelligenz, deren Aufgabe darin besteht, in geregelten Bahnen spezielle Aufgaben zu lösen. Und das, was der Mensch kann – sich in sehr komplexen Situationen zurechtfinden und ganz, ganz viele Aspekte einschließlich der emotionalen zu erwägen –, das kann künstliche Intelligenz in vergleichbarem Umfang nicht und wird es auch auf sehr lange Zeit nicht können.

t3n: Sie bestreiten also, dass es eines Tages eine Art Superintelligenz geben könnte?

Man kann darüber streiten, wie intelligent künstliche Intelligenz werden kann. Was ich aber für absoluten Kokolores halte, ist die Vorstellung, dass eine solche Superintelligenz einen eigenen Willen entwickelt. Dass eine künstliche Intelligenz böse wird und sich gegen die Menschen verschwört, ist völlig unrealistisch, ist philosophisch gesehen totaler Quatsch und entstammt Science-Fiction-Mustern, die wir hier leichtfertig übertragen. Ebenfalls wie aus Science-Fiction-Filmen wirken Vorstellungen aus dem Trans- beziehungsweise Posthumanismus, dass wir eines Tages das menschliche Gehirn in der Cloud speichern können.

t3n: Warum halten sich diese Diskussionen so hartnäckig?

Ich glaube, diese Erzählungen haben eine strategische Funktion. Man entwirft solche Bilder, wie das Leben in 50 Jahren wohl ist, wenn wir unsere Gehirne in Silizium konservieren und in Datenclouds weiterleben, um alle Schritte, die jetzt im Hinblick auf künstliche Intelligenz gemacht werden, als Wege zu einem fantastischen Ziel darzustellen. Und dafür sind diese Fantasien so wichtig. Man verspricht den Menschen ein Paradies und erklärt alle Maßnahmen – die totale Überwachung durch Digitalisierung, Versuche, Autos moralisch zu programmieren, KI-gesteuerte Waffensysteme – als notwendige Schritte auf dem Weg zum Paradies. Das ist der Sinn dieser Erzählungen.

t3n: Ewiges Leben wäre also nichts für Sie?

Naja, ich habe keine Lust, in Silizium weiterzuleben. Ich meine, das mag jeder für sich entscheiden. Interessant ist, dass die gleichen Leute, die davon träumen, auch immer Fans davon sind, andere Planeten zu besiedeln. Also ich kann mir nichts Ätzenderes und Langweiligeres vorstellen, als auf dem Mars leben zu müssen.

t3n: Glauben Sie denn, dass durch Corona solche transhumanistischen Ideen, die den menschlichen Körper als verletzliche Hülle überwinden wollen, an Bedeutung zunehmen?

Ja, das könnte ich mir vorstellen, allerdings bei einer ziemlich kleinen Klientel. Bestimmte Nerds fühlen sich vermutlich beflügelt. Aber man darf nicht vergessen: Wenn ich auf Silizium gespeichert bin, können auch Viren angreifen. Und diese Computerviren lassen mich dann total abstürzen.

Das Silicon Valley jedenfalls ist ein großer Fan solcher transhumanistischen Vorstellungen wie Gehirn-Backups in der Cloud.

Ich weiß gar nicht, ob die IT-Gurus im Silicon Valley das wirklich glauben. Also der eine oder andere vielleicht, ja. Stephen Hawking hat das offensichtlich geglaubt. Aber ich könnte mir vorstellen, dass Elon Musk oder Ray Kurzweil das nicht wirklich glauben, sondern diese Erzählungen als Ablenkungsmanöver nutzen.

t3n: Ein Ablenkungsmanöver für was?

Wir sollen uns davor fürchten, dass künstliche Intelligenz böse wird, und deswegen sollen wir sie ethisch programmieren, damit sie gut ist. Damit überschreiten wir aber eine gewaltige Grenze, wenn wir versuchen, KI ethisch zu programmieren.

t3n: Geht das überhaupt, künstliche Intelligenz ethisch zu programmieren?

Meines Erachtens geht es nicht. Weil wir in Situationen, in denen wir moralische Entscheidungen fällen, sehr stark emotional reagieren. Und da künstliche Intelligenz keine Emotionen hat, können wir sie nicht moralisch programmieren. Was wirklich durch und durch programmiert ist, das handelt nicht moralisch, weil es ja keine Freiheit hat. Ich nenne ja nur da ein Urteil moralisch, wenn ich meine, frei entschieden zu haben. Wenn ich das aber gar nicht kann, dann haben wir es nicht mit moralischen Entscheidungen zu tun.

t3n: Aber angenommen, autonom fahrende Autos, die von einer KI gesteuert werden, würden die Sterblichkeit bei Verkehrsunfällen tatsächlich um 90 Prozent reduzieren. Würden Sie dann trotzdem sagen, das sollten wir nicht tun?

Die Vorstellung, dass das autonom fahrende Auto die Sterblichkeit so dramatisch reduziert und dass es die einzige Möglichkeit ist, das zu tun, ist ja schon wahnsinnig konstruiert. Wenn wir weniger Verkehr auf unseren Straßen haben und die Leute fahrtüchtiger sind oder wenn sie langsamer fahren, haben wir ja auch sehr viel weniger Verkehrstote. Deswegen finde ich das Beispiel an den Haaren herbeigezogen. Es gibt so viele Möglichkeiten, die Zahl der Verkehrstoten zu reduzieren. Wir müssen nicht unbedingt etwas machen, das wir – gegen den Vorstellungen des Grundgesetzes – moralisch programmieren müssen: Eine Maschine, die den Wert menschlichen Lebens aufrechnet, haben wir zuletzt im Dritten Reich gehabt und das ist in Deutschland strengstens verboten.

„Normales Leben fließt nicht in geregelten Bahnen. Und dafür sind unsere Gehirne im Evolutionsprozess optimiert worden.“

t3n: Wie meinen Sie das?

Wenn autonomes Fahren nur unter der Bedingung möglich sein sollte, dass eine Maschine den Lebenswert von Menschen einstuft oder abstuft, um danach zu bemessen, wie der Wagen in einer Konfliktsituation ausweicht, dann leben wir in einem anderen Staat. Das ist mit dem Grundgesetz völlig unvereinbar, weil unsere Vorstellung von Menschenwürde nicht zulässt, dass menschlicher Lebenswert abgestuft wird. Und ich bin auch erstaunt, mit welcher Leichtfertigkeit hier Debatten geführt werden, die den zentralsten Satz, der überhaupt im Grundgesetz steht, nicht mehr so richtig ernst nehmen …

t3n: … dass die Würde des Menschen unantastbar ist …

… der Satz steht deswegen drin, weil wir die Erfahrung des Dritten Reiches gemacht haben. Da hat man den Lebenswert von Menschen relativiert.

t3n: Was ist denn aus Ihrer Sicht wichtig, wenn man künstliche Intelligenz regulieren will?

Es gibt Kriterienkataloge und alle erdenklichen Initiativen, die von vielen Menschen unterstützt werden. Da stehen sehr viele schöne, hehre Ziele drin, wie zum Beispiel Nichtnachteiligkeit, Offenheit und Transparenz. Keiner soll benachteiligt, keiner diskriminiert werden und so. Das ist ja alles gut und richtig. Aber was mir fehlt, ist eine klare rote Linie. Überall dort, wo künstliche Intelligenz zukünftig über das Leben von Menschen entscheiden soll, braucht es eine klare rote Linie. Und ich sehe bislang nicht, dass diese Linie wirklich klar gezogen wird. Das zu tun, wäre die vordringlichste Aufgabe.

Betrachten wir KI als das, was es ist: Analysesoftware, die auf Basis statistischer Wahrscheinlichkeiten arbeitet und dann beispielsweise Effizienzgewinne in bestimmten Bereichen erzielen kann.

t3n: Welchen positiven Einfluss könnte denn eine so gedachte KI auf unsere Gesellschaft haben?

Zunächst einmal kann sie die Menschen von sehr langweiliger Büroarbeit befreien. Dieser Arbeit werden wir langfristig auch nicht hinterhertrauern, genauso wenig wie wir der Arbeit in den Kohlegruben oder in den Stahlwerken hinterhertrauern. Nachdem wir also einförmige körperliche Arbeit weitgehend abgeschafft haben, könnten wir das jetzt mit einförmiger geistiger Arbeit tun.

t3n: Was noch?

Wir können uns in der Wissenschaft, speziell in der Medizin, viel davon versprechen, weil wir deutlich komplexere Datenmengen verarbeiten können. Es ist jetzt möglich, Millionen von Krankenakten einzuspeisen und Krankheitsverläufe sehr, sehr viel genauer und präziser vorauszuberechnen und zu erkennen. Das wäre ein großer Vorteil, und ich bin überzeugt, dass es ganz viele weitere Wissenschaften gibt, die davon profitieren. Mithilfe von künstlicher Intelligenz können Sie in vielen Bereichen einfach sehr viel effektiver forschen. Wenn man es im Gesundheitssystem macht, muss geklärt werden, wie es mit der Datensicherheit aussieht, wem die Daten gehören und vieles mehr. Das hat natürlich viele soziale Folgen, weshalb Sicherheiten, auf die man sich verlassen kann, wirklich wichtig sind.

t3n: Was halten Sie von Juli Zehs Perspektive, die uns auf eine Gesundheitsdiktatur zusteuern sieht?

Das sehe ich nicht so. Dieses Misstrauen, dass Juli Zeh diesbezüglich in den Staat hat, kann ich nicht nachvollziehen. Also bei mir ist nach wie vor das Misstrauen in Konzerne des Silicon Valley, die mit meinen Gesundheitsdaten Missbrauch betreiben, viel größer als die Vorstellung, dass der Staat sich in eine Health-and-Order-Diktatur verwandelt.

t3n: Glauben Sie denn, KI kann bei der Bekämpfung des Klimawandels behilflich sein?

Natürlich. Wir haben ja bereits über statistische Korrelationssysteme gesprochen, die eine immense Datenverarbeitung möglich machen und so Prozesse optimieren und effizienter machen können. Das lässt sich dann für alles erdenkliche einsetzen, natürlich auch für die Forschung in diese Richtung. Nur ist das im Augenblick nicht das große Hauptanwendungsgebiet dieser Technologie, weil sich die Verantwortlichen im Augenblick keine Fantastilliarden davon versprechen.

t3n: Gleichzeitig verbrauch KI und alle weiteren Informationstechnologien sehr viel Energie – mit zunehmender Tendenz.

Dieser enorme Verbrauch an Strom, der immer noch zum größten Teil von fossilen Energieträgern kommt, taucht in der ganzen KI-Debatte nicht auf. Der unglaubliche Verbrauch an Naturressourcen wie zum Beispiel Kobalt und Lithium und all die Ökosünden, die damit einhergehen: Diese Kosten tauchen in der Rechnung nicht auf. Insofern finde ich, dass vieles, was hier zukunftsgerichteter Diskurs sein soll, eigentlich Old School ist. Das stammt so noch aus der technisch unbedarften Zeit, als man sich über ökologische Fragen viel zu wenig Gedanken gemacht hat. Das müssen wir dringend anpassen.

t3n: Kann denn in Krisenzeiten nicht ein Wille zur Veränderung entstehen, der in einem Normalbetrieb einer Gesellschaft einfach nicht möglich ist?

Theoretisch ja. Aber bisher beobachte ich eher einen fehlenden Willen dazu. Ich sehe jetzt in der Situation nach der Coronakrise den Versuch, die alte Realität wiederherzustellen – mit allem, was sie vorher auszeichnete inklusive der Dinge, die vorher falsch und schädlich waren. Und wenn man das einmal komplett repariert hat, dann ist auch das Fenster für große Veränderungen wieder geschlossen.

t3n: Haben Sie ein Beispiel dafür?

Wenn der Staat bei der Lufthansa einsteigt, hätte er ja auch durchsetzen können, Mitspracherecht zu haben. Und er hätte die Forderung stellen können, die für die Lufthansa nicht gewinnbringenden Kurzstrecken einzustellen. Ich höre nichts dergleichen. Es ist auch klar, woran es liegt: weil es dann heißt, dass Arbeitsplätze gefährdet seien und mit dem Hinweis auf Arbeitsplätze ist jede ökologische Transformation sofort zu bedrohen oder im Ansatz zu ersticken.

t3n: Glauben Sie denn, dass wir die ökologische Transformation hinbekommen?

Ach, ich weigere mich, zu glauben. Mein Verstand neigt dazu, auf das Negative zu setzen. Aber mein Gefühl lässt sich von meinem Verstand nicht beeindrucken und glaubt weiterhin, dass man dafür kämpfen sollte, solange es möglich ist.

t3n: Das macht ja auch die menschliche Intelligenz aus: die Wechselwirkung mit den Gefühlen.

Ohne jeden Zweifel. Und die rein rationale Analyse der gegenwärtigen Weltlage wird zu keinem guten Ergebnis führen. Aber zum Glück haben wir die Emotionalität, die uns Hoffnung gibt, und wenn wir die Hoffnung gar nicht mehr haben, dann kommt auch nichts Gutes mehr dabei raus.

Tolles Interview – Danke!