Warum wir uns vor den Maschinen der Zukunft nicht fürchten müssen

Unsere Gesellschaft würde ohne Maschinen, Computer, Roboter und das Internet zusammenbrechen. Wollte schon vor Jahrzehnten keiner mehr auf Digitaluhren, Taschenrechner oder Computer verzichten, sind wir heutzutage ohne sie nahezu aufgeschmissen. Und die Entwicklung geht rasant weiter.

Wissenschaftler und Science-Fiction-Experten verkünden bereits: Die Menschheit nähere sich der technologischen Singularität – dem Punkt also, ab dem Maschinen dem Menschen überlegen sind, und zwar in den Bereichen Intelligenz, Kreativität und Leistungsfähigkeit.

Auch wenn Singularität im Wortsinn nur Einzigartigkeit bedeuted, wird der Begriff keinesfalls neutral verwendet. Die Angst vor der Dominanz der Maschinen gibt es seit der frühen Industrialisierung. Schon Ende der 1950er warnte der Mathematiker Stanislaw Ulam vor einer Veränderung der Menschheit durch die Technik. 1993 veröffentlichte der US-amerikanische Mathematiker und Computerexperte Vernon Vinge einen Essay, in dem er proklamierte: „Innerhalb von dreißig Jahren wird es die Technologie geben, übermenschliche Intelligenz zu kreieren. Kurz darauf wird die Menschheit am Ende sein.“

Vinge nennt vier Wege, in denen sich diese Singularität ausdrücken werde: intelligente Computer, die nach seinen Worten „wach“ sein werden, also über eine Art Bewusstsein verfügen; Netzwerke, in denen diese Computer miteinander agieren; Mensch-Maschine-Interfaces sowie biologisch erzeugte, übermenschliche Systeme.

Chance oder Bedrohung für die Menschheit?

Singularitäts-Vordenker Ray Kurzweil.

Mit jeder Maschine, die uns Arbeit abnimmt, wächst nicht nur unsere Freiheit, sondern auch unsere Abhängigkeit. Die Entwicklung folgt einer einfachen Logik: Arbeit wird, sobald es möglich ist, von Maschinen übernommen.

Als Henry Ford Anfang des 20. Jahrhunderts das Fließband in seinen Autofabriken einführte, waren es noch Menschen, die Millionen Autos konstruierten. Nach dem Zweiten Weltkrieg übernahmen das immer mehr Maschinen. Heute haben Roboter an vielen Stellen menschliche Arbeiter verdrängt.

Lutz Prechelt, Professor für Mathematik und Informatik an der Freien Universität Berlin, sieht den Anfang dieser Entwicklung sogar viel früher. „Als im 19. Jahrhundert mechanische Webstühle eingeführt wurden, gab es massenhaft Proteste gegen diese Technik, die Menschen arbeitslos machte.“ Ab den 1810er Jahren kam es immer wieder zu so genannten Maschinenstürmen, bei denen Arbeiter mechanische Produktionsketten zerstörten. „Tatsächlich wurden durch diese erste industrielle Automation viele Menschen arbeitslos“, erklärt Lutz Prechelt. „Mittelfristig gesehen war es jedoch eine sinnvolle Entwicklung.“ Die automatische Massenproduktion machte die Produkte günstiger.

Technologischer Fortschritt ist unaufhaltsam. Ein Versuch, ihn zu stoppen, ist zwecklos. Raymond Kurzweil, berühmtester Prophet der technologischen Singularität [1], sah das ähnlich. Schon in den 1990er Jahren skizzierte er sehr genau, welchen Einfluss der technologische Fortschritt in der Zukunft haben wird – immer auf der Grundlage der Machbarkeit.

Als Fundament seines Denkens zieht er das Mooresche Gesetz heran, wonach die Leistungsfähigkeit von Transistoren und Rechnern exponentiell wächst. So hat Kurzweil sogar ein Datum gesetzt, ab dem es möglich sein wird, das menschliche Hirn in einem Rechner zu simulieren: 2029 soll demnach der erste Computer genauso leistungsfähig sein wie ein menschliches Hirn – der Mensch hätte damit künstliche Intelligenz erschaffen.

Was ist Intelligenz?

Die geistige Leistung eines Menschens kann – genauso wie seine

Körperkraft – naturwissenschaftlich gemessen werden. Mediziner schätzen

die Größe der gesamten menschlichen DNA auf etwa 600 Megabyte – der

Bauplan, nach dem unser Organismus funktioniert, passt also auf eine

handelsübliche CD-ROM. Die Arbeit der Nervenzellen, wie der Synapsen im Hirn, lässt sich problemlos messen. Die Übertragung von Reizen funktioniert chemisch und zum Teil auch elektrisch. Scans können schon heute genau zeigen, in welcher Region des Hirns welche Emotion oder Aktivität verarbeitet wird. Der Mensch in seiner mechanischen Funktionsweise wird immer besser analysiert. Über die Definition von Intelligenz wird jedoch freilich gerungen. Für Rodney Brooks, Wissenschaftler am MIT, bräuchte ein Wesen beispielsweise einen Körper, um ein Selbst auszubilden. Ein Roboter könne durch den Umgang mit seiner Umgebung intelligent sein. Ein System mit CPU dagegen könne Intelligenz nur simulieren.

Auch Professorin Nicole Karafyllis, Technikphilosophin an der TU Braunschweig, ist skeptisch gegenüber der Möglichkeit, so Intelligenz zu messen. „Für mich bedeutet künstliche Intelligenz, dass programmierbare Maschinen nur ausgewählte Operationen des menschlichen Gehirns funktional ausführen können. Und andere eben nicht.“

Digitale Technik und die Funktionsweise eines Gehirns lassen sich nicht eins zu eins vergleichen. Ein auf Mikrochips basierendes und von Software gesteuertes System ist etwas komplett anderes als ein biologisches Nervensystem. Wie genau Synapsen funktionieren, hat die Hirnforschung noch nicht endgültig klären können.

Der Schwarm steuert das Internet

Aber für Menschen wie Google-Mitbegründer Larry Page ist das kein Hindernis: Seit mehr als fünf Jahren versucht der Suchmaschinenkonzern, mittels künstlicher Intelligenz seine Algorithmen zu verbessern. Ein einfacher Vergleich zwischen der Leistungsfähigkeit von Googles Suchmaschine heute und vor fünf Jahren allein zeigt schon, wie schnell sich Programme wirklich verbessern können. Die Kraft der Schwarmintelligenz übertrifft jedes Individuum. „Googles Algorithmus basiert zwar lediglich auf der schieren Statistik von Milliarden Suchanfragen, doch kein Mensch hat Zugang zu so einer Menge von Daten und wie sie genutzt werden“, so Lutz Prechelts Einschätzung.

Maschinen und Menschen zwischen Freundschaft und Feindschaft.

Folgt man dem Gedankenspiel, dass Google irgendwann das gesamte Menschheitswissen mit künstlicher Intelligenz paaren könnte, ergeben sich quasi unendliche Möglichkeiten. Denn irgendwann soll diese Intelligenz der Anpassung weitergehen und selbstständig kreativ sein. Ray Kurzweil hat dazu mit anderen Wissenschaftlern schon die Singularity University [2] im Silicon Valley gegründet. An der Fakultät wird seit 2008 versucht, die exponentiell wachsenden Möglichkeiten der Technik auszuschöpfen und mit künstlicher Intelligenz zu erweitern.

Ein wichtiger Aspekt ist dabei die selbstständige Verbesserung der Leistung. Ähnlich wie bei Compilern wird daran gearbeitet, dass die Programme ihren eigenen Code stetig ausbessern und erweitern. Seed Artificial Intelligence nennt sich so etwas: Ein Samen an Intelligenz wird „gepflanzt“ – ein neuer, selbstständiger Organismus entsteht.

Auch in Deutschland gibt es an vielen Universitäten Forschungsprojekte zu künstlicher Intelligenz. Mit dem Deutschen Forschungszentrum für Künstliche Intelligenz (DFKI) wurde sogar bereits 1988 eine Forschungseinrichtung gegründet, in der die Bundesländer Rheinland-Pfalz und das Saarland zusammen mit dem Bundesbildungsministerium sowie Privatunternehmen an Projekten zu Wissensmanagement, Robotik oder auch intelligenten Benutzerschnittstellen forschen. 2010 hatte das Institut rund 36 Millionen Euro für die Forschung zur Verfügung, wobei das DFKI immer den Auftrag hat, seine Forschungsergebnisse in kommerzielle Anwendungen umzusetzen.

Das Internet, das Spinnennetzwerk

Am 21. April 2011 brach die Cloud von Amazon für mehrere Stunden zusammen. Für die Branche der Cloud-Anbieter war es eine Katastrophe. Und für Amazons Kundenservice hatte der Ausfall noch ein skurriles Nachspiel: Bei der „Terminator“-Serie „The Sarah Connor Chronicles“ beginnen am 21. April 2011 die Maschinen ihren Kampf gegen die Menschheit. Amazon musste zahlreichen Nutzern erklären, dass der Ausfall nichts damit zu tun hatte. Am Schluss mussten sie sogar in einer offiziellen Pressemitteilung erklären, dass es keine Verbindung zwischen ihrem Cloud-Zusammenbruch und den fiktiven „Terminator“-Maschinen gebe.

Auch wenn in diesem Fall die Realität lediglich von der Popkultur eingeholt wurde: Die Skepsis gegenüber der Macht des Internets und auch die Angst, die durch die Möglichkeiten von Millionen miteinander verbundenen Computern weltweit entsteht, sind manchmal mehr als bloße Verschwörungsgeschichten.

Schon jetzt funktionieren Strom- und Wassernetze, Finanztransaktionen und Informationsübertragungen teilweise nur noch über das Netz. Und mit der weiteren Verbreitung von Smartphones und anderen mobilen Internetgeräten wird die Einflechtung des Netzes in immer mehr Bereiche der Gesellschaft unaufhaltsam vorangehen. „An vielen Stellen werden wir technologischen Fortschritt nicht mehr merken“, sagt Lutz Prechelt. In kleinen Schritten, von Tag zu Tag wird sich die Technik immer weiter in unserem Alltag festsetzen.

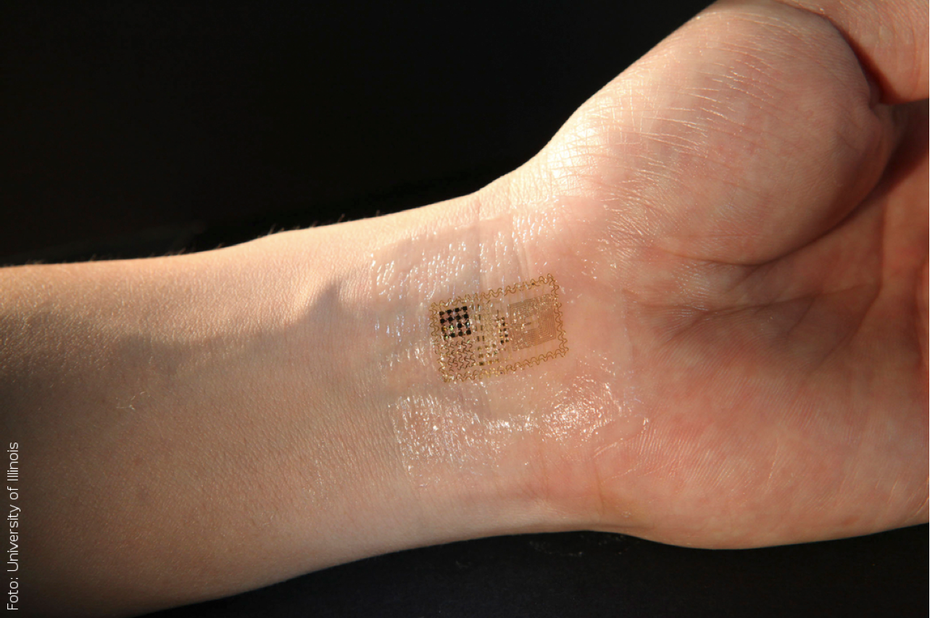

Halb Klebe-Tattoo, halb Elektronik: Sensoren wie das „Epidermal Electronic System“ können medizinische Daten wie Blutzucker oder Blutdruck ermitteln.

Das Internet kann inzwischen mit einem spinnenartigen Wesen verglichen werden, dass immer mehr Menschen mit dem Rest der Welt verbindet. Ola Ahlvarsson, schwedischer Internet-Pionier, fasst das so zusammen: „Alles wird miteinander verbunden sein.“ Rob Faludi, Professor an der School of Visual Arts in Manhattan und Dozent an der New York University, sieht den nächsten Schritt in einer Weiterentwicklung der Programme und Apps zu mehr Eigenständigkeit: „Anstatt nur dumme Tools zu benutzen, geben wir ihnen (den Maschinen, Red.) Aufgaben, die sie unabhängig ausführen. Einfach, weil sie die Welt um sich herum verstehen.“ Doch Faludi sieht nicht nur die positiven Eigenschaften der Vernetzung: In der Dokumentation „On the Brink“ [3] erinnert er an mögliche negative Auswirkungen: „Natürlich wissen wir nicht, was am Ende dabei herauskommt.“

Was möglich ist, wird kommen

Auch Lutz Prechelt sieht diese beiden Seiten der Entwicklung: „Natürlich sollten wir den Fortschritt nicht verteufeln.“ Vielmehr braucht es eine lebendige, ergebnisoffene Diskussion über Chancen und auch Risiken von neuer Technik. Professorin Nicole Karafyllis sieht das ähnlich: „Technikfolgenabschätzung und Technikbewertung sind notwendige Instrumente in einer technologischen Gesellschaft – schließlich sollen die Bürger ja über die Gestaltung ihrer Zukünfte mit entscheiden können.“

Noch ist das Internet nicht außer Kontrolle geraten. Seit einigen Jahren gibt es sogar die Tendenz, das kreative Chaos in wirtschaftlich profitablere Wege zu leiten. Das Netz wird einerseits durch die besseren Computer und Programme immer kreativer, aber auch durch den Menschen selbst, der das Netz und die globale Interaktion immer besser nutzen kann. Das Internet hat dadurch schon längst ein Eigenleben bekommen. Noch braucht es Menschen, die die Informationen an einer Stelle eingeben, damit sie nutzergerecht abrufbar sind. Doch die Entwicklung der Verkehrsleitsysteme, Fahndungsprogramme der Polizei und Geheimdienste sowie Smart-Grids zeigt schon jetzt, dass Maschinen schneller und oftmals klüger entscheiden können. Der Mensch lässt sich vom Netz überwachen – freiwillig.

Die Mensch-Maschine

Neben den Möglichkeiten, um uns herum künstliche Intelligenz zu erschaffen, gibt es ein riesiges Potenzial, diese mit uns auf biologische Weise zu verbinden. Laut Duden ist ein Cyborg ein Mensch, in dessen Körper technische Geräte als Ersatz oder zur Unterstützung nicht ausreichend leistungsfähiger Organe integriert sind. Ein Mensch mit einem Herzschrittmacher also. Oder einem Cochlear-Hörimplantat. Technische Hilfsmittel einzusetzen, um die Arbeit von Organen zu ergänzen oder ganz zu übernehmen, ist inzwischen Routine. Sensoren übermitteln Patientendaten an Krankenhäuser; Herzaktivitäten werden von Ärzten gescreent, die Hunderte Kilometer entfernt sitzen. Blut- oder Leberwerte werden sekundengenau analysiert.

Die Medizin ist ein Bereich, in dem der technologische Fortschritt nicht nur deutlich hervortritt. Sie ist auch ein Bereich, in dem dieser am dankbarsten aufgenommen wird. Kein rationaler Mensch ist gegen eine Therapie, die Leben rettet, Schmerzen lindert oder den Alltag erleichtert. „Niemand kann die künstlichen medizinischen Hilfsmittel aufhalten, die Nachfrage ist jetzt schon so groß“, so Lutz Prechelts. Dabei unterscheidet er klar zwischen der Technologie, die etwas ersetzt, wie künstliche Gliedmaßen. Und der Technik, die die Leistungsfähigkeit der Menschen verbessert. „Was, wenn sich nicht jeder diese Verbesserung leisten kann?“. Eine Mehrklassengesellschaft, die jetzt schon in der Gesundheitsvorsorge auftritt, könnte sich noch verschärfen, wenn es möglich wäre, mittels medizinischer Technik Supermenschen zu schaffen? Und was ist, wenn sich die künstlichen Helferlein ohne Kontrolle von selbst weiterentwickeln?

Risiko Schnittstelle

Wie bei allen Entwicklungen im Bereich der Technik ist es auch hier eine Frage der Zeit, bis die ersten Wissenschaftler versuchen werden, das menschliche Nervensystem nicht nur mit kleinen Mikrochips zu verbinden, sondern eine besondere Form der Augmented Reality zu schaffen und das Bewusstsein mit einer Art Internet zu verbinden. „Je passgenauer die Mensch-Maschine-Schnittstelle ist, desto riskanter ist die Technik – weil das Einhalten der Grenze, die ja im Wort ‚Schnittstelle’ enthalten ist, immer weniger gut zu kontrollieren sein wird“, sagt Nicole Karafyllis. Nanopartikel könnten sich von Interfaces lösen und die Blut-Hirn-Schranke passieren, ohne dass man wüsste, was dann genau im Hirn passiere.

Es entstünden – gewollt oder ungewollt – Mensch-Maschinen. Aber: „Ein Verbot würde in dem medizinischen Kontext nicht funktionieren“, sagt Lutz Prechelt. Etwas, dass in einem Land verboten sei, würde in einem andern Land dann erlaubt. „Und wenn es dem Menschen große Vorteile bietet, wird das Verbot überall anders auf Dauer nicht zu halten sein.“

Fazit

Technologische Singularität ist eine Theorie. Ob es sie geben wird und, wenn ja, in welcher Form, lässt sich nicht vorhersehen. Fakt ist: Die technologische Entwicklung hat dem Menschen bis jetzt weitaus mehr genutzt als geschadet. Wir konnten dadurch länger und komfortabler leben, mehr Menschen ernähren, und der weltweite Austausch fördert nicht nur Wirtschaft und Wissenschaft, sondern auch Empathie gegenüber Menschen, die wir nur aus dem Netz kennen. Die Angst gegenüber Maschinen ist an mancher Stelle sicherlich begründet. Doch hat sich in der langen Geschichte der Menschheit gezeigt, dass sich über kurz oder lang ein vernünftiges Verhalten gegenüber Technik einstellt. „Technik per se ist nicht böse“, sagt Lutz Prechelt. Es kommt eher darauf an, wie die Menschen sie benutzen. Keiner möchte heutzutage auf Fernsehen oder Autos verzichten, doch trotzdem können manche Menschen mit diesen Geräten nicht umgehen, sie schaden ihnen mehr. Auch Nicole Karafyllis betont, wie wichtig es für jeden Einzelnen ist, den Nutzen einer bestimmten Technologie zu sehen.

So ist es auch mit Computern und einer möglichen künstlichen Intelligenz. Niemand weiß, ob sie die Menschheit bedroht oder sogar als neutrale Instanz das Leben verbessert, friedlicher macht, wenn sie nicht aktiv gegen einen Teil der Menschheit eingesetzt wird. Dafür zu sorgen, dass das nicht passiert, ist die Aufgabe eines jeden Entwicklers und Nutzers.