Der TrustRank setzt auf Vertrauen. Und löst den PageRank damit ab

Keine Frage: Als die Google-Gründer Sergey Brin und Larry Page (daher auch die Bezeichnung) 1997 den PageRank entwickelten und ihn als Grundlage für ihre Suchmaschine Google einsetzten, revolutionierten sie damit die Branche. Dadurch, dass Verlinkungen als Empfehlungen in das Ranking der Suchtreffer eingingen, wurde die Qualität der Ergebnisse deutlich gesteigert und die Grundlage für eine beeindruckende Dominanz von Google im westlichen Suchmaschinenmarkt gelegt. Doch sind seitdem über zehn Jahre vergangen und man kann davon ausgehen, dass sowohl das Prinzip des PageRanks weiterentwickelt wurde als auch neue Selektionskriterien hinzugekommen sind.

PageRank 2.0

Der TrustRank ist sicherlich eine der bekanntesten Weiterentwicklungen des PageRank-Verfahrens. Sowohl Google [1] als auch Yahoo [2] und zahlreiche Forschungsgruppen [3] haben ihre Erfahrungen hierzu bereits veröffentlicht.

Grundsätzlich arbeitet der TrustRank ähnlich wie der PageRank: Links werden als Empfehlung für die verlinkte Seite gewertet. Im Gegensatz zum herkömmlichen Algorithmus wird beim TrustRank allerdings noch eine Liste mit vertrauenswürdigen Adressen geführt. Die ermittelte Entfernung der gefundenen Seite zu diesen vertrauenswürdigen Adressen ergibt nun einen Indikator für das Vertrauen, das Google in die Seite setzt. Durch dieses Verfahren konnte Google zwar den Spam in seinen Trefferlisten deutlich reduzieren; welche Adressen auf den Vertrauenslisten stehen, ist allerdings nicht bekannt. Wahrscheinlich ist, dass zahlreiche Universitäten, Open-Source-Projekte und öffentliche Institutionen dort aufgelistet sind.

Es ist davon auszugehen, dass Google bereits seit längerer Zeit auf ein dem TrustRank ähnliches Verfahren als Selektionskriterium zurückgreift. Zu auffällig ist, dass alte und vertrauenswürdige Seiten die Google-Richtlinien häufig zu ihren Gunsten auslegen dürfen, während neuere Domains für den gleichen „Tatbestand“ regelmäßig mit einer Ranking-Penalty belegt werden.

Links im Kontext

Während der PageRank eine komplette Seite als Einheit betrachtet und allen ausgehenden Links – unabhängig von ihrer Position und Einbindung – den gleichen Wert beimisst, geht der so genannte Block-Level-PageRank hier differenzierter vor: Die Seite wird in einzelne Elemente aufgeteilt und der PageRank-Wert für jedes Element berechnet. So können eher unwichtige Teile wie die Fußzeile oder Werbeeinblendungen von den wichtigen Inhaltsbereichen unterschieden werden und die Qualität der Berechnung steigt. Sowohl Google [4] als auch Microsoft (Bing) [5] haben Untersuchungen in diese Richtung veröffentlicht. Ein weiteres Indiz spricht dafür, dass Google bei der Bewertung von Links auf dieses Verfahren setzt: Erst kürzlich haben einige Google-Nutzer neben dem Treffer einen Screenshot der Seite in den Ergebnislisten gesehen – den Aufwand, wirklich jede Seite zu rendern, wird Google nicht allein für diesen Zweck getrieben haben.

Rasendes Ranking

In Googles Anfangszeiten gab es ein monatliches Update, den so genannten „Google Dance“. Bis zum nächsten Update blieb dadurch ausreichend Zeit für den rechenintensiven Prozess der PageRank-Ermittlung. Mittlerweile werden neue Seiten viel schneller indexiert – mit dem Infrastruktur-Update „Google Caffeine“ häufig bereits wenige Minuten nach Publizierung. Für das ursprüngliche PageRank-Modell ergeben sich damit zwei Probleme: Zum einen kann der PageRank einer Seite in dieser kurzen Zeit eher geschätzt als seriös berechnet werden. Die Werte werden also ungenauer und damit sinkt die Qualität der Suchergebnisse. Zum anderen haben neue Seiten nur selten ausreichend eingehende Links von anderen Domains, die Grundlage der Berechnung fehlt folglich in den ersten Tagen und Wochen. Damit ist der PageRank für den immer wichtiger werdenden Teil der sehr frischen Suchergebnisse ungeeignet und Google muss alternative Metriken zur Sortierung der Suchtreffer heranziehen.

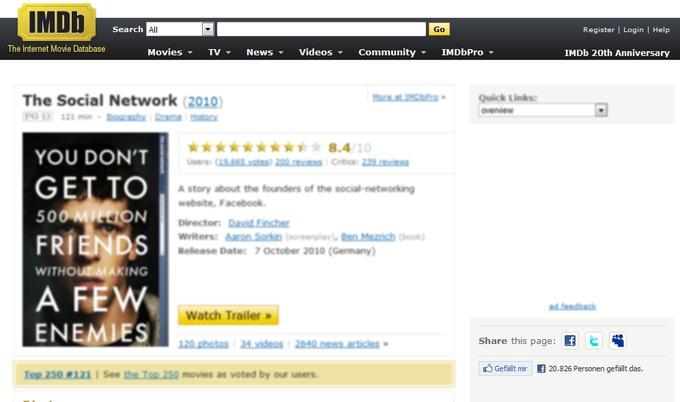

Facebook wird beim Thema Suche immer relevanter: Durch den allgegenwärtigen Like-Button (bei IMDb rechts unten) kann Facebook nicht nur eine Art Kundenrezension in Suchergebnisse einführen. Das Unternehmen ist so auch in der Lage, Empfehlungen von Freunden stärker zu gewichten, um personalisiertere Suchergebnisse auszugeben.

Google kann auf eine große Anzahl von Datenquellen für Nutzerverhalten zurückgreifen: Sämtliche Klicks in den Suchergebnissen werden gespeichert, AdSense-Einbindungen und die Übernahme des Werbevermarkters Doubleclick tragen ebenso dazu bei wie Google Analytics und der hauseigene Browser Chrome. Auf dieser Basis kann für jede beliebige URL ermittelt werden, ob der Besucher dort findet, was er gesucht hat oder ob er mit dem nächsten Suchtreffer besser bedient war. Dass Google diese Daten in das Ranking einfließen lässt, ist mittlerweile ein offenes Geheimnis, jedoch erhalten dadurch erstmals auch Themen wie die Usability einer Webseite zumindest indirekt Einfluss auf den Erfolg in den Suchergebnislisten.

Facebook geht noch einen Schritt weiter und überlässt das Bewerten von Seiten beinahe gänzlich den Benutzern: mit dem Open-Graph-Protokoll sowie dem allgegenwärtigen Like-Button. Dadurch, dass nicht nur Webseitenbetreiber durch einen Link ihre Empfehlung aussprechen können, vergrößert sich die Basis für Berechnung enorm. Auch eine weitgehende Personalisierung der Werte ist möglich, wenn für Suchergebnisse hauptsächlich Stimmen der eigenen Freunde und Bekannten gewertet werden.

Ausblick

Das Ranking von Google hat seit der Gründung vor 13 Jahren stark auf der Bewertung von Links aufgebaut und das wird sich in den nächsten Jahren auch nicht ändern. Allerdings wurde der PageRank in den vergangenen Jahren intern stark weiterentwickelt und hat keinen direkten Bezug mehr zu jenem PageRank, den Google öffentlich über die Google Toolbar ausliefert. Für die Zukunft müssen wir uns darauf einstellen, dass Metriken wie das Nutzerverhalten oder der Social Graph an Bedeutung gewinnen – und das leider, ohne dass Google uns einen Wert zwischen 0 und 10 zur Bewertung liefert.

Johannes Beus (Geschäftsführer SISTRIX GmbH) beschäftigt sich seit über neun Jahren mit der Optimierung von Webseiten für Suchmaschinen. In einem der ältesten deutschsprachigen SEO-Blogs veröffentlicht er seit 2003 regelmäßig Zusammenfassungen eigener Auswertungen und Einschätzungen des SEO-Markts. Mit der SISTRIX Toolbox bietet er die Möglichkeit, eine professionelle SEO-Software zu überschaubaren Kosten zu nutzen. Als Partner von TRG The Reach Group unterstützt er zahlreiche bekannte Marken in einer nachhaltigen SEO-Strategie.

Johannes Beus (Geschäftsführer SISTRIX GmbH) beschäftigt sich seit über neun Jahren mit der Optimierung von Webseiten für Suchmaschinen. In einem der ältesten deutschsprachigen SEO-Blogs veröffentlicht er seit 2003 regelmäßig Zusammenfassungen eigener Auswertungen und Einschätzungen des SEO-Markts. Mit der SISTRIX Toolbox bietet er die Möglichkeit, eine professionelle SEO-Software zu überschaubaren Kosten zu nutzen. Als Partner von TRG The Reach Group unterstützt er zahlreiche bekannte Marken in einer nachhaltigen SEO-Strategie.