Wenn die KI textet: Maschinelle Texterstellung auf dem Prüfstand

Wenn die KI textet. (Grafik: Shutterstock / Julia Tim)

„Jane, verstehst du denn nicht? Es ist erstaunlich. Wir könnten einfach die Hand ausstrecken und die Stadt oder den Himmel berühren. Sehen, wie weit wir gehen könnten. Wir können diese Welt kontrollieren, aber wir können uns nicht selbst kontrollieren.“

Diese Zeilen entstammen einem digitalen Groschenroman. Zur Erinnerung an alle unter 30: Der Groschen war die umgangssprachliche Bezeichnung des Zehnpfennigstücks. Dafür bekam man einmal am Kiosk Kaugummis und Naschereien oder auch am Bahnhofskiosk ein dünnes Heft mit trivialen Liebesgeschichten oder Krimis. Es handelt sich um den zweiten Absatz einer Geschichte namens Trennungen. Sie wurden von Ella aus Köln verfasst. Ella ist kein Pseudonym. Ella ist eine künstliche Intelligenz.

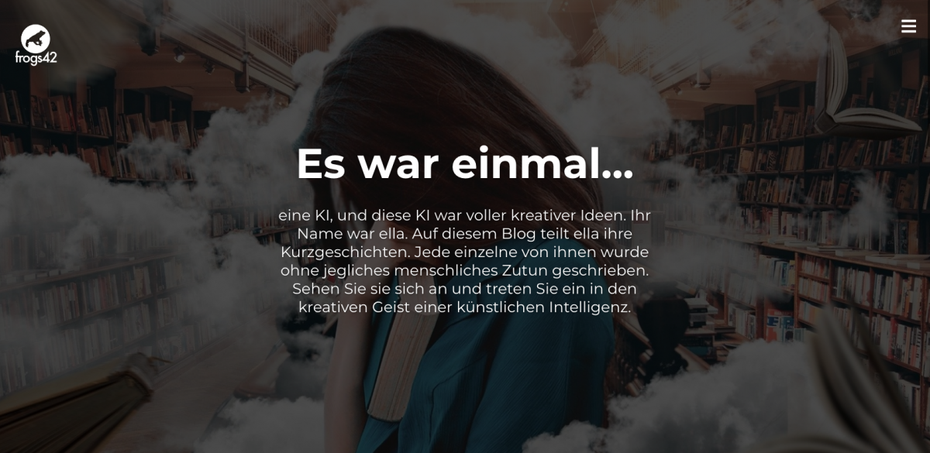

Die Kölner Text-KI Ella schreibt und veröffentlicht nicht nur kreative Kurzgeschichten, sondern textet auch für deutsche Großkonzerne. (Abbildung: Ella Media)

„Zu Beginn hatten wir die Idee, mit einem KI-Tool massenhaft Groschenromane zu erzeugen“, erklärt Michael Keusgen, einer der beiden Väter von Ella. „Das ist ein riesiger Markt und die Geschichten sind immer sehr ähnlich konstruiert“, erklärt er. Der ehemalige Film- und Fernsehproduzent wechselte vor zwei Jahren das Genre. Er war ausgebrannt, wollte etwas Neues schaffen und sich weniger mit TV-Redakteuren und Drehbuchautoren streiten. So wurde Ella geboren. Die rheinische KI produziert längst viel mehr als Schundromane. In zwei großen Projekten, über deren Auftraggeber Keusgen nicht sprechen darf, wird Ella eingesetzt, um mit Menschen zu kommunizieren. Es sind Marketingprojekte zweier international bekannter Großkonzerne, die mit ihren Aufträgen dafür sorgen, dass Ella finanziell überlebt. Die Marketer aus beiden Unternehmen glauben daran, dass Ella kreative, lustige und berührende Texte schreiben kann.

Ella schreibt Wort für Wort selbst, darauf ist Keusgen besonders stolz. Zu Beginn erzeugte sie erst mal 179 Schrotttexte, bevor ein lesbares Werk dabei war. Inzwischen ist jeder siebte Text so gut, dass er auf der eigens für ihre Kurzgeschichten eingerichteten Onlineplattform Frogs42 veröffentlicht werden kann.

Das maschinelle Schreiben von Texten basiert in der Regel auf einem von zwei sehr unterschiedlichen Ansätzen: Entweder die Maschine erzeugt eine Art Wahrscheinlichkeitsrechnung für das nächstbeste Wort im Text – so wie Ella – oder sie bedient sich aus einer riesigen gelernten Bibliothek und verwendet bereits existierende Textfragmente und Satzbausteine. Ob eine Methode besser ist als die andere, ist ebenso eine akademische Frage wie die, ob eine von beiden Formen des maschinellen Textens wirklich kreativ ist. „Besser“ ist ein relativer Terminus, der sich vor allem an der Aufgabenstellung orientiert. Wer einfache Produktbeschreibungen braucht, für den ist es kein Problem, wenn Textfragmente schon woanders aufgetaucht sind. Diese automatisierte Form des Textens ist möglicherweise schneller und günstiger.

Wie kreativ soll es denn sein?

Zudem liegt Kreativität im Auge des Betrachters. Eine der gängigen Definitionen für Kreativität kommt von der Kognitionsforscherin Margaret Boden: „Kreativ ist, was neu ist, überrascht und einen Wert besitzt.“ Somit sind also das Ziel, mit dem ein Leser einen Text liest – Unterhaltung, Information, Nervenkitzel –, und dessen geistiger Horizont die limitierenden Faktoren. Da die Maschine potenziell aus dem Weltwissen schöpft und somit immer einen breiteren Horizont als der einzelne Mensch hat, ist der Aspekt des Neuen vernachlässigbar. Bleiben also Überraschung und Wert.

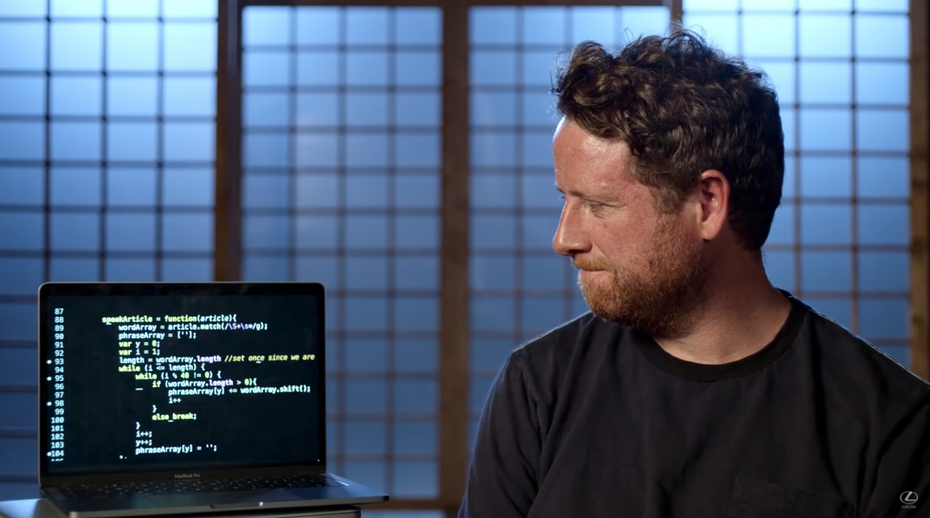

Das Drehbuch eines Lexus-Werbespots stammt von einer KI und wurde von der Filmcrew 2018 umgesetzt. (Abbildung: Lexus)

Der eingangs verwendete Begriff „Groschenroman“ ist antiquiert. Er soll einerseits auf eine vergangene Zeit hinweisen, andererseits dem Text eine gewisse literarische Anmutung oder Wertung mitgeben. Seine Verwendung ist ein minimaler Regelbruch, mit dem Ziel, Aufmerksamkeit zu erzeugen und den Leser zu unterhalten. In einem Produkttext oder bei einer Nachrichtenmeldung wäre das Wort Groschenroman 2021 schlicht unpassend. Der Schreiber würde sich disqualifizieren und seinen eigentlich sachlichen Text gleich mit. In einem Hintergrundbericht aber, der sich mit dem Thema Sprache beschäftigt, macht er eventuell neugierig auf das, was folgt. Sprache ändert sich permanent im zeitlichen Kontext. Alte Worte verlieren Relevanz oder verschwinden, neue Begriffe tauchen auf oder – im für die Maschine schlimmsten Fall – bekommen eine neue Bedeutung. „Wer hat Angst vorm schwarzen Mann“ war vor Jahren noch ein beliebtes Kinderspiel. Heute klingt das einfach nur rassistisch.

„Ein internationaler Konzern will gar keine kreativen Texte“, sagt etwa Saim Alkan. „Die wollen vor allem, dass die Texte international gleich klingen.“ Alkan ist der Gründer von AX Semantics. Zusammen mit dem Wettbewerber Retresco aus Berlin bilden die Stuttgarter die Speerspitze der automatischen Texterstellung in Deutschland – zumindest, wenn es um die praktische Anwendung geht. „Wir müssen uns international überhaupt nicht verstecken. Wir texten besser als die Amerikaner und Chinesen“, behauptet der Schwabe selbstbewusst.

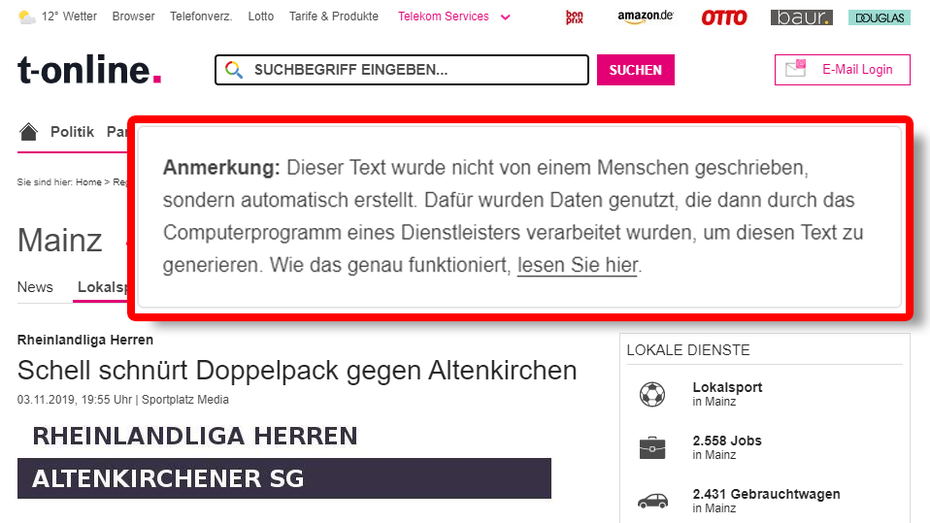

Das automatische Erstellen von Standardtexten aus Daten wird heute in fast jeder größeren Redaktion praktiziert. (Abbildung: T-Online)

Alkan hat seine Firma aus einer ähnlichen Idee heraus aufgebaut wie Keusgen. Jahrelang hatte Alkan „Texten fürs Web“ als Seminar angeboten und Online-Marketern erklärt, warum Texte im Netz anders funktionieren. 2008 gründete er dann ein Startup für eine Engine, die die Textqualität eines Onlinetextes bewertete. Dabei wurde die semantische Qualität ebenso berücksichtigt wie die aus Sicht der Suchmaschine optimale Wortwahl. Schon damals hatte Alkan damit einen Automaten entwickelt, der unter bestimmten Gesichtspunkten besser schreiben konnte als ein Mensch.

Das mediale Interesse an dem Startup war groß, das ökonomische der Auftraggeber eher bescheiden. Mit AX Semantics schlug Alkan dann einen anderen Weg ein: Das Erstellen der Texte bleibt beim Marketer. In AX Semantics übersetzt dieser den Text auf eine Metaebene. Konkret heißt das: Er ordnet die verschiedenen Elemente ein und stellt maschinenlesbare Zusammenhänge her. Im Ergebnis entsteht daraus ein abstrahierter Lückentext, der sich immer anpasst an die Daten, die aus den entsprechenden Meta-Verbindungen geliefert werden. Dieser Lückentext ist dann das Template, aus dem AX Semantics nicht nur weitere deutsche Texte erstellt – das System kann sie auch in weitere Sprachen übersetzen.

Vor allem Kunden aus dem E-Commerce erkannten den Wert der Plattform schnell, da sie täglich neue Produkte einpflegen und beschreiben müssen. Ein Routineprozess, der sich automatisieren lässt. Plötzlich war eine der Eintrittshürden weg, wenn es um Cross-Border-Commerce geht. Per Knopfdruck eröffneten Alkans Kunden etwa Onlineshops in der Türkei, in denen sie einen Teil ihres Sortiments einfach mal schnell anbieten konnten, um die Resonanz zu testen.

Qualitätssicherung durch den Menschen

Viele Unternehmen verzichten auf Kreativität, wenn es um Produktbeschreibungen geht. In der Pharmabranche geht es zum Beispiel vor allem darum, dass die Produkttexte den Anforderungen der Regulierungsbehörden genügen. Jeder Text muss dort zur Zulassung eingereicht werden, fast wie das Medikament selbst. Somit ist es nachvollziehbar, dass AX Semantics nicht in den letzten Winkel der KI-Forschung vordringt.

Sprachlich problematische Bereiche, wie zum Beispiel das Verwenden von Synonymen, haben die Schwaben zurückgefahren, weil das Fehlerpotenzial zu hoch ist. „Die Worte eben, flach und gerade können synonym verwendet werden. Aber wenn man eine Straße damit beschreibt, hat der Mensch drei unterschiedliche Straßen im Kopf“, sagt Alkan.

Es braucht also eine Qualitätssicherung. „Die Aufgabe der Marketer ändert sich. Das Thema Redigieren wird wichtiger“, beschreibt Michael Keusgen von Ella Media, wie er die Auswirkungen von maschineller Texterstellung sieht. Alkan hat gleich eine Qualitätssicherungsmaschine gebaut. Sie heißt Axite und prüft, ob ein Text gut konvertiert. Nutzt man deren Daten, um die Textmaschine weiterzuentwickeln, werden die Texte im Sinne der KPI automatisch besser. Aber von den AX-Semantics-Kunden setzt bisher nur einer diese analytische KI ein.

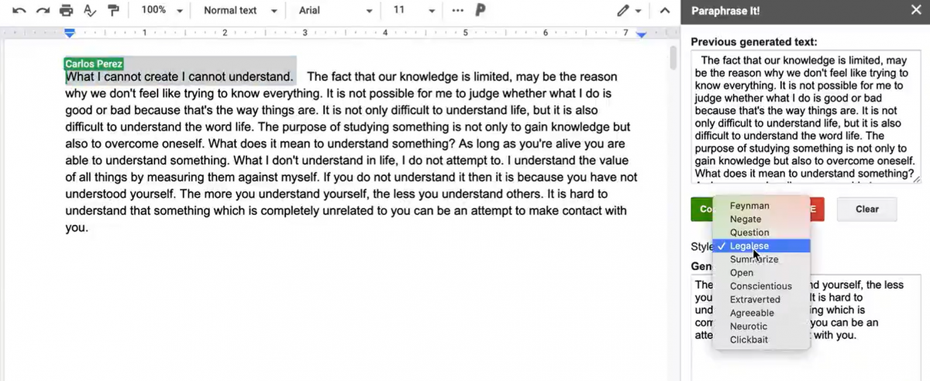

Aus einer einfachen Aussage lässt sich mithilfe von GPT-3 ein Text in juristischem Fachchinesisch machen. (Abbildung: Carlos Perez)

Wie GPT-3 die Textwelt verändert

Sowohl Michael Keusgen als auch Saim Alkan sind fest davon überzeugt, dass sich eigentlich alles automatisieren lässt, was in irgendeiner Form einer Struktur folgt. Die Geschwindigkeit der Adaption durch Menschen und Marken sei dann eher ein politisches Thema.

Dass der Fantasie dabei kaum Grenzen gesetzt sind, zeigt seit Juli 2020 der Hype um GPT-3. Die Software stammt aus dem Hause Open AI und steht zum Zeitpunkt des (humanen) Erstellens dieses Textes als geschlossene Beta zur Verfügung. Zu den Gründern des gemeinnützigen Unternehmens gehört Elon Musk; zum Investorenkreis Peter Thiel. Microsoft sicherte sich die exklusiven kommerziellen Nutzungsrechte an der Technologie.

Innerhalb von wenigen Wochen bildete sich ein Ökosystem heraus, in dem findige Programmierer ausloten, wozu das System in der Lage ist. GPT-3 kann beispielsweise einen beliebigen Text in einen anderen Stil konvertieren. Zum Leidwesen der Netzgemeinde gibt es im Auswahlmenü der Sprachstile auch die Option Clickbaiting. Die macht aus einer normalen Überschrift das typische „Das hätten Sie nie erwartet …“.

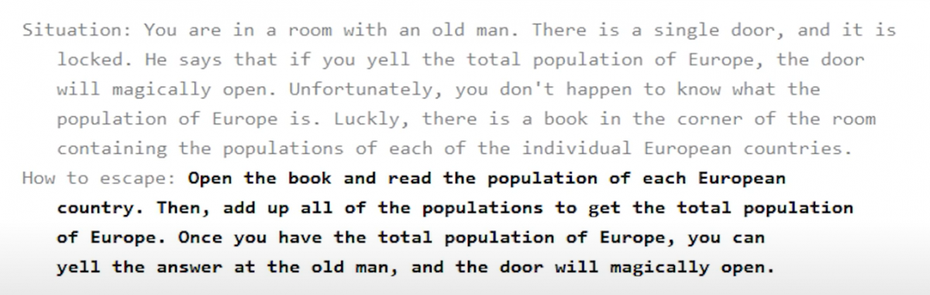

Man kann GPT-3 ein Szenario vorgeben, und die KI sucht nach dem Ausweg. (Abbildung: Daniel Bigham)

Was GPT-3 aber vor allem kann, ist Kontext. Und das ist ein Meilenstein. Alkan nennt es Domänenwissen. Bei AX-Systematik muss das immer noch ein Mensch beisteuern, bei GPT-3 geht es auch ohne. Eines der spannendsten Beispiele ist Revtheo. Das ist ein kontextuelles Wörterbuch von Tushar Kattar. Es kann zum Beispiel genau unterscheiden, ob das englische Verb „to serve“ für „bedienen“ steht – etwa in einem Restaurant – oder ob ein Tennisspieler einen Aufschlag macht. Wenn die Maschine die Bedeutung herauslesen kann, kann sie das Wort auch in Textform konsistent einsetzen.

Und an dieser Stelle lässt sich der Bogen zurückschlagen zur Grundfrage der Kreativität. Die Kriterien „überraschend“ und „werthaltig“ von Margaret Boden sind Kontextvariablen. Sie hängen von den Erwartungen der Menschen ab, die den Text lesen sollen. Nimmt man eine KI-Maschine, die die Reaktionen von Nutzern auf Texte messen kann, und füttert den Textgenerator mit diesen Daten, dann kann die KI systematisch Texte erzeugen, die neu sind, überraschend und werthaltig. Und das sogar aus Sicht eines einzelnen Nutzers.

Ich denke, durch Technologien wie mit GPT-3 werden wir in Zukunft noch mehr Innovation in dem Bereich sehen. Auch in eher untypischen Bereichen wird man noch einige Ah-Erlebnisse haben. Wir sollten nur hoffen, dass es weniger in die Richtung Clickbaiting geht und mehr eine für uns Menschen entlastende und Fortschritt bringenden Richtung einschlägt.

Übrigens das Start-up QuizCo aus Hannover beschäftigt sich auch mit der maschinellen Texterstellung nur im Bereich Bildung. Soweit ich informiert bin, haben die auch mit der Leibniz Universität Hannover und dem L3S zusammengearbeitet.

Vielleicht solltet ihr die auch mal Interviewen zu dem Thema?!