Diskriminierung durch Algorithmen – Studie weist Fälle nach und empfiehlt Gegenmaßnahmen

Unter anderem kritisiert das Technikfolgen-Büro die Diskriminierung durch Gesichtserkennungssysteme. (Bild: metamorworks/Shutterstock)

„Gesellschaftliche Ungleichbehandlungen können sich in komplexe algorithmische Entscheidungssysteme (AES) einschreiben und dadurch potenziell eine Vielzahl von Personen betreffen“, schreiben die Verfasser der Studie „Mögliche Diskriminierung durch AES und maschinelles Lernen“. Nach allgemeinen Erklärungen beweist das Büro für Technikfolgen-Abschätzung beim Deutschen Bundestag (TAB) an vier frappierenden Fallbeispielen seine These. Das TAB besteht unter Federführung des Karlsruher Instituts für Technologie aus Fachleuten verschiedener Institute dieses Bereichs.

Nachdem die Autoren algorithmische Systeme in selbstlernend oder regelbasiert unterteilt haben, bringen sie als übergeordnete Instanz AES ins Spiel. Sie vollziehen sowohl die Datenerfassung und Analyse, deuten die Ergebnisse und leiten daraus Entscheidungsempfehlungen ab. Sie seien nicht nur als Vorbereitung und Unterstützung, sondern auch als Ersatz menschlicher Entscheidungsprozesse im Einsatz. Die Studie nennt Beispiele für solche Systeme sowie Probleme.

Vom Algorithmus diskriminiert

Als erstes Beispiel dient ein AES im medizinischen Bereich. Das System berechnete eine niedrigere Sterberate für Patienten mit Mehrfacherkrankungen und chronische Krankheiten als von solchen, die nur unter einer Lungenentzündung litten. Im Ergebnis ordnete es den schwer Erkrankten einen geringeren Betreuungsbedarf zu. Der Fehler lag in den Daten, mit denen das System trainiert worden war: In denen hatten chronisch und mehrfach erkrankte bereits eine intensive Behandlung erhalten und wiesen daher eine niedrigere Sterblichkeit auf.

Aus dem österreichischen Arbeitsamt stammt der zweite Fall. Das System ordnet die Klienten in drei Kategorien von arbeitsmarktnah bis -fern ein. Dabei werden Frauen mit Betreuungspflichten als arbeitsmarktfern klassifiziert. Der Hintergrund: Alleine das Geschlecht führt zu einem Abzug der Arbeitsmarktnähe, die Betreuungspflicht zu einem weiteren. Ob hier Diskriminierung vorliege, müsse eine Gesamtbetrachtung der Prozesse ergeben, sagen die Verfasser.

Beispiel drei betrifft die Rückfallwahrscheinlichkeit von Straftätern in den USA. Das dafür eingesetzte System Compas lag bei der Vorhersage der Quote bei afroamerikanischen Straftätern falsch. 45 Prozent der Gruppe blieben gesetzestreu, während das nur auf 24 Prozent der weißen Kandidaten zutraf.

Einem strukturellen Fehler unterliegen viele AES in den USA, die Beispiel vier bilden. Ihre Gesichtserkennungssysteme identifizieren am häufigsten weibliche und dunkelhäutige Gesichter falsch. Sie kommen im Strafvollzug, bei der Strafverfolgung, der inneren Sicherheit und Prävention zum Einsatz. Sowohl falsch-negative als auch falsch-positive Ergebnisse können für den Einzelnen „unangenehme Folgen“ haben, steht in dem rund 80 Seiten starken Dokument. IBM hatte aus diesem Grund sein Gesichtserkennungsprogramm beendet.

Breite Handlungsoptionen vorgeschlagen

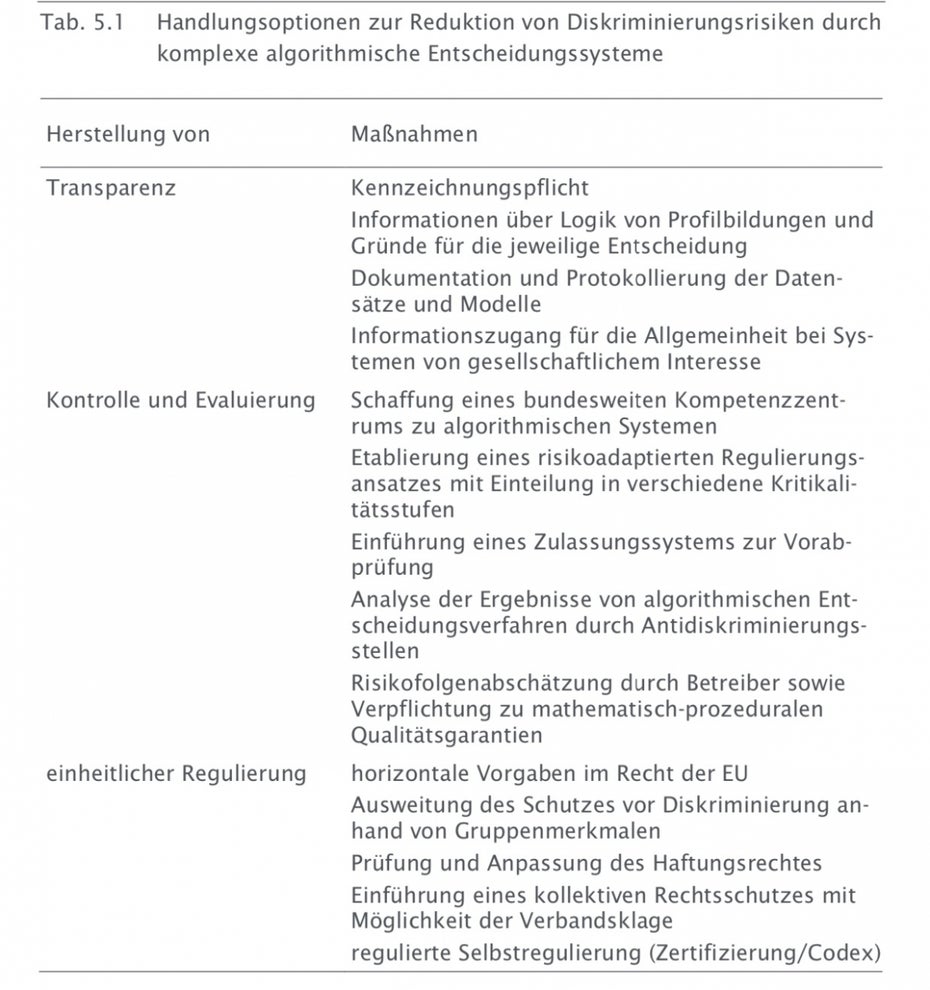

Die Studie hebt hervor: Die Diskriminierung beim österreichischen Arbeitsamt wäre nicht aufgefallen, wäre das System nicht transparent gewesen. Die Wissenschaftler plädieren daher für mehr Transparenz und Kontrolle, etwa durch eine unabhängige Stelle. Zudem könne eine Kennzeichnungspflicht helfen, Betroffenen den Einsatz von AES zu signalisieren. Sie solle jedoch nicht wie bei gebräuchlichen Datenschutzerklärungen zu Durchwink-Formularen ohne Wissenszuwachs führen. Die Studie schlägt vor, Datensätze und -modelle zu dokumentieren und zu protokollieren. Weitere Ideen bestehen im Etablieren eines Kompetenzzentrums, eines Zulassungssystems und Prüfungen durch Antikriminierungsstellen. Im Bereich der Regulierung solle man das Haftungsrecht anpassen, Gruppendiskriminierung aufnehmen und einen kollektiven Rechtsschutz etwa über Verbandsklagen installieren. Daneben könnte regulierte Selbstkontrolle zum Beispiel über Zertifikate helfen. Ähnlich hatte sich zuletzt die Datenethik-Kommission geäußert und hatte sich allerlei Kritik aus den Digital-Verbänden ausgesetzt.

Das Technikfolgen-Büro des Bundestages schlägt eine Vielzahl von Maßnahmen zur Eindämmung von Diskriminierung durch KI-Systeme vor. (Screenshot: TAB/t3n)

Die Gesellschaft soll entscheiden

Am Ende konstatieren das TAB eine Entwicklung hin zu einer algorithmisierten Gesellschaft. Sie bedinge eine Reflexion darüber, welche Werte über AES walten, welche Folgen sie haben und wie sie reguliert werden sollen. Gesellschaftliche Weichenstellungen seien schon im Entwicklungsstadium nötig. Das Papier fordert, sie der Meinungsbildung, demokratischen Prozessen und gesetzgebenden Ebenen zu übergeben.