Forschungsteam kreiert KI-Wurm, der sich durch KI-Tools bewegen und Daten stehlen kann

Generative KI-Systeme wie ChatGPT von OpenAI oder Googles Gemini werden immer häufiger eingesetzt, zahlreiche Startups und Technologieunternehmen bauen fest auf sie. Doch je mehr Freiheit den KI-Tools eingeräumt wird, desto größer werden auch die potenziellen Angriffsmöglichkeiten.

Mit dem KI-Wurm sei „eine neue Art von Cyberangriff“ möglich

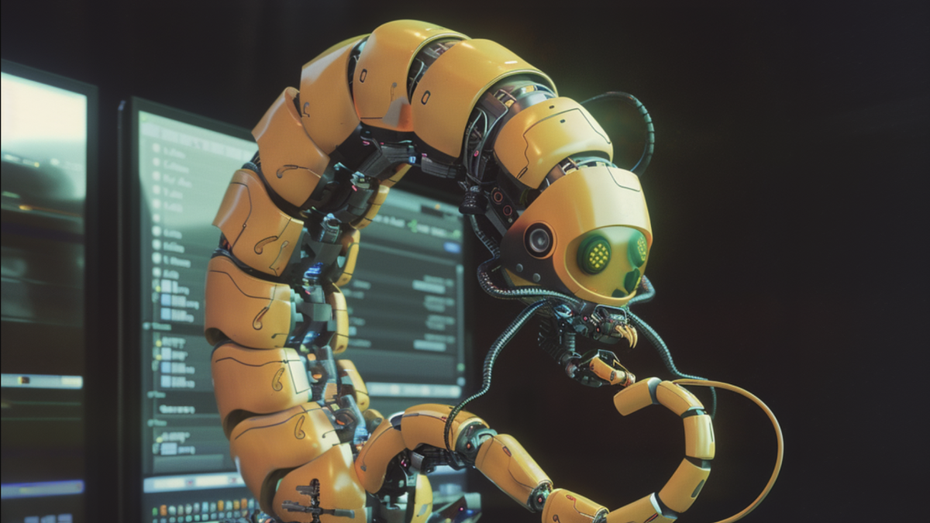

Um die Risiken vernetzter, autonomer KI-Systeme aufzuzeigen, hat eine Gruppe von Forscher:innen einen der ersten generativen KI-Würmer geschaffen, der sich von einem System auf ein anderes ausbreiten und dabei Daten stehlen oder Malware darin einsetzen kann.

Damit sei jetzt die Möglichkeit gegeben, „eine neue Art von Cyberangriff durchzuführen, die es noch nie zuvor gegeben hat“, sagt Ben Nassi gegenüber der Computerzeitschrift Wired. Der Forscher der Cornell Tech in New York ist einer der Hauptautoren der Studie.

Eingabeaufforderungen auf Textbasis als Einfallstor

Im Forschungsbericht heißt es, der KI-Wurm könne einen generativen KI-Email-Assistenten angreifen, um Daten aus Emails zu stehlen und Spam-Nachrichten zu versenden – und dabei Sicherheitsmaßnahmen in ChatGPT und Gemini außer Kraft setzen.

Die meisten generativen KI-Systeme basieren auf Text-Eingabeaufforderungen, mit denen die Tools angewiesen werden, eine Frage zu beantworten oder ein Bild zu erstellen. Laut Wired können diese Aufforderungen allerdings auch als Waffe gegen das System eingesetzt werden. Sogenannte Jailbreaks können dazu führen, dass ein System seine Sicherheitsregeln missachtet und hasserfüllte Inhalte ausspuckt, während sogenannte Prompt-Injection-Angriffe einem Chatbot geheime Anweisungen geben können.

Erschaffer:innen des KI-Wurms wollen sich mit OpenAI und Google treffen

In einem Forschungsvideo ist zu sehen, wie das manipulierte Email-System eine Nachricht mehrmals weiterleitet. Die Forscher:innen erklären auch, dass sie Daten aus Emails extrahieren könnten. „Es können Namen sein, es können Telefonnummern, Kreditkartennummern und alles sein, was als vertraulich gilt“, sagt Nassi.

Die Wissenschaftler:innen sehen den KI-Wurm als eine Warnung vor „schlechtem Architekturdesign“ von KI-Systemen – und stellten ihre Ergebnisse Google und OpenAI zur Verfügung. Ein Sprecher von OpenAI sagte gegenüber Wired, dass das Unternehmen daran arbeite, seine Systeme „widerstandsfähiger“ zu machen. Google äußerte sich nicht dazu. Nassis Team hat ein Treffen mit OpenAI und Google beantragt, um über das Thema zu sprechen.

bitte hört auf zu gendern. die Effekte vom gendern sind wissenschaftlich nicht erwiesen. mich macht es mittlerweile traurig zu sehen, dass es immer mehr einzug findet. es ist so gesehen sprachesoterik.

Die Effekte von Gendern sind mittlerweile gut belegt:

https://de.wikipedia.org/wiki/Studien_und_Umfragen_zu_geschlechtergerechter_Sprache

Auf welche wissenschaftliche Quelle beziehst Du Dich denn?

Der persönliche Geschmack ist natürlich eine andere Sache, aber der generische Gemininum ist ja auch nicht so dolle, oder ;-)