Wie Google DeepMind einen Roboterarm zum Amateur-Tischtennis-Spieler macht

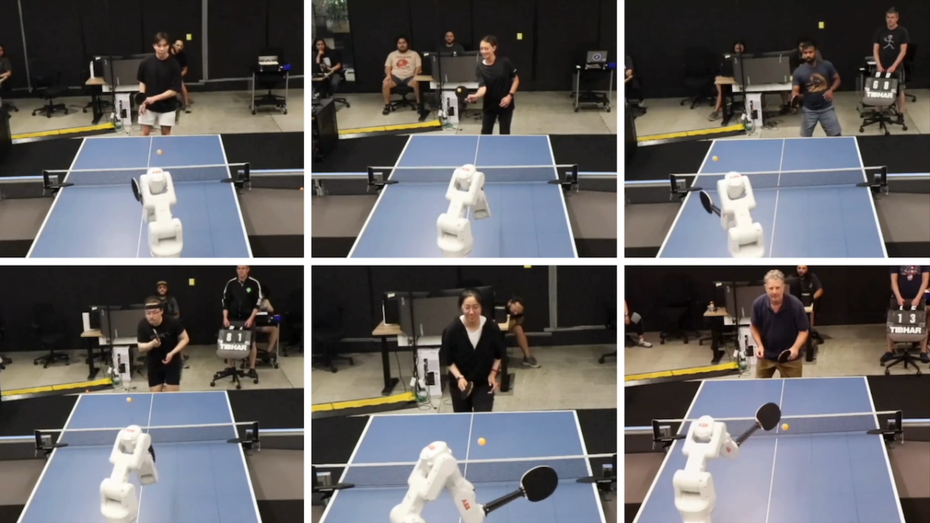

Okay, zugegeben: Ganz so athletisch sieht das Tischtennis-Spiel von dem Roboter von Google DeepMind nicht aus. Dennoch hat es die KI-Schmiede nach eigenen Angaben geschafft, der einarmigen Maschine das Spiel auf Niveau eines Amateurs beizubringen. Das ist somit das erste Mal, dass es einem Roboter in einer Sportart gelingt, mit einem Menschen gleich zu ziehen und sie stellenweise sogar zu besiegen.

In der dazugehörigen Studie, die die Forscher:innen bereits auf Arxiv zur Verfügung gestellt haben, die aber noch nicht das Peer Review durchlief, berichtet das Team von 29 Spielen gegen menschliche Gegner mit unterschiedlichem Leistungsvermögen. Davon gewann der Roboterarm 13 Spiele mit einem 3D-gedruckten Schläger.

Ein genauerer Blick auf die Ergebnisse zeigt: Der Tischtennis-Roboter konnte zwar alle menschlichen Gegner auf Anfängerniveau schlagen und sich bei 55 Prozent der Spieler auf Amateurniveau durchsetzen. Allerdings hatte er gegen fortgeschrittene Spieler keine Chance. Highlights von Spielen und Spiele in voller Länge haben die Forscher:innen auch zur Verfügung gestellt.

„Unsere Erwartungen übertroffen“

Dennoch zieht das Entwicklerteam eine positive Bilanz: „Noch vor ein paar Monaten gingen wir davon aus, dass der Roboter realistischerweise nicht in der Lage sein würde, gegen Menschen zu gewinnen, gegen die er noch nie gespielt hatte. Das System hat unsere Erwartungen bei weitem übertroffen“, sagt Pannag Sanketi, Softwareingenieur bei Google DeepMind, der das Projekt leitete. „Die Art und Weise, wie der Roboter selbst starke Gegner ausmanövriert hat, war beeindruckend.“

Wie aber bringt ein Tischtennis-spielender Roboter die Technologie voran? Die Idee dahinter ist es, dass sie dadurch (besser) lernen, nützliche Aufgaben in realen Umgebungen wie Wohnungen und Lagerhäusern präzise und sicher ausführen können – das langverfolgte Ziel der Robotik.

„Der Ansatz von Google DeepMind zum Trainieren von Maschinen lässt sich auf viele andere Bereiche des Fachgebiets übertragen“, sagt Lerrel Pinto, ein Informatikforscher an der New York University, der nicht an dem Projekt mitgearbeitet hat.

„Ich bin ein großer Fan davon, Robotersysteme zu sehen, die tatsächlich mit und um echte Menschen herum arbeiten, und dies ist ein fantastisches Beispiel dafür“, sagt er. „Er ist vielleicht noch kein starker Spieler, aber die Grundvoraussetzungen sind vorhanden, um sich weiter zu verbessern und es schließlich zu schaffen.“

Wer mehr über den Stand der Entwicklung der Robotik erfahren möchte, dem sei die Ausgabe 5/2024 von MIT Technology Review empfohlen. Darin beschäftigen wir uns damit, wie KI die Robotik voranbringen kann. Hier könnt ihr die TR 5/2024 als Print- oder pdf-Ausgabe bestellen.

Simulation und Daten aus realen Spielen

Um ein guter Tischtennisspieler zu werden, braucht der Mensch eine hervorragende Hand-Augen-Koordination, die Fähigkeit, sich schnell zu bewegen und schnelle Entscheidungen zu treffen, um auf den Gegner zu reagieren – all das sind für Roboter große Herausforderungen. Um ihrer Maschine diese Fähigkeiten „beizubringen“ bzw. die Fähigkeit, diese nachzuahmen, haben die Forscher:innen von Google DeepMind einen zweiteiligen Ansatz verwendet: Sie nutzten Computersimulationen, um das System zu trainieren, damit es seine Schlagfertigkeit beherrscht, und nahmen dann eine Feinabstimmung anhand von Daten aus der realen Welt vor, wodurch es sich mit der Zeit verbessern konnte.

Die Forscher:innen stellten einen Datensatz von Tischtennisballzuständen zusammen, einschließlich Daten zu Position, Spin und Geschwindigkeit. Das System griff auf diese Bibliothek in einer simulierten Umgebung zurück, in der die Physik von Tischtennisspielen genau widergespiegelt wurde, um Fähigkeiten wie das Zurückspielen eines Aufschlags, das Schlagen eines Vorhand-Topspins oder eines Rückhandschlags zu lernen. Allerdings mit einer Einschränkung: Da der Roboter aufgrund seiner „Physis“ den Ball nicht selbst aufschlagen konnte, wurden die realen Spiele entsprechend angepasst.

Kontinuierliche Feedbackschleife

Während seiner Spiele gegen Menschen sammelt der Roboter Daten über seine Leistung, um sein Spiel zu verbessern. Den Ball behält er mit Hilfe von Daten, die von zwei Kameras erfasst werden, im Blick. Den Spielstil seines menschlichen Gegners erfasst ein Motion-Capture-System, das LEDs am Schläger des Gegners verwendet. Die Balldaten werden für das Training in die Simulation zurückgespeist, wodurch eine kontinuierliche Feedbackschleife entsteht.

Dieses Feedback ermöglicht es dem Roboter, neue Fähigkeiten auszuprobieren, um seinen Gegner zu besiegen, d. h. er kann seine Taktik und sein Verhalten wie ein Mensch anpassen. Das bedeutet, dass er sowohl während eines Spiels als auch mit der Zeit immer besser wird, je mehr Spiele er spielt.

Probleme, den Ball zu treffen, hatte der Roboterarm vor allem, wenn dieser zu schnell, außerhalb seines Sichtfeldes (höher als 1,80 Meter über dem Tisch) war oder er sehr niedrig auf den Roboter zukam, denn in seinem Protokoll war er angewiesen, Schläge zu vermeiden, die den Tischtennisschläger beschädigen könnten. Auch mit rotierenden Bällen hatte die Maschine seine Schwierigkeiten: Der Roboter konnten den Spin nicht direkt messen – das fanden auch die fortgeschrittenen Gegner schnell heraus und nutzten dies als Vorteil für sich.

„Einen Roboter für alle Eventualitäten in einer simulierten Umgebung zu trainieren, ist eine echte Herausforderung“, sagt Chris Walti, Gründer des Robotikunternehmens Mytra und früherer Leiter des Robotikteams von Tesla, der nicht an dem Projekt beteiligt war. „Es ist sehr, sehr schwierig, die reale Welt zu simulieren, weil es so viele Variablen gibt, wie einen Windstoß oder sogar Staub [auf dem Tisch]“, sagt er. „Wenn man keine sehr realistischen Simulationen hat, wird die Leistung eines Roboters begrenzt sein.“

„Gern als Trainingspartner“

Doch Google DeepMind will diese Begrenzung beheben oder zumindest reduzieren, unter anderem durch die Entwicklung von KI-Modellen, die die Flugbahn des Balls vorhersagen, und durch die Einführung besserer Algorithmen zur Kollisionserkennung.

Entscheidend ist, dass die menschlichen Spieler Spaß an ihren Spielen gegen den Roboterarm hatten. Sogar die fortgeschrittenen Teilnehmer, die ihn besiegen konnten, sagten, dass sie Spaß hatten und dass sie das Gefühl hatten, dass der Roboterarm ihnen als dynamischer Übungspartner helfen könnte, ihre Fähigkeiten zu verbessern.

„Ich würde ihn auf jeden Fall gerne als Trainingspartner haben, jemanden, mit dem ich von Zeit zu Zeit ein paar Matches spielen kann“, sagte einer der Studienteilnehmer:innen.

Abseits von Tischtennis: Roboter im Einsatz