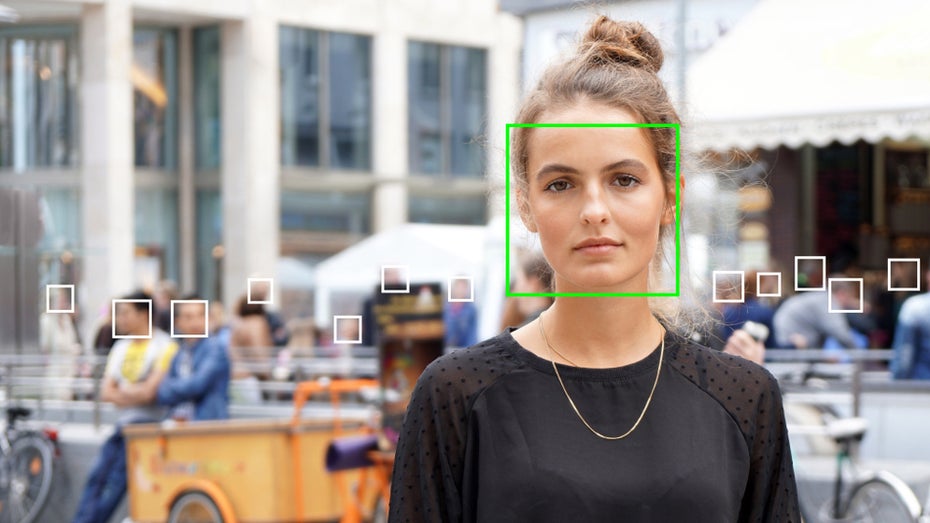

Immer häufiger wird KI zur Erkennung von Emotionen genutzt. Aber funktioniert das? (Foto: Shutterstock)

Gesichtserkennung wird heute nicht mehr nur zum Auseinanderhalten von Personen genutzt. Gleich eine ganze Reihe an Firmen bietet KI-Systeme an, die erkennen sollen, wie sich eine Person fühlt. Daraus wiederum sollen je nach Einsatzgebiet weitere Rückschlüsse über die Person getroffen werden können. Diese Technologien sollen beispielsweise im Rahmen von Bewerberinterviews genutzt werden oder um zu erkennen, wie stark ein Patient leidet. Ein Riesenmarkt: Einer Prognose zufolge könnte der Sektor bis 2024 einen Wert von mehr als 91 Millionen US-Dollar erreichen.

Mehrere wissenschaftliche Studien kommen jedoch zu dem Schluss, dass die Mimik einer Person keine ausreichende Grundlage für die Erkennung ihrer Emotionen bietet. Das AI Now Institute fordert daher jetzt in seinem Jahresbericht, dass der Gesetzgeber den Einsatz dieser Technologie eingrenzen sollte, wenn sie für Entscheidungen genutzt wird, die Einfluss auf das Leben von Menschen haben. Bis das geschieht, sei es die Pflicht von Technologieunternehmen, Produkte zur Emotionserkennung nicht an Kunden auszuliefern, solange die Funktionsweise dieser Werkzeuge nicht wissenschaftlich bewiesen sei.

AI Now Institute fordert Moratorium für den Einsatz von Gesichtserkennung im öffentlichen Leben

Das AI Now Institute gehört zur New York University und untersucht die gesellschaftlichen Auswirkungen von künstlicher Intelligenz. Im Jahresbericht des Instituts warnen die Autoren unter anderem auch davor, dass der Einsatz von Gesichtserkennung im politischen und sozialen Bereich negative Auswirkungen haben könnte. Um das eindeutig zu klären, müsse es ein Moratorium geben, damit Forscher, Gesetzgeber und Gemeinden die möglichen Nachteile verstehen und mit passenden Gesetzen darauf reagieren können.

In dem Bericht wird auch der Einsatz von künstlicher Intelligenz bei der Festsetzung von Arbeitszielen kritisiert. Darunter würden vor allem Arbeitnehmer aus dem Niedriglohnsektor leiden, denen die Möglichkeit gegeben werden sollte, die von einer KI erstellten Vorgaben anzufechten. Außerdem fordert das Institut, dass Wissenschaftler aus dem Machine-Learning-Sektor potenzielle Risiken ihrer Forschung besser erfassen, indem sie die Herkunft ihrer Trainingsdaten wie auch ihrer Modelle besser dokumentieren.

Ebenfalls interessant: Diskriminierung: Deshalb platzte Amazons Traum vom KI-gestützten Recruiting