Octoparse: So funktionieren Online-Trendanalysen mit Data-Scraping

(Bild: dunnnk / t3n)

Die marktüblichen Tools arbeiten normalerweise API-basiert. Das bedeutet, sie greifen mit Daten-Konnektoren auf die Programmierschnittstelle von beispielsweise Facebook zu und importieren die nötigen Daten. Problematisch daran ist, dass Facebook, Twitter und andere Social-Media-Portale ihrerseits den API-Zugriff stark limitieren – wer mehr Daten will, muss entsprechend zahlen. Oder überspitzt formuliert: Wer die Performance-Werte aus der API eines Accounts für die letzten sieben Tage rückwirkend will, bekommt sie kostenlos – die Werte für den letzten Monat hingegen nicht.

Data-Scraping als Alternative

Eine grundsätzlich andere Herangehensweise für Social-Media-Analysen ist die Anwendung von Scraping-Verfahren. Dabei werden die Daten „von der Oberfläche“ einer Website gescraped, also „geschabt“ – oder im übertragenen Sinne: gesammelt. Informatiker nutzen dafür beispielsweise die Programmiersprachen Python oder R. Da die meisten Online-Marketer aber keine Informatiker sind, gibt es hierfür einfachere Lösungen. Eine davon: Octoparse.

Die Software ermöglicht das Sammeln von relevanten Online-Daten in allen möglichen Variationen. In Hinsicht auf das Datenvolumen ist die kostenfreie Basic-Version für die meisten Analysen bereits vollkommen ausreichend – sofern man nicht Zehntausende Facebook- oder Instagram-Posts analysieren will. In der Basic-Version arbeitet der Octoparse-Crawler grundsätzlich im „Advanced Mode“ und operiert über den Nutzer-Browser, der entsprechend konfiguriert werden kann. Die kostenpflichtige Version arbeitet hingegen über eine Cloud von Octoparse und löst viele Fragestellungen von alleine.

In diesem Beitrag widmen wir uns dem Advanced Mode und den damit verbundenen technischen Möglichkeiten.

Der Octoparse-Webcrawler

Das Octoparse-System arbeitet mit einem Crawler, der auf einer gewünschten Ziel-Website Daten sammelt und sie in einer CSV- oder Excel-Tabelle ausgibt. Daraus lassen sich wiederum alle erdenklichen Diagramm-Visualisierungen erstellen und vergleichen.

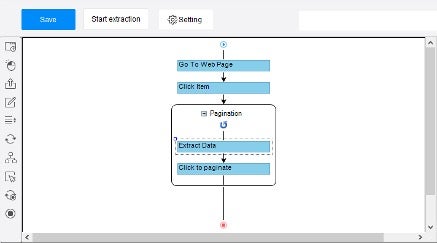

Vor dem Start des Crawlers muss er entsprechend konfiguriert werden. Was auf den ersten Blick kompliziert aussieht, ist schnell gelöst wegen der interaktiven und hauseigenen Anleitungen der Plattform. Wer beispielsweise danach sucht, wie die Performance-Daten aus Instagram-Posts extrahiert werden, kann problemlos die Schritt-für-Schritt-Anleitung dazu nutzen. Ziel der Konfiguration ist, dem Crawler die Verfahrensschritte der gewünschten Website-Bedienung mitzugeben.

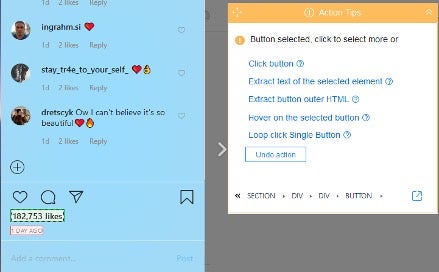

Im Klartext sieht das in etwa folgendermaßen aus: Wir geben die gewünschte Ziel-URL ein und legen die Elemente fest, die der Crawler scrapen soll – also zum Beispiel Seitentitel, Datum, Textinhalt, Hashtags, Likes, Anzahl der Kommentare, Textinhalt aller Kommentare mit zugeordneten Nutzern. Anschließend kommt der entscheidende Schritt: Der Crawler muss sich selbst automatisiert zum nächsten Post navigieren – wir müssen eingeben, welches Element dafür geklickt werden muss. Außerdem müssen wir die Website-Ladezeiten berücksichtigen – in diesem Fall geben wir ein, wie oft der Crawler nach jedem Klick zu einem anderen Post scrollen soll. Das Einzige, was noch fehlt, ist die Einstellung einer Loop-Funktion, damit die Anwendung immer wieder neu ausgeführt wird. Fertig: Das System startet nun, und geht in Echtzeit die gesamte Timeline bis zum Schluss Post für Post durch.

Abbildung 1: Beispiel für ein Konfigurations-Interface für den Crawler zum Scrapen von Instagram-Beiträgen mit Loop-Funktion. (Screenshot: Slava Wagner)

Abbildung 2: Festlegen der Elemente für die Datenextraktion eines Instagram-Beitrags. (Screenshot: Slava Wagner)

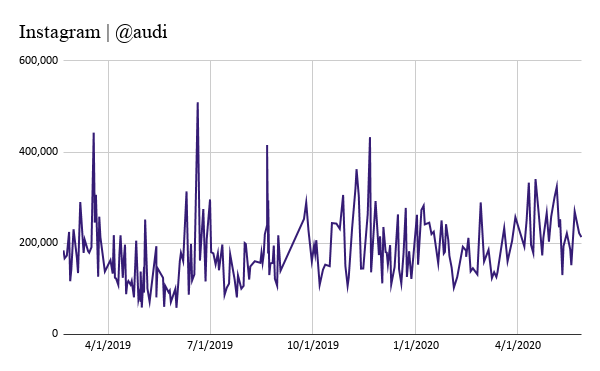

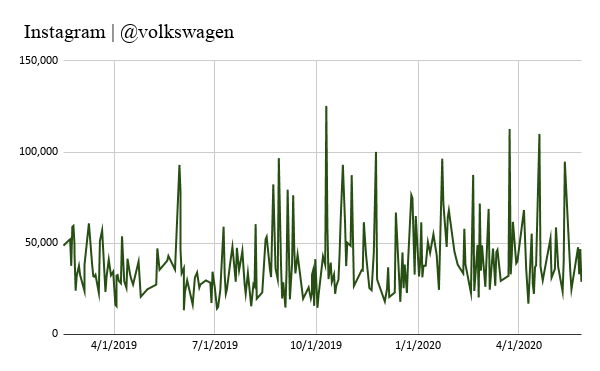

Beispiel: Scraping der Instagram-Posts von Audi und VW von Anfang 2019 bis Anfang 2020 (* nur Bilder, keine Videos)

Abbildung 3: Entwicklung der Beitrags-Likes auf einzelnen Posts bei Instagram auf dem Account von @audi. (Screenshot: Slava Wagner)

Abbildung 4: Entwicklung der Beitrags-Likes auf einzelnen Posts bei Instagram auf dem Account von @volkswagen. (Screenshot: Slava Wagner)

Spannende Datenquellen

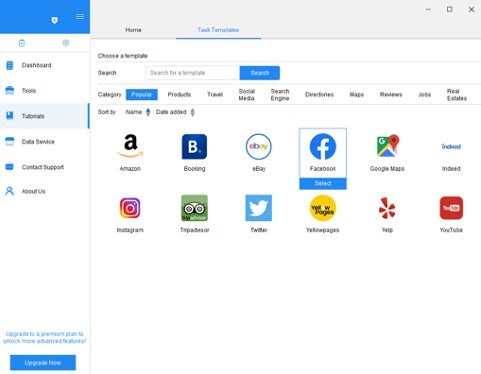

Octoparse selbst stellt umfangreiche Anleitungen zum Scrapen interessanter Datenquellen bereit. Für eine Trendanalyse der gefragtesten Berufsgruppen lassen sich die Indeed-Einträge des letzten Jahres auswerten, in Clustern abbilden und vergleichen. Ebenfalls lassen sich Preisentwicklungen von E-Commerce-Anbietern bei Amazon analysieren sowie Marktnischen entdecken. Hashtag-Trendanalysen auf Twitter, Facebook oder Instagram können ebenfalls wichtige Erkenntnisse darüber liefern, mit welchen Hashtags eine Social-Media-Kampagne lanciert werden könnte, um erfolgreich zu sein.

Abbildung 5: Datenquellen zum Scrapen bei Octoparse (Screenshot: Slava Wagner)

Vorteile

Octoparse überzeugt mit Praktikabilität für Nutzer ohne Programmierkenntnisse. Das Tool hilft bei der Sammlung und Verarbeitung großer Datensätze aus vielen relevanten Plattformen – ob für eigene Accounts, Kundenaccounts oder Mitbewerber-Analysen. Die kostenfreie Basic-Version wartet mit riesigem Funktionsumfang auf, der in den allermeisten Fällen für den alltäglichen Gebrauch vollkommen ausreicht. Außerdem bieten die Anleitungen für die Konfiguration des Scraping-Verfahrens zahlreiche Analysemöglichkeiten für verschiedene Zwecke. Für fortgeschrittene Nutzer ist es außerdem möglich, Daten domainübergreifend zu sammeln und zu kategorisieren.

Besonders interessant: Der Crawler kann sich mit der richtigen Konfiguration auch selbst bei bestimmten Plattformen anmelden. Das ermöglicht es, auch interne Metriken wie beispielsweise Impressionsraten bei Facebook, Instagram oder Twitter zu scrapen, ohne dafür auf kostenpflichtige Tools zuzugreifen.

Weiterer Vorteil: In der Basic-Version lassen sich bis zu 10.000 Dateneinträge pro Analyse exportieren. Eigentlich wäre eine solche Limitierung eher ein Nachteil – aber auf der anderen Seite: Wie viele Social-Media-Accounts haben in den letzten zwei Jahren Tausende Posts publiziert?

Nachteile

Der wahrscheinlich größte Nachteil ist die Ladezeit des Programms. Octoparse ist keine Web-App, sondern muss als konventionelles Programm heruntergeladen werden. Je länger das Programm konfiguriert wird, desto langwieriger werden die Ladezeiten. In Kombination mit den teilweise komplexen technischen Konfigurationsverfahren kann es gerade Einsteiger in den Wahnsinn treiben – daraus folgt ein nervenaufreibendes Trial & Error.

Ein weiterer gravierender Nachteil: Einige Anleitungen sind nicht auf dem aktuell neuesten Stand der Social-Media-Plattformen. Bespiel (Juni 2020): Die Anleitung zum Scrapen von Twitter-Accounts im Advanced Mode funktioniert nicht ordnungsgemäß – egal, welche individuellen Herangehensweisen zusätzlich angewandt werden.

Fazit – eine gewisse Unabhängigkeit

Es gibt viele Herangehensweisen für die Analyse von Social-Media-Accounts. Doch gerade API-basierte Software bleibt oft in technischen Sackgassen stecken – Performances lassen sich nicht über Jahre zurückverfolgen, adäquate Mitbewerber-Analysen schwer durchführen und zu allem Überfluss fallen teils hohe monatliche Kosten an. Das größte Problem ist aber die Abhängigkeit von vielen vereinzelten, kleinteiligen Anbietern. Mit Data-Scraping-Ansätzen entfallen all diese Punkte – wir können alle erdenklichen Datensätze selbst einholen, unabhängig von Plattform oder Metrik. Diese Unabhängigkeit ist dahingehend von besonderem Vorteil, dass Online-Marketer ihre Digitalanalysen für Kunden stets out of the box erstellen können: mit unikalen Daten, die viele nicht haben.