Quantencomputer vs. Kryptografie: Der Wettlauf um die digitale Sicherheit

Die US-Standardisierungsbehörde National Institute of Standards and Technology (NIST) hat die ersten drei Standards für die Post-Quanten-Kryptographie veröffentlicht: ML-KEM, ML-DSA und SLH-DSA. Die Standards sind nach Auffassung der NIST geeignet, auch Angriffen mit zukünftig verfügbaren Quantencomputern gefeit. ML-KEM dient der verschlüsselten Kommunikation mit Websites oder Servern, während ML-DSA und SLH-DSA für die Erstellung und Überprüfung digitaler Signaturen dienen. In diesem und im nächsten Jahr sollen noch mindestens zwei weitere Standards veröffentlicht werden.

Die aktuell eingesetzte Kryptografie basiert auf mathematischen Problemen, die als Einwegfunktionen bezeichnet werden – Berechnungen, die in einer Richtung einfach auszuführen, in der anderen aber kaum zu lösen sind, selbst mit einem leistungsstarken Computer. So lassen sich beispielsweise zwei Primzahlen leicht miteinander multiplizieren. Die Zerlegung einer großen Zahl in ihre Primfaktoren ist jedoch extrem aufwendig zu berechnen.

Gamechanger Quantencomputer?

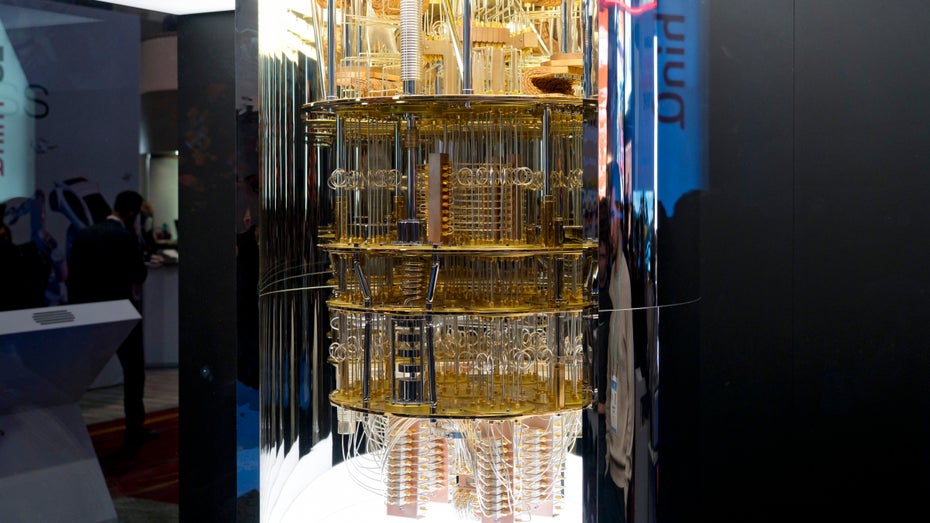

Das könnte sich ändern, wenn praktisch nutzbare Quantencomputer ins Spiel kommen. Zwar sind die aktuell existierenden Quantencomputer nicht leistungsfähig genug, um beispielsweise einen RSA-Schlüssel zu knacken. Forscher:innen bei IBM beispielsweise verweisen aber auf jüngste Fortschritte bei der Fehlerkorrektur von Quantencomputern und die immer bessere Qualität der Qubits. Spätestens 2035 könnten solche Quantencomputer tatsächlich mächtig genug sein.

Weltweit arbeiten Forschungsgruppen daher an Post-Quanten-Kryptografie-Verfahren. Die NIST arbeitet seit 2016 an dem Problem und hatte ursprünglich 69 Kandidaten-Algorithmen. Vielversprechende neue mathematische Ideen erweisen sich aber immer wieder als unsicher, weil Forscher:innen Lücken in der Implementierung des Verfahrens finden.

Kryptografie, also Verschlüsselung betrifft immer die Sicherheit der Daten (unabhängig deren Form).

Der eine will nicht, dass der andere den Inhalt erfährt.

Und hier beginnt das wahre Problem – nämlich Faktor MENSCH.

Ob einfaches mischen oder weglassen der Buchstaben, Enigma oder Navajo-Code-Talker (übrigens, am 14. August den National Navajo Code Talkers Day gefeiert) und zuletzt z.B. SHA3-512, mit Salz und Pfeffer, oder ohne – so lange jemand die Daten mit Password oder auf andere Weise entschlüsseln darf oder kann – das schafft auch ein Gegner. Sicher sind die Daten erst dann, wenn niemand weiß, dass es etwas zum Entschlüsseln gibt. Also die alte, immer noch gültige „Weisheit“: was du nicht weißt, macht dich nicht heiß.

Andere logische Formen der Sicherung der Daten?

Verschlüsseln von dem verschlüsseltem, am besten mit zwei oder sogar mehr verschiedenen Methoden.

Ob das bei großen Datenmengen praktikabel ist? Darf bezweifelt werden.

Einfache Methode ist, die verschlüsselten Daten so zu programmieren, dass diese bei z.B. drittem Fehlversuch (Brute-Force-Attack) sich selbst löschen. Prinzipiell ähnlich wie bei PHP die Funktion „unlink“.

Zwar sind die Daten vorerst weg, aber man kann diese an einer anderen Stelle zur Verfügung stellen.

Und viel wichtiger ist die Tatsache, dass man sehr schnell merkt, ob jemand sich an diese herangemacht hat.

Es sind zwar alles nur Vorschläge eines kompletten Kryptografie-Laien, aber manchmal sind die einfachen Methoden die besten.

Oder wie mal eine gute Werbung formulierte: „… Weil einfach einfach einfach ist …“.