AWS: Neue GPU-Instanzen sollen KI-Entwicklung beschleunigen

Die neuen P4-Instanzen von AWS (Amazon Web Services) richten sich an Unternehmen und Forschungseinrichtungen, die Wert auf maximale Leistung bei der Berechnung komplexer KI-Modelle legen. Die neuen GPU-Instanzen werden jeweils von Intels Cascade-Lake-Prozessoren und acht A100-Tensorkernen von Nvidia angetrieben.

Höhere Leistung soll KI-Training billiger machen

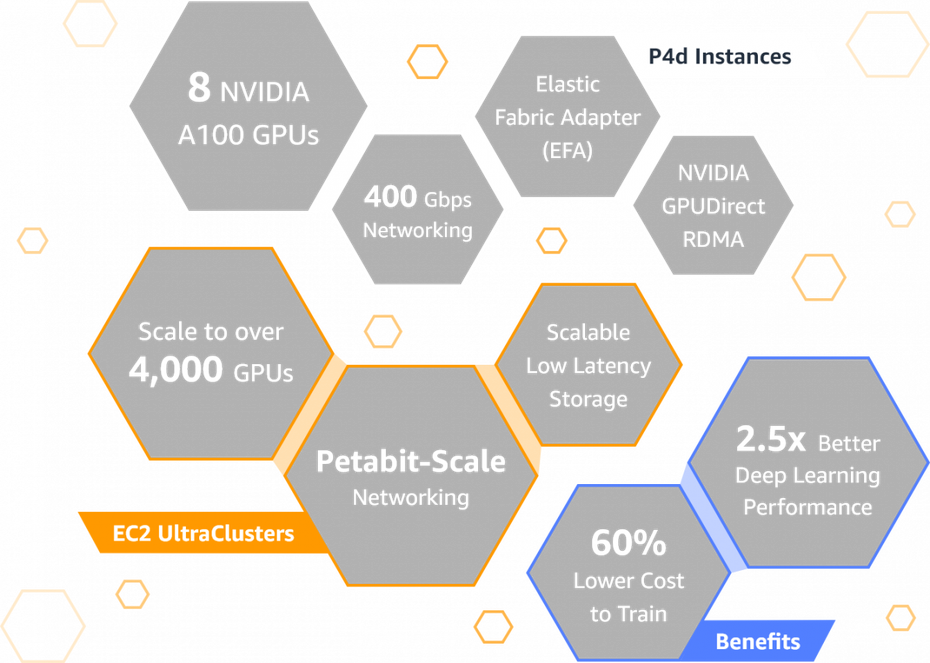

Damit verspricht AWS eine Kostenreduzierung um 60 Prozent bei einer Beschleunigung um das Zweieinhalbfache, wenn die Cluster für die Berechnung komplexer KI-Modelle eingesetzt werden.

Andere interessierte Anwender werden schon angesichts der aufgerufenen Preise eher die Finger vom neuen P4-Angebot lassen, das es derzeit nur in der Variante P4D.12xlarge gibt. Die bringt 320 Gigabyte an GPU-Speicher und eine Netzwerkanbindung mit 400 Gigabit pro Sekunde mit.

P4D im Überblick. (Grafik: AWS)

96 Prozessorkerne, 1,1 Terabyte System-Arbeitsspeicher und acht Terabyte SSD-Speicher sorgen dann auch für einen vergleichsweise hohen Stundenpreis von rund 33 US-Dollar. Der wird – wie immer bei AWS – nur dann fällig, wenn auch eine Nutzung erfolgt. Wer sich längerfristig binden will, kann den Stundenpreis auf rund 12 Dollar senken.

Cluster können Supercomputer-Niveau erreichen

Im Extremfall lassen sich mehr als 4.000 GPUs zu einem sogenannten EC2-Ultracluster kombinieren. Diese Supercomputer-Klasse hat AWS bereits mit Kunden wie dem Toyota Research Institute, GE Healthcare und Aon getestet.

Mike Garrison, technischer Leiter am Toyota Research Institute, ist von den Vorzügen überzeugt. So habe schon die Vorgängergeneration der GPU-Cluster zu einer Effizienzsteigerung bei der KI-Modellierung geführt. P4 verspreche nicht nur noch mehr Geschwindigkeit, sondern erlaube auch das Training noch komplexerer Modelle in kürzerer Zeit.