Core Web Vitals: Nur 3 Prozent der deutschen Websites erreichen einen guten Messwert

Google. (Foto: Evan Lorne/Shutterstock)

Mit den Core-Web-Vitals-Messwerten misst Google anhand mehrerer Signale die Nutzerfreundlichkeit einer Website. Vorgestellt wurden die Metriken bereits 2020. Aufgrund der Coronakrise hat der Suchmaschinenanbieter die Einführung der Core Web Vitals als Teil eines neuen Rankingfaktors aber immer wieder verschoben. Demnächst wird es aber dann doch losgehen: Ab Mitte Juni 2021 sollen die Core-Web-Vitals-Messwerte einer Website schrittweise Einfluss auf deren Ranking haben.

Hintergrund: Core Web Vitals – Googles Kennzahlen zur Bewertung der User-Experience erklärt

Wirklich gut vorbereitet sind hiesige Websites aber offenbar nicht, wie eine aktuelle Untersuchung der SEO-Plattform Searchmetrics zeigt. Von den mehr als zwei Millionen untersuchten deutschsprachigen Websites erreichen laut der Studie nur drei Prozent einen guten Wert in allen drei Kategorien der Core-Web-Vitals-Messung.

Core Web Vitals: So schneiden deutsche Websites ab

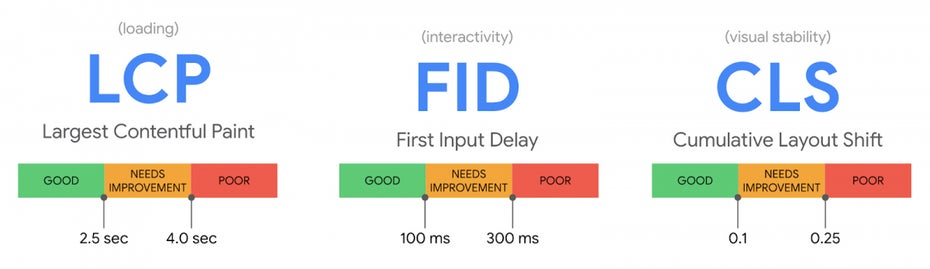

Die Core Web Vitals bestehen aus insgesamt drei Messwerten. Der erste heißt Largest Contentful Paint (LCP) und misst die Renderzeit des größten Seitenelemente innerhalb des sichtbaren Bereichs einer Website. Als guten LCP-Wert definiert Google alles unterhalb von 2,5 Sekunden. Bezogen auf die Durchschnittswerte der 20 höchstplatzierten Google-Ergebnisse gibt es hier keine Probleme. Im Schnitt liegt ihr LCP-Wert laut Searchmetrics bei 2,47 Sekunden. Die fünf höchstplatzierten organischen Treffer im Durchschnitt sogar bei 1,93 Sekunden.

Den zweiten Wert der Core Web Vitals bezeichnet Google als First Input Delay (FID). Hier wird gemessen, wie viel Zeit zwischen der ersten Nutzeraktivität und der Reaktion der Website vergeht. Gemeint ist beispielsweise die Verzögerung zwischen dem Klick auf einen Button und der dazugehörigen Aktion. Da dieser Wert ohne jedwede Interaktion jedoch auf null bleibt, haben sich die Macher der Searchmetrics-Studie dazu entschieden, stattdessen einen anderen Messwert zu verwenden.

Die Core Web Vitals im Überblick. (Grafik: Google)

Als Ersatz für FID setzen die Studienautoren auf die Total Blocking Time (TBT). Sie misst, wie viele Ladevorgänge Nutzer davon abhalten, mit einer Website zu interagieren. Leider schneiden viele deutsche Websites bei dieser Ersatzmessung nicht gut ab. Die 20 höchstplatzierten Google-Ergebnisse sind im Durchschnitt um 43,5 Prozent langsamer als der Google-Benchmark von 300 Millisekunden.

Die dritte Core-Web-Vitals-Angabe heißt Cumulative Layout Shift (CLS). Sie dient als Kennzahl für visuelle Stabilität einer Website. Hier wird gemessen, wie oft sich Seitenelemente unerwartet verschieben. Gemeint sind beispielsweise asynchron geladene Bilder, die plötzlich das Layout eines Textes verschieben. Auch hier schnitten die meisten der 20 höchstplatzierten Websites nicht gut ab. Laut Searchmetrics waren sie im Durchschnitt 215,7 Prozent schlechter als der von Google als gut definierte Wert von 0,1.

Liebt t3n’ler, da müsst ihr jetzt stark sein. Gerade auf dieser Seite geguckt, LCP 8,7s, TBT 1010ms, TtI 9,7s, bis auf CLS alles rot.

Und zusammenfassend sagt Google: Summary Nach Auswertung der Daten aus den letzten 28 Tagen haben alle Seiten, die von dieser Quelle bereitgestellt werden, den Core Web Vitals-Test nicht bestanden.

Also nicht nur Artikel darüber schreiben, sondern die Probleme auch selbst angehen :-)

Und was schlägt sich neben anderen Dingen ganz schlecht auf die Core-Web-Vitals aus? Google-Dienste wie Google Fonts oder AdSense.

na geiler zeitpunkt… is ja nich so, dass man nich eh schon 24/7 arbeitet durch den corona-shit… danke google… Oo

Ich verstehe nicht, warum man das nicht schon vor Jahren angegangen ist. Das ist so ein altes Thema und eben nicht nur von Google gewollt, sondern vom User. Das ist dem User zuträglich und es die Vorgaben dieser Web-Vitals gibt es schon seit Jahren.

Wer sich heute darüber aufregt, dass die eigene Seite das nicht kann, hat in den letzten Jahren geschlafen. Es war genug Zeit dafür da und Mobile-First und wie man all das nennt, gibt es so lange schon.

Ich finde es positiv, weil es für Hobbyprogrammierern deutlich schwieriger wird, eine Webseite ohne tiefgründige Know-How aufzubauen. Ich finde es unverschämt, das Webseiten teilweise für einen Dumpingpreis verkauft werden. Der Kunde weiß sicher nicht, dass der Code eigentlich katastrophal aufgebaut ist. Wer an den falschen Ecken spart, zahlt doppelt.

Danke für den Artikel :)