Deepfakes: Digitale Identitätsprüfung steht vor einem Problem

Wer Finanzdienstleistungen im Netz anbietet, muss, schon allein um den EU-Richtlinien zur Geldwäsche zu entsprechen, die Identität seiner Neukund:innen überprüfen. Das Prinzip wird in der Branche als „Know your customer“ (KYC) bezeichnet. Zu Deutsch: Kenne dein:e Kund:in. Praktisch funktioniert das Ganze so: Bei der Registrierung müssen Kund:innen ein Ausweisdokument in die Kamera ihres Smartphones oder Computers halten.

Anschließend zeigen sie sich selbst in der Kamera und müssen – je nach System – bestimmte Bewegungen machen. Also beispielsweise auf Zuruf nach rechts oder links gucken. So soll verhindert werden, dass Betrüger:innen einfach ein Video abspulen können, um das System zu täuschen. Das reicht allerdings längst nicht mehr aus.

Schon 2018 soll ein Team chinesischer Cyberkrimineller Deepfakes eingesetzt haben, um KYC-Systeme auszutricksen. Als Deepfakes werden mittels KI erstellte beziehungsweise manipulierte aber fotorealistisch aussehende Medieninhalte, wie beispielsweise Videos von Personen, bezeichnet.

In dem chinesischen Fall nutzten die Betrüger:innen echte Ausweisdokumente, um dann mittels Deepfake-Technologie künstlich erstellte Gesichter darüberzulegen. Auf die Art generierten sie nicht existente Personen, die dann wiederum Firmen gründeten. Über diese Firmen konnten sie die chinesische Steuerbehörde um 500 Millionen Yuan, umgerechnet 70,5 Millionen Euro, betrügen.

Die Masche ging für die Beteiligten einige Jahre gut, 2021 wurden sie dann jedoch gefasst und angeklagt. Der Fall zeigt allerdings, dass bestehende KYC-Systeme eben sehr wohl ausgetrickst werden. Das untermauert auch eine aktuelle Untersuchung mehrerer gängiger Systeme.

Know your customer: Deepfakes können Systeme nach wie vor austricksen

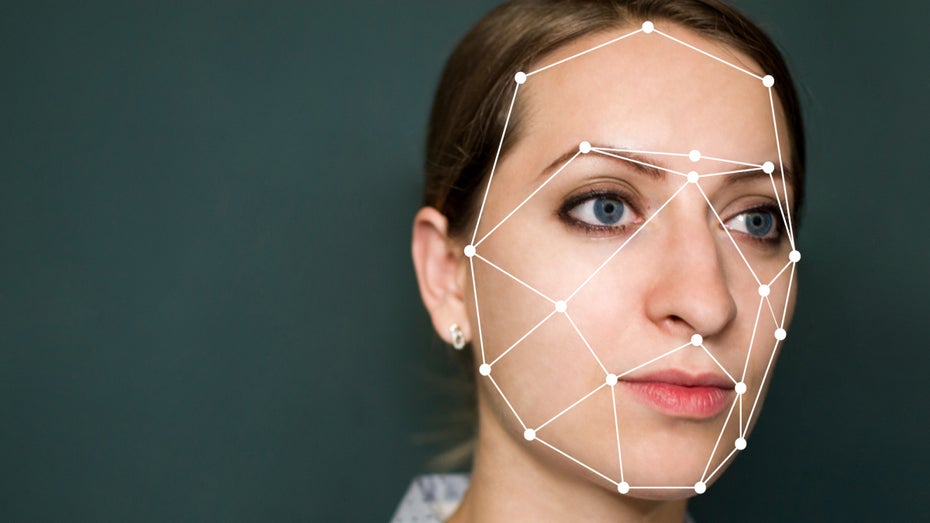

Dass Gesichtserkennungslösungen mit Deepfakes in die Irre geführt werden können, wurde in der Vergangenheit schon von mehreren wissenschaftlichen Studien bewiesen. Jetzt hat sich der auf KI-gestützte Verifikationslösungen spezialisierte Anbieter Sensity an einen praktischen Versuch gewagt.

Mit einem selbst entwickelten Angriffswerkzeug testete das Unternehmen mehrere am Markt verfügbare KYC-Systeme darauf, ob sie durch Deepfakes getäuscht werden könnten. Das Ergebnis ist ernüchternd: Fast alle Systeme konnten nach Unternehmensangaben ausgetrickst werden.

Für den Schutz vor Geldwäsche und die Nachverfolgbarkeit von Geldströmen stellen Deepfake-Angriffe eine ernstzunehmende Gefahr dar. Aber auch in anderen Bereichen könnte die Technologie in Zukunft für Probleme sorgen. Ein 2020 veröffentlichter Bericht von Wissenschaftler:innen des University College of London bezeichnet mittels Deepfake erstellte Fake News als eine der größten Gefahren, die sich durch die KI-Technologie in den kommenden Jahren ergeben könnten.

Gleichzeitig könnten mit Deepfakes auch gezielt Einzelpersonen am Telefon oder in Videochats imitiert werden, um so beispielsweise an Informationen zu gelangen. Noch lassen sich Deepfakes in vielen Fällen manuell und auch algorithmisch erkennen, nach Ansicht der Forscher:innen könnte das jedoch langfristig immer schwieriger werden.