So kann ein Farbpunkt autonome Autos verwirren

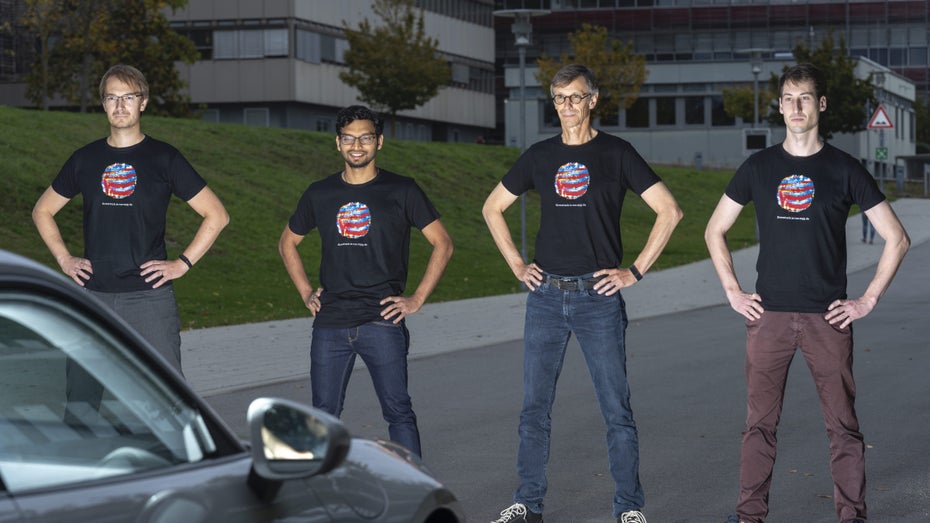

Wenn Sarah Connor das gewusst hätte: Der Punkt auf den T-Shirts der Forscher kann Maschinen die Orientierung nehmen. (Foto: Max-Planck-Institut für Intelligente Systeme)

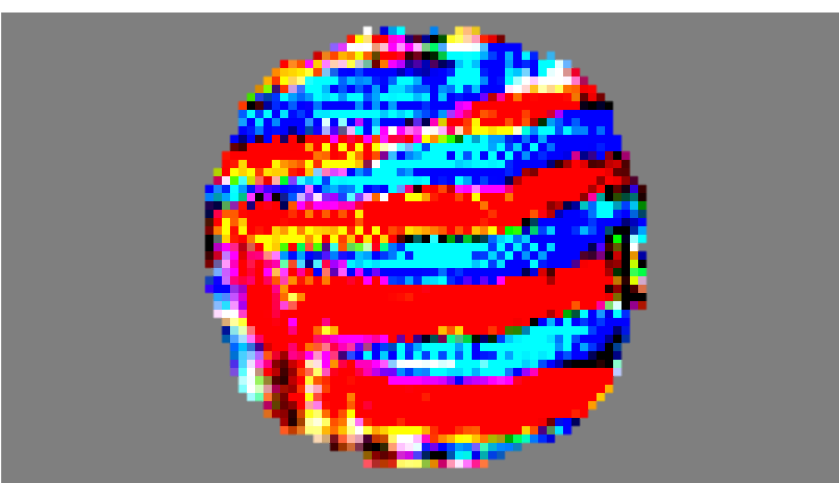

Der Punkt, der aktuelle selbstfahrende Autos empfindlich stören kann, sieht unspektakulär aus: Ein bisschen rot, ein bisschen blau – als hätte jemand einen Lava-Planeten mit einer Wärmebildkamera fotografiert.

„Wir haben drei, vielleicht vier Stunden gebraucht, um das Muster zu erstellen – das ging ganz schnell“, erklärt Anurag Ranjan. (Foto: Max-Planck-Institut für Intelligente Systeme)

Der Farbpunkt, den ein Team um Anurag Ranjan, ein Forscher am Max-Planck-Institut für Intelligente Systeme in Tübingen, entwickelt hat, reicht aus, um die Systeme von selbstfahrenden Autos zu hacken. Laut den Forschern würde es sogar reichen, wenn der Punkt irgendwo im Sichtfeld des Autos platziert wird – zum Beispiel auf einem T-Shirt oder einer Einkaufstüte.

„Wir haben drei, vielleicht vier Stunden gebraucht, um das Muster zu erstellen – das ging ganz schnell“, erklärt Anurag Ranjan in einer Pressemitteilung. Ranjan hat in seiner kürzlich veröffentlichten Studie „Attacking Optical Flow“ untersucht, wie solche Muster Störsignale bei Autopiloten auslösen können.

Punkt stört den „optischen Fluss“

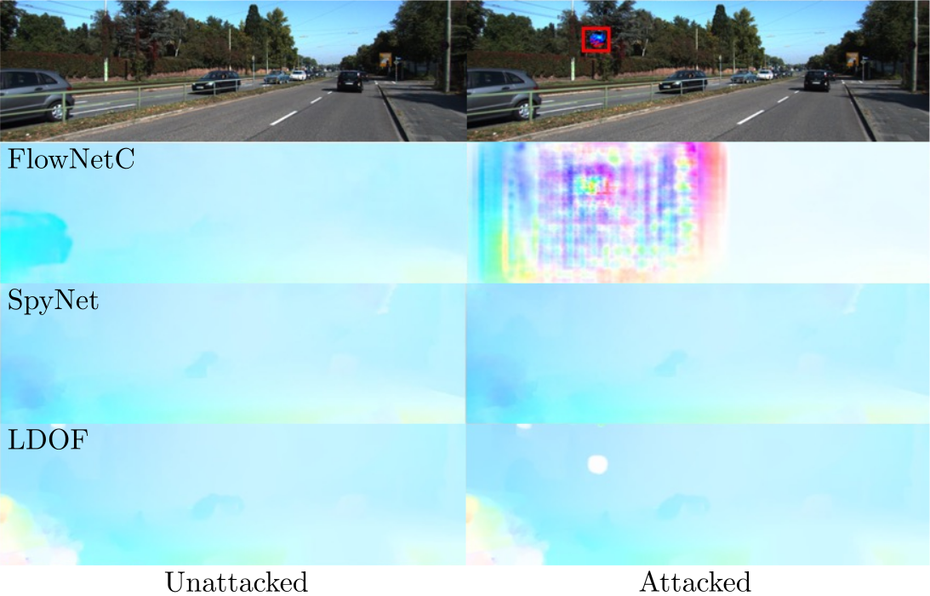

Laut den Forschern des Max-Planck-Instituts für Intelligente Systeme arbeiten viele Autopiloten mit einer Technik, die sich „Optical Flow“ – optischer Fluss – nennt. „Der optische Fluss beschreibt die Bewegung in einer Szene, die von den Bordkameras erfasst wird“, so die Forscher. Das von den Wissenschaftlern entwickelte Muster kann diesen optischen Fluss empfindlich stören. „Selbst wenn sich das Muster nicht bewegt, kann es dazu führen, dass tiefe neuronale Netze, wie sie heute in großem Maße zur Flussberechnung eingesetzt werden, falsch rechnen: Das Netzwerk kalkuliert plötzlich, dass sich große Teile der Szene in die falsche Richtung bewegen“, so die Forscher. Wie sehr das Muster die Berechnungen stört, zeigt ein Video der Forscher:

Laut Anurag Ranjan und seinem Team reicht dabei schon eine Größe von weniger als 1 Prozent des Gesamtbildes aus, um die Systeme des optischen Fluss anzugreifen. „Dies ist bedenklich, da das Flow-System in vielen Fällen die Bewegung der Objekte in der gesamten Szene gelöscht hat“, erklärt Ranjan.

Links: Die Sicht ohne störenden Punkt; Rechts: Beeinträchtigte Sicht mit Farbpunkt. (Foto: Max-Planck-Institut für Intelligente Systeme)

Wie anfällig die Autopiloten der großen Autohersteller im Moment für Ranjans Farbpunkt sind, ist allerdings schwer zu sagen: In der Regel verraten Tesla und Co. nicht, wie ihre Systeme genau funktionieren. „Prinzipiell sind die heutigen Perzeptionssysteme mit Deep Learning auf Kamera anfällig“, schrieb Christian Müller, ein Forscher zum Thema autonomes Fahren am DFKI in einer E-Mail. „Tesla verwendet seit einiger Zeit auch Radar. Ob es trotzdem zu einem Unfall kommen kann, kann nur bei tiefer Kenntnis über das konkrete System ausgeschlossen werden“, so Müller. Um Autopiloten robuster zu machen, rät er: „Mehre Sensoren am besten mit Kamera + Lidar + Radar verwenden.“ Tesla, so der Experte, verwende zur Zeit keine Lidar-Technologie.

Schwachstellen in den verbreitetesten Algorithmen

„In unseren Experimenten haben wir die fünf verbreitetsten Optical Flow Algorithmen verwendet und sie angegriffen. Wir haben dabei deutliche Schwachstellen gefunden,“ schrieb Ranjan in einer E-Mail.

Die Forscher vom Max-Planck-Institut hoffen, dass ihre Forschung die Autopiloten in der Praxis sicherer machen wird: „Unsere Arbeit soll die Hersteller von selbstfahrender Technologie wachrütteln, sie vor der potenziellen Bedrohung warnen. Wenn sie davon wissen, können sie ihre Systeme so trainieren, dass sie gegenüber derartigen Angriffen robust sind“, sagt Michael J. Black, Direktor der Abteilung für Perzeptive Systeme am Max-Planck-Institut für Intelligente Systeme.

Damit ein Farbpunkt selbstfahrende Autos verwirren kann, müssten sie allerdings erstmal überhaupt fahren. Auf absehbare Zeit ist der Verkehr also erstmal sicher vor allen Autopiloten-Hacks.

- Apple-Mitgründer Steve Wozniak: Wir werden nie vollautonome Autos haben

- t3n-Themenseite: Autonomes Fahren