Warum Googles Meena einen Durchbruch für Chatbots bedeuten könnte – und warum sie noch nicht gänzlich menschlich ist

Chatbots geben bei Fluggesellschaften Auskunft zu Buchungen oder Flugdaten, sie schlagen Rezepte vor oder nehmen Pizza-Bestellungen auf. Solche Chatbots sind in ihrer Anwendung jedoch meist auf ihren Aufgabenbereich beschränkt und nicht für allgemeine Unterhaltungen ausgelegt. Ein paar wenige Unterformen von Chatbots sind aber bereits zu generalistischen Konversationen in der Lage, häufig sind sie aber sehr fehleranfällig – für „gute“ Konversationen fehlen ihnen einerseits größere Datenmengen, andererseits haben sie im Gegensatz zu Menschen kein kulturelles Gespür. Das könnte sich jetzt mit Googles Chatbot Meena ändern, denn dieses Modell setzt neue Maßstäbe in human-digitalen Konversationen.

Eine Form von Chatbots sind sogenannte virtuelle Gefährten (oder auch „Conversational Agents“), mit denen Unterhaltungen über verschiedenste Themen möglich sind. Führende englischsprachige Vertreter waren bis Mitte letzten Jahres vor allem zwei Conversational Agents (CA): Steve Worswicks Mitsuku und Microsofts Zo, die Mitte letzten Jahres offline ging. Nun hat Google einen Artikel zu deren entwickelten Modell, dem Chatbot Meena, veröffentlicht, in dem sie eine Herangehensweise beschreiben, wie Chatbots noch menschlicher werden könnten.

Meena ist wie Mitsuku ein sogenannter Open-Domain-Chatbot. Das heißt, der User kann über alles Mögliche schreiben oder Fragen stellen und der CA hat eine Antwort darauf. Das bedeutet jedoch nicht unbedingt, dass die Antwort gut ist. Existierende Open-Domain-Chatbots haben das Problem, dass ihre Antworten oft keinen Sinn ergeben: Sei es, dass die Antworten nicht immer konsistent mit dem sind, was sie zuvor im Gesprächsverlauf gesagt haben, oder dass es ihnen an Weltwissen und allgemeinen Verständnis über Zusammenhänge fehlt. Gleichzeitig ist eine Antwort nicht unbedingt „gut“ im menschlichen Verständnis, nur weil sie Sinn ergibt. Wenn Antworten zu unspezifisch sind, stört das den Gesprächsfluss oder wirkt unnatürlich. Phrasen wie „Cool“ oder „Keine Ahnung“ passen auf sehr unterschiedliche Inputs durch den User, sind aber meist nicht wirklich aussagekräftig. Durch sehr generische Antworten wie diese vermeidet der Chatbot aber, dass er etwas komplett Falsches sagt. Ein echter Mensch hingegen kann inhaltsvolle Antworten geben, die sowohl Sinn ergeben als auch kontextspezifisch sind.

Mitsuku: I would try looking at all the clues and maybe ask someone who has solved them before to help. – Ich würde versuchen, mir alle Hinweise anzusehen und dann vielleicht jemanden um Hilfe fragen, der schon einmal eine Lösung gefunden hat.

Beispiel 1: Diese Antwort ergibt Sinn, ist aber wenig kontextspezifisch. Quelle: Interview mit dem Chatbot Mitsuku.

Was unterscheidet Meena von anderen Chatbots? Welche Herangehensweisen an diese beiden Probleme verfolgt das Modell?

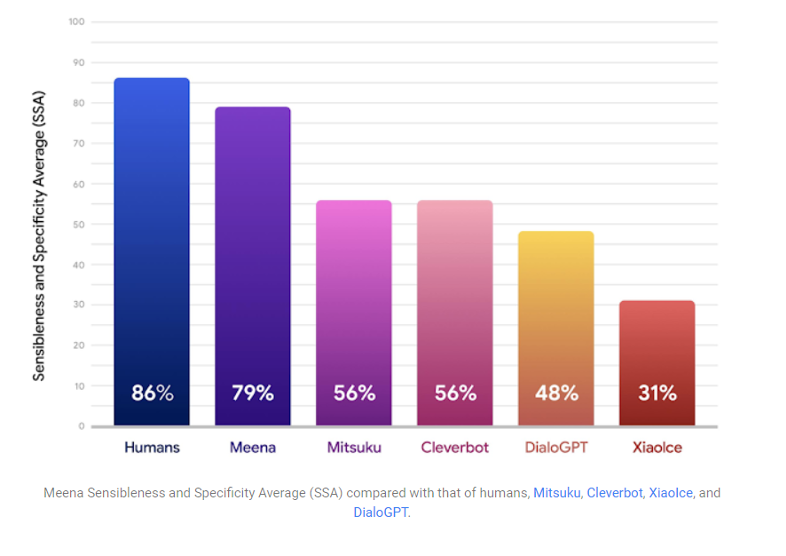

Meena wurde mit 341 Gigabyte an offenen Daten basierend auf Social-Media-Konversationen trainiert. Das Besondere an ihr sind aber nicht nur ihre Datenmengen, sondern die Kriterien, mit der ihre Antworten von menschlichen „Crowdworkern“ bewertet wurden. Google hat zwei Maßstäbe definiert: Sensibilität und Spezifität (Sensibleness and Specificity). Zwei Fragen werden bei der Bewertung von Konversationen gestellt. Erstens: Ist die Antwort sensibel, also passt sie von einem logischen und menschlichen Verständnis her zu dem, was vom User geschrieben wurde, ergibt sie also Sinn? Die BewerterInnen sollten sich dabei auf ihren gesunden Menschenverstand verlassen. Das ist deshalb interessant, weil hierbei eine unterbewusste, menschliche Komponente mit einbezogen wird – denn was Sinn ergibt und was nicht, ist subjektiv. Je mehr Evaluation durch eine diverse Masse an Menschen aber passiert, desto „menschlicher“ werden die Antworten. Das zweite Kriterium bezieht sich auf Spezifität: Bezieht sich die Antwort sehr eng auf das, was der User geschrieben hat, wird Meenas Antwort mit „spezifisch“ bewertet.

Wieso ist Meena ein Durchbruch?

Während Konversationen mit gängigen Conversational Agents aufgrund der Oberflächlichkeit ihrer Antworten häufig schleppender verlaufen und darüber hinaus gerade bei spezifischen Antworten oft fehleranfällig sind, beugt das Modell, das Google bei Meena beschreibt, diesen Problemen vor. Die beiden genannten Kriterien ergeben eine relativ menschliche Mischung: Fehler bei kontextspezifischen Antworten werden minimiert, denn sobald sie zwar spezifisch sind, aber keinen Sinn mehr ergeben, ist die Bewertung insgesamt schlechter. Darüber hinaus erfolgt die Bewertung von vielen verschiedenen Personen, das heißt eine einseitige Betrachtung dessen, was Sinn ergibt oder spezifisch passend ist, wird zunehmend reduziert.

(Grafik: Google)

In Zukunft wird Spracheingabe sich weiter entwickeln und ein breites Anwendungsfeld haben: Verschiedene Menschen, jung und alt, mit unterschiedlichen kulturellen Hintergründen und Wertvorstellungen werden über Sprache mit digitalen Assistenten kommunizieren. Conversational Agents müssen also in der Lage sein, zielgerichtete, sinnvolle und aussagekräftige Antworten zu produzieren, die gleichzeitig verschiedene kulturelle Hintergründe mitberücksichtigen. Bezogen auf den von Google etablierten Durchschnitts-Wert von sensiblen und spezifisch markierten Aussagen (Sensibleness and Specificity Average) erreicht Meena schon jetzt einen Wert von 79 Prozent, während untersuchte menschliche Konversationen auf 86 Prozent kommen. Je menschlicher eine Konversation ist, desto besser funktioniert logischerweise die Kommunikation, was den Weg für Sprachanwendungen und digitale Assistenten weiter ebnet.

Man darf nicht vergessen, dass die beiden Kriterien nur einen kleinen Ausschnitt dessen ausmachen, was die menschliche Sprache sowie den Menschen an sich ausmacht. Nur weil ein Chatbot sehr gut und genau darauf eingehen kann, was das Gegenüber gesagt oder geschrieben hat, bedeutet das nicht, dass diese Technologie insgesamt menschlich ist. Darüber hinaus hat die menschliche Sprache noch viele weitere Feinheiten, die momentan noch nicht gänzlich von Chatbots erfasst werden können. Außerdem ist zu bedenken, dass hinter jedem Chatbot Menschen stehen, die ihn trainieren und somit den Faktor Mensch selbst in die Technologie mit einspeisen. Trotz allem ist Meena ein wunderbares Beispiel dafür, zu was KI schon jetzt fähig ist.

Leider ist die Autorin bei der Übersetzung einem „False friend“ aufgesessen: Die korrekte deutsche Übersetzung von „sensible“ ist nicht „sensibel“ sondern „sinnvoll“. Und „sensibleness“ ist nicht „Sensibilität“ sondern (in diesem Kontext) „Sinnhaftigkeit“.