Großes Google-Update: Gewinner, Verlierer und erste Erkenntnisse

Google-Update. (Bild: Oncrawl)

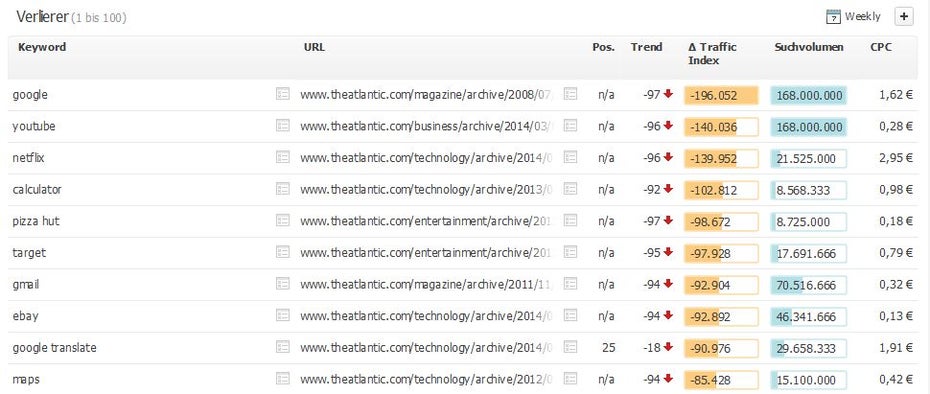

Google-Update: Viele ehemals klassische Printpublisher unter den Verlierern

Wir berichteten letzte Woche, dass Google ein aber auf Twitter klar, dass es nicht das erwartete Penguin-Update sei

Wenige Tage später haben die Suchmaschinen-Experten von Searchmetrics erste Erkenntnisse über den Effekt des Udpates sammeln und auch Gewinner wie Verlierer ausmachen können. Den Daten zufolge habe es einen umfangreichen Wechsel der bestplatzierten Websites unter den Top 100 gegeben: Sowohl unter google.de als auch google.com befänden sich nunmehr 50 Prozent neue Websites in den Gewinner- beziehungsweise Verliererlisten als bisher, so Marcus Tober von Searchmetrics.

Durch das Update haben derzeit vor allem in den USA Publishing-Websites mit Beiträgen zu Marken-Keywords beziehungsweise generischen Keywords mit hoher potenzieller Trafficstärke (Entitäten) stark verloren. In Deutschland sei es in diesem Ausmaß noch nicht festzustellen, was aber unter Umständen damit zu tun haben könnte, dass das Update noch nicht vollständig ausgerollt wurde. Offenbar gehören zu den Verlierern auffällig viele Domains klassischer Print-Publisher – Gewinner hingegen sind Brand-Websites wie audi.de, villeroy-boch.com, telekom.de und alaskaair.com.

The Atlantic gehört zu den großen Verlierern des Google-Updates. (Screenshot: Searchmetrics)

Gewinner des Google-Updates: Websites mit Multimedia-Inhalten und erfülltem User-Intent

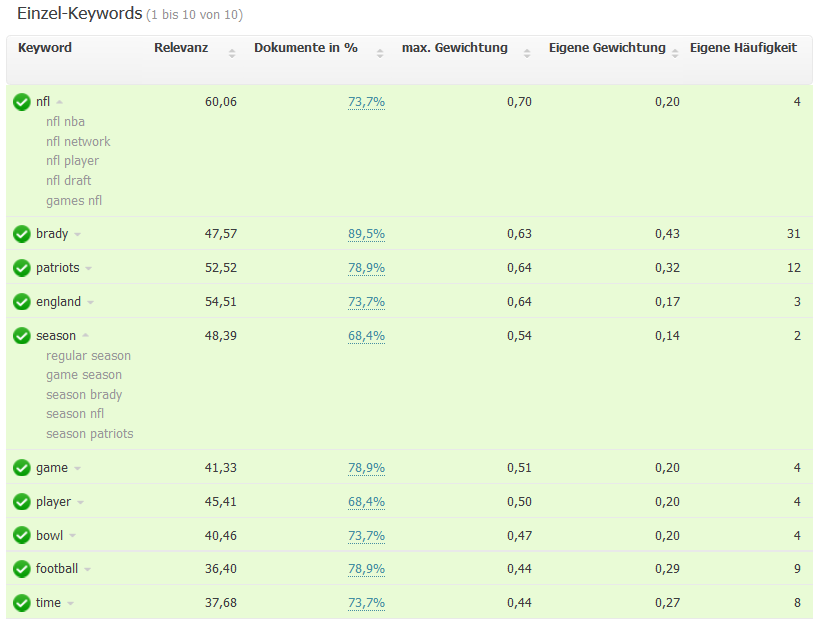

Einige Publisher haben mit dem Update auch ordentlich Auftrieb erhalten. Beispielsweise gq.com konnte vor allem mit seinem Bericht über den Profifootballer Tom Brady, der neben einem Video und zahlreichen Fotos mit über 3.000 Wörtern außerordentlich textlastig ist und viele inhaltliche Themenbereiche abdeckt, viel Boden gut machen. Sprich: Artikel mit hohem Informationsgehalt inklusive einem breiten Spektrum an Unterthemen zum Keyword, die mit Mutimedia-Inhalten angereichert sind, sieht Google gern. Außerdem, so Tober, sei der QDF-Score (Query Deserves Freshness) relevant. Diesen ermittelt Google unter anderem durch die Nachrichtenlage und das Nutzerverhalten. Hier würden in der Regel Themen gewinnen, die eine Newsrelevanz besitzen – beim Tom-Brady-Artikel könnte das der Fall sein, da Anfang Januar von der Superbowl-Saison geprägt ist.

Das Google-Update lässt holistische Inhalte wie den gq-Artikel über Tom Brady im Ranking steigen. (Screenshot: Searchmetrics)

Aber nicht nur Websites, die qualitativ hochwertige Inhalte anbieten, gehören zu dem Gewinnern. Auch Anbieter von „Educational Games“ wie brainpop.com oder mathplayground.com sind im Ranking gestiegen. Interessant sei hier laut Tober, dass diese Seiten kaum aktuelle Inhalte böten, oder viele Keywords abdecken würden.

Es wird vermutet, dass sich diese Seiten vor allem aufgrund der Nutzer-Signale gut positionieren können. Hierzu zählen einerseits die Erfüllung der Nutzerintention: Sucht jemand zum Beispiel nach „How to write a sentence“ und landet auf Brainpop, kann das gefundene Angebot womöglich die Ansicht der Suche erfüllen. Darüber hinaus laden diese Seiten zu einer ungewöhnlich hohen Verweildauer ein:Laut Similarweb beträgt diese durchschnittlich acht Minuten. Die Bounce-Rate – ein nicht zu verachtender Faktor – liegt bei unter 20 Prozent. Weitere Details zum Google-Update findet ihr im Searchmetrics-Blog.

Kurz zusammengefasst: Websites, die Inhalte umfassend und multimedial aufbereiten, gehören tendenziell zu den Gewinnern des Google-Updates. Außerdem spielt außer dem Umfang des Inhalts auch der praktische Nutzen für den User eine Rolle, der offenbar unter anderem durch Verweildauer und Bounce-Rate gemessen zu werden scheint.

Hallo Andreas Floemer,

da (vermutlich) viele Webmaster (ausweislich der zahlreichen Kommentare im WWW) möglicherweise ‚panisch‘ (re-)agieren … gar ‚optimieren‘, könnte dies in diesem Kontext einen ‚Domino-Effekt‘ auslösen … !

Folglich würden immer mehr und mehr andere Webmaster ‚Auswirkungen‘ spüren welche durch dass ‚kopflose‘ Handeln besagter Webmaster überhaupt erst hervorgerufen worden sein könnte.

Wenn dadurch bedingt Webmaster nach Webmaster korrigieren und optimieren, dann würde dass ein (Teufels-)Kreislauf werden der nicht so schnell enden würde.

In diesem Sinne: ‚Don’t panic, nothing’s happened — Google just played with its core.‘

Es gibt immer jemanden der (be-)herrscht und solche die sich beherrschen lassen … man darf nicht vergessen dass Google die Nutzer / Webmaster braucht um zu existieren NICHT umgekehrt – denn es gibt zahlreiche andere Suchmaschinen und Alternativen.

Meine Seite ist dem IT-bereich zuzuordnen und ich habe nun weder profitiert noch sonstige (relevante) ‚Auswirkungen‘ gespürt.

Dass einzige was ich für mich festgestellt habe ist dass sich meine Kommentare auf t3n.de sehr, sehr positiv für mich auswirken – insofern, Google ist NICHT immer der Garant für zielgerichtete Webseitenbesucher.

Ciao, Sascha.

Ich nutze ein Script um die Bounce-Rate zu minimieren. Wenn der Besucher versucht die Seite zu verlassen, wird dass mit dem Script rigoros unterbunden. Was will man mehr…

Hallo Elias,

ich bin ziemlich sicher, dass es nur eine Frage der Zeit ist, bis Google auch auf sowas reagiert und merkt, dass sie hier veralbert werden.

Zumal das – genau wie grep schreibt – nichts mit Nutzerfreundlichkeit zu tun hat, sondern ausschließlich nervig ist!

Gruß, Christian

Das halte ich für fragwürdig, zumindest im hohen Maß user-unfreundlich. Einen Reisenden sollte man nicht aufhalten und wenn mich eine Seite script-technisch mit irgendwelchen Methoden penetriert um mich am Verlassen zu hindern, komme ich persönlich definitiv nicht wieder und über ein solches Erlebnis erzähle ich auch und das ich das nicht gut finde ;)

Ich glaube auch Elias, mit solchen Methoden kommt man nicht weit!

Hallo Elias,

viele (ihrer) Webseitenbesucher mögen sich ’so‘ überreden / nötigen lassen auf der (ihrer) Webseite (weiterhin) zu bleiben … andere NICHT – die kommen ggf. nie wieder !

Ich (z. B.) hasse (insbesondere penetrante) grafische Werbung …, Textlinks u. ä. stören mich hingegen wenig(er) bis gar nicht.

Und gerade deshalb möchte ich meine Webseitenbesucher nicht mit solchen Methoden ‚belästigen‘ – wer mich wirtschaftlich unterstützen möchte kann spenden !

Es gibt zahlreiche Möglichkeiten schnell, legal und illegal, viel Geld zu machen … aber Geld ist nicht mein primäres Ziel.

Lange, nervige und ständige Werbeblöcke im TV welche die Sendung(en) unterbrechen, führ(t)en – bei mir – dazu dass ich (u. U.) ab- resp. umschalte.

Dass ist es was Werbetreibende (scheinbar) nicht verstehen, Werbung nervt – dass wichtigste an Werbung ist also dass diese NICHT nervt.

Ciao, Sascha.

Ist das jetzt was neues, dass Google qualitativ und quantitativ hochwertige Inhalte priorisiert? Vielleicht liegt es doch einfach daran, dass Google mehr Wert auf Verschlüsselung durch https legt und dadurch findet eine Neupositionierung etlicher Seiten statt. Die angesprochenen Faktoren im Artikel haben schon immer Einfluss auf die Position gehabt. So war zumindest meine Meinung, aber ich lasse mich gerne eines Besseren belehren.

Grüße

(d)omi

Hallo grosssmutttr,

tatsächlich ist HTTPS einer von (sehr) vielen (SEO-)Faktoren; Google gewichtet diesen aber nicht sonderlich hoch.

Leider drückt Verschlüsselung die Geschwindigkeit der Webseite ein wenig (nach unten) sodass sich dies minimal negativ auswirken könnte.

Wer ein domainvalidiertes SSL- / TLS-Zertifikat benötigt resp. einsetzen möchte erhält dieses von einigen Anbietern kostenfrei.

Sie brauchen allerdings physikalischen Zugriff auf ihren (Web-)Server um betreffendes Zertifikat zu implementieren.

Ciao, Sascha.

Hi Sascha,

aus eigener Erfahrung kann ich sagen, dass bei einem schnellen Server ein https-Zertifikat eine beachtliche Steigerung der Besucherzahlen und somit auch dem Google-Rang führt.

Wenn du mir einen Anbieter nennen kannst, bei dem ein von allen Browsern akzeptiertes https-Zertifikat kostenfrei ist, wäre ich sehr froh?

Grüße

(d)omi

Hallo grosssmutttr,

kostenlose, domainvalidierte SSL- / TLS-Zertifikate gibt’s hier: https://www.startssl.com resp. https://letsencrypt.org !

Ciao, Sascha.

Ich habe noch keine Veränderungen durch das https Zertifikat gemerkt

Hallo grosssmutttr,

ich hatte gestrig, kurz nach Deiner Anfrage, einen entsprechenden Kommentar mit zwei Links abgegeben, welcher hier bis dato aber noch nicht veröffentlicht worden ist, ggf. weil Kommentare, die nicht sofort freigegeben werden, nur werktags, tagsüber moderiert werden.

Daher füge ich die besagten Links hier nochmal, allerdings nicht als echte Hyperlinks an:

1. StartSSL(.com).

2. Let’sEncrypt(.org).

Ciao, Sascha.

Hi Sascha,

das sieht ja gar nicht schlecht aus. Vielen Dank für die Links!

Hallo grosssmuttr,

kein Problem, gern geschehen.

Meine Mottos:

1. ‚The best things in life are free‘ .

2. ‚Life is binary you either a one or a zero‘.

3. ‚Less is more‘

4. ‚Keep it stupid simple.‘

Google und selbsternannte Suchmaschinenoptimierer ‚predigen‘ viel wenn der Tag lang ist … und wenn eine falsche Aussage logisch dargestellt wird dann erscheint sie auch richtig … wird demnach immer und immer wieder wiederholt … bis sie quasi als ‚die Lösung‘ glorifiziert wird.

Man sollte nicht alles glauben was man liest egal wie seriös die Quelle(n) ist / sind; um SEO hat sich ein florierender Markt gebildet der von der Unwissenheit und dem Unvermögen der Webmaster lebt.

Man sollte sich immer seine eigenen Gedanken machen und alles anzweifeln; es lohnt sich konsequent, paranoid dagegen zu sein wenn man tatsächlich richtig (mit seinen Vermutungen) liegt.

Eine Webseite sollte (primär) schnell sein und entsprechend ausgezeichnet (mit HTML) sein – schau Dir mal meinen Quellcode an !

Anstatt (nur) Backlinks zu setzen oder (ominös) zu kaufen lieber abgelaufene Domains (mit vielen guten Backlinks) ganz regulär über den Registrar erstehen.

Suchmaschinen sehen Webseiten als Text – der Rest ist gewissermaßen unwichtig … egal was hier und da erzählt wird.

Meine Webseite hat derzeit rund 1000 hochwertige Backlinks und besteht nur aus einer sehr ausschweifenden Anleitung zur Benutzung des unixoiden Werkzeug ‚(GNU) grep‘ und ist dennoch (relativ) gut im hart umkämpften Umfeld meiner Mitbewerber platziert.

Meine Seite nutzt kein CMS, kein PHP sondern lediglich HTML(5) und CSS (extrem minifiziert).

Das Suchvolumen zu ‚GNU grep‘ bzw. ‚grep‘ ist natürlich sehr gering aber für mich ist diese Webseite ein Prestige-Projekt.

In Googles Pagespeed-Test schneide ich in der Desktop-Version mit 100/100 ab; auf mobile Geräte habe ich nicht optimiert – meine Besucher kommen größtenteils über Textbrowser.

Also nicht dem Mainstream folgen, selber denken.

Ciao, Sascha.