Microsoft zieht sich aus ethischen Gründen aus der Gesichtserkennung zurück

Das Unternehmen in Redmont hat sich neue Verhaltensregeln in Sachen künstlicher Intelligenz auferlegt. (Foto: Shutterstock)

Microsoft stellt neue Regeln für den Umgang mit künstlicher Intelligenz auf. Die „Responsible AI Standards“ haben eine gründliche Überarbeitung erfahren. Sie mündet unter anderem darin, dass das Unternehmen bestimmte Dienste nur noch begrenzt zugänglich macht, andere stellt es ganz ein. Es macht dazu eine Reihe von Regelwerken öffentlich und erklärt die zugrundeliegenden Prozesse in einem Video.

Regelwerk soll KI-Entwicklung verantwortungsvoller machen

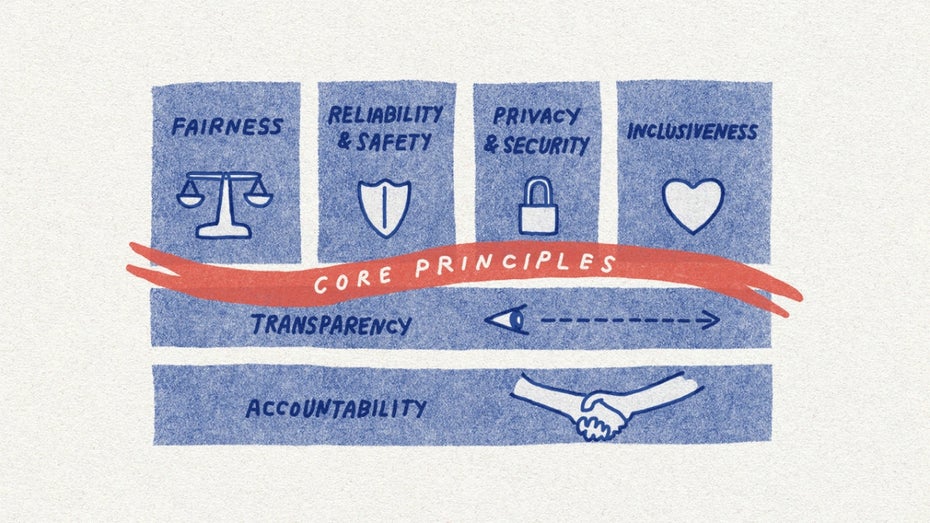

Natasha Crampton, die „Chief Responsible Officer“ bei Microsoft, stellt das neue Regelwerk in einem Blogbeitrag vor. Dabei handelt es sich um konkrete Zielvorgaben in den Bereichen Rechenschaft, Transparenz, Fairness, Zuverlässigkeit, Datenschutz und Inklusion. Die beiden Punkte Zuverlässigkeit und Datenschutz enthalten den Zusatz „und Sicherheit“. Das 26 Seiten starke Dokument (Download) identifiziert Unterkategorien, formuliert dafür Ziele und Vorgaben, wie diese zu erreichen sind. Dabei deckt es den Bereich vor, während und nach der Softwareentwicklung ab.

Stimmenimitation „Neural Voice“ an der kurzen Leine

Crampton schreibt, der Konzern habe neben dem Katalog für richtiges Handeln auch mehrschichtige Kontrollsysteme eingeführt. Als Beispiel nennt sie „Azure AI’s Custom Neural Voice“, das eine synthetische Stimme erzeugt, die dem Original zum Verwechseln ähnelt. Microsoft begrenzt den Kundenzugang, definiert akzeptable Anwendungsfälle und kommuniziert technische Regeln, um sicherzugehen, dass der:die Sprecher:in auch aktiv bei der Erstellung mithilft. So soll der Missbrauch des Stimmsystems vermieden werden.

Microsoft hat für bestimmte Bereiche Ziele definiert. Ihnen liegen bestimmte Prinzipien zugrunde. (Grafik: Microsoft)

Emotionen-Tracking bei Gesichtserkennung eingestellt

Ähnliche Kontrollstufen sind auch bei den Gesichtserkennungsdiensten geplant: Nur noch spezielle Kund:innen und Partner:innen dürfen in eingegrenzten und fest definierten Fällen Zugang haben und der wird umfassend technisch kontrolliert. Bestimmte Funktionen von Azure-Face stellt Microsoft ganz ein. Dazu gehören alle, die das Erkennen von emotionalen Zuständen und von Identitätsmerkmalen wie Geschlecht, Alter, Haare und Make-up ermöglichen. Crampton weist darauf hin, dass es keinen wissenschaftlichen Konsens über „Emotionen“ gibt. Zudem sei es schwierig, „Schlussfolgerungen über verschiedene Anwendungsfälle, Regionen und Bevölkerungsgruppen hinweg zu verallgemeinern“. Man wolle auch andere KI-Systeme, die angeblich auf den emotionalen Zustand von Menschen schließen können, auf den Prüfstand stellen.

Folgenabschätzung und Transparenzhinweise

Microsoft veröffentlicht außerdem die bisher interne Vorlage, um Folgen abzuschätzen. Die Folgenabschätzungen setzt das Unternehmen bereits in der Frühphase ein, um den beabsichtigten Nutzen und die potenziellen Schäden abzuwägen. Auch andere Prüfschritte stellt der Konzern der Öffentlichkeit zur Verfügung, etwa einen Leitfaden und eine Sammlung von Transparenzhinweisen. Crampton spricht von einem ersten Schritt in Richtung verantwortungsvolle KI. Microsoft verpflichte sich zu Offenheit, Ehrlichkeit und Transparenz „in unseren Bemühungen, sinnvolle Fortschritte zu erzielen“.