SEO-Audit: So erkennst du schlechte Backlinks

Dank zahlreicher Backlink-Tools wird es immer einfacher, das Backlink-Profil der eigenen Seite im Blick zu behalten. Dennoch hat sich diese Praxis noch längst nicht bei jedem Seitenbetreiber durchgesetzt. Das liegt unter anderem daran, dass nicht jeder Webmaster das Budget hat, um Experten damit zu beauftragen. Diese Anleitung soll euch dabei helfen, einen Linkaudit selbst durchzuführen.

Warum ist ein Linkaudit wichtig?

Backlinks gehören zu den wichtigsten Rankingfaktoren einer Seite. Doch nützlich sind sie nur, wenn sie von Google auch als hochwertig angesehen werden. Schlechte, unnatürliche Backlinks hingegen können einer Seite schaden – beispielsweise durch eine manuelle oder eine algorithmische Abstrafung. In seinen Qualitätsrichtlinien erklärt Google, welche Methoden beim Linkaufbau unerwünscht sind. Webmaster können sich unter dem Punkt Linkaufbau darüber informieren, welche Praktiken gegen die Richtlinien verstoßen.

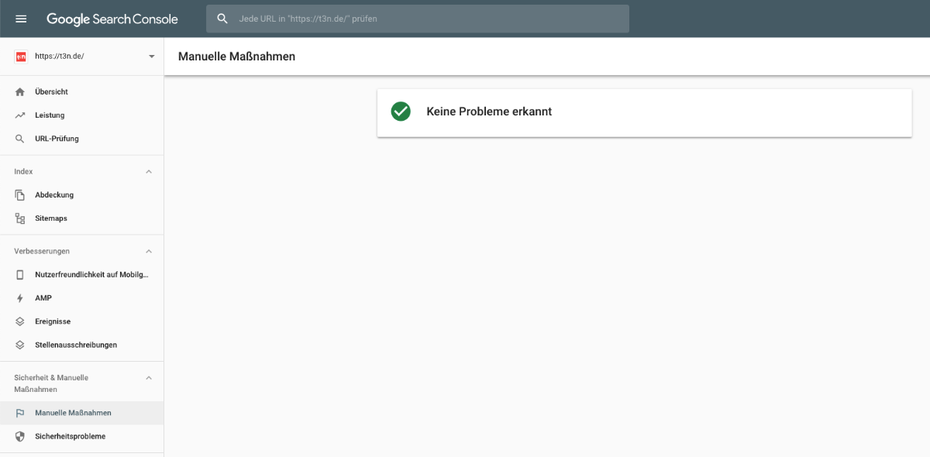

Ein solcher Verstoß kann eine manuelle Abstrafung durch das Spam-Team von Google nach sich ziehen. Webmaster werden in der Google Search Console unter dem Punkt Sicherheit und Manuelle Maßnahmen darüber informiert, ob eine Abstrafung erfolgt ist. Voraussetzung ist jedoch, dass Seitenbetreiber ihre Seite mit der Search Console verknüpft haben (was ohnehin jeder tun sollte).

Die Google Search Console informiert Seitenbetreiber über etwaige manuelle Maßnahmen. (Screenshot: Google Search Console)

Mit dem sogenannten Penguin-Update, das im April 2012 ausgerollt und im Oktober 2016 in den Kernalgorithmus von Google aufgenommen wurde, geht Google auch algorithmisch gegen Verstöße gegen die Qualitätsrichtlinien vor. Solche Abstrafungen sind nicht aus der Search Console ersichtlich, sondern zeigen sich üblicherweise in einem starken Sichtbarkeitsverlust und Traffic-Rückgang.

Mit regelmäßigen Backlink-Audits können Seitenbetreiber solche Probleme identifizieren und beheben.

Linkaudit: In 4 Schritten negative Backlinks identifizieren

Ein Linkaudit ist nicht so kompliziert, wie es vielleicht auf den ersten Blick erscheint. Er ist in vier relativ einfachen Schritten erledigt.

1. Linkdaten sammeln

Im ersten Schritt müssen zunächst alle Backlinks und Linkdaten zusammengetragen werden. Über nahezu alle SEO-Tools können Webmaster eine mehr oder minder vollständige Auflistung ihrer Backlinks abrufen. Besonders empfehlenswert sind spezialisierte Anbieter, beispielsweise Ahrefs oder Majestic. Wie viele Links diese Anbieter finden, ist allerdings stark vom verwendeten Tool und dessen Index abhängig.

Eine kostenlose – aber ebenso unvollständige – Alternative bieten die Google-Webmaster-Tools. Unter dem Menüpunkt Links können Webmaster eine Auswahl der von Google identifizierten Backlinks als Tabelle herunterladen. Für einen möglichst umfassenden Einblick ins eigene Linkprofil sollten Webmaster die Linkdaten von mehreren Quellen nutzen.

2. Linkdaten säubern und ordnen

Als nächstes gilt es, die Linkdaten aus allen Quellen zu kombinieren und Dopplungen zu entfernen.

Mithilfe von zwei kostenlosen Tools werden anschließend Aktualität und Qualität geprüft.

- Scrapebox Dofollow Test: Das kostenlose Addon für Scrapebox hilft dir bei der Identifikation von Dofollow- und Nofollow-Links. Da letztere nicht relevant sind, können sie einfach aussortiert werden.

- Scrapebox Backlink Checker: Mit diesem zweiten kostenlosen Addon für Scrapebox wird der Statuscode der verlinkenden Webseite abgerufen. Ist sie nicht mehr erreichbar, kann sie ebenfalls aus der Liste entfernt werden.

Jetzt ist die Übersicht der Backlinks soweit vorbereitet, dass mit der eigentlich Analyse und Bewertung begonnen werden kann.

3. Analysieren der Backlinks

Bei der Analyse der verbliebenden Links können verschiedene Merkmale herangezogen werden, die schwache Links ausmachen. Aufgrund der schieren Menge ist eine detaillierte Analyse jedes einzelnen Backlinks kaum möglich. Idealerweise prüfen Webmaster deshalb schrittweise die folgenden Kriterien, sortieren qualitativ hochwertige Links aus und fokussieren sich anschließend auf die verbliebenen, minderwertigen Links.

Es ist unmöglich, eine wasserdichte Grenze zwischen minder- und hochwertigen Links zu ziehen. Wer dieser Anleitung folgt, braucht deshalb etwas Bauchgefühl und Erfahrung. Wer sich unsicher ist, kommt nicht darum herum, etwas Geld in die Hand zu nehmen und einen Experten zu beauftragen.

An diesen Kriterien lässt sich die Qualität eines Links erkennen:

- Pagerank: Der Pagerank ist schon lange kein Rankingfaktor mehr, hilft aber, in kurzer Zeit die stärksten Backlinks zu identifizieren.

- Spam-TLD: Manchmal ist schon die Top-Level-Domain (TLD) das erste Indiz eines minderwertigen Links. Für lange Zeit waren beispielsweise russische Links (.ru) ein günstiges und beliebtes Mittel. Sie sollten nicht automatisch auf deiner Blacklist landen, aber genauer untersucht werden.

- Titel der Webseite: Der Titel einer Webseite macht schnell die thematische Nähe deutlich. Ist ein Zusammenhang vollkommen abwegig, sollte reagiert werden. Auch Google weiß, dass ein natürlicher Link eine gewisse thematische Nähe voraussetzt.

- Ankertext: Wer Linkdaten über ein SEO-Tool bezieht, kennt auch dessen Ankertext. Wenngleich das nicht automatisch ein K.-o.-Kriterium ist, sollten bei vielen harten Ankertexten die Warnlampen angehen. Wenn 60 Prozent der Links auf eine Kategorieseite deren Titel als Ankertext tragen, ist das kein gutes Zeichen.

- Autorität der Website: Nahezu jedes SEO-Tool definiert die Autorität einer Website über andere Kennzahlen, doch das ist vernachlässigbar. Die Kennzahlen helfen bei einer ersten Analyse, die ungewöhnlich starken und schwachen Ausreißer wahrzunehmen.

- IP-Adresse:Wurden durch die vorherigen Recherchen erste Indizien für ein Linknetzwerk gefunden? Dann sollte zumindest geprüft werden, ob ein auffällig großer Teil der verlinkenden Websites die gleiche IP-Adresse hat.

Manche der oben genannten Kriterien können über kostenpflichtige SEO-Tools bezogen werden. Die grundlegenden Informationen, beispielsweise Pagerank und Seitentitel, lassen sich über „SEOTools für Excel“ abrufen. Wer das kostenlose Excel-Addin noch nicht kennt, sollte es unbedingt ausprobieren.

4. Aussortieren der Backlinks

Die besprochenen Kriterien dienen als erster Anhaltspunkt, mehr nicht. Nur in absolut eindeutigen Fällen sollte ein Link aufgrund schlechter Werte aussortiert werden. Der Regelfall ist eine zweite manuelle Prüfung.

Folgende Indizien können dir helfen, zwischen guten und schlechten Backlinks zu entscheiden:

- Ist die Website über Google erreichbar? (Abfrage: „site:webseite.de“). Ist das nicht der Fall, sollte auch der robots.txt geprüft werden. Helfen kann dabei beispielsweise das Robots.txt.-Test-Tool von Ryte. Sollte die Seite eigentlich indexiert sein, ist das ein schlechtes Zeichen.

- Außerdem sollte man sich die verlinkende Seite anschauen und sich dabei folgende Fragen stellen: Handelt es sich um eine hochwertige Webseite mit eigenen Inhalten? Wurde der Link an einer inhaltlich sinnvollen Stelle mit thematisch relevantem Kontext platziert? Falls nicht, gibt es einen triftigen Grund für die ungewöhnliche Platzierung? Können alle Fragen mit einem klaren „Nein“ beantwortet werden, sollte der Link rausfliegen.

- Handelt es sich um einen bezahlten Link? Dreht sich auf der Website alles um Schuhe, in diesem einen Beitrag ist jedoch von ganz anderen Themen die Rede, ist das ein schlechtes Zeichen.

Einen groben Überblick über die verschiedenen Linkarten und ihre Wertigkeit für Google gibt Ahrefs im hauseigenen Blog. Je erfahrener du bist, desto einfacher wird dir dieser Schritt fallen. Bist du dir bei einigen Links unsicher, erspare dir die Ungewissheit und kontaktiere einen SEO-Experten. Sicher ist sicher, erst recht bei einem derart heiklen Thema.

Dieser Artikel wird regelmäßig aktualisiert. Autor des Originalartikels ist Lars Budde.

Nutze Seerobots auch, ist ein Super plugin :)

Mit Firefox 29 ist leider die Addonleiste verschwunden, die für dieses Plugin notwendig ist.

Lösung dafür gibt es hier: http://www.hoffmanoid.de/2014/04/29/addonleiste-im-firefox-29-wiederherstellen/

Schon sehr bedenklich wie man sich von Google vorführen lässt. Da „spricht“ Google ein Machtwort und schon versuchen tausende von verzweifelten SEO’s das umzusetzen. Es gibt Anleitungen, siehe hier, wie man es am besten macht. Und unzählige Stunden werden in die von Google gewünschte „Bereinigung“ investiert. Wenn so viele schlechte Links existieren, sollte nicht Google sein Strategie überdenken? Nein, es wird auf uns alle abgewälzt. Wir alle arbeiten für Google. Wer nicht hört, wird eben bestraft und bekommt keinen Platz unter den ersten SERPs. Google ist nicht nur eine Suchmaschine, sondern auch ein Machtfaktor nach dem sich alle richten sollen (müssen). Sehr bedenklich!

Schade, dass kein Download für den Mac angeboten wird.

Grüße

Ulrich Eckardt

Link Audit ist definitiv wichtig, um schwache oder ggf. Bad Content Backlinks loszuwerden. Ich benutze selber auch die Tools von Scrapebox, den DoFollow Test und den Backlink Checker. Viele SEO Agenturen übersehen leider den Link Audit und gehen Bad Content bzw. schwachen Backlinks gar nicht erst nach – obwohl man diese doch wirklich los werden kann.

Bedenklich ist die Abstrafung allemal, wenn man wie Alfred die Analogie des Ganzen betrachtet. Lasse ich über Jahre zu, dass sich gewisse Handlungsweisen einschleichen (ob sie nun unbedenklich sind sei mal dahingestellt ^^), und belohne sie sogar (etliche Seiten mit dumpfem Backlink-Portfolio in den oberen Serps) ist es schon aberwitzig nicht den Algorithmus sondern primär die ‚betriebliche Übung‘ hart anzugehen.

Nunja, Algorithmus in den Kinderschuhen oder nicht, letztlich gehts ums Geld.

Nofollow links können einfach aussortiert werden weil sie nicht relevant sind ??

Mutige Aussage, die überprüft werden sollte :D

Nofollow Links mögen vielleicht keinen Autorität vererben, aber dennoch können sie – von den richtigen Seiten platziert – durchaus einen positiven Effekt auf die Seite haben. Das wird oft in einem falschen Zusammenhang dargestellt. Sie in einem Audit nicht zu berücksichtigen bzw. auszuschließen kann aber Sinn machen.