Weg mit der Blackbox: Wie erklärbare KI zum Wettbewerbsvorteil wird

Dem Potenzial von KI sind keine Grenzen gesetzt. (Foto: Gorodenkoff / Shutterstock)

Spätestens seit der Veröffentlichung von ChatGPT im November 2022 ist das Potenzial von KI in aller Munde. Unternehmen suchen fieberhaft nach Wegen, um es auch für ihre Zwecke zu nutzen. Doch das ist angesichts des IT-Fachkräftemangels und der auf uns zukommenden KI-Regulierung nicht so einfach.

Dabei sind es gerade die aktuellen Errungenschaften in generativer KI wie ChatGPT, Midjourney und Co., die auch nicht-technische Fachkräfte dazu befähigen, ihre Jobs durch hoch individualisierbare Automatisierungen effizienter auszuüben. Im Grunde ist es schon vorgezeichnet: Über kurz oder lang werden wir alle von reinen KI-Konsument:innen zu Produzent:innen von KI-Automatisierungen aufsteigen. Anders gesagt: In wenigen Jahren wird KI überall (enthalten) sein und von uns allen aktiv mitgestaltet werden.

Wer behält den Überblick?

Bislang wurden KI-Systeme von Entwickler:innen für Entwickler:innen produziert. Doch schon jetzt kommen auch die Nutzer:innen und Anbieter von KI-Lösungen hinzu und verlangen Erklärungen, warum ein System eine bestimmte Entscheidung getroffen hat.

Zwei Fälle aus der jüngeren Vergangenheit zeigen, wie problematisch KI-Systeme sein können: Microsofts KI-Chatbot Tay äußerte sich sexistisch und rassistisch, nachdem er von Internet-Bots auf Twitter getrollt wurde. Amazons automatisierte HR-KI generierte Empfehlungen mit starkem Bias pro weiße Männer. Und diese zwei Beispiele sind vermutlich nur die Spitze des Eisbergs. Weil wir nicht wissen, welche Probleme sich noch unter der Meeresoberfläche befinden, brauchen wir bestmögliche Einsichten in die Funktionsweise von KI-Systemen.

Deshalb werden schon jetzt – und in Zukunft noch stärker – gesetzliche Vorgaben eine entscheidende Rolle bei der Entwicklung von KI spielen. Auch die Fragen verändern sich, die Menschen an KI-Systeme stellen. Ein Entwickler will wissen: Hat das Modell technischen Einschränkungen, die ich beachten muss? Aber diese Frage würde eine Nutzerin nicht stellen. Für sie ist wichtig, ob sie die Ergebnisse des Modells nachvollziehen und produktiv nutzen kann. Regulatoren wiederum wollen wissen, ob das Modell und die Art und Weise, wie es verwendet wird, mit den rechtlichen Anforderungen vereinbar ist.

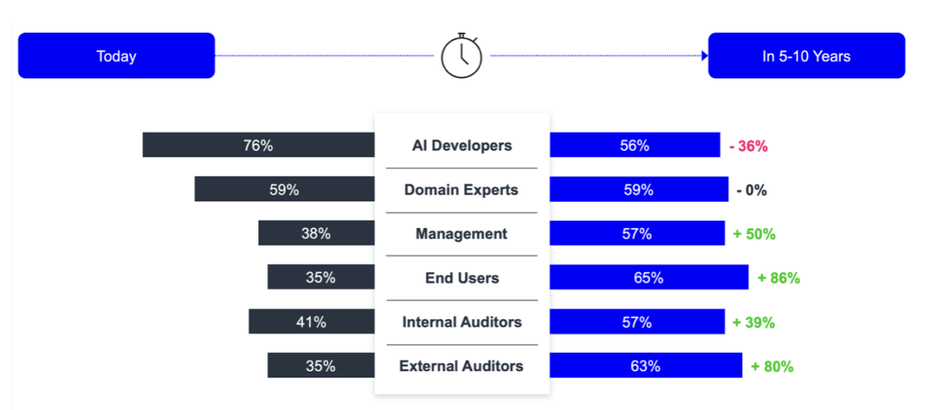

Aktuell wird KI von Entwickler:innen für Entwickler:innen gebaut. Aber insbesondere Endnutzer:innen und externe Regulator:innen werden in fünf bis zehn Jahren die größten Nachfrager:innen von KI-Systemen. (Grafik: Kraus et al., 2021. „Erklärbare KI: Anforderungen, Anwendungsfälle und Lösungen“)

Kurz gesagt: KI-Lösungen erfordern künftig ein anderes Stakeholder:innen-Management, als es heute der Fall ist. Ein System muss viel mehr Fragen von viel mehr Menschen beantworten können. Gleichzeitig muss es individualisierter auf diese unterschiedlichen Gruppen angepasst sein.

Eine vom Bundesministerium für Wirtschaft und Energie beauftragte Studie zeigt, dass das Bedürfnis nach erklärbarer KI in den nächsten fünf bis zehn Jahren vor allem beim Management, den Nutzer:innen und den Prüfstellen zunehmen wird. Und mit dem AI Act werden all diese Gruppen auch das Recht auf Antworten auf ihrer Seite haben.

Erklärbarkeit ist bares Geld

Aber KI erklärbar zu machen ist mehr als eine gesetzliche Auflage, deren Missachtung Unternehmen teuer zu stehen kommen kann. Vielmehr eröffnen sich gewaltige Profitchancen für Unternehmen, wenn sie ihre KI-Systeme besser verstehen. Der Geschäftswert, den zusätzliches Datenwissen liefert, ist immens. Mit der reinen Prognose einer Verkaufszahl durch eine KI kann ein Unternehmer wenig anfangen, wenn er eine Entscheidung treffen muss. Er wird sich dann zum Beispiel fragen, welche Faktoren die Vorhersage beeinflusst haben und wie sicher sich die KI ihrer Prognose ist. Genau das beantwortetet erklärbare KI und ermöglicht so evidenzbasierte Entscheidungen.

Gleichzeitig zahlt ein Unternehmen damit auf das ein, was Nutzer:innen am wichtigsten ist: Vertrauen und Transparenz. Eine Studie hat ergeben, dass Erklärungen das Vertrauen der Nutzenden in die KI erhöhen. Und das sogar, wenn die KI bekanntermaßen einen Bias hat.

In Zukunft wird die Ausbreitung von KI also auf höhere Erwartungen an ihre Erklärbarkeit treffen. Deshalb bedarf es auch eines ganzheitlichen Ansatzes, um KI für verschieden Stakeholder:innen erklärbar zu machen. Genau dieser Gedanke steht hinter dem noch jungen Feld Explainable AI (XAI), also erklärbare KI. XAI ist das Mittel, das alle Stakeholder:innen an der KI-Transformation beteiligt – und gleichzeitig große wirtschaftliche Potenziale bietet. Aber XAI ist nicht gleich XAI. Erst durch die geeigneten Methoden und eine zielgruppengerechte Darstellung entstehen diese Vorteile.

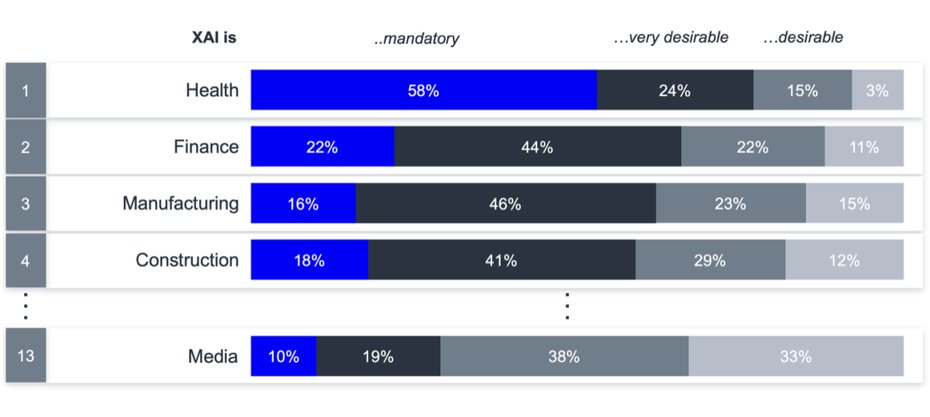

Schon heute ist Erklärbarkeit für einen Großteil der KI-Systeme in vielen Branchen rechtlich verpflichtend. Mit dem AI Act wird dieser Anteil in allen Branchen wachsen. Und selbst wenn es nicht verpflichtend ist, bedeutet „very desirable“, dass KI-Modelle nur mit XAI überhaupt auf den Markt kommen. (Grafik: Kraus et al., 2021. „Erklärbare KI: Anforderungen, Anwendungsfälle und Lösungen“)

Erklärbarkeit hat viele Gesichter

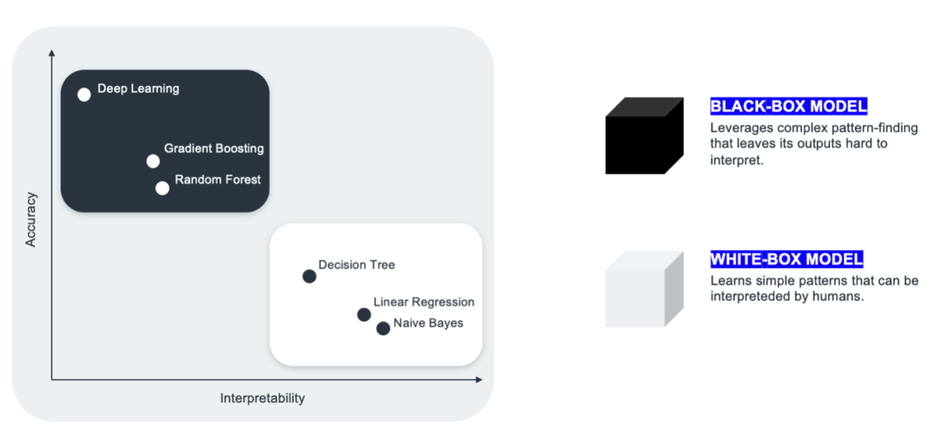

Das Forschungsfeld erklärbare KI hat sich gebildet, um zu beantworten, welche Art von Erklärung benötigt wird, damit ein KI-System als vertrauenswürdig und nachvollziehbar angesehen wird. Denn mit zunehmender Komplexität der Aufgaben, die KI-Systeme bearbeiten sollen, steigt auch die Komplexität der Modelle. Wenn heute oft von sogenannten Blackbox-Modellen die Rede ist, dann ist genau das gemeint: ein KI-System, dessen Rechenoperationen und Prozesse wie in einer schwarzen Box versteckt sind.

Das Problem: Nur solche Blackbox-Modelle können die wirklich komplexen Aufgaben, durch die KI die heute so gefeierten Durchbrüche erreicht, auch lösen. Ihre Pendants, Whitebox-Modelle, sind zwar leicht nachvollziehbar für Menschen, aber aufgrund der simplen Rechenoperationen auch nur für simple Aufgaben nutzbar.

Im Kontrast zu Blackboxen sind die Ergebnisse von Whitebox-Modellen für Menschen sehr gut nachvollziehbar. Allerdings können sie nur simple Aufgaben lösen. (Grafik: Statworx)

Welche Erklärbarkeit brauchen wir?

Stand heute ist XAI ein Feld für Akademiker:innen und Entwickler:innen. Für sie sind komplexe Grafiken, Wahrscheinlichkeitstabellen und statistische Tests relevant; für alle anderen Stakeholder:innen allerdings meist unverständlich und unwichtig.

Wie schaffen wir es nun, Erklärbarkeit größer zu denken und alle Beteiligten angemessen anzusprechen? Dafür müssen wir unsere Definition von Erklärbarkeit erweitern. Sie ist mehr als ein objektiv messbares Gütekriterium. Genau wie ein KI-Modell immer in einen Kontext von anderen Technologien, Arbeitsprozessen und Menschen eingebettet ist, müssen auch seine Erklärungen einen Kontext mitliefern.

Ein KI-Modell, das aus Rechnungen bestimmte Einzelposten extrahieren kann, löst noch kein Problem. Es kann aber Teil einer Lösung sein, wenn diejenigen, die Rechnungen verarbeiten müssen, daraus einen Nutzen ziehen – zum Beispiel weil das Modell sich nahtlos in die vorhandene digitale Infrastruktur integrieren lässt, Ressourcen einspart und neue Informationen liefert.

Wir sollten XAI deshalb als Kommunikationsmedium betrachten. Eine Erklärung, die ein KI-Modell isoliert und ohne Kontext betrachtet, ist wie der Versuch, Schach zu erklären, indem man nur das Bewegungsmuster des Springers beschreibt. Nur eine ganzheitliche Erklärung des Spiels macht es für Menschen nachvollziehbar – und schafft so Transparenz, Vertrauen und die Bereitschaft, mitzuspielen. Alle dazugehörigen Technologien, Prozesse und betroffenen Personengruppen müssen einbezogen werden. Nur so erhalten auch alle beteiligten Personen geeignete Erklärungen und maßgeschneiderte Unterstützung.

KI ist Teil unserer Welt – und muss so behandelt werden

Erklärungen haben eine soziale Funktion. Menschen benötigen Wissen über ihre Umwelt, um kluge Entscheidungen zu treffen. Nur ein ganzheitlicher XAI-Ansatz kann diese soziale Funktion von Erklärbarkeit ernsthaft berücksichtigen. XAI trägt dazu bei, dass Menschen selbstwirksam mit KI umgehen können. Damit werden Erklärungen zum Ausgangspunkt fürs eigene Denken.

XAI schreibt keine bestimmte Interpretation und Konsequenz vor, sondern befähigt alle, die Fragen an KI stellen wollen und müssen, zu entscheiden: Brauche ich hier eine vollständige Erklärung des KI-Systems oder muss ich nur die Einschränkungen und Risiken eines Modells kennen?