Lokale KI statt ChatGPT: So einfach bringt ihr einen Chatbot auf euren Rechner

Der massive Erfolg von ChatGPT hat auch dazu geführt, dass viele Firmen Regeln für den Umgang mit dem KI-Tool aufgestellt haben. Apple beispielsweise soll Medienberichten zufolge Anfang 2023 ein generelles ChatGPT-Verbot erlassen haben. Der Konzern wolle so sicherstellen, dass keine sensiblen Informationen das Unternehmen verlassen.

Dank quelloffener KI-Modelle wie Llama 2 von Meta, Stable LM von Stable Diffusion oder dem französischen Mistral gibt es mittlerweile eine ganze Reihe von Alternativen, die ihr bei Bedarf lokal auf eurem Rechner ausführen könnt. Auf die Art braucht ihr euch dann auch keine Sorgen darüber zu machen, wo eure Eingaben landen könnten.

KI-Chatbot lokal ausführen: So einfach geht es mit Ollama

Das Programm Ollama bietet eine extrem einfache Möglichkeit, große Sprachmodelle lokal auf dem eigenen Rechner auszuführen. Dazu verfügt das Open-Source-Programm über eine Bibliothek von derzeit mehr als 50 großen Sprachmodellen, die ihr direkt über Ollama herunterladen und ausführen könnt.

Ollama ist für macOS, Linux und seit neustem auch für Windows verfügbar. Nach der Installation braucht ihr nur noch das gewünschte KI-Modell auszuwählen, und Ollama lädt euch automatisch die neuste Version herunter und startet eine Konversation mit der KI.

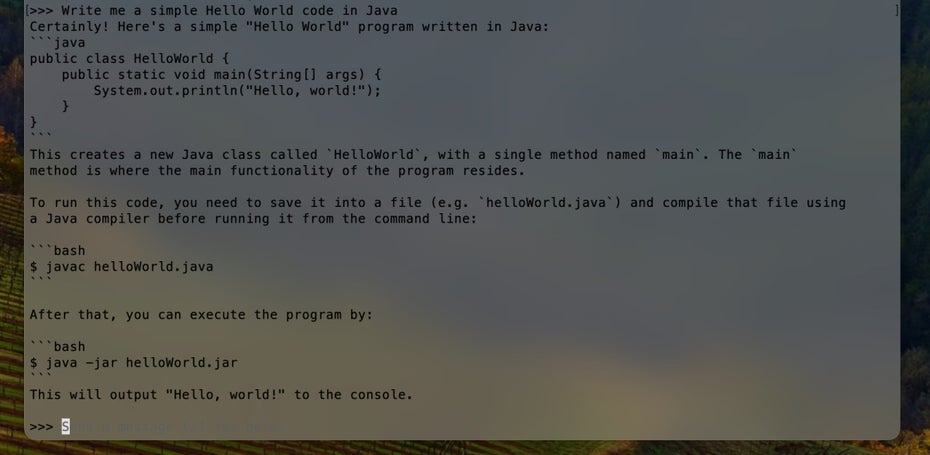

Mit Ollama führt ihr KI-Chatbots lokal auf eurem Rechner aus. (Screenshot: Ollama / t3n)

Dabei ist allerdings zu beachten, dass Ollama nicht über eine grafische Nutzer:innen-Oberfläche verfügt, sondern als Kommandozeilenwerkzeug ausgelegt ist. Immerhin zeigt euch eine Web-Übersicht der verfügbaren KI-Modelle direkt den Befehl an, mit dem ihr das gewünschte Modell ausführt. Ihr könnt das jeweilige Kommando daher auch einfach von dort in den Terminal kopieren. Beim erstmaligen Ausführen des Befehls wird das gewählte Modell dann automatisch heruntergeladen.

Ein Beispiel: Wollt ihr das KI-Modell Mistral installieren und ausführen, reicht die Eingabe ollama run mistral

Neben Modellen, die für die reine Text-Generierung gedacht sind, findet ihr in der Ollama-Bibliothek auch eine Reihe von Modellen, die für die Code-Generierung ausgelegt sind. Beispiele dafür sind codellama, deepseek-coder, stable-code oder wizardcoder.

Kein Bock auf den Terminal? Grafische Benutzeroberflächen für Ollama

Wer sich partout nicht im Terminal mit einem KI-Chatbot unterhalten möchte, hat die Wahl aus einer Reihe von verfügbaren Frontends. Während die meisten davon webbasiert sind, gibt es auch eine Reihe von Desktop-Frontends für Ollama.

Mac-Nutzer:innen, die nach einer simplen Desktop-Oberfläche suchen, können sich beispielsweise Ollamac anschauen. Hier könnt ihr mehrere Chats parallel verwalten und jeweils zum Start einer Konversation festlegen, welches Modell genutzt werden soll. Installieren müsst ihr die Modelle aber nach wie vor über das Terminal.

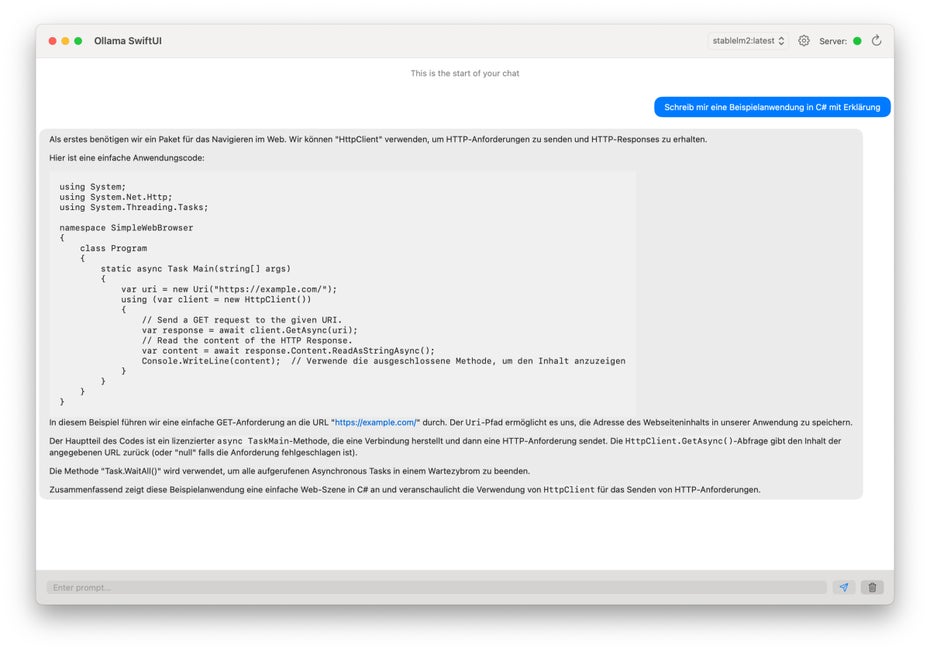

Mit Ollama-SwiftUI bekommt ihr einfaches aber funktionales grafisches Interface für eure lokalen Chatbots. (Screenshots: Ollama-SwiftUI / t3n)

Wenn ihr die Modelle auch unter einer grafischen Oberfläche verwalten möchtet, lohnt sich ein Blick auf Ollama-SwiftUI. Über das Programm könnt ihr neue Modelle direkt herunterladen, bestehende kopieren und sogar löschen. Der Umweg über den Terminal entfällt damit vollständig. Außerdem könnt ihr hier sogar innerhalb einer Chatkonversation das KI-Modell wechseln.

Sind lokale KI-Modelle ein vernünftiger Ersatz für ChatGPT?

Wie sinnvoll der Einsatz eines lokalen Chatbots ist, hängt letztlich auch von dem Einsatzgebiet ab. Fakt ist, dass OpenAIs Sprachmodell GPT-4 bei vielen Aufgaben bessere Ergebnisse liefern wird als die meisten Open-Source-Modelle. Bei einigen unserer Test-Prompts lieferten die genutzten Modelle nicht gerade hilfreiche Antworten.

Je nach Einsatzgebiet können die lokal ausführbaren KI-Modelle aber durchaus ausreichend sein. Im Zweifel solltet ihr es daher einfach ausprobieren. Immerhin könnt ihr Ollama, die damit nutzbaren Modelle und die erwähnten GUI-Tools vollkommen kostenfrei und ohne Begrenzungen nutzen. Zumindest in dieser Hinsicht kann das Cloud-Angebot von OpenAI nicht mithalten.