Facebook Big Data: Das gigantische Datenaufkommen des Social-Network-Riesen

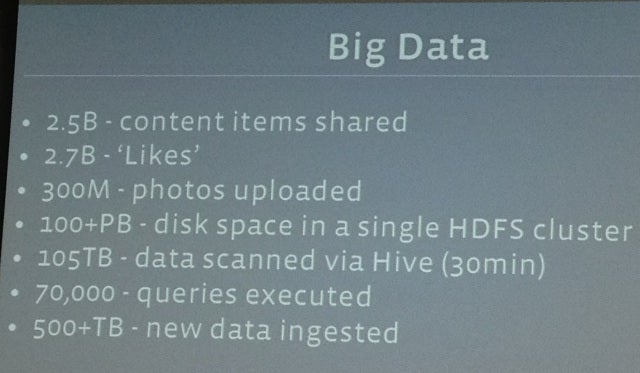

Der Social-Network-Riese Facebook verwaltet riesige Datenmengen. Wie TechCrunch berichtet, verarbeitet das Unternehmen täglich 2,5 Milliarden Inhalte, 2,7 Milliarden Likes und 300 Millionen Fotos. Zusammengenommen ergibt das ein tägliches Datenvolumen von mehr als 500 Terabyte.

Facebook Big Data: So verwaltet das Social Network die Datenmengen

Damit nicht genug: Jede halbe Stunde scannt das System etwa 105 Terabyte. Datenmengen dieser Größe – „Big Data“ im wortwörtlichen Sinne – sind schwer zu verwalten. Jay Parikh ist Facebooks Vize-Präsident für Entwicklung; er betont, wie wichtig es ist, aus der schieren Datenmenge auch Erkenntnisse zu ziehen. Erst dann könne man auch wirklich von „Big Data“ sprechen.

Facebook: Big Data im wortwörtlichen Sinne. (Quelle: TechCrunch)

Die aus den Daten gewonnenen Erkenntnisse helfen nicht nur Facebook selbst, so Parikh. Auch Werbetreibende profitieren vom stetig steigenden Wissen über das Verhalten der Nutzer. Wenn eine Werbeanzeige in Kalifornien besser läuft als in anderen US-Bundesstaaten, könne Facebook das gewonnene Wissen nutzen und die Performance der Anzeige verbessern, indem sie vermehrt kalifornischen Nutzern angezeigt wird.

Facebook Big Data: Project Prism hilft bei der Verwaltung

Bislang speichert Facebook alle Daten rund um dessen Nutzer und deren Verhalten in einem einzigen Rechenzentrum, weitere werden für Back-Ups und andere Daten genutzt. Wenn das Rechenzentrum die Daten nicht mehr fassen kann, werden sie in einem anderen, größeren Rechenzentrum untergebracht. Weil dieser Prozess Ressourcen verschwendet, wurde Project Prism angestoßen.

Project Prism macht es möglich, die Daten auf mehrere Rechenzentren zu verteilen, ohne dass dies einen Einfluss auf den internen Workflow hat. Denn auch intern wurden die Daten nicht unterteilt. Produktentwickler können abteilungsübergreifend alle gesammelten Informationen einsehen. Ein Missbrauch ist nicht ausgeschlossen, wird aber nicht toleriert. Fehltritte seitens der Mitarbeiter führen unmittelbar zur Kündigung, erklärt Parikh.

Erst vor kurzem wurden Fotos aus dem Inneren eines Facebook-Rechenzentrums veröffentlicht, den entsprechenden Artikel findet ihr hier.

Weitere Informationen

- How Big Is Facebook’s Data? 2.5 Billion Pieces Of Content And 500+ Terabytes Ingested Every Day – TechCrunch

(Quelle des Vorschaubildes: west.m / flickr.com, Lizenz: CC-BY)

Erster Absatz: 2,5 Milliarden statt Millionen…

@ma7c: You got me! Vielen Dank, ist korrigiert. :)