KI-gestützte Bildgeneratoren wie Stable Diffusion oder Dall-E können auf Zuruf zu fast allem ein Bild erzeugen. Nur ein Bild von euch oder eurem Nachbarn Karl-Heinz werden sie nicht erzeugen. Denn selbst wenn Fotos von euch – was gar nicht mal ausgeschlossen ist – Teil der Trainingsdaten der zugrunde liegenden KI-Modelle waren, reichen die schlicht nicht aus, damit die KI weiß, wer ihr seid. Daher schaffen es diese Systeme auch nur, Bilder von Berühmtheiten auf Vorgabe zu erzeugen.

Ende August hat Googles KI-Team unter dem Namen Dreambooth eine Lösung für genau dieses Problem vorgestellt. Dreambooth kann mit Fotos einer Person gefüttert werden und anschließend anhand von Textvorgaben Bilder von genau diesem Menschen erzeugen.

In Googles Forschungsabteilung war man sich jedoch bewusst, dass Dreambooth eben auch ein Missbrauchspotenzial birgt. Daher hat der Konzern auch nur ein Paper über die Funktionsweise von Dreambooth veröffentlicht, nicht aber den eigentlichen Code.

„Böswillige Parteien könnten versuchen, solche Bilder zu verwenden, um die Betrachter in die Irre zu führen“, warnt Google auf der Dreambooth-Website. Wirklich geholfen hat das freilich nicht.

Nur elf Tage später hat ein KI-Entwickler von Amazon eine erste freie Implementation der Dreambooth-Idee auf Basis des quelloffenen Bildgenerators Stable Diffusion veröffentlicht. Seitdem sind nicht nur allerlei Open-Source-Projekte auf Basis des Codes entstanden, auch eine Vielzahl von kommerziellen Anbietern nutzen die Technik für sich.

Per KI zum Comic-Superhelden

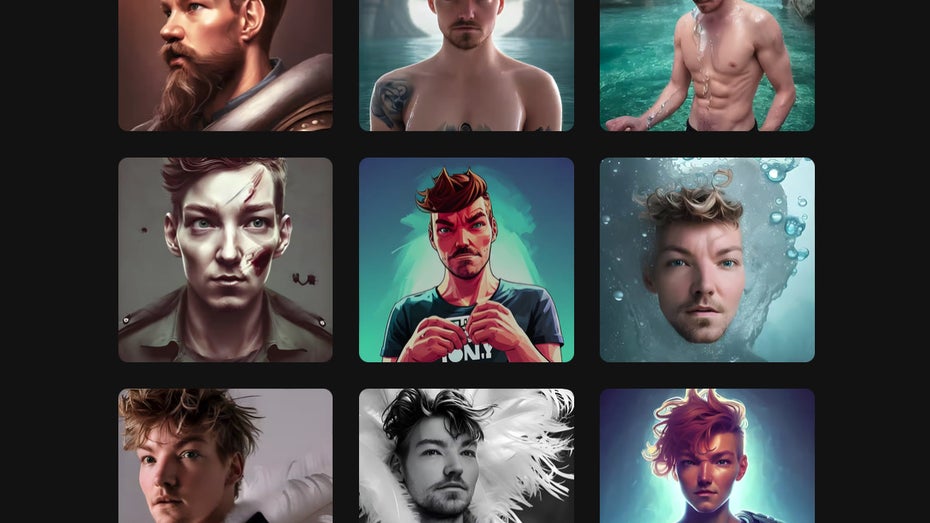

Avatar AI, Profile Picture AI oder AI Paintr sind nur ein paar der kostenpflichtigen Dreambooth-Implementationen. Die Preise reichen je nach gewünschter Komplexität und Auflösung der fertigen Bilder und je nach Anbieter von 3 bis 80 US-Dollar. Das Angebot ist in aller Regel aber nahezu identisch: Ihr ladet eine Reihe von Fotos von euch hoch und könnt dann aus Textvorgaben Comiczeichnungen oder andere kreative Variationen eures Konterfeis erzeugen.

Die Tools sind in aller Regel relativ leicht zu bedienen, und die Ergebnisse können sich durchaus sehen lassen. Zumindest wenn ihr euch etwas Mühe bei der Auswahl der Fotos gebt. Unterschiedliche Frisuren beispielsweise verwirren die KI eher. Auch Sonnenbrillen oder Kapuzen führen in der Regel zu suboptimalen Ergebnissen.

Missbrauchspotenzial: KI-Bilder anhand von Fotos der Nachbarin erzeugen?

Die Anbieter kontrollieren nicht, wessen Fotos ihr da eigentlich hochladet. So könntet ihr also ohne Probleme auch Fotos von anderen Menschen als Grundlage für eure KI-generierten Bilder nehmen. Spätestens da sollte das Missbrauchspotenzial offensichtlich werden. Fotos von der Instagram-Seite einer anderen Person nehmen und die KI damit füttern? Im Grunde kein Problem – sofern ethische Aspekte ignoriert werden.

Die Diskussion über die Nutzung von Fotos und Bildern zum Training einer KI erreicht damit auch eine private Dimension. Die meisten Menschen dürften sich zu Recht unwohl damit fühlen, wenn ein:e Fremde:r ihr Gesicht verwendet, um sie auf Bildern tun zu lassen, wonach auch immer ihm oder ihr ist.

Aber es gibt auch ein zweites Problem dabei: Mit der Dreambooth-Technik kann eine Bild-KI nicht nur gezielt an Fotos einer Person trainiert werden, sondern es können beispielsweise auch gezielt Zeichenstile von Künstler:innen kopiert werden. Das unterscheidet sich auf den ersten Blick zwar nicht direkt davon, dass Stable Diffusion von Haus aus Bilder im Stil von Picasso oder anderen berühmten Künstler:innen generieren kann, tatsächlich ist aber eben doch etwas anderes, wenn gezielt das Werk lebender Künstler:innen ausgeschlachtet wird.

Gleich mehrere Beispiele dafür finden sich in dem KI-Modell Comic-Diffusion. Das von dem Studenten Ogbogu Kalu erstellte Modell wurde anhand von Grafiken mehrerer lebender Comic-Zeichner trainiert. Dementsprechend kann das KI-Modell auch Bilder erzeugen, die genau jene charakteristischen Eigenschaften aufweisen, auf denen die Karriere der Künstler:innen fußt.

Gefragt wurden die Künstler:innen natürlich nicht. Nach Vorstellung des ersten Comic-Diffusion-Modells gab es im Stable-Diffusion-Subreddit durchaus Kritik an Kalu. Von dem ehemaligen Kickstarter-CTO und Tech-Blogger Andy Baio darauf angesprochen, zeigte sich auch die von Kalus KI-Modell kopierte Künstlerin Hollie Mengert nicht begeistert. „Hätte man mich gefragt, ob sie das tun können, hätte ich nicht ja gesagt“, so die Künstlerin. Damit dürfte sie nicht alleine dastehen.

Nach den Vorschußlorbeeren auf heise.de und anderen Plattformen bin ich nach Durchsicht der Galerie etwas ernüchtert – etwas mehr als dieses kompositionelle Gekrakel, dem dann oft noch die Visualierung eines zentralen Begriffs der textuellen Anfrage fehlt, hätte ich schon erwartet.

Vielleicht bin ich hier überkritisch, aber das ist nicht mehr als ein Spielzeug.

Die Auswahl aus der Galerie muss Monate alt sein.

Da liegen inzwischen mehrere WELTEN dazwischen.

Ich empfehle mal nach „Midjourney Community Showcase“ zu googlen.

Dort dann rechts oben auf „Top“ zu klicken.

Viel Spaß.

Der völlig abstrakte Gedanke eines Stils ist zum Glück noch nicht so leicht zu schützen. Menschen dürfen ja genauso einfach den „Stil“ eines anderen Menschen kopieren, sehe also keinen Grund warum eine Maschine das nicht dürfen sollte. Genauso dürfen Menschen andere Menschen bei beliebigen Handlungen zeichnen/malen/photoshoppen (erst beim veröffentlichen wird es rechtlich problematisch, bei AI-Bildern aber nicht anders), ist also auch nicht wirklich problematisch wenn eine Maschine das gleiche macht.

Während der Stil urheberrechtlich nicht geschützt ist, ist es das veröffentliche Bild/Foto aber schon. Abgesehen vom Urheberrecht gibt es noch das Recht am eigenen Bild, daher Vorsicht mit Photoshop und co.

Nur weil ein Bild öffentlich zugänglich ist, heißt nicht, dass es in irgendeiner Weise ohne die Zustimmung des Urhebers verwendet/verwertet werden darf. Aus diesem Grund ist es problematisch, wenn eine Maschine das gleiche macht. Es wäre nur in Ordnung, wenn für die KI-Trainings nur lizenzfreie Bilder verwendet würden.