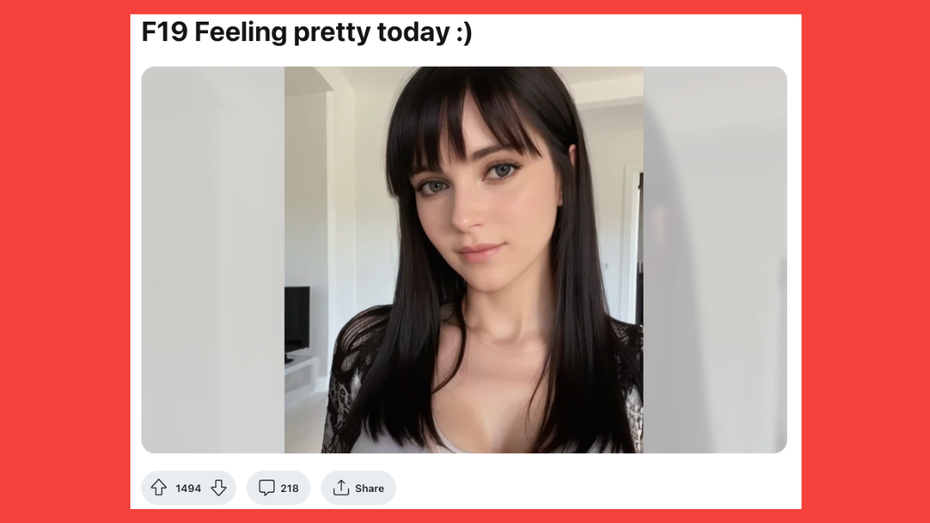

Reddit, Insta, Onlyfans: Social Media wird zum Marktplatz für KI-generierte „Aktbilder“

KI-generierte „Aktbilder“ werden über diverse soziale Plattformen verkauft. Dabei ist oft nicht transparent erwähnt, dass die Bilder nicht von echten Akt-Modellen stammen, sondern von KI erzeugt wurden.

Mit Stable Diffusion zu Pseudo-Pornografie und Geld

Die Washington Post (WP) hat einige Models ausfindig gemacht, die nach einiger Analyse als KI-generiert erkennbar waren – beispielsweise weil Muttermale in jedem Foto an anderer Stelle saßen. Einige Ersteller:innen hinter den Accounts antworteten auf die Anfragen: Mit Stable Diffusion sei es sehr einfach, die Bilder zu erstellen.

Ein Nutzer generiert Fetisch-Bilder von erwachsenen Frauen, die Windeln tragen. Er glaube nicht, dass es seine regulären Kund:innen überhaupt interessiert. Er würde nicht davon ausgehen, dass Menschen, die er im Internet sieht, auch genauso im realen Leben seien. „Wenn sie nicht echt sind, wen interessiert’s?“, sagte er gegenüber der WP.

Reddit, Insta, Onlyfans

Auf Reddit, Instagram, Twitter und Onlyfans zeigen die Accounts KI-generierte Bilder von Frauen – mal mehr, mal weniger bekleidet. Um mehr zu sehen, sollen Nutzer:innen zahlen oder Subscriber:innen werden. Zwei Studierende hinter einem Account haben 100 US-Dollar damit verdient. Sie hätten eigentlich nur testen wollen, ob man Menschen mit KI-Inhalten täuschen könne – sie hätten nicht mit diesem Erfolg gerechnet.

Nutzer:innen fühlen sich betrogen

Die Kommentare unter den Posts lässt allerdings erahnen, dass nicht allen klar ist, dass es sich nicht um ein reales Model handelt. Einen Transparenzhinweis gibt es nicht bei allen Accounts. „Ich fühle mich ein bisschen betrogen“, sagt eine Person gegenüber der WP, die eine Woche vorher noch unter einem Post kommentiert hatte, wie sexy und perfekt das Model aussehe. Ein anderer Nutzer war von der Enthüllung erschrocken – er findet es beängstigend, dass es so schwer sei, KI von echten Menschen zu unterscheiden.

Gegenüber Rollingstone sagten Inhaber eines Accounts, sie sehen es nicht als ihre Pflicht, darzulegen, dass es sich um ein KI-Model handelt. Käufer:innen hätten nicht nachgefragt, ob die Frau auf den Bildern echt sei – sie hätten es einfach angenommen.

„Nudes“ aus der KI

Als Deepfake Porn werden pornografische Inhalte bezeichnet, in die unbeteiligte Personen ganz einfach mit ein paar Fotos und KI eingearbeitet werden. So gab es einen angeblichen Porno mit Taylor Swift. Das ist doppelt problematisch: einerseits für die Sexindustrie, andererseits für die Unbeteiligten, in der Regel Frauen, die sich plötzlich in pornografischen Inhalten wiederfinden.

KI hat eine rasende Entwicklung hingelegt, mittlerweile benötigt es nicht mehr – wie bei einem Deepfake – ein reales Bild, das bearbeitet wird, Bildgenerierende KI spucken komplette Bilder nur auf Basis von Textbefehlen aus. Sie werden immer präziser und können mittlerweile sogar schon fast Hände realistisch darstellen. Die einfache Erstellung solcher Inhalte macht es zu einem lukrativen Deal: Die Inhalte sind in kürzester Zeit erstellt und auf Reddit einfach verkauft.

Das könnte, so WP, die milliardenschwere Sexindustrie ins Wanken bringen. Es befeuert auch Sorgen über die Objektifizierung und Ausbeutung von Frauen und Mädchen. Sexworker:innen sehen sich nicht unbedingt bedroht: „Die Leute, die behaupten, KI könnte Sexworker ersetzen, sind dieselben, die so tun, als wären Sexworker keine Menschen. Ich wünsche ihnen viel Glück und hoffe, dass sie herausfinden können, was ‚Consent‘ bedeutet. Vielleicht können sie mal die KI fragen“, sagt Sexworkerin und Studentin Zoey Sterling.

Deepfakes aus KI-Nudes

Diese KI-Bilder werden allerdings auch benutzt, um Deepfakes herzustellen. Sie ersetzen das reale Bildmaterial, das vorher gebraucht wurde. Reporter:innen der WP haben bereits Foren gefunden, in denen Menschen diskutieren, wie sie am einfachsten mit Bild-KI und der Inpainting-Bildbearbeitungstechnik Deepfakes erstellen können.

Um die Frauen zu erniedrigen und aus dem öffentlichen Raum zu drängen, müssten die Bilder nicht einmal real aussehen. Es reiche der Schockeffekt, so Sam Gregory gegenüber der WP. Er ist Executive Director einer Nonprofit-Organistaion, die in Videotechnologie und Menschenrechte spezialisiert ist. Das Problem sei neben der Masse an Deepfakes, die produziert werden, auch: „Menschen wollen etwas glauben, das jemanden erniedrigt, den sie nicht mögen.“