Stable Diffusion 2.0: Das sind die wichtigsten Neuerungen

Innerhalb von nur 90 Tagen nach der Veröffentlichung des ersten Stable-Diffusion-Modells auf GitHub wurde das Projekt dort von mehr als 33.000 Entwickler:innen als Favorit markiert. Zum Vergleich: Kryptoprojekte wie Ethereum und Bitcoin oder auch das Apache-Projekt Kafka brauchten dafür mehrere Jahre. Das Interesse an der quelloffenen Bild-KI ist enorm.

Jetzt hat Stability.ai, das Startup hinter dem Projekt, Version 2.0 von Stable Diffusion vorgestellt. Neben einigen Neuerungen wurde dabei auch die klassische Text-zu-Bild-Funktion des KI-Modells überarbeitet und soll jetzt deutlich bessere Ergebnisse liefern. Damit generierte Bilder können standardmäßig in einer Auflösung von 512 mal 512 oder 768 mal 768 Bildpunkten generiert werden.

Wem diese Auflösung nicht reicht, der kann auch auf den neuen KI-gestützten Upscaler zurückgreifen. Damit können Bilder auf eine Auflösung von 2.048 mal 2.048 Pixeln oder höher hochskaliert werden.

Depth-to-Image: Stable Diffusion kann jetzt noch besser bestehende Bilder verändern. (Grafik: Stability.ai)

Depth-to-Image: Stable Diffusion kann jetzt noch besser bestehende Bilder verändern

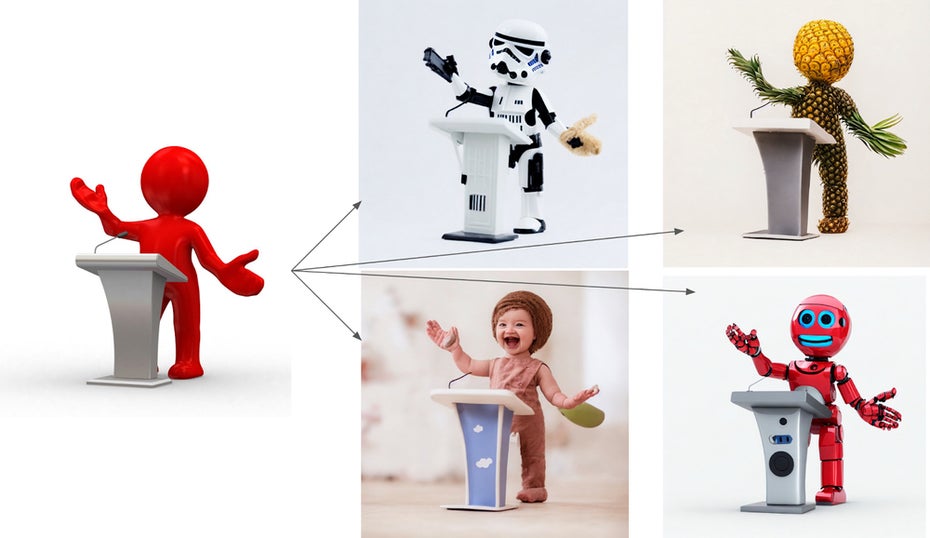

Mit einem neuen tiefenbasierten KI-Modell kann Stable Diffusion 2.0 deutlich besser als bisher dafür genutzt werden, bestehende Bilder zu verändern. Das Modell kann aus einem angelieferten Bild auf die Tiefe schließen und diese Information dann bei der Generierung eines neuen Bildes verwenden. So bleibt die Struktur des Originals erhalten, während dort gezeigte Elemente vollständig verändert werden.

Überarbeitet wurde außerdem die Möglichkeit, Bestandteile bestehender Bilder anhand von Texteingaben zu verändern. Damit soll es extrem einfach sein, schnell und einfache Änderungen an Bildern vorzunehmen.

Genau wie frühere Versionen steht Stable Diffusion 2.0 unter einer Open-Source-Lizenz, die auch den kommerziellen Einsatz der Technologie erlaubt. Das KI-Modell findet ihr auf GitHub. In den kommenden Tagen sollen die neuen Features von Stable Diffusion auch in die kommerzielle Web-Oberfläche Dreamstudio und die API-Plattform von Stability.ai integriert werden.