„Multisearch in der Nähe“: Google bohrt Suchfunktion der Google-App für lokale Ergebnisse auf

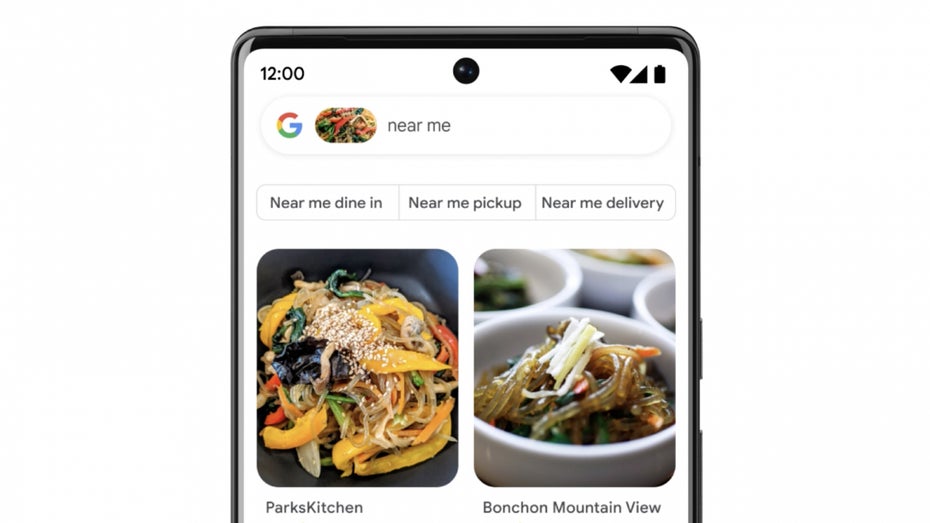

Für die neue lokale Suchfunktion könne ein Bild oder ein Screenshot verwendet werden, um nach dem Produkt „in meiner Nähe“ zu suchen. Findet ihr beispielsweise auf Instagram oder irgendwo im Netz ein lecker aussehendes Gericht, verrät euch die Suche nicht nur, wie es heißt, sondern auch, welches Restaurant es in eurer Umgebung auf seiner Speisekarte hat.

Google Multisearch in der Nähe

Wenn ihr die Multisearch-Funktion verwendet, um das Gericht in eurer Nähe zu finden, „durchsucht Google Millionen von Bildern und Bewertungen“, die auf Websites und von Mitwirkenden der Google-Maps-Community veröffentlicht wurden.

Googles Multisearch in der Nähe hilft euch dabei, Produkte und Restaurants zu finden. (Bild: Google)

Neben lokalen Restaurants werden euch je nach Suche auch Einzelhändler angezeigt, die Kleidung, Haushaltswaren und Lebensmittel anbieten, die ihr sucht.

Laut Google sollen die lokalen Informationen in der Multisuche noch in diesem Jahr weltweit auf Englisch bereitgestellt und im Laufe der Zeit auf weitere Sprachen ausgeweitet werden.

Googles Multisearch hilft euch künftig bei der Produktsuche im Supermarkt

Bislang bietet die visuelle Googlesuche lediglich die Objekterkennung in einem Einzelbild an. Künftig soll es möglich sein, Informationen über eine ganze Szene oder eine Regalreihe im Supermarkt zu erhalten, so das Unternehmen.

Die Weiterentwicklung der visuellen Suche heißt „Scene Exploration“ und soll dazu in der Lage sein, mithilfe der Multisearch-Funktion die Smartphone-Kamera zu schwenken und in Echtzeit Informationen über mehrere Objekte in einer größeren Szene zu liefern.

Als Beispiel nennt Google die Suche nach dem „perfekten Schokoriegel für euren Freund, der ein echter Schokoladenkenner ist“. Ihr wisst etwa, dass er Zartbitterschokolade liebt, aber keine Nüsse mag. Zudem wollt ihr eine hochwertige Schokolade verschenken. Mithilfe der Scene Exploration könnt ihr das gesamte Regal mit der Smartphone-Kamera einscannen und euch hilfreiche Informationen einblenden lassen.

Google beschreibt die Scene Exploration als „einen großen Fortschritt in der Fähigkeit unserer Geräte, die Welt so zu verstehen, wie wir sie verstehen“. Wann die neue Funktion bereitgestellt wird, hat das Unternehmen nicht verraten.