Apple Intelligence: Apple stellt neue KI-Funktionen für iPhone und Mac vor – aber nicht jeder darf sie nutzen

Wollte Apple auf der WWDC 2024 nicht neue Funktionen mit künstlicher Intelligenz vorstellen? So hieß es zumindest vorab. Doch in der ersten Stunde der Auftakt-Keynote erwähnten die Offiziellen um CEO Tim Cook die Technologie mit keiner Silbe. Stattdessen sahen Zuschauer:innen relativ kleine Neuerungen für die kommenden Betriebssysteme iOS 18, iPadOS 18 und macOS Sequoia. Erst als Cook abermals an Software-Chef Craig Federighi übergab, wurde es so richtig interessant. Denn Federighi stellte Apple Intelligence vor. Der Begriff ist sicherlich nicht zufällig gewählt, denn die Kurzform lautet AI.

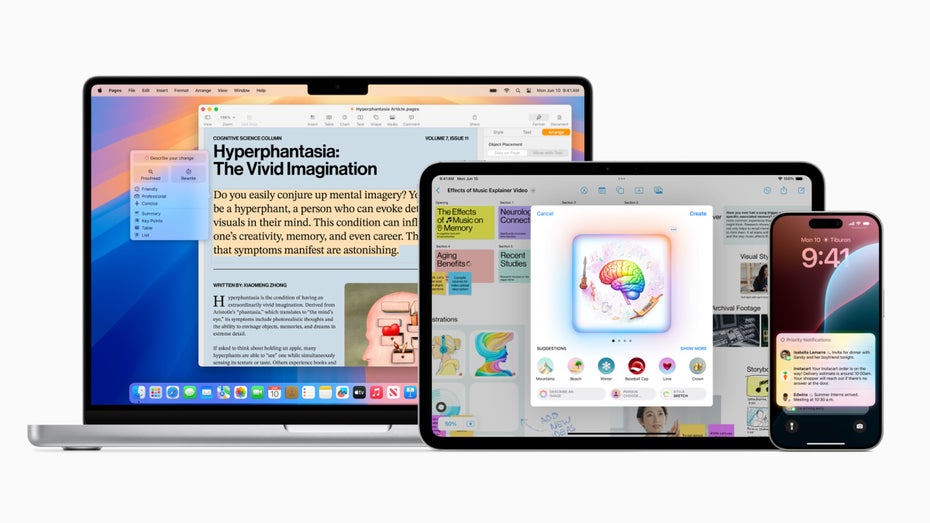

Unter dem Begriff Apple Intelligence fasst das Unternehmen all seine neuen KI-Funktionen zusammen. Dazu gehören diverse Schreibhilfe, die Möglichkeit, sich Bilder generieren zu lassen und eine stark verbesserte Version von Siri.

Wird Siri endlich klug?

Der Hauptteil der Vorstellung fiel dann auch auf Apples Sprachassistenz. Die aktiviert ihr wie gewohnt mit einem langen Druck auf die Einschalttaste am iPhone oder iPad oder über das Siri-Symbol am Mac. Neu: Die futuristische Sprechblase ist Geschichte. Stattdessen wird der Bildschirminhalt farblich umrandet, wenn Siri aktiv ist.

Im Einsatz soll Siri künftig natürlicher klingen, außerdem Anfragen von Nutzer:innen besser verstehen. Verhaspelt man sich beim Einsprechen, sei das für die Assistenz dank der KI-Stütze künftig kein Problem mehr, hieß es bei der Vorstellung. Dazu kommt: Siri versteht den Kontext bei der Unterhaltung, weiß etwa wer mit „Mama“ gemeint ist und kann die Personen mit Daten wie einer Einladung zum Essen oder dem Geburtstag in Verbindung bringen.

Die App Image Playground gibt euch Starthilfe bei der Erstellung von KI-Bildern (Bild: Apple)

Auch praktisch: Siri wird nicht nur zum mächtigen Kalender, sondern auch zum Tech-Support. Man kann der Assistenz Fragen zu Funktionen von iPhone, iPad oder Mac stellen. Natürlich ist auch nach wie vor möglich, via Siri Timer zu starten oder den Wecker zu stellen. Und ist es gerade einmal zu laut oder ihr müsst besonders leise sein, könnt ihr die Assistenz auch per Chat bitten, euch zu wecken.

Für die Zukunft stellte Apple weitere Funktionen in Aussicht. So soll Siri bald erkennen können, was auf dem Bildschirm passiert. Dann lässt sich etwa eine Adresse aus einem Chat per Sprachbefehl einem Kontakt zuordnen. Das erspart, wenn es denn funktioniert, viel Tipperei. Außerdem soll sich Siri von App zu App „bewegen“ können. Ein Beispiel: Ihr bearbeitet ein Foto per Sprachbefehl. Dann lässt es sich ganz einfach in die Notizen-App kopieren. Beide Funktionen sollen aber erst später nachkommen.

Apple und die üblichen KI-Tools

Abseits davon hat Apple die üblichen KI-Tools vorgestellt. Ein Schreibassistent kann etwa dabei helfen, E-Mails umzuformulieren oder zusammenzufassen. In der Mail-App zeigt die KI auf Wunsch automatisch priorisierte Mails ganz oben an und bietet die Möglichkeit, Antworten für euch zu formulieren. Wer mag, kann auf seinem Apple-Gerät künftig Bilder generieren. Zum Herumspielen stellt Apple sogar eine neue App namens Image Playground zur Verfügung. Hier könnt ihr euch die Parameter selbst zusammenklicken. Die KI baut dann daraus ein Bild. Ähnliches gibt es auch für Emojis. Apple nennt sie dann Genmojis.

Auf Befehl baut euch Apple Intelligence mit Material aus eurer Mediathek einen Urlaubsfilm. (Bild: Apple)

Für die Fotos-App gibt es künftig ebenfalls eine KI-Funktion. Mit der lassen sich unerwünschte Personen und Objekte aus dem Hintergrund entfernen. Bei Google heißt das „Magischer Radierer“, Apple spricht vom „Clean Up“-Tool, also von einem Aufräumwerkzeug. In der Notizen-App kann ein neuer Stift aus Skizzen nun KI-Bilder erstellen.

Etwas spannender für den Alltag klingt die Funktion, sich künftig Notifications zusammenfassen zu lassen. So bleibt ihr auch bei vielen Nachrichten im Gruppenchat immer auf dem Laufenden. Auf Wunsch lässt die KI außerdem nur wichtige Nachrichten auf den Sperrbildschirm. Apple nennt das Feature „Reduce Noise“, also Geräuschreduzierung. Damit könnte das Unternehmen den Zeitgeist treffen. Das Smartphone mal weniger in die Hand nehmen, liegt gerade bei Jüngeren im Trend.

Wie steht es um die Sicherheit?

Bei so viel KI-Interkation mit den eigenen Daten stellt sich automatisch die Frage nach der Sicherheit. Bei der Veranstaltung gab Apple an, dass die meisten Anfragen direkt auf dem Gerät (on Device) bearbeitet werden. Dafür brauchen iPhone und Macbook also keinen Zugriff auf die Cloud. Sollte das anders sein, stellt Apple spezielle Server zur Verfügung, die mit den eigenen Silicon-Prozessoren ausgestattet sind. Ihr werdet also nicht an x-beliebige Rechenzentren verwiesen.

Die Datenhoheit soll dabei bei Nutzer:innen bleiben. Laut Apple speichern diese Server keine persönlichen Daten. Anders könnte der Fall bei einer weiteren Funktion liegen. Denn dank der Zusammenarbeit mit OpenAI bietet Apple auch Zugriff auf das neue Sprachmodell ChatGPT-4o – gratis für alle. Stellt ihr eine Anfrage an Siri und die Assistenz weiß nicht weiter, leitet sie euch auf Wunsch ans OpenAI-Modell weiter. Allerdings verspricht Apple, dass auch beim Kontakt mit ChatGPT keine Daten gespeichert werden.

Die Einschnitte

Weil On-Device-KI viel Rechenpower verlangt, setzt Apple dafür ein Endgerät mit M-Prozessor voraus. Nutzer:innen brauchen also ein halbwegs aktuelles Macbook Air oder Pro oder iPad Air oder Pro. Auf dem normalen iPad funktioniert die Apple Intelligence nicht. Beim iPhone kommt es noch dicker: Damit ihr von den neuen Funktionen profitiert, braucht ihr ein iPhone 15 Pro oder Pro Max. Alle anderen iPhones sind nicht damit kompatibel.

Und selbst, wenn ihr die Voraussetzungen erfüllt, geht ihr nur einen kleinen Schritt in die Zukunft. Denn zwar ist Apple Intelligence ein Teil der neuen Betriebssystem, die KI-Software steht euch aber auch im Herbst, wenn die finale Software erscheint nur als Beta und nur auf Englisch zur Verfügung.