So sieht es aus, wenn KI einen automatisierten Podcast baut

Automatisch erzeugte Podcasts könnten ein Zukunftsmodell sein. (Foto: Alex from the Rock / shutterstock)

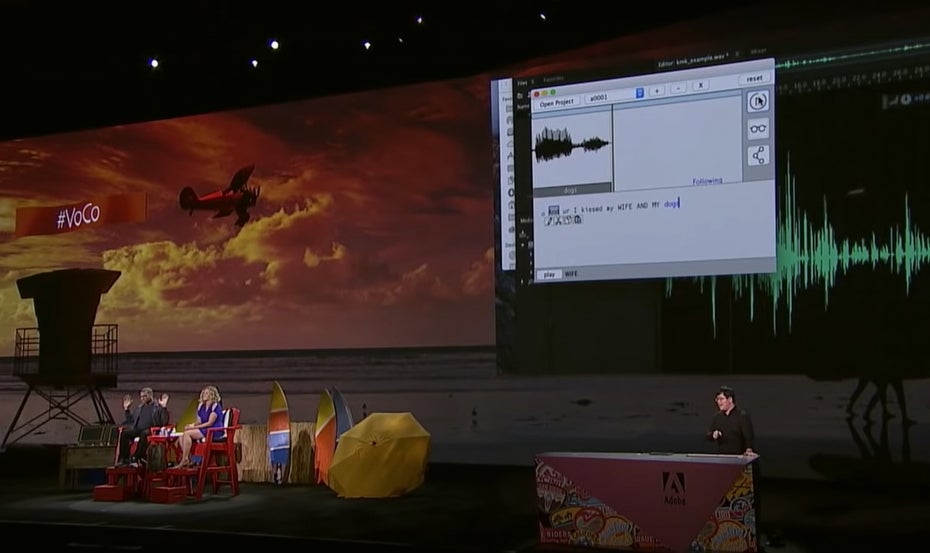

Wir schreiben das Jahr 2016. Adobe stellt auf seiner Hausmesse Max ein neues Tool namens Voco vor. Der Entwickler des Produkts, Zeyu Jin, zeigt, wie einfach er einen Deepfake des Schauspielers Jordan Peele erstellen kann. Peele war Gast auf der Adobe Bühne. Das Spektakuläre: Jin konnte einzelne Textelemente innerhalb der Transkription verschieben und das System generierte automatisch eine neue Tondatei mit dem manipulierten Ergebnis.

Voco kam (noch) nicht zur Serienreife. Der öffentliche Aufschrei war zu groß. Ein solches System öffnet betrügerischen Deepfakes Tür und Tor, dachte man damals. Und man hatte recht. Nur ließ sich die Entwicklung durch das Einfrieren eines einzelnen Tools nicht mehr aufhalten. Heute beginnen wir uns an Deepfakes zu gewöhnen. In Werbung und Marketing sind sie längst gang und gäbe.

Und die Diskussion um Deepfakes hat zwei Dimensionen angenommen. Die eine ist die gesellschaftliche: Wie kann der Rezipient eines Videos, Fotos oder Tondokuments das Echte vom Falschen unterscheiden? Kann eventuell die künstliche Intelligenz selbst dabei helfen, die Fakes die sie selbst generiert, zu identifizieren?

Zeyu Jin zeigte schon 2016 auf der Adobe-Bühne, wie man eine Tonspur im Text bearbeiten kann. (Foto: Voco)

Der andere Teil der Diskussion ist allerdings mindestens genauso spannend: Wenn man falsche Informationen digital erzeugen kann, dann kann man auch richtige Informationen auf diesem Weg produzieren. Das System Voco löst bei einem Texter nicht nur Schrecken aus, sondern eröffnet ihm auch gleichzeitig die Perspektive, einen inhaltlichen oder grammatikalischen Fehler nachträglich korrigieren zu können. Im Podcast oder im Video.

Das Beispiel HNA

Genau diese Idee hatte man auch im Hause Ippen. Die Verlagsgruppe ist bekannt dafür, sich schnell und progressiv mit Innovationen zu befassen. Jan Ippen, Gründer und Geschäftsführer von Ippen Digital, ist zum Beispiel in der SEO-Szene so gut vernetzt, dass einige der großen Suchmaschinenoptimierer Deutschlands abwinken, wenn man sie nach den Erfolgsprinzipien der Ippen-Publikationen fragt. „Dazu kann ich nichts sagen, ich bin mit Jan befreundet“, lautet die Standardantwort.

Spannend ist, dass zum Ippen-Portfolio viele kleinere Regionalzeitungen gehören, denen man von außen nicht viel Digitalkompetenz zutraut. Aber gemeinsam sind sie stark – sofern sie es wollen. Und Meike Klement will. Sie leitet das Digitalteam bei der HNA, der Hessisch Niedersächsischen Allgemeinen. Und sie ist dafür verantwortlich, dass es seit Oktober 2021 einen Podcast im Programm gibt, der automatisch aus Texten der HNA-Website generiert wird.

5.000 Zuhörer hat der Podcast jeden Tag. Insgesamt gibt es inzwischen 104 Episoden. Es wurden also eine halbe Million Streams abgerufen. Und inzwischen startet jeder der HNA-Podcasts mit einem Werbeblock. Gestern warb der Handyhersteller Xiaomi mit einem elegant in den Stream eingebundenen Spot für sein neues Flaggschiff-Produkt.

Lokale und regionale Nachrichten bieten den Hörern den Mehrwert, den sie sich vom Nachrichtenpodcast versprechen. (Screenshot: HNA)

Das Erfolgsgeheimnis des HNA-Podcasts ist keines. Die Zeitung konzentriert sich auf die Informationen, die sie unverwechselbar machen: Lokales und Regionales. Bei den meisten anderen Themen könnten sie mit den großen Redaktionsteams der überregionalen Zeitungen und Portale nicht mithalten oder keinen echten USP anbieten. Im Kasseler Kiez hingegen schon.

Das Spannende aber ist eher, dass die Redaktion diese Idee überhaupt ausprobiert hat. Verlage sprechen tagtäglich über die Möglichkeiten, die sie zur Verbreitung ihrer Inhalte haben. Aber der Podcast ist halt doch ein aufwendiges Format. Und weil man im Vorfeld nicht weiß, ob es sich rechnet, starten viele solcher Experimente erst gar nicht.

Die Technik

Es sei denn, die Technik hilft. Das Düsseldorfer Unternehmen Storyflash hat eine Art Redaktionssystem für Social Media entwickelt. Damit lassen sich Posts planen, an die verschiedenen Kanäle anpassen und mit Animationen anreichern. Es lag nahe, dieses System auch auf weitere Mediengattungen auszudehnen, denn es hilft den Redakteuren dabei, ihre Texte breit zu streuen, ohne den ganz großen Aufwand dahinter.

Und die neueste der Plattformen ist tatsächlich der Podcast. Im Storyflash-Backend markiert der Redakteur die Artikel, die er für den News-Podcast haben will. Dort kann er auch Texte editieren, etwa um eine Überschrift noch spannender zu machen. Dann wählt er den akustischen Rahmen aus (Intro, Outro, Hintergrundmusik) und entscheidet sich für eine oder mehrere Sprecherstimmen.

Die Storyflash-Software schickt die fertige Meta-Information an das System von Aflorithmic nach London. Dort werden die Texte von einer Text2Speech-Engine „eingesprochen“. Das System montiert die Schnipsel zu einer etwa zwei Minuten langen Episode und die Software von Storyflash publiziert sie beim Münchner Podcast-Hoster Julep. „Wir haben uns viele Lösungen angeschaut, aber Julep ist einfach und die beherrschen auch Monetarisierung“, erklärt Storyflash-Gründer Pascal Hohmann.

Das Ergebnis klingt gut. Man kann die Computersprecher erkennen, aber das stört kaum. Man hat sich an diese Form der Content-Übertragung auch bei Google Maps gewöhnt. Nacharbeiten muss man eventuell bei Spezialbegriffen (zum Beispiel Schwalm-Eder-Kreis) und bei Akronymen. Bei einem Testtext über NFTs spricht die Maschine das „S“ als zur Abkürzung gehörig, also NFTS. „Das kann man lösen, indem man ein Leerzeichen zwischen T und S setzt“, erklärt Hohmann. Auch weitere Befehle zur korrekten Auszeichnung der Texte werden in der nächsten Version der Storyflash-Software vertreten sein. Voco lässt grüßen.

Das Potenzial

Vermutlich schießt an dieser Stelle bereits die Fantasie mancher t3n-Leser ins Kraut. Wenn der Text automatisch umgesetzt werden kann, kann er auch automatisch übersetzt und eingelesen werden. Aus dem deutschen Artikel entsteht ein englischer Podcast. Auch kleinere Update-Formate – etwa der interne wöchentliche Firmennewsletter – lassen sich mit überschaubarem Aufwand produzieren. Eine automatisch eingelesene Story könnte Ausgangspunkt einer Diskussion innerhalb eines „richtigen“ Podcasts sein.

Knapp 500 Euro verlangt Storyflash für das Paket pro Monat. Da gehört dann auch eigenes Audiobranding dazu. Testen kann man das System gratis.

Noch einen Schritt weiter geht das Hofer Unternehmen Ahearo. Hier werden die Texte zwar auch automatisch eingelesen, aber die Stimme, die zum Tragen kommt, stammt von einem professionellen Hörbuch-Sprecher. Daraus lassen sich – neben vorgelesenen Artikeln – auch Tonspuren generieren, die unter einem Video liegen. Das Ahearo-System kommt bereits bei einigen größeren Verlagen zum Einsatz. Unter anderem Men’s Health, PCGo oder die Zeitschrift Outdoor setzen es ein. Noch ist beim Ahearo-System der Automatisierungsgrad nicht der gleiche wie bei Storyflash. Dafür haben die Franken eine App mit einem Audio-Kiosk am Start, der beim Vertrieb des Mediums helfen kann.

Men’s Health nutzt das automatische System von Ahearo für Audiostories, die unter anderem über Social Media verteilt werden. (Bild: Men’s Health)

Unterm Strich zeigt sich, dass die automatische Optimierung oder Konvertierung von Inhalten ein immer höheres technisches Niveau erreicht – ein technisches Niveau, das den Menschen offensichtlich gefällt, wie das Beispiel HNA zeigt. Entscheidend ist, ob die inhaltliche Qualität des Originalmaterials stimmt. Und dafür bleiben die Redaktionen verantwortlich. Es werden „nur“ ein paar Hindernisse bei der Verbreitung entfernt und dadurch werden Ressourcen in Redaktionen du Marketingabteilungen frei.

Schließlich können sie Marketer und Redakteure ja nicht klonen, um der wachsenden Menge an Aufgaben Herr zu werden. Oder doch?