Ob als Betrugsmasche in Bewerbungsgesprächen oder Troll-Aktion gegenüber Berlins Regierender Bürgermeisterin Franziska Giffey: Immer wieder tauchen Deepfakes, also künstlich erzeugte Bilder, in Videocalls auf.

Gerade wenn in so einem Telefonat vertrauliche Informationen ausgetauscht werden, sollte sicher sein, dass am anderen Ende auch nur die Person sitzt, für deren Ohren die Details bestimmt sind.

Bei normalen Videoclips und Fotos, die beispielsweise über Social Media verbreitet werden, gibt es einige Details, die auf manipulierte Inhalte hinweisen können. Aber wie lassen sich Deepfakes speziell im Live-Videocall erkennen?

Deep-Fake im Videocall: Startup empfiehlt Perspektivwechsel

Einen Tipp dafür hat jetzt Metaphysic.ai in einem ausführlich Blogbeitrag veröffentlicht. Das britische Startup ist im Netz mit viralen Tom-Cruise-Deepfakes bekannt geworden. Dabei kam die App Deepfacelive zum Einsatz. In der hat das Team nun einen kurzen Test durchgeführt, um zu demonstrieren, dass eine ganz bestimmte Perspektive Deepfake-Tools Schwierigkeiten bereitet.

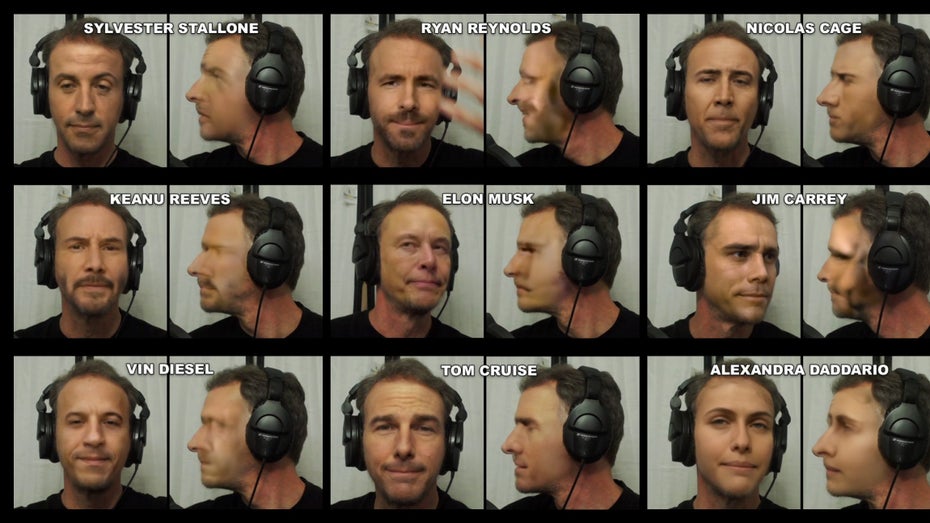

Mit verschiedenen Deepfake-Filtern über dem Gesicht sollte sich Proband Bob Doyle während eines Calls bewegen. Das Ergebnis: Während die Täuschung in der Frontalansicht häufig gut angepasst ist, bringt eine seitliche Drehung des Kopfes um 90 Grad die Software aus dem Konzept. Der Filter passt nicht mehr zu den Gesichtskonturen und ist eindeutig zu erkennen.

Deepfake-Algorithmen: Das seitliche Profil als Schwachstelle

Ein Grund für die fehlerhafte Darstellung dürften nach Einschätzung von Metaphysic.ai-Mitarbeiter Martin Anderson die Referenzpunkte sein, über die die Software das Gesicht des Probanden analysiert.

In der Frontalansicht stünden dem Programm deutlich mehr Referenzpunkte zur Verfügung als nach dem Wechsel ins seitliche Profil: „Tatsächlich ordnen die meisten 2D-basierten Algorithmen zur Gesichtsausrichtung einer Profilansicht des Gesichts nur 50 bis 60 Prozent der Orientierungspunkte einer Frontalansicht zu.“

Ein weiteres Problem: „Typische 2D-Ausrichtungspakete betrachten eine Profilansicht als zu 50 Prozent verdeckt, was die Erkennung, das genaue Training und die anschließende Gesichtssynthese erschwert“ – es kommt zu Fehlern bei der Darstellung.

Und noch ein Grund macht die Anpassung auf seitliche Profile für Deepfake-Anwendungen komplizierter als das Verändern von Frontalansichten: Es fehlt an Trainingsdaten. Von den meisten Menschen gibt es deutlich mehr Fotos, die frontal aufgenommen wurden, nur selten werden bewusst seitliche Aufnahmen gemacht – zum Beispiel für Polizeiakten. „Der Mangel an verfügbaren Daten macht es schwierig, […] ein Deepfake-Modell so zu trainieren, dass es Profilansichten überzeugend reproduzieren kann.“

Schwachstelle in Deepfake-Software: Nachbearbeitung hilft

Diese Schwierigkeiten dürften den Nutzer:innen von Deepfake-Programmen bekannt sein, schätzt Anderson. „Im Wissen um diese Schwachstelle bei Deepfakes vermeiden die meisten viralen Deepfaker die Verwendung von Clips, die gut trainierte, genaue und zeitlich konsistente Profilansichten erfordern“, schreibt er in seinem Blogbeitrag.

Natürlich gibt es auch Fälle, in denen Videoausschnitte abseits von Livecalls zumindest umfangreich nachbearbeitet werden, um Schwachstellen auszugleichen. Und die Anwendungen zum Erzeugen von Deepfakes werden ständig weiterentwickelt, sodass das seitliche Profil irgendwann auch bei Live-Videos fehlerfrei ausgespielt wird.

Bis dahin gilt aber: Wer im Videocall stutzig wird, kann das Gegenüber künftig ja einmal bitten, den Kopf wirklich um 90 Grad zur Seite zu drehen – und dabei ganz genau hinschauen.