In Paris hat Prabhakar Raghavan, der bei Google unter anderem für die Suche zuständig ist, heute eine Reihe von Neuerungen angekündigt. Im Zentrum stand dabei vor allem der Einsatz von KI in verschiedenen Google-Produkten. Ausgerechnet zu Bard, Googles Alternative zu Microsofts gerade erst vorgestellter KI-gestützten Suche, hatte der Manager allerdings nicht viel Neues zu berichten.

Stattdessen ging es vor allem um die Verbesserung der visuellen Suche mit Google und neue Funktionen für den Kartendienst des Unternehmens.

Lens ist bald überall: Google verbessert die visuelle Suche

Mit Google Lens bietet der Konzern schon seit geraumer Zeit die Möglichkeit, über die Smartphone-Kamera oder anhand von gespeicherten Fotos eine visuelle Suche durchzuführen. Wie Google jetzt ankündigt, soll die Funktion in den kommenden Monaten auf das gesamte Android-Interface ausgeweitet werden.

Zukünftig können Android-Nutzer:innen direkt aus jeder App heraus die Lens-Funktion starten und so beispielsweise nach Objekten in einem Video suchen, das sie über eine Messaging-App erhalten haben. Auch in Fotos und Videos auf Websites kann die Funktion genutzt werden.

Um das Feature zu nutzen, müssen Android-Nutzer:innen zukünftig nur etwas länger auf Home- oder Power-Button drücken, um den Google Assistant zu aktivieren. Dort wird es dann bald auch einen neuen Menüpunkt geben, mit dem der Display-Bildschirm an Lens übergeben wird.

Google Lens: Visuelle Suche kann mit zusätzlichen Parametern verfeinert werden

Ebenfalls neu in Google Lens ist die sogenannte Kombi-Suche. Nachdem Nutzer:innen ein Objekt auf einem Foto oder Screenshots ausgewählt haben, können sie mit in einem weiteren Schritt die Suche um weitere Details ergänzen.

Als Beispiel wählte Google die visuelle Suche nach einem Designerstuhl. Bei dem Beispiel wurde dann eine bestimmte Farbe als zusätzlicher Parameter angegeben, um einen Stuhl in dem Look vom Foto aber anderer Farbgebung zu finden. Weitere Beispiele aus Googles Pressematerialien umfassen Gerichte oder Cocktails, die erst visuell mit Lens erkannt werden, um dann die Suche mit „Rezept“ zu erweitern.

Google Lens: KI macht Übersetzung transparent

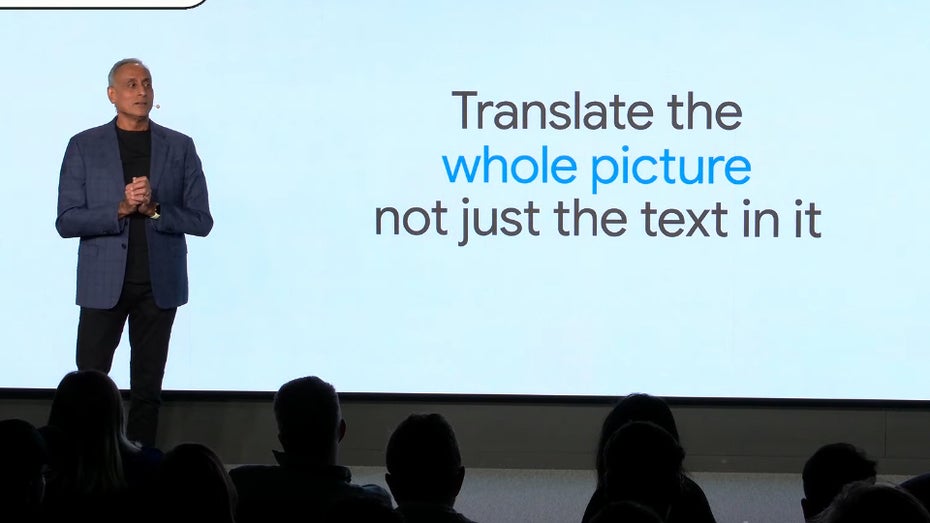

Wer Texte auf Bildern bislang mit Google Lens übersetzt hat, dem wurde die Übersetzung anschließend über dem Bildtext angezeigt. Das entspricht auch der Vorgehensweise auf Apples Betriebssystemen. Zukünftig wird sich Google in der Hinsicht aber vom Konkurrenten abgrenzen.

Noch in diesem Jahr soll Google Lens bei einer Übersetzung das fremdsprachliche Original per KI aus dem Original herausretuschieren und durch die Übersetzung ersetzen. Das sieht in den vom Konzern bereitgestellten Werbevideos durchaus überzeugend aus.

Neue KI-API von Google und beruhigende Worte an die SEO-Branche

Kommenden Monat wird Google eine neue Software-Schnittstelle veröffentlichen, mit der Entwickler:innen Zugriff auf das KI-Modell Lamda erhalten, das auch Bard antreiben soll. Zu einem späteren Zeitraum will der Unternehmen die Schnittstelle um weitere KI-Modelle erweitern.

Während Google das Rennen um die Integration eines Chatbots in die Suche mit Microsoft verloren hat, nutzt Raghavan das Event, um bei Website-Betreibern und Suchmaschinenoptimierern etwaige Ängste gegenüber einer um KI erweiterten Google-Suche abzubauen. Er reagiert damit auf Ängste der Branche, dass eine in die Suche integrierte Chat-KI dazu führen könnte, dass Nutzer:innen ihre Fragen bei Google beantwortet kommen und dann nicht mehr auf weiterführende Links klicken.

Am Ende der Präsentation hat Raghavan erklärt, dass Google noch an einer ganzen Reihe weiterer KI-gestützter Produkte arbeitet. Das könnte auch als Signal an die Börse verstanden werden. Denn der Hype um ChatGPT und ähnliche Produkte hat längst die Märkte erfasst. Die Neuankündigung zu Googles Bard-KI sorgte genau wie Microsofts Integration einer OpenAI-KI in die Bing-Suche für deutliche Preisveränderungen der jeweiligen Aktien.