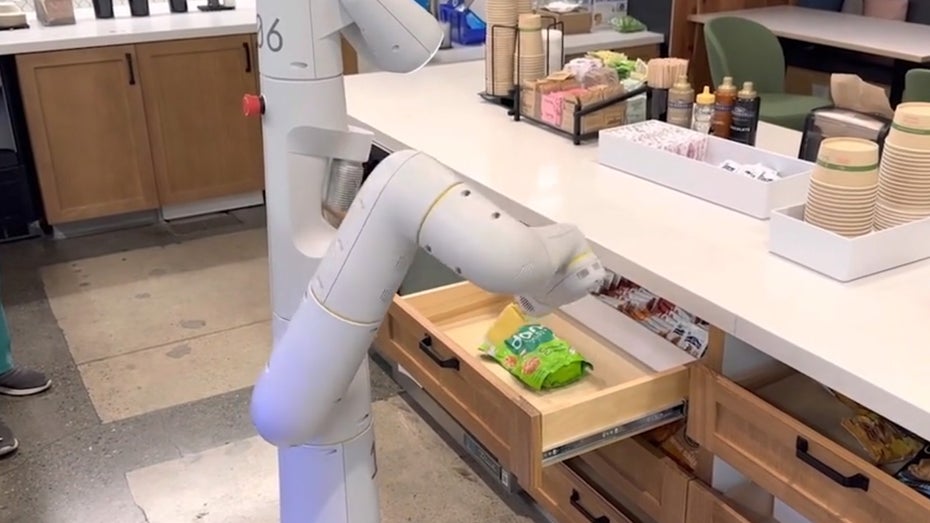

Die Tüte Chips kommt sofort! (Screenshot: Google / t3n)

Palm-E ist eine Art Gehirn für Roboter, das auf KI basiert. Damit können Roboter einfache Befehle in natürlicher Sprache entgegennehmen und diese eigenständig ausführen. Palm-E wurde von Robotics at Google zusammen mit der Technischen Universität Berlin und Google Research entwickelt, wie es auf der Website heißt.

Hier demonstrieren die Forscher auch, was damit in der Praxis möglich ist. So beauftragen sie einen Roboter zum Beispiel damit, eine Tüte Reischips aus der Schublade zu holen. Der macht sich auf den Weg, öffnet die Schublade und bringt sie zurück zu der Person, die den Auftrag erteilt hat.

Auch von einem anderen Forscher, der den Roboter bei der Aufgabe stört, indem er ihm die Tüte wegnimmt, lässt der sich nicht beirren. Er schnappt sich die Tüte einfach wieder aus der Schublade und tut, was ihm gesagt wurde. Das Ganze haben die Forscher in einem Video festgehalten:

Sprachmodell kann Aufgaben selbst erstellen

Der Name Palm-E ist entstanden, da das Robotergehirn auf Googles bestehendem großen Sprachmodell Palm basiert. Das könnt ihr euch so ähnlich vorstellen wie das Sprachmodell, das ChatGPT antreibt.

Damit der Roboter Aufgaben ausführen kann, muss er aber nicht nur verstehen können, was gesagt wurde, sondern die Sätze auch in Aufgaben umwandeln. Im Forschungsbericht geben die Wissenschaftler ein Beispiel dafür.

Hört der Roboter den Satz: „Ich habe mein Getränk verschüttet, kannst du mir etwas bringen, um es sauber zu machen?“, plant er eine Sequenz an Aufgaben, die so oder so ähnlich aussehen könnte: 1. Schwamm finden 2. Schwamm aufheben, 3. Schwamm zum Nutzer bringen, 4. Schwamm ablegen.

Der Roboter kann sehen

Sprache verstehen und sie in Aufgaben ummünzen, ist aber nur der eine Aspekt. Damit der Roboter sich in der Welt orientieren und Dinge tatsächlich finden kann, muss er wissen, wie diese aussehen. Dafür nutzt er Kameras und verschiedene Sensoren. So wird aus einem einfachen Sprachmodell ein visuelles Sprachmodell. Laut Google verfügt es über 562 Milliarden Parameter.

Ein Parameter kann zum Beispiel ein Wort oder ein Bild von einem Objekt sein. Ein visuelles Sprachmodell kann diese dann miteinander verknüpfen und weiß so, wovon der Nutzer spricht.

Bis wir unseren eigenen KI-Butler bekommen, wird es wahrscheinlich noch einiges an Tests brauchen. Die ersten Ergebnisse sind aber bereits eindrucksvoll.