Ratgeber: So erarbeitest du die richtige Strategie für Voice-Search

(Foto: amedley / Shutterstock.com)

Mit der Verbreitung von Sprachassistenten wie dem Google Assistant oder Amazons Alexa wird eine neue Evolutionsstufe für Nutzerschnittstellen eingeläutet. Spätestens im Jahr 2020 sollen bereits 50 Prozent der Suchanfragen sprachbasiert sein, so eine Prognose des Marktforschungsunternehmens Comscore. Die Frage, die sich dabei stellt: Wie werden Sprachbefehle das Nutzerverhalten bei der Suche beeinflussen? Was sind die Anforderungen der Schnittstellen wie zum Beispiel des Google Assistant? Und wie müssen Unternehmen darauf reagieren?

Voice-Search: The One and Only?

Unschlagbar ist Voice, wenn es darum geht, schnell, komfortabel und sogar parallel zu anderen Tätigkeiten eine Information zu erhalten oder eine Interaktion zu starten. Überall dort, wo klassische Short-Head-Keywords zu unpräzise für ein gutes Suchergebnis sind oder Longtail-Optimierung ein Fass ohne Boden wäre, ergibt Voice-Search ebenfalls Sinn. Aber es gibt auch weniger vorteilhafte Szenarien – etwa in öffentlichen Verkehrsmitteln oder einer lauten Umgebung. Und auch wenn es um vorwiegend visuelle Suchen geht, wie zum Beispiel im Bereich Mode, ist eine alleinige Voice-Search wenig sinnstiftend. Die Vorteile der herkömmlichen Suchmodi werden von Voice also nicht abgelöst!

5 Tipps für die richtige Voice-Strategie

Die Erkenntnis daraus: Voice allein ist nicht die Zukunft der Suche, sondern eine nutzerzentrierte Mischung aus klassischer Text-Suche, Voice und Visual. So erhält der Nutzer je nach Komplexität seiner Suchanfrage, je nach Kontext und Anwendungsszenario den dafür passenden Suchmodus – mal ganz herkömmlich und manchmal als kombinierte Version.

Vor diesem Hintergrund zeigt sich, dass Voice-Search zwar wohl kein allumfassender Game-Changer werden, jedoch in naher Zukunft eine Reihe von technologischen Trends anschieben wird. Grund genug, sich heute schon Gedanken über Strategien zu machen, welche Rolle Sprachassistenten im eigenen Geschäftsumfeld spielen werden. Dabei musst du folgende Aspekte berücksichtigen:

- Habe stets den Kundennutzen im Blick: Wo profitiert dein Nutzer von Voice-Search?

- Denke darüber nach, ob eine Kombination verschiedener Modi den größten Usernutzen stiftet.

- Prüfe, wo vorgelesene Featured Snippets besser zu deinem Markenbild passen, wo eventuell ein Dialog via Chatbot.

- Überlege, wo du mit deinen Nutzern verstärkt in Dialog treten willst, in der klassische Website-User-Experience aber an Grenzen stößt.

- Denke auch darüber nach, wie du mit deinen Nutzern sprechen willst! Sprache bietet viel Raum für Sympathie, aber auch für Missverständnisse.

Die Entscheidung: Chatbot oder Featured Snippet?

Die Anzahl der Chatbots am Markt ist aktuell noch überschaubar. Doch mit zunehmender Nutzung von Sprachassistenten gilt es, Webinhalte auch für Voice zu optimieren. Die grundlegende Frage dazu lautet: Featured Snippets (FS) oder Chatbot?

Featured Snippets können einfache Frage-Antwort-Szenarien abbilden und eignen sich vor allem für W-Fragen, FAQ oder How-tos. Sie lassen sich leicht in eine Website integrieren und können von Google aus-/beziehungsweise auch vorgelesen werden. Ein Beispiel sind Fragen wie: „Wie mache ich Senfgurken?“, oder auch „Wer erfand den Kühlschrank?“. Allerdings: Der User bekommt nur dieses FS angezeigt beziehungsweise vorgelesen, das Google dafür selektiert hat. Für mehrstufige, komplexe Dialoge sind FS nicht geeignet. Zudem sollte man bedenken, dass FS maximal ein Branding-Effekt zugewiesen werden kann, da der User stets in der Google-Umgebung verbleibt.

Chatbots dagegen können detaillierte Dialoge führen und bieten zudem eine multimodale Verzahnung zu Text oder Display. Sie können beispielsweise via Smartphone Auskunft über das TV- oder Kinoprogramm geben und gleichzeitig durch eine Buchung führen. Ein weiterer Vorteil ist, dass der Markt hier noch weitgehend leer ist, man wenig Konkurrenz hat, aber auch (noch) wenig gute Vorbilder. Ansprechende Call-to-Action-Elemente zu Webportalen sind ebenfalls möglich.

In 3 Schritten zum Chatbot-Setup für Google Actions

Google bietet mit „Actions on Google“ einen mächtigen Ansatz in Form von im Google Assistant integrierten Chatbots, die als Antwort auf Suchanfragen gestartet werden und sich multimodaler Inhalte bedienen können. Für das Setup für Google Actions gelten drei Faustregeln:

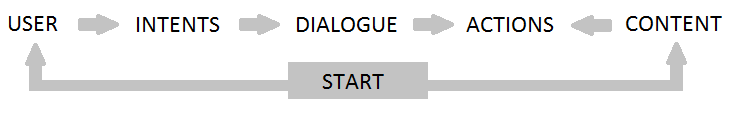

- Verwende das bipolare „UIDAC“-Entwicklungsmodell: Startpunkte der Entwicklung stellen einerseits die User (konkret: deren Motive und Profile), andererseits aber auch der zur Verfügung stehende Content in Form von textuellen und multimedialen Inhalten oder auch Produktdaten dar.

(Grafik: Frank Eisensehr)

Aus den Nutzermotiven lassen sich konkrete Ziele ableiten, die in einem Chatbot in Form von Intents abgefangen werden können. Intents in einem Fashion-Shop-Chatbot können zum Beispiel Fragen nach Sonderaktionen und Sortimentskategorien, eine konkrete Produktsuche oder die Suche nach lokalen Filialen darstellen. Ein konkreter Intent sollte einen Dialog zwischen Bot und User initiieren, der das Nutzerziel in Form einer konkreten Action beantwortet. Als Ergebnis einer Action kann etwa die visuelle Ausspielung von Produktlinks, Angeboten oder weiterer content-basierter Inhalte erfolgen und somit ein multimodaler Übergang stattfinden.

- Starte mit einem kleinen Case als Basis für iterative Weiterentwicklung: Um hier seriös und planvoll zu arbeiten, empfiehlt es sich, einen überschaubaren und aussagekräftigen Test zu fahren, der im Erfolgsfall gut skaliert werden kann. Für die Entwicklung von Google Actions existieren ausreichend Grundlagen, die ein solches Vorgehen unterstützen. Googles Tool Dialogflow bietet für eine entsprechend skalierbare Entwicklung von Chatbots sehr gute Grundlagen, da beispielsweise bereits ein Analytics-Tool integriert ist, in dem häufige „Unmatched Intents“ aufgeführt werden, also Nutzeranfragen, die der Chatbot aktuell noch nicht sinnvoll beantworten kann. Auch der User-Flow kann hier analysiert und auf dieser Basis optimiert werden.

- Du musst testen, testen, testen: Nicht allein die analytische Seite führt zu einem guten Ergebnis, sondern auch eine empirische Komponente ist notwendig. Um die Intentionen relevanter User kennenzulernen, reichen subjektive Analysen nicht aus – hier muss im ganzen Prozess kontinuierlich getestet werden, und zwar mit „echten Menschen“. Gerade um Nutzern eine angenehme und zielgerichtete Voice-UX zu bieten, sollten Dialogstrukturen, Formulierungen und Tonalitäten aus der Praxis heraus gestaltet und im Detail weiter optimiert werden.

Was ändert sich im klassischen SEO?

Voice-fähige Anwendungen im Web gibt es heute vor allem in Form von Featured Snippets, die etwa über Google Assistant auf dem Android Smartphone auch sprachlich wiedergegeben werden können.

Aber auch Chatbots – die oben genannten Google Actions – werden bei bestimmten Suchanfragen, die an den Google Assistant gerichtet werden, bereits empfohlen. So wird hier aktuell zum Beispiel die Suche „Was läuft im Fernsehen?“ mit einer Empfehlung der „TV Spielfilm“-App beantworter, die nahtlos und ohne weitere Installation im Assistant gestartet werden kann. Diesen Vorgang nennt man „Implicit Invocation“, während ein direkter Aufruf beispielsweise via „Rede mit TV Spielfilm“ als „Explicit Invocation“ bezeichnet wird. Um mit der eigenen Google Action eine solche Empfehlung durch den Assistant zu erreichen, ist es einerseits erforderlich, den Chatbot mit Blick auf Voice-UX optimiert zu haben, sowie weiterführend diese Kriterien besser zu erfüllen als konkurrierende Actions, die dafür in Frage kommen. Die wesentlichen Ranking-Faktoren für Google Actions lauten dabei Google zufolge:

- Konversationsfehler vermeiden

- Kommunikationsfluss nicht mit Account Login blockieren

- Offene Fragen vermeiden

- Aussagekräftige und hilfreiche Startphrasen zum Dialogstart verwenden

Chatbots und Featured Snippets müssen zukünftig als weiterer Teil der Online-UX verstanden und in die SEO-Strategie inkludiert werden. Essenziell ist zudem, Content wirklich klar zu strukturieren und eine saubere Architektur des HTML-Quelltexts bereitzustellen. Dazu ist es empfehlenswert, Structured Data zur einfachen Bereitstellung schematischer Inhalte zu nutzen. In der Beta-Version ist dazu bereits das sogenannte Speakable-Markup verfügbar, das als Datenelement für Sprachanwendungen im Quelltext verankert wird.