Größter Computerchip aller Zeiten: Vier Billionen Transistoren und 900.000 KI-Kerne

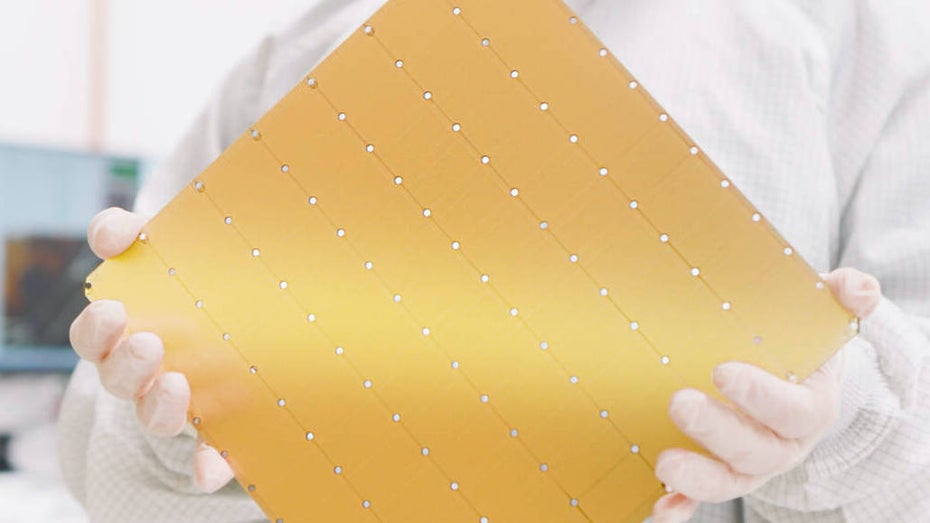

WSE-3: der größte Computerchip der Welt. (Foto: Cerebras Systems)

Mit der Wafer Scale Engine 3 (WSE-3) hat der Supercomputing-Spezialist Cerebra den größten und wahrscheinlich leistungsstärksten Computerchip der Welt vorgestellt. Der WSE-3 misst 21,5 mal 21,5 Zentimeter – was zwar der Größe seines Vorgängers WSE-2 aus dem Jahr 2021 entspricht. Allerdings gibt es derzeit keine größeren Wafer, ein Chip kann also nicht noch größer werden.

WSE-3: Doppelt so schnell wie der Vorgänger

Dafür ist WSE-3 doppelt so schnell und leistungsstark wie sein Vorgänger.

So kommt das Chipmonster mit vier Billionen Transistoren und 900.000 KI-Kernen. Zum Vergleich: Vorgänger WSE-2 hatte 2,6 Billionen Transistoren und 850.000 KI-Kerne.

Einer der leistungsstärksten Chips, der aktuell schon für das KI-Training genutzt wird, ist die Nvidia-GPU H200. Sie kommt auf „nur“ 80 Milliarden Transistoren, wie livescience.com ausführt.

Supercomputer soll KI-Systeme trainieren

Das KI-Training soll künftig eine der Hauptaufgaben der von WSE-3 angetriebenen Computer sein. Bestimmt ist der Riesenchip laut dem Unternehmen für den im Bau befindlichen Supercomputer Condor Galaxy 3. Das in Dallas, im US-Bundesstaat Texas, beheimatete System soll nach der Fertigstellung eine Rechenleistung von acht Exaflops bringen.

Damit wäre der Condor Galaxy 3 fast achtmal so schnell wie der Frontier-Supercomputer im Oak Ridge National Laboratory in Tennessee. Das aktuelle führende System im Supercomputer-Ranking schafft gut 1,2 Exaflops. Wenn der Condor Galaxy 3 zusammen mit seinen beiden Vorgängern gekoppelt wird, soll das Gesamtsystem sogar bis zu 16 Exaflops erreichen können.

10-mal größere Systeme als GPT-4 trainierbar

Der Condor Galaxy 3 soll künftig für das Training von KI-Systemen eingesetzt werden. Dabei soll der Supercomputer so leistungsstark sein, dass damit problemlos KI-Systeme trainiert werden können, die bis zu zehnmal größer als etwa OpenAIs GPT-4 oder Googles Gemini sind.

GPT-4, so hat kürzlich ein Leak gezeigt, soll 1,76 Billionen Variablen (Parameter) verwenden, um das System zu trainieren. Condor Galaxy 3 könnte KI-Systeme mit rund 24 Billionen Parameter handeln, wie Cerebras mitteilt. Cerebras-CEO Andrew Feldman zufolge könnten Megachip und Supercomputer dazu beitragen, „die aktuelle größten KI-Probleme“ zu lösen.

Bisher haben mich KI-Dystropien immer cool gelassen. Diese Zahlen und Dimensionen fühlen sich jetzt aber irgendwie so unkontrollierbar an, dass ich mich an Skynet erinnert fühle.

Ich glaube kaum, dass in der näheren und ferneren Zukunft eine tödliche Gefahr von KI ausgehen wird. KI wird sicher Arbeitsplätze kosten, aber vielleicht auch Arbeitsplätze sichern.

Der Mensch ist eine viel größere und reale Bedrohung. Man braucht nur nach Russland zu schauen, wo ein eiskalter Machtmensch immer wieder indirekt mit der Bombe droht. Siehe auch Nordkorea, siehe auch das Machtstreben von China ….

Umso wichtiger ist es, nicht auf Eskalation gebürstet zu sein (Stichwort: Taurus). Härte zeigen wo es sinnvoll ist, Verhandlungsbereitschaft zeigen wo es erforderlich ist.

Schreibt die KI denn nun die Artikel oder auch die Kommentare. Und liest eine andere KI die Artikel ?