Seit Firmengründung im Jahr 2021 hat das KI-Startup Anthropic bereits mehr als 700 Millionen US-Dollar an Risikokapital erhalten. Mit dem Geld hat der ehemalige OpenAI-Forschungsvizechef und heutige Anthropic-CEO Dario Amodei jetzt eine Text-KI nach dem Vorbild von ChatGPT entwickelt, die sich in einigen Bereichen von dem Produkt seines ehemaligen Arbeitgebers unterscheidet.

Das grundlegende Konzept nennen Amodei und sein Team „constitutional AI“, also gesetzmäßige KI. Damit soll ein grundlegendes Problem von ChatGPT und ähnlichen Systemen gelöst werden. Denn die können leicht zur Erzeugung potenziell gefährlicher Inhalte genutzt werden. Durch die Einführung grober Regeln soll die KI von Anthropic genau solche Inhalte vermeiden, ohne dass zu viel menschliche Arbeit in die Kontrolle gesteckt wird.

Die genauen Vorgaben für seine KI hat das Anthropic-Team bislang nicht offengelegt. Nach Firmenangaben soll damit aber unter anderem gezielt die Wiedergabe schädlicher Ratschläge untersagt sein. Anhand der Regeln wurde dann eine Text-KI trainiert, die ihre Ergebnisse immer wieder anhand ihrer Regeln angepasst hat. Anschließend wurden die am besten zu den Regeln passenden Antworten als Grundlage für ein KI-Modell genommen, mit dem dann wiederum die ChatGPT-Alternative Claude trainiert wurde.

ChatGPT-Alternative Claude: Erste Tester berichten von gemischten Ergebnissen

Noch befindet sich Claude in einer geschlossenen Beta-Phase. Einige Beta-Tester haben aber bereits erste Vergleiche mit ChatGPT auf Twitter veröffentlicht. Laut Yann Dubois, einem Doktoranden des Stanford AI Lab, sind die Antworten von Claude generell näher an der eigentlichen Frage. Dafür seien sie aber weniger genau.

Laut Dubois hat Claude aber das größte Problem von ChatGPT und ähnlichen Lösungen nicht gelöst: Die KI gibt wie ihr großes Vorbild bisweilen Unwahrheiten aus. Immerhin, so Dubois, soll Claude aber in manchen Fällen immerhin offen eingestehen, dass es eine Frage aufgrund mangelndem Wissen nicht beantworten kann.

Nach Angaben des KI-Forschers Dan Elton soll Claude allerdings bessere Witze als ChatGPT erzählen können. Gleichzeitig fand Elton aber auch eine bedenkliche Schwachstelle: Wer Fragen in einer Base64-Codierung stellt, der kann damit offenbar die Sicherheitsmechanismen von Claude umgehen, die schädliche Antworten verhindern sollen. Elton konnte der KI auf die Art beispielsweise eine Kochanleitung für die illegale Droge Meth entlocken. Dieselbe Schwachstelle wurde im Dezember 2022 bereits in ChatGPT entdeckt.

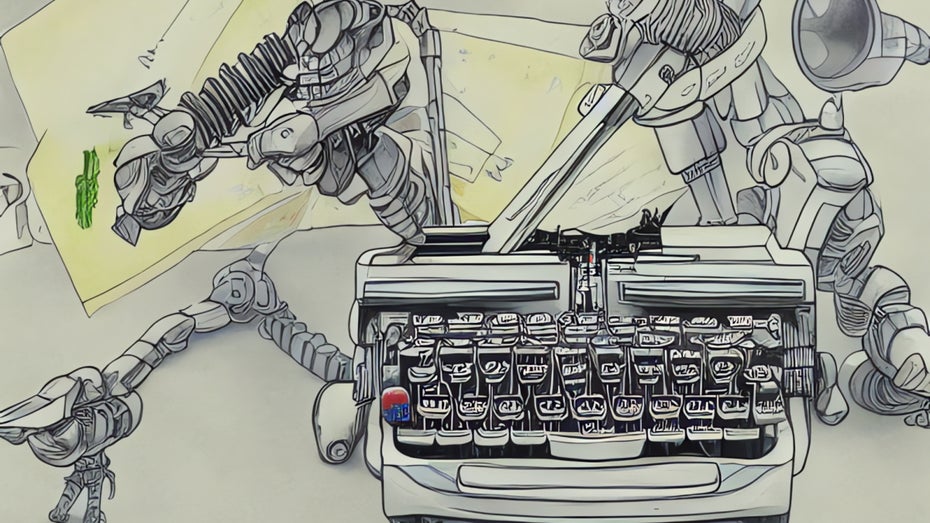

Bildergalerie: Dall-E malt unsere Headlines