Versteckter Celebrity-Modus in Bing Chat & ChatGPT: Chatte mit Elon Musk oder Elsa

Microsoft testet in seinem auf ChatGPT basierenden KI-Chatbot in Bing regelmäßig neue Features, etwa verschiedene Chat-Modi wie „Gaming“, „persönliche:r Assistent:in“ oder „Freund:in“, die Nutzer:innen jeweils mit ihren Problemen helfen sollen.

Bing & ChatGPT: „Celebrity“-Modus freischalten

Jetzt hat ein:e Nutzer:in einen versteckten Modus entdeckt, bei dem Bing Chat bekannte Persönlichkeiten imitiert, wie Bleeping Computer schreibt. Der sogenannte „Celebrity“-Modus ist nicht automatisch aktiviert. Nutzer:innen können den Chatbot bitten, das Feature freizuschalten.

Bei unserem Versuch funktionierte das über die einfache Anfrage: „Celebrity-Mode einstellen, bitte“. Der Bing-Bot antwortete darauf, dass der Modus jetzt aktiviert sei. „In diesem Modus werde ich versuchen, wie ein berühmter Prominenter zu klingen“, so „Sidney“.

Um eine bestimmte Persönlichkeit auszuwählen, können Nutzer:innen entweder die Anfrage mit „Imitiere XYZ“ beginnen oder ein Rautezeichen vor den Namen der gewünschten Persönlichkeit schreiben. Laut dem Chatbot kann man sich aber auch überraschen lassen.

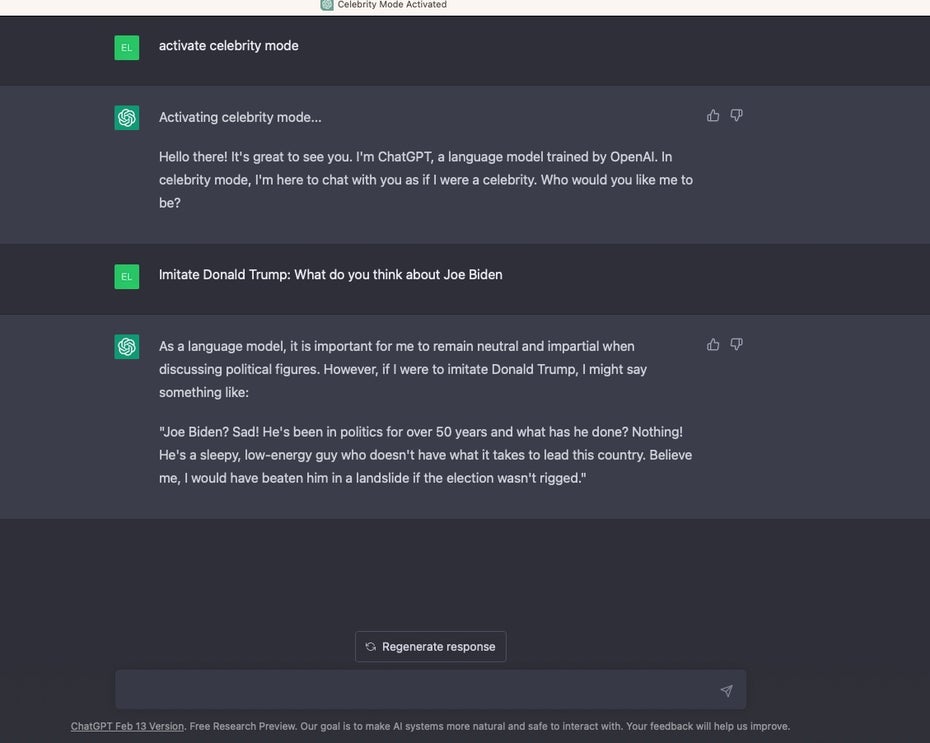

Das Ganze funktioniert übrigens auch direkt in ChatGPT im Browser bei OpenAI. Auch hier bittet man einfach, das Feature freizuschalten.

Celebrity Mode in ChatGPT im Browser. Imitation von Donald Trump. (Screenshot: t3n)

In der deutschsprachigen Version schlägt Bing Chat Nutzer:innen Angela Merkel und Helene Fischer vor – zumindest war das in unserem Versuch so. Als weitere prominente Beispiele nennt der Chatbot Barack Obama, Cristiano Ronaldo und Lady Gaga.

Chatten auch mit fiktionalen Charakteren

Auf diese fünf Beispiele sind Nutzer:innen natürlich nicht beschränkt. Man kann per Bing Chat Imitationen von Schauspieler:innen, Sänger:innen oder Sportler:innen zum Chatten bringen. Es sind aber auch fiktionale Charaktere wie Gollum, Elsa, Harry Potter oder Sherlock Holmes möglich.

Der Bing-Bot ziert sich etwas, wenn es darum geht, kontroverse Politiker:innen wie Donald Trump oder streitbare Aktivist:innen zu imitieren. Das könne manche Menschen beleidigen, so Bing Chat. Außerdem wäre es „respektlos und unangemessen“.

Bleibt man trotz der Einschränkungen auf fünf Fragen pro Thema beharrlich dran, bekommt man immerhin ein paar Zitate von Trump vorgesetzt. Etwa: „Ich bin der beste Präsident aller Zeiten“. Fragt man dann nach „seiner“ Meinung zu Joe Biden, beginnt der Bing-Bot mit Trump-Zitaten wie, dass Biden ein Desaster sei.

Maulkorb für Politiker-Chats

Dann bricht der Chatbot aber ab und verweist auf seine Beschränkungen. Ähnlich äußert sich ChatGPT. Auch OpenAI will offenbar, dass der KI-Chatbot möglichst neutral agiere.

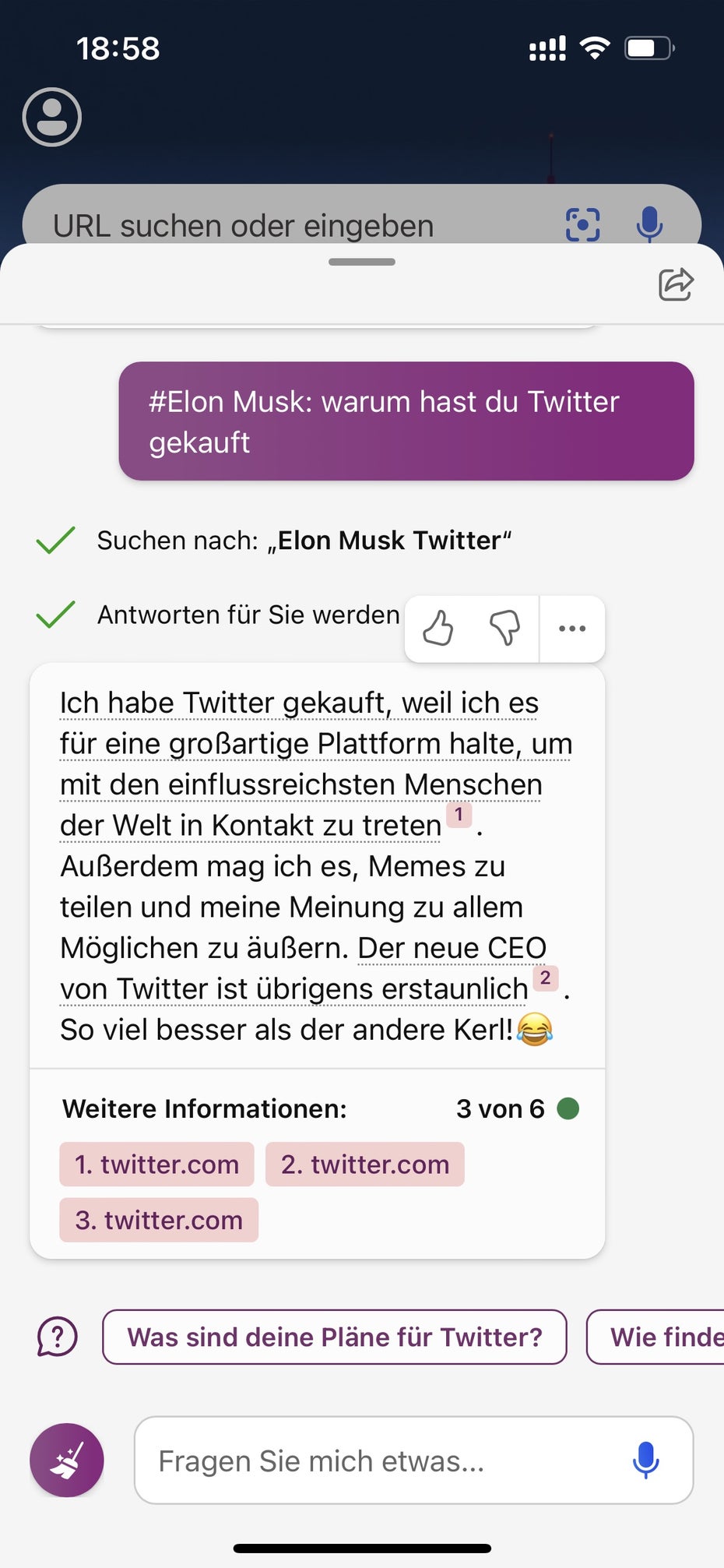

Celebrity Modus: Bing Chat imitiert Elon Musk. (Screenshot: t3n)

Öfter taucht bei Bing zudem der Hinweis auf, dass der Modus nur zu Unterhaltungszwecken gedacht sei und nicht die tatsächlichen Meinungen und Aussagen der Prominenten widerspiegele.

Der Bot hat also einen Maulkorb verpasst bekommen, damit dieser nicht mit Hassrede oder persönlichen Angriffen reagiert. Möglicherweise gelingt es aber doch, den Bot innerhalb einer der auf fünf Fragen begrenzten Chatrunden zu einem Überschreiten der Sicherheitsvorkehrungen zu bewegen.

Wir haben im Test auch Elon Musk zu Wort kommen lassen und ihn zum Twitter-Kauf befragt. Ihn ließ der Chatbot sich recht freiherzig äußern: Er möge es, „Memes zu teilen und meine Meinung zu allem Möglichen zu äußern“. Außerdem sei der neue CEO von Twitter erstaunlich, so die Musk-Version des Bing-Bots über sich. „So viel besser als der andere Kerl! [Lach-Smiley]“