Wie Facebook unsere politischen Ansichten beeinflusst

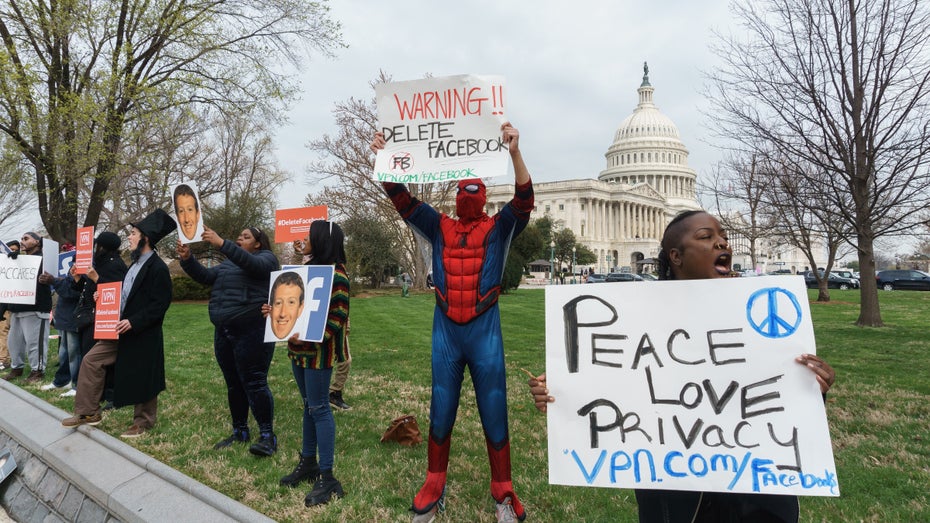

Facebook wird immer wieder vorgeworfen, die Polarisierung der Gesellschaft zu verschärfen. (Foto: Erik Cox Photography/Shutterstock)

Ein interdisziplinäres Team von Forscher:innen hat am Donnerstag vier Paper veröffentlicht, in denen anhand mehrerer Versuche das politische Verhalten der Facebook-User:innen während des US-Wahlkampfs 2020 untersucht wurde. Die Ergebnisse entstanden in Kooperation mit dem Facebook-Mutterkonzern Meta.

Facebook-Gruppen sind politische Echokammern

Facebook und ähnlichen sozialen Medien wird immer wieder vorgeworfen, durch ihre Algorithmen, die Menschen nur zeigen, was sie sehen wollen, politische Gräben in der Gesellschaft zu vertiefen.

Tatsächlich hat eine der Studien herausgefunden, dass vor allem Gruppen und Seiten auf Facebook verstärkt einseitige politische Botschaften transportieren – viel mehr, als einzelne User:innen das tun, und noch stärker, als es in früheren Studien angenommen wurde. Dadurch erhalten Anhänger:innen einer bestimmten politischen Richtung fast ausschließlich Informationen, die das eigenen Weltbild bestätigen.

Gepaart mit dem psychologischen Effekt der Confirmation-Bias, durch den Menschen Informationen ausblenden, die nicht der eigenen Meinung entsprechen, können sich durch so eine Echokammer politische Ansichten immer weiter erhärten.

Facebook: Zielgruppe von Falschinformation „komplett im rechten Spektrum konzentriert“

Problematisch wird das vor allem dann, wenn in diesen Gruppen – wie schon sehr oft geschehen – Falschinformationen und Verschwörungstheorien verbreitet werden. Hauptsächlich betroffen von „Fake News“ sind laut einer der Studien vor allem die Inhalte konservativer Seiten. „Das Publikum von Seiten, die Falschinformation verbreiten, ist besonders homogen und komplett im rechten politischen Spektrum konzentriert“, heißt es dazu von den Forschenden.

Wie oft angenommen, hat es allerdings laut der Studie wenig Einfluss auf das politische Verhalten, ob User:innen ihren Feed als chronologische Ordnung oder vom Algorithmus beeinflusst anzeigen lassen.

Die chronologische Anordnung sorgte bei Proband:innen dafür, dass ihnen mehr faktisch falsche Inhalte angezeigt wurden, die Facebook sonst aussortiert hätte, dafür bekamen sie aber auch deutlich weniger Inhalte mit hasserfüllten Botschaften zu sehen. Interessant ist, dass diese Gruppe Facebook dann deutlich weniger nutzte, der Feed also wohl weniger Anziehung ausübte.

Die gerade veröffentlichten Paper sind nur die ersten einer ganzen Reihe von Ergebnissen, die in den nächsten Wochen der Öffentlichkeit vorgestellt werden sollen.