Speech2Text2Speech: Spreche ich mit KI?

Der kürzeste Witz in Corona-Zeiten: #stayathome gibt uns endlich mehr Zeit für die wichtigen Dinge.#stressedathome

„Auf was ich mich am meisten freue nach dem Lockdown: keine Videomeetings mehr“. So lautete die E-Mail-Antwort einer Mitarbeiterin in einer PR-Agentur auf die Frage, wann sie Zeit für ein Telefonat hätte. Und mit dieser Aussage ist sie nicht allein. Bis 2010 war es die E-Mail, die uns die Arbeitszeit stahl. Dann kam Facebook. Das wurde ersetzt durch Whatsapp und Slack. Und heute sind es Zoom, Skype und Goto Meeting. Schon gibt es erste Forschungen zu „Burnout durch Online-Meeting“, berichtet der britische Telegraph.

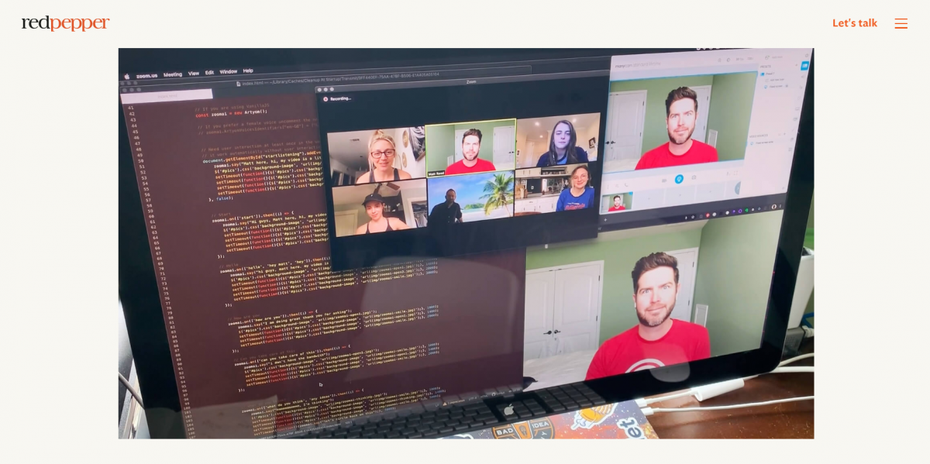

Auch Matt Reed war genervt von der Vielzahl virtueller Gesprächsangebote von Geschäftspartnern, Freunden und Familie. Also erfand er den Zoom-Bot. Der Bot nimmt die Wortbeiträge der anderen Teilnehmer im Meeting, wandelt sie in Text um, schleust sie durch einen Entscheidungsbaum und gibt die Antworten mit Matts Stimme aus. Begleitet wird das durch eine rudimentäre Animation, in der Matts Gesicht den Mund auf- und zuklappt, wie eine Handpuppe aus dem Kasperle-Theater. Und um seine Gesprächspartner wenigstens für einen Moment lang glauben zu lassen, dass er es wirklich ist, entschuldigt sich Matts Avatar gleich zu Beginn des Meetings für seine schlechte Internetverbindung.

Matt Reed programmierte einen Zoom-Bot, um sich vom virtuellen Meetingstress zu entlasten. (Bild: Redpepper.land)

Das Minenfeld Text2Speech

Matt Reeds kleiner digitaler Spaß richtet den Scheinwerfer auf eine der spannendsten technologischen Entwicklungen dieser Tage. Wie lange dauert es noch, bis Software so gut mit uns sprechen kann, dass wir nicht mehr bemerken, dass kein Mensch am anderen Ende der Leitung sitzt.

Die Erinnerungen werden wach an die erste Präsentation von Google Duplex vor zwei Jahren. Die Software des Onlineriesen rief telefonisch bei einem Frisiersalon an und vereinbarte für eine Kundin einen Termin. Die Mitarbeiterin im Frisiersalon – es wurde nie geklärt, ob das wirklich ein Mensch war – schien in dem Moment nicht unterscheiden zu können, ob der Anrufer Mensch oder Maschine war. Und das spielte für den Informationsaustausch, nämlich die Terminfindung, auch keine Rolle.

Dennoch war der Aufschrei groß. Die versammelten Techies bei Googles IO-Konferenz kreischten vor Begeisterung. Die Medien, Verbraucherschützer und Ethik-Räte schrien auf vor Entsetzen über den „Betrug“, den die Maschine an der armen Friseurin beging.

Die Kritik richtete sich vor allem darauf, dass die Google-Software „irrationale“ Elemente in die Sprachausgabe einstreute, nämlich zögernde „Hmms“ und zustimmende „Ahaas“. „Es ist verrückt“, meint Sam Crowther von A Million Ads. „Jahrzehntelang haben wir Toningenieure uns die Finger wund gearbeitet, um ‚Hmms‘ aus Sprachaufnahmen zu entfernen, um den besseren Ton zu treffen. Und heute zeichnet sich automatisierte Sprachproduktion dadurch aus, dass das Ergebnis durch solche ‚Hmms‘ menschlicher klingt.“

Das gilt auch für das spektakuläre Projekt „JFK Unsilenced“ von Cereproc. In jahrelanger Kleinarbeit sammelten die Toningenieure Schnipsel aus Reden des früheren US-Präsidenten John F. Kennedy und „rekonstruierten“ eine Rede, die JFK nie gehalten hat. Er hätte sie am 22. November 1963 in Dallas halten sollen, wurde aber auf dem Weg dorthin erschossen. Die künstliche Rede enthält nicht nur die authentische Stimme des Präsidenten, sondern ist auch gefüllt von Knistern und atmosphärischen Geräuschen, die eine „historische“ Aufnahme simulieren sollen. Tatsächlich schossen die Entwickler etwas übers Ziel hinaus: Die „Aufnahme“ klingt, als stamme sie aus den 20er Jahren des 20. Jahrhunderts. #schellackplatte

Die Toningenieure von Cereproc rekonstruierten die Stimme des toten John F. Kennedy. (Screenshot: Frank Puscher)

Während das Projekt JFK als Kulturgut gefeiert wird, werfen zwei weitere Projekte Schlaglichter auf die kritische Seite von künstlicher Spracherzeugung. Adobe präsentierte 2016 auf der Hausmesse Max das Projekt Voco. Soundfiles ließen sich per Copy-and-Paste editieren und zwar nicht in der Wellenform, sondern im transkribierten Text. Der vorführende Software-Ingenieur konnte sogar neuen Text eingeben, der dann mit der Stimme von US-Comedian Keegan-Michael Key ausgegeben wurde. Samples in einer Gesamtlänge von 20 Minuten reichen dem Programm zur „Virtualisierung“ der Stimme.

Die Universität Washington verknüpfte künstliche Stimme auch noch mit Bewegtbild und legt Barack Obama eine Rede in den Mund, die er so nie gehalten hat. Noch ist der artifizielle Charakter der Zusammenstellung erkennbar, aber nicht mehr lange.

Die Konsequenzen für Marketing und Kommunikation

In dem Moment, wenn Menschen in ihrer Wahrnehmung eingeschränkt sind, fällt die Unterscheidung Mensch oder KI als Gegenüber schwer. Matt Reed redete sich mit der schlechten Onlineverbindung raus. Die „Duplex-Friseurin“ konzentriert sich auf die Fakten der Kommunikation und ihr steht am Telefon eben auch keine Mimik oder Gestik zur Interpretation zur Verfügung.

Das hat Vor- und Nachteile für die Onlinekommunikation. Zuvorderst wird es nötig, vor allem bei wichtigen Aussagen klare Quellenbelege anführen zu können und das möglichst aus vertrauenswürdigen Ressourcen. Nicht auszudenken, was ein gefaktes Statement des CEO zu den erwarteten Absatzzahlen im Quartal mit einem Börsenkurs machen könnte. Möglicherweise wird hier tatsächlich die Blockchain eine Rolle spielen, denn sie kann eine unfälschbare Herkunftskette eines Videos dokumentieren und somit Fälscher mindestens abschrecken.

Marken, Medien und Unternehmen, die in der Lage sind, beim User Vertrauen aufzubauen, sind hier klar im Vorteil. Hier ist also auch ein Stück Transparenz über die eigenen Prozesse gefragt. Hat der Pressesprecher die Fragen an den CEO beantwortet, oder der CEO selbst?

Im Umkehrschluss bekommt das Marketing ein unglaublich mächtiges Tool an die Hand. Die virtuelle Sprache ist die Vorstufe zum Avatar. So könnte man den CEO „virtuell“ an einem Podcast teilnehmen lassen, obwohl er gar keine Zeit für das Interview hat. Die Antwortet werden von der Pressestelle gescriptet und dann von der Software zu einer Audio-Datei gerendert.

Colonel Sanders, der virtuelle Influencer von Kentucky Fried Chicken, kann dann nicht nur Fotos machen, sondern auch das Weltgeschehen kommentieren.

Grundsätzlich ist Text2Speech ein extrem leistungsfähiges Workflow-Tool, wenn es gut funktioniert. Potentiell wird aus jedem Artikel ein Podcast. t3n hat das vor Jahren schon mit dem „menschlichen“ Vorlesedienst Narrando getestet. Automatische Tools wie Bingewith heben die Idee auf die nächste Stufe, sobald sie auch auf Deutsch gut klingen.

Für die Medien ergibt sich aber auch eine gewaltige Herausforderung. Da bekanntlich die KI-Übersetzungen schon ziemlich gut funktionieren, kann jeder redaktionelle Inhalt per Knopfdruck in ein „hörbares“ deutsches Format übertragen werden. Medien, die oft auf den amerikanischen oder asiatischen Markt schauen, bekommen eine Menge neue Konkurrenz, können aber gleichzeitig auch internationale Märkte bespielen.

Ob man – analog zu John F. Kennedy – einem längst verstorbenen Kultmoderator eine neue Radiosendung geben will, müssen wohl Ethik-Räte entscheiden. Technisch machbar ist es.

Bis zum vollständigen künstlichen Mitarbeiter, wie ihn IP Soft auf der Plattform Digitalworkforce ins Rennen schicken will, ist es noch ein Stück des Weges. Aber wie lang ist dieser Weg wirklich?

5 Tipps, wie man einen Chatbot entlarven kann

1. Empathische Dialoge mit Wiederholungen

a. Mensch: Mir geht es schlecht

b. AI: Kann ich helfen?

c. Mensch: Mir geht es wirklich schlecht

d. AI: Kann ich helfen?

2. Zwei-Schritt-Disassoziation

Die zweite Frage nutzt eine Antwort implizit, die auf die erste Frage gegeben wurde.

a. Mensch: Wo bist Du?

b. KI: In München.

c. Mensch: Wie ist das Wetter draußen?

d. KI: Könntest Du die Frage wiederholen?

3. Die Endlosschleife

a. Mensch: Ich habe ein Problem mit meinem Paket.

b. KI: Wie lautet die Kundennummer?

c. Mensch: 12345

d. KI: Das Päckchen wird am (gestern) erwartet.

e. Mensch: Ja, aber ich will wirklich wissen, wann es kommt.

f. KI: Das Päckchen wird am (gestern) erwartet.

g. Mensch: Das war gestern, wann kommt das Paket?

h. KI: Das Päckchen wird am (gestern) erwartet.

4. Das Entscheidungsdilemma

Die Fragestellung zielt in eine Richtung, in der der Bot beide Antwortmöglichkeiten für ungünstig hält, wobei eine Antwort ungünstiger erscheint als die andere.

Beispiel: Ich will, dass der Verspätungszuschlag aufgehoben wird oder ich kündige und beleidige euch auf Social Media.

5. Das unlösbare Dilemma

Die Fragestellung zielt auf zwei Antworten, die aus Sicht des Bots beide gleich schlecht sind. Er müsste gegen Business-Regeln oder Gesetze verstoßen; hier würde der Mensch empathisch reagieren, der Bot eher mechanisch.

Die Tipps stammen von Anthony Helmstetter und können hier ausführlich nachgelesen werden.

Das könnte dich auch interessieren: