Daten sammeln, ohne Daten zu sammeln: Apples Sicherheitslösung „Differential Privacy“ erklärt

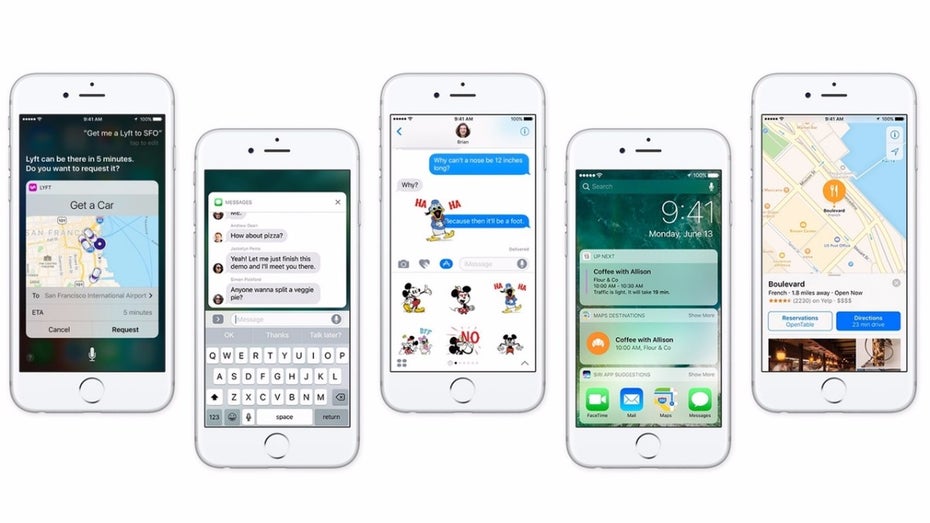

(Bild: Apple)

„Differential Privacy“: Apple sammelt eure Daten, ohne eure Daten zu sammeln

Mithilfe der Differential Privacy soll iOS 10 tolle Features bieten, ohne auf Privatsphäre verzichten zu müssen, so Apples Software-Chef Craig Federighi. (Screenshot: Apple)

Apple will mit den Daten seiner Kunden kein Geld verdienen, das hat das Unternehmen mehr als einmal bekräftigt. Nicht erst seit dem Rechtsstreit zwischen Apple und dem FBI hatte das Unternehmen aus Cupertino stets deutlich gemacht, dass lediglich mit der Hardware Geld verdient werde. Dennoch braucht Apple die Daten seiner Nutzer, um die eigenen Deep-Learning-Systeme damit zu füttern – schließlich soll sich Apples Siri mit der Konkurrenz von Google, Amazon und Microsoft messen.

Auch auf der WWDC-2016-Keynote spielte „Differential Privacy“ eine Rolle. (Bild: Apple)

Mithilfe der gesammelten Daten kann Apple künftig unter anderem herausfinden, welche Emojis besonders beliebt sind, welche Quicktype-Vorschläge beim Verfassen von Nachrichten helfen und welche der von der Spotlight-Suche angezeigten Links am häufigsten angetippt werden – das alles sind Funktionen, die in iOS 10 einfließen werden. Damit Apple mit unseren Daten arbeiten kann, ohne uns mit den Daten in Verbindung zu bringen, setzt das Unternehmen auf das sogenannte „Differential Privacy“-Konzept. Mit diesem Ansatz aus der Statistik will Apple Nutzerdaten sammeln und analysieren, um Nutzern individualisierte Vorschläge zu unterbreiten – jedoch ohne die Privatsphäre jedes einzelnen zu kompromittieren.“Mit Differential Privacy lassen sich Muster aus großen Datenmengen gewinnen, ohne dabei Rückschlüsse auf einzelne Individuen zu ziehen zu können.”

iOS 10 wird smarter, aber laut Apple nicht auf Kosten der Sicherheit – Differential Privacy sei die Lösung. (Bild: Apple)

Wie Andy Greenberg vom Wired-Magazin passend zusammenfasst, wird durch „Differential Privacy“ versucht, so viel wie möglich über eine Gruppe zu lernen, aber gleichzeitig so wenig wie möglich über eine einzelne Person zu erfahren. Auf diese Weise soll zwar Apples Deep-Learning-System herausfinden können, über welche Inhalte die Nutzer sprechen, was sie wollen und welche Aktivitäten sie ausüben. Darüber hinaus soll aber niemand anderes Daten daraus extrahieren können – weder Hacker, noch Geheimdienste – zumindest in der Theorie.

Apple bleibt bei der Beschreibung seiner neuen Datensammeltechnik recht vage: „Differential Privacy“ verschleiert die Identität der einzelnen Nutzer durch Hinzufügen von Hash- und Zufallswerten. Trotz der Störfaktoren, die mathematisch beweisbar sein müssen, soll aber weiterhin eine statistische Auswertung möglich sein. Laut Apple könne man mit den Fragmenten der einzelnen Nutzerdaten nichts anfangen – erst durch die Datenmasse, also die Sammlung einzelner Nutzerdaten, lassen sich bestimmte Muster feststellen, die in letztlich in Siri und Co. einfließen.

Die Masse macht’s: Differential Privacy von Apple erklärt:

Beginnend mit iOS 10 wird Apple mithilfe der Differential Privacy-Technologie die Nutzungsmuster einer großen Anzahl von Nutzern analysieren, ohne dabei die Privatsphäre des Einzelnen zu beeinträchtigen. Um die Identität von Personen unkenntlich zu machen, wird nur ein kleiner Teil der Nutzerdaten verarbeitet und durch Differential Privacy mit einem mathematischen Rauschen versehen. Je mehr Menschen ähnliche Nutzungsmuster an den Tag legen, desto besser kann ein allgemeines Muster erkannt werden, mit der die Benutzererfahrung verbessert werden kann.

– Apple

Differential Privacy: Auch Google hat eine ähnliche Technik im Einsatz

Apple ist nicht das erste Unternehmen, das „Differential Privacy“ in seinen Produkten einsetzt – auch Google verwendet eine ähnliche Technik, um Nutzungsstatistiken für seinen Chrome-Browser zu sammeln. Das Verfahren basiert allerdings auf der 50 Jahre alten „Randomisierten-Antwort-Technik“ und wird von Google als RAPPOR bezeichnet. Apple hingegen ist wohl das erste Unternehmen, das Differential Privacy in großem Umfang verwendet.

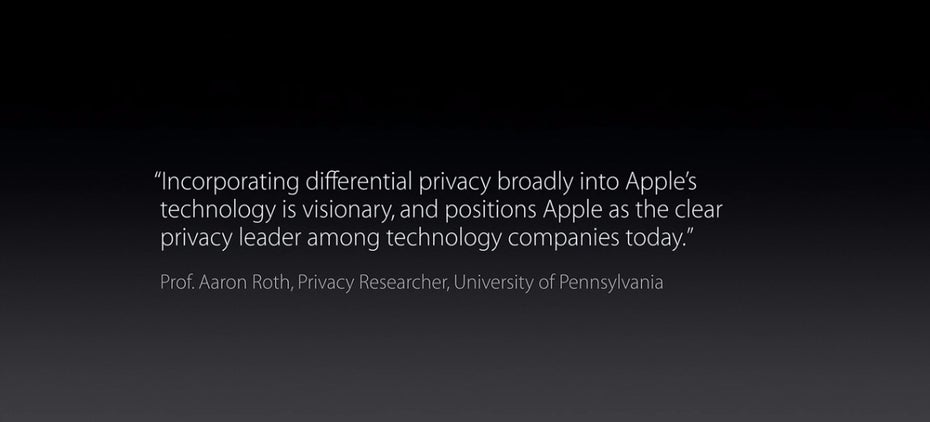

Apple ließ es sich auf der WWDC-Keynote nicht nehmen, einen Sicherheitsexperten hinsichtlich der Integration der Technik in die eigene Software zu zitieren. (Screenshot: Apple)

Differential Privacy ist nicht unumstritten: Je mehr persönliche Daten Apple zieht, desto mehr „Noise“ (Hintergrundrauschen) muss generiert werden, um die Privatsphäre zu sichern. Das bedeutet, dass die Technik korrekt „proportioniert“ sein muss. Zum einen müssten genügend Daten zur korrekten Analyse vorhanden sein, zum anderen aber nur so wenige, dass die Privatsphäre des Einzelnen gesichert bleibe, so der Sicherheitsexperte Matthew Green in seinem Blogbeitrag.

Angeblich sei Apple bei der Integration der Technik aber “auf dem richtigen Weg“. Das zumindest sagt Aaron Roth, Mathematiker und Sicherheitsexperte, der einen Blick auf Apples Integration von Differential Privacy werfen konnte. Apples Ansatz klingt vielversprechend und könnte wegweisend für den Umgang mit unseren Nutzerdaten sein.

Dass Apple auf Sicherheit bedacht ist, zeigt die Integration der Ende-zu-Ende-Verschlüsselung als Standard in Facetime, iMessage und Homekit. Ausserdem müssen Apps ab 2017 auf HTTPS setzen. Sobald Apple weitere Details zur Umsetzung der Differential Privacy bekanntgibt, lässt sich besser einschätzen, ob die Integration gelungen ist. Google könnte sich in manchen Belangen eine Scheibe abschneiden – zum Beispiel sollte beim neuen Allo-Messenger standardmäßig die Ende-zu-Ende Verschlüsselung aktiviert sein.